Is Scaling All You Need? LLM收益递减,AI小厂难活命

Is Scaling All You Need? LLM收益递减,AI小厂难活命在GPT-4发布后14.5个月里,LLM领域似乎已经没什么进步了?近日,马库斯的一句话引发了全网论战。大模型烧钱却不赚钱,搞AI的公司表示:难办!

在GPT-4发布后14.5个月里,LLM领域似乎已经没什么进步了?近日,马库斯的一句话引发了全网论战。大模型烧钱却不赚钱,搞AI的公司表示:难办!

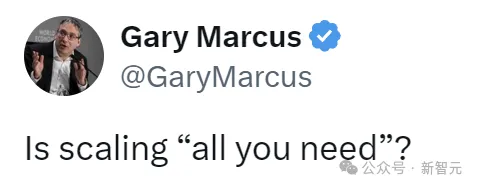

现有多模态大模型在对齐不同模态时面临幻觉和细粒度感知不足等问题,传统偏好学习方法依赖可能不适配的外源数据,存在成本和质量问题。Calibrated Self-Rewarding(CSR)框架通过自我增强学习,利用模型自身输出构造更可靠的偏好数据,结合视觉约束提高学习效率和准确性。

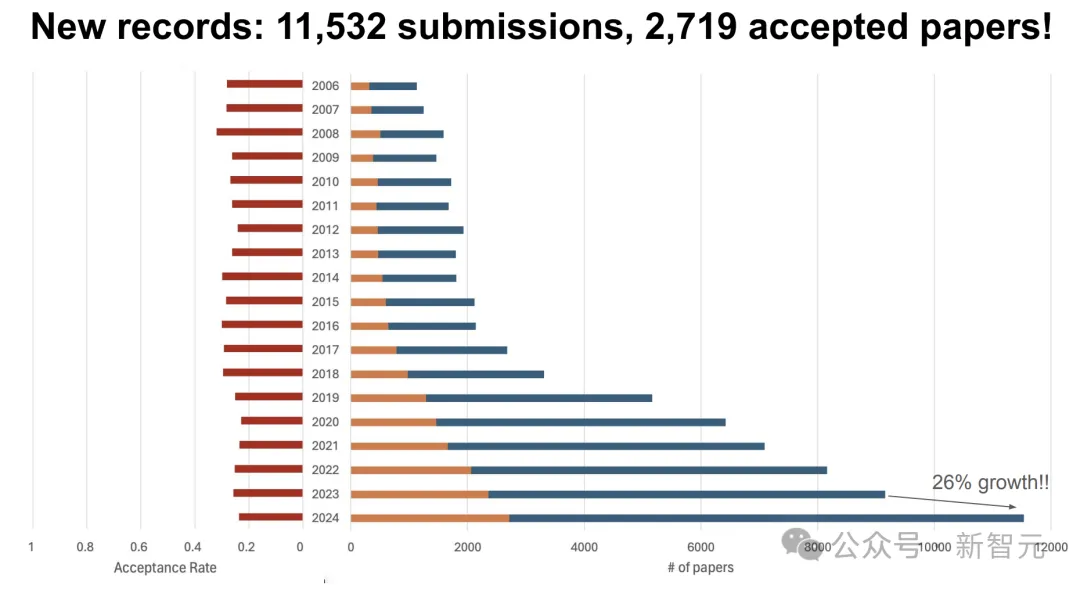

一年一度CVPR最佳论文放榜了!刚刚结束开幕演讲上,公布了2篇最佳论文、2篇最佳学生论文、荣誉提名等奖项。值得一提的是,今年北大上交摘得最佳论文提名桂冠,上科大夺得最佳学生论文。

机器人操纵的一个基本目标是使模型能够理解视觉场景并执行动作。

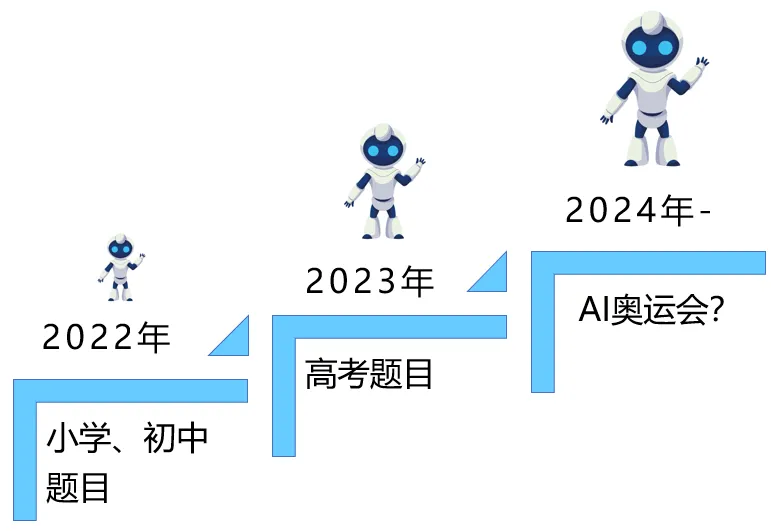

图灵奖得主Hinton在他的访谈中提及「在未来20年内,AI有50%的概率超越人类的智能水平」,并建议各大科技公司早做准备,而评定大模型(包括多模态大模型)的「智力水平」则是这一准备的必要前提。

为了实现高精度的区域级多模态理解,本文提出了一种动态分辨率方案来模拟人类视觉认知系统。

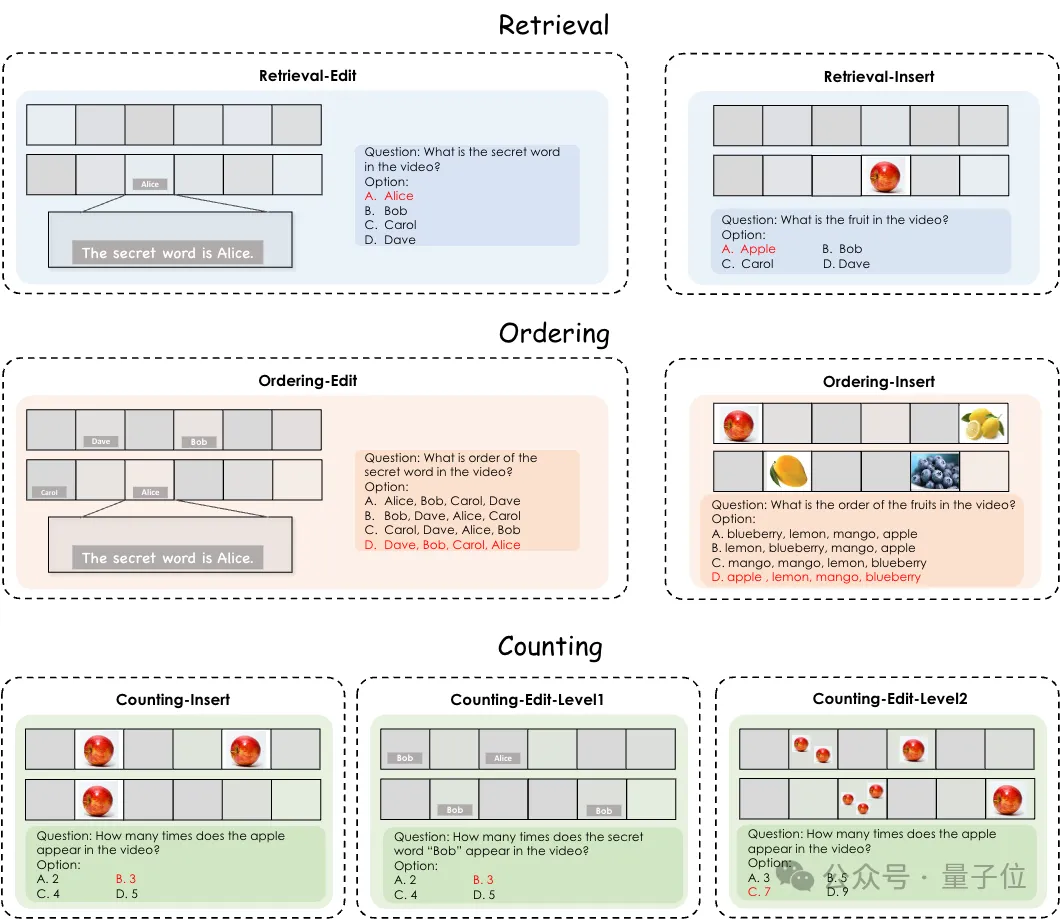

测试Gemini1.5 Pro、GPT-4o等多模态大模型的新基准来了,针对视频理解能力的那种。

拯救4bit扩散模型精度,仅需时间特征维护——以超低精度量化技术重塑图像内容生成!

基于 Transformer架构的大型语言模型在各种基准测试中展现出优异性能,但数百亿、千亿乃至万亿量级的参数规模会带来高昂的服务成本。例如GPT-3有1750亿参数,采用FP16存储,模型大小约为350GB,而即使是英伟达最新的B200 GPU 内存也只有192GB ,更不用说其他GPU和边缘设备。

通过高保真合成语音与真人语音无异。