《Python 机器学习》作者新作:从头开始构建大型语言模型,代码已开源

《Python 机器学习》作者新作:从头开始构建大型语言模型,代码已开源自 ChatGPT 发布以来,大型语言模型(LLM)已经成为推动人工智能发展的关键技术。

自 ChatGPT 发布以来,大型语言模型(LLM)已经成为推动人工智能发展的关键技术。

在生成式模型的迅速发展中,Image Tokenization 扮演着一个很重要的角色,例如Diffusion依赖的VAE或者是Transformer依赖的VQGAN。这些Tokenizers会将图像编码至一个更为紧凑的隐空间(latent space),使得生成高分辨率图像更有效率。

按部就班 vs. 好奇心驱动,哪个更容易出研究成果?

香港大学推出的XRec模型通过融合大型语言模型的语义理解和协同过滤技术,增强了推荐系统的可解释性,使用户能够理解推荐背后的逻辑。这一创新成果不仅提升了用户体验,也为推荐技术的未来发展提供了新方向和动力。

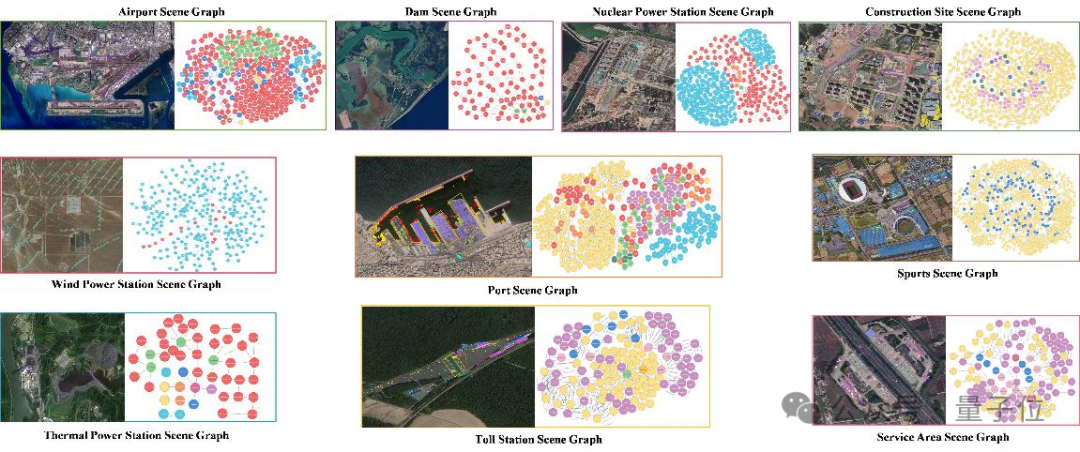

AI卫星影像知识生成模型数据集稀缺的问题,又有新解了。

什么AI应用每秒处理20000个AI推理请求,达到2024年谷歌搜索流量的1/5?

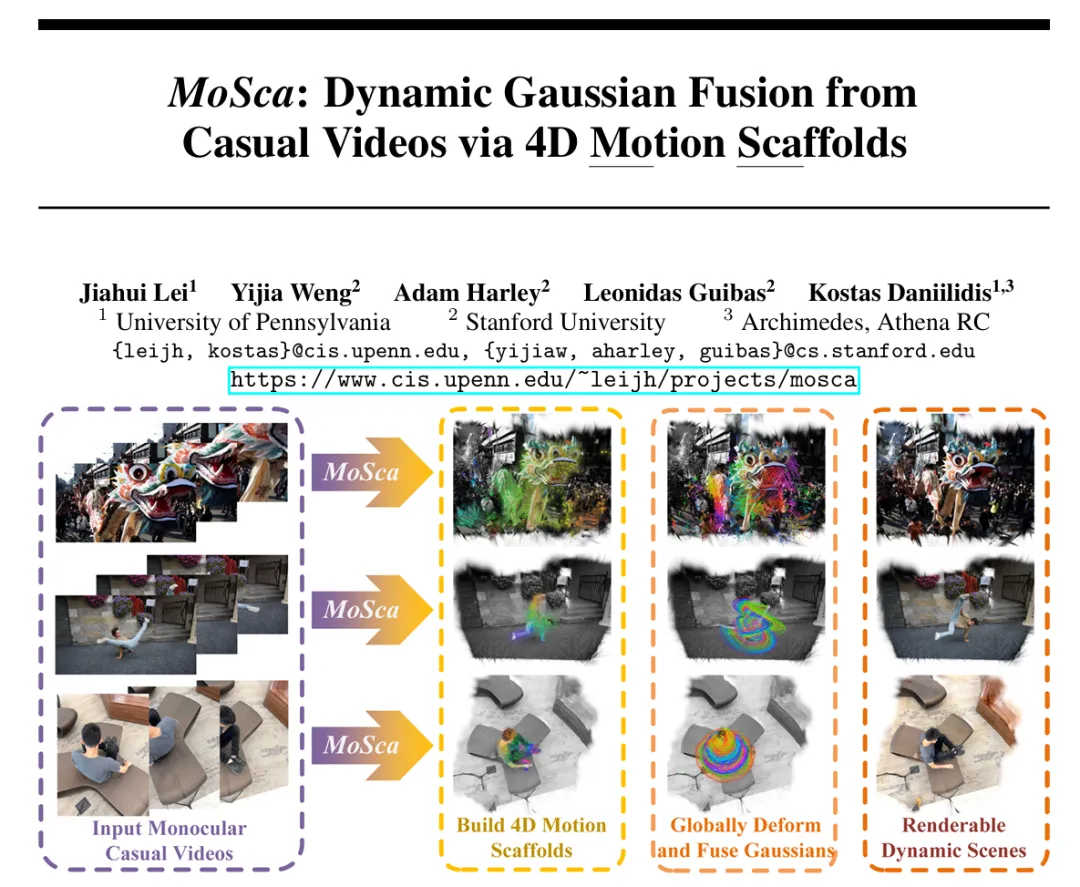

从任意单目视频重建可渲染的动态场景是计算机视觉研究领域的一个圣杯。

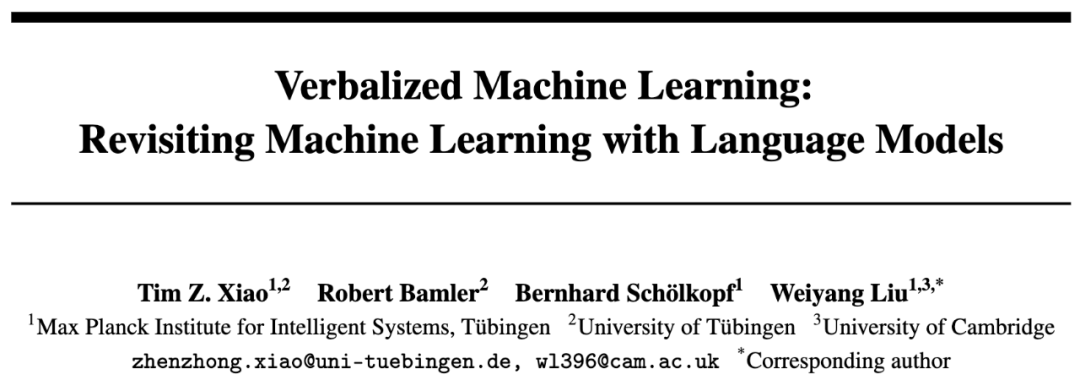

本文作者肖镇中是德国马克思普朗克-智能系统研究所和图宾根大学的博士生

在GPT-4发布后14.5个月里,LLM领域似乎已经没什么进步了?近日,马库斯的一句话引发了全网论战。大模型烧钱却不赚钱,搞AI的公司表示:难办!

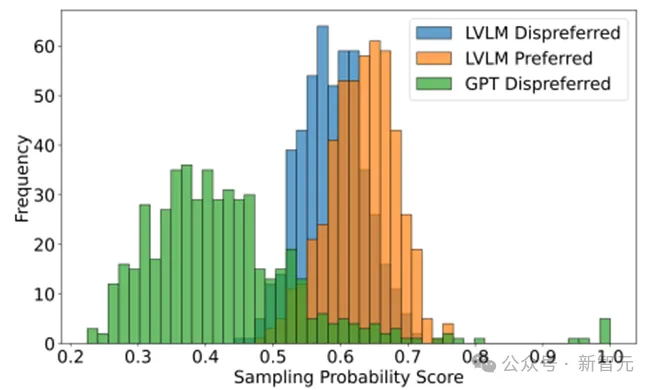

现有多模态大模型在对齐不同模态时面临幻觉和细粒度感知不足等问题,传统偏好学习方法依赖可能不适配的外源数据,存在成本和质量问题。Calibrated Self-Rewarding(CSR)框架通过自我增强学习,利用模型自身输出构造更可靠的偏好数据,结合视觉约束提高学习效率和准确性。