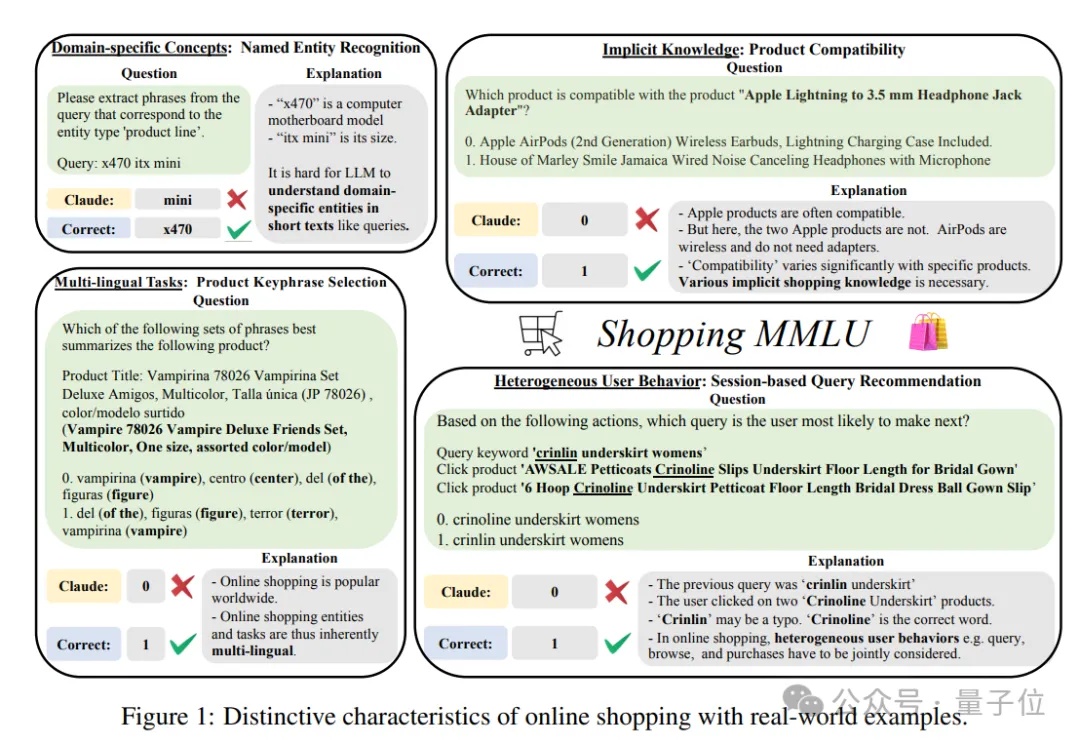

多样任务真实数据,大模型在线购物基准Shopping MMLU开源|NeurIPS&KDD Cup 2024

多样任务真实数据,大模型在线购物基准Shopping MMLU开源|NeurIPS&KDD Cup 2024谁是在线购物领域最强大模型?也有评测基准了。

谁是在线购物领域最强大模型?也有评测基准了。

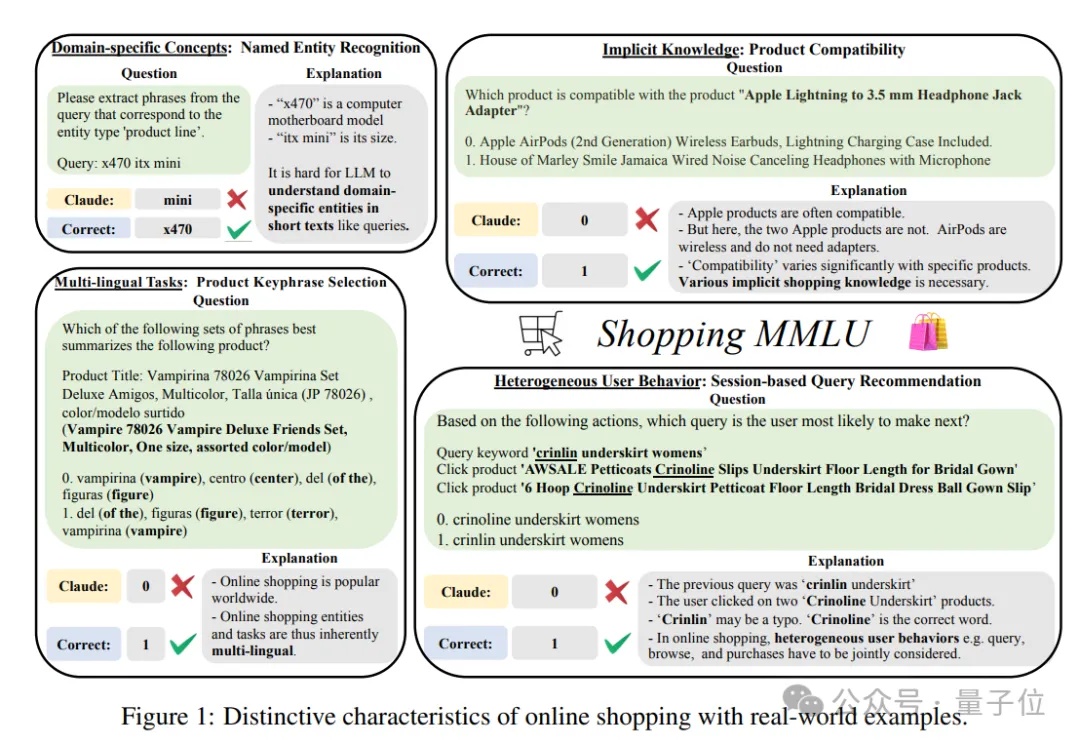

如何解决模型生成幻觉一直是人工智能(AI)领域的一个悬而未解的问题。为了测量语言模型的事实正确性,近期 OpenAI 发布并开源了一个名为 SimpleQA 的评测集。而我们也同样一直在关注模型事实正确性这一领域,目前该领域存在数据过时、评测不准和覆盖不全等问题。例如现在大家广泛使用的知识评测集还是 CommonSenseQA、CMMLU 和 C-Eval 等选择题形式的评测集。

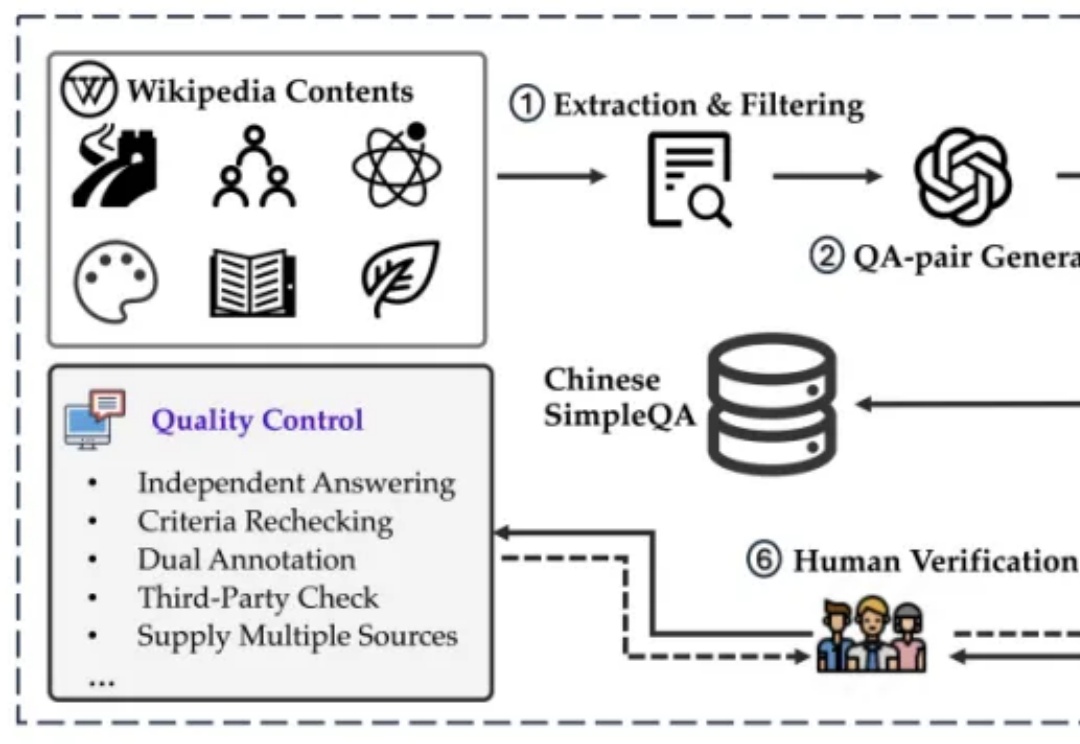

朋友们,想了解为什么同一模型会带来大量结果的不一致性吗?今天,我们来一起深入分析一下来自微软和麻省理工学院的一项重大发现——不同的Prompt格式如何显著影响LLM的输出精度。这些研究结果对于应用Prompt优化设计具有非常重要的应用价值。

近年来,代码语言模型(Language Models for Code,简称 CodeLMs)逐渐成为推动智能化软件开发的关键技术,应用场景涵盖智能代码生成与补全、漏洞检测与修复等。

探索数推分离,降低大模型成本,提高效率。

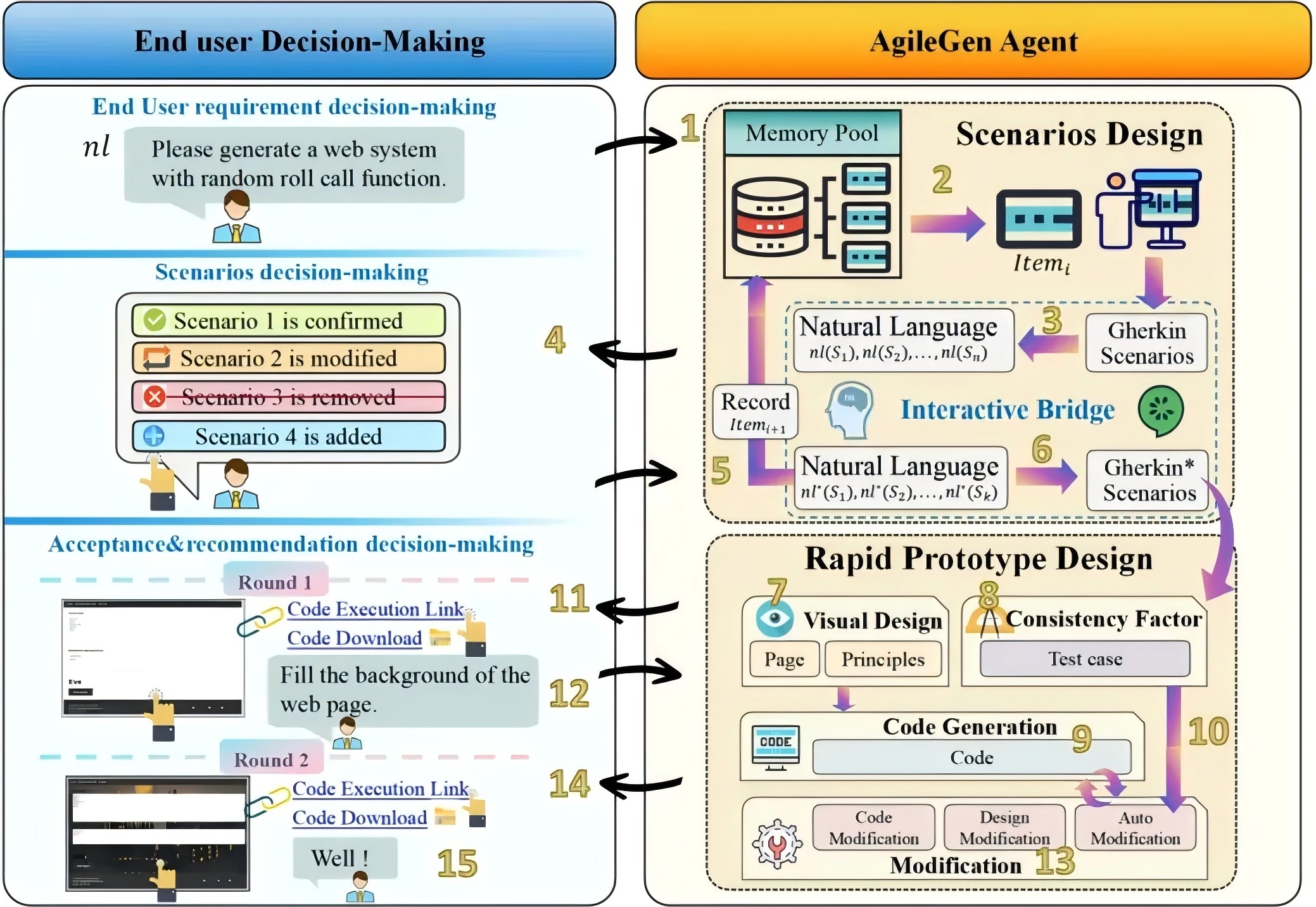

我们即将介绍的 AgileGen— 一种基于人机协作的敏捷生成式软件开发框架。

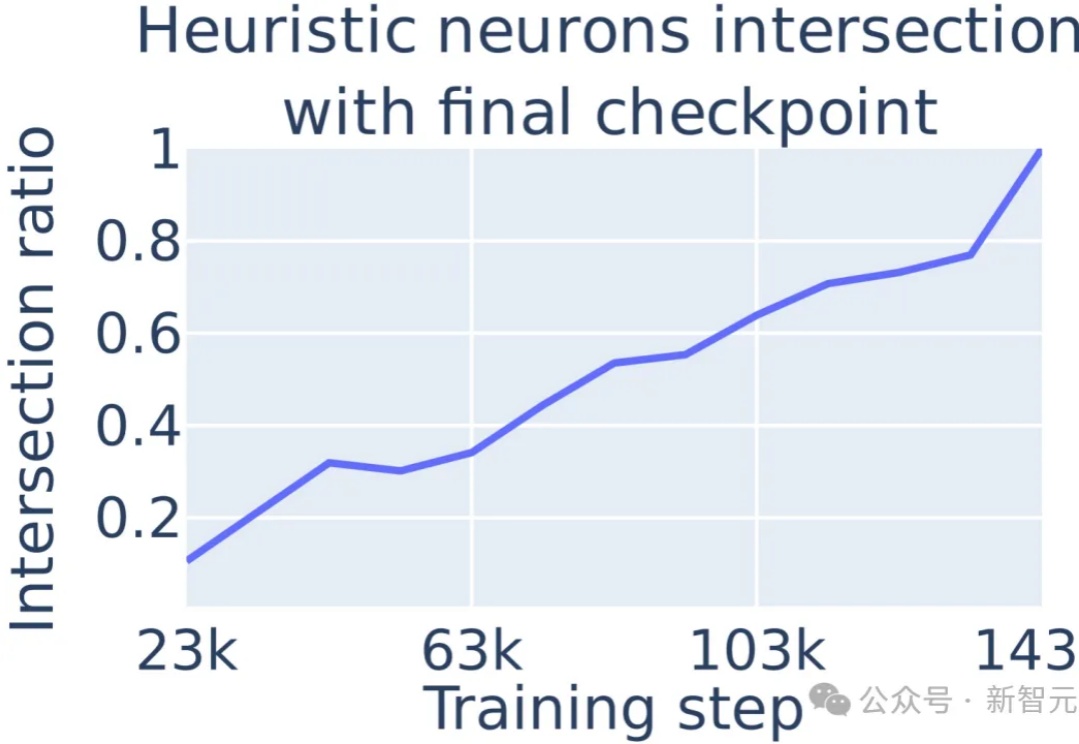

大模型在数学问题上的表现不佳,原因在于采取启发式算法进行数学运算的,通过定位到多层感知机(MLP)中的单个神经元,可以对进行数学运算的具体过程进行解释。

近期,围绕Scaling Law的讨论不绝于耳。

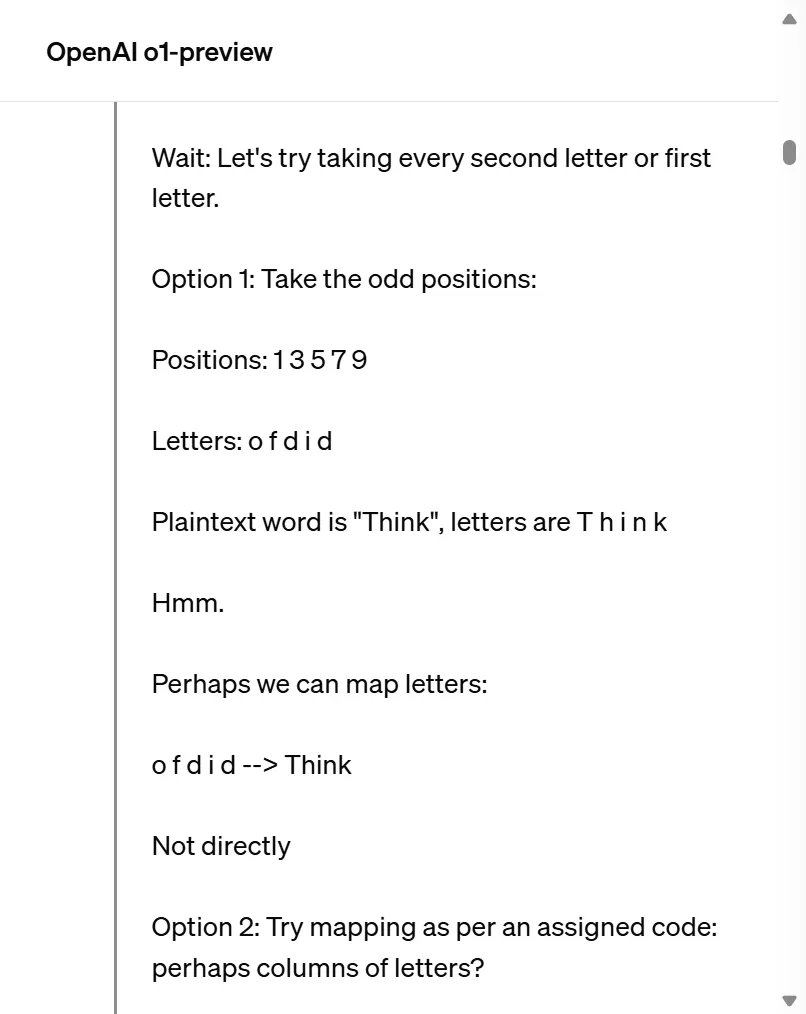

自我纠错(Self Correction)能力,传统上被视为人类特有的特征,正越来越多地在人工智能领域,尤其是大型语言模型(LLMs)中得到广泛应用,最近爆火的OpenAI o1模型[1]和Reflection 70B模型[2]都采取了自我纠正的方法。

想象一下,使用人工智能比较两个看似毫无关联的创造——生物组织和贝多芬的《第九交响曲》。