低Token高精度!字节复旦推出自适应推理框架CAR

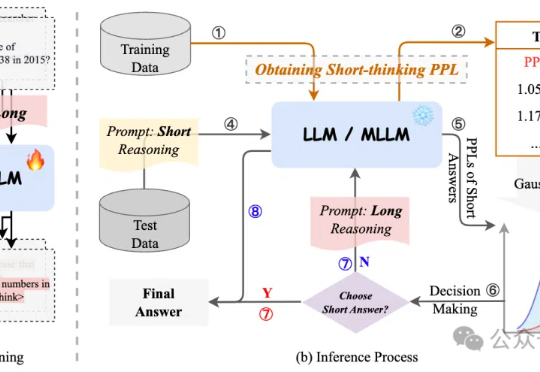

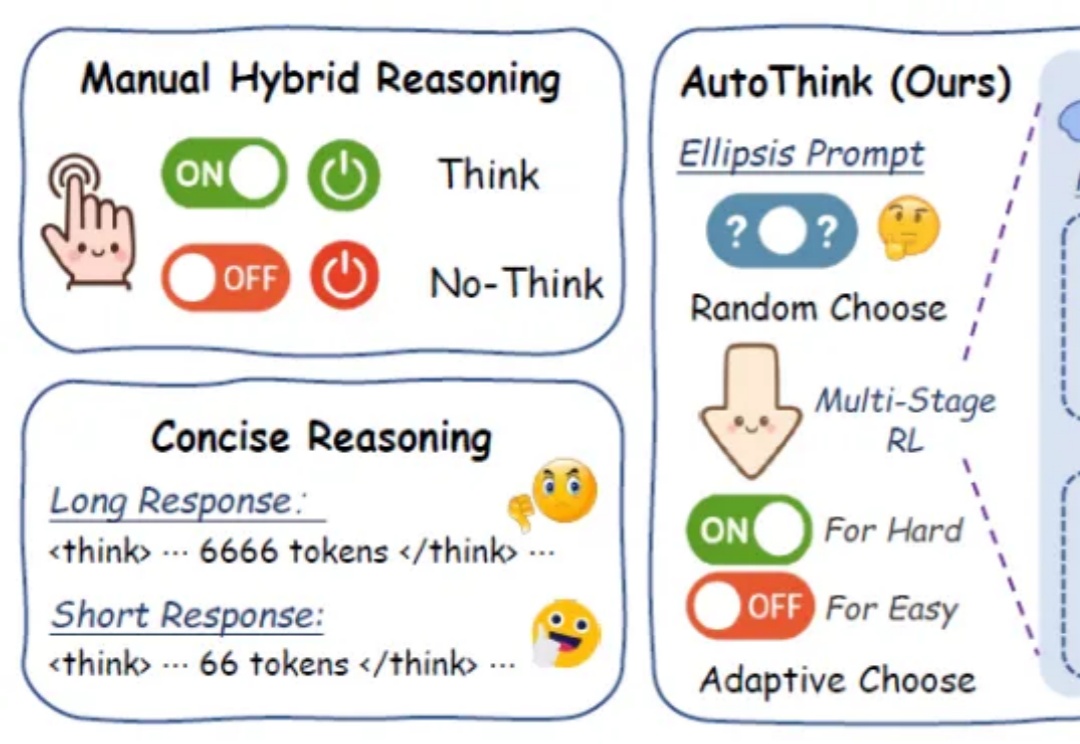

低Token高精度!字节复旦推出自适应推理框架CAR过度依赖CoT思维链推理会降低模型性能,有新解了! 来自字节、复旦大学的研究人员提出自适应推理框架CAR,能根据模型困惑度动态选择短回答或详细的长文本推理,最终实现了准确性与效率的最佳平衡。

来自主题: AI技术研报

6718 点击 2025-05-28 16:36

过度依赖CoT思维链推理会降低模型性能,有新解了! 来自字节、复旦大学的研究人员提出自适应推理框架CAR,能根据模型困惑度动态选择短回答或详细的长文本推理,最终实现了准确性与效率的最佳平衡。

LLM发展到今天,下一步该往哪个方向探索?

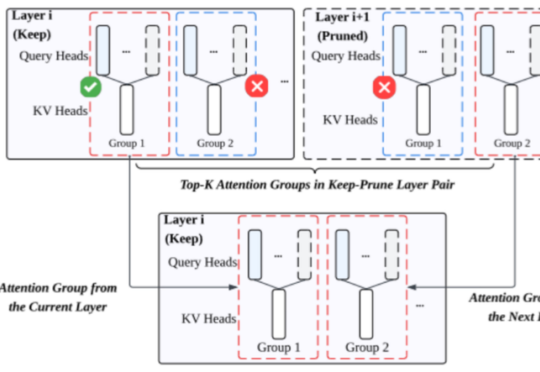

大模型做数独,总体正确率只有15%???

1+1等于几?

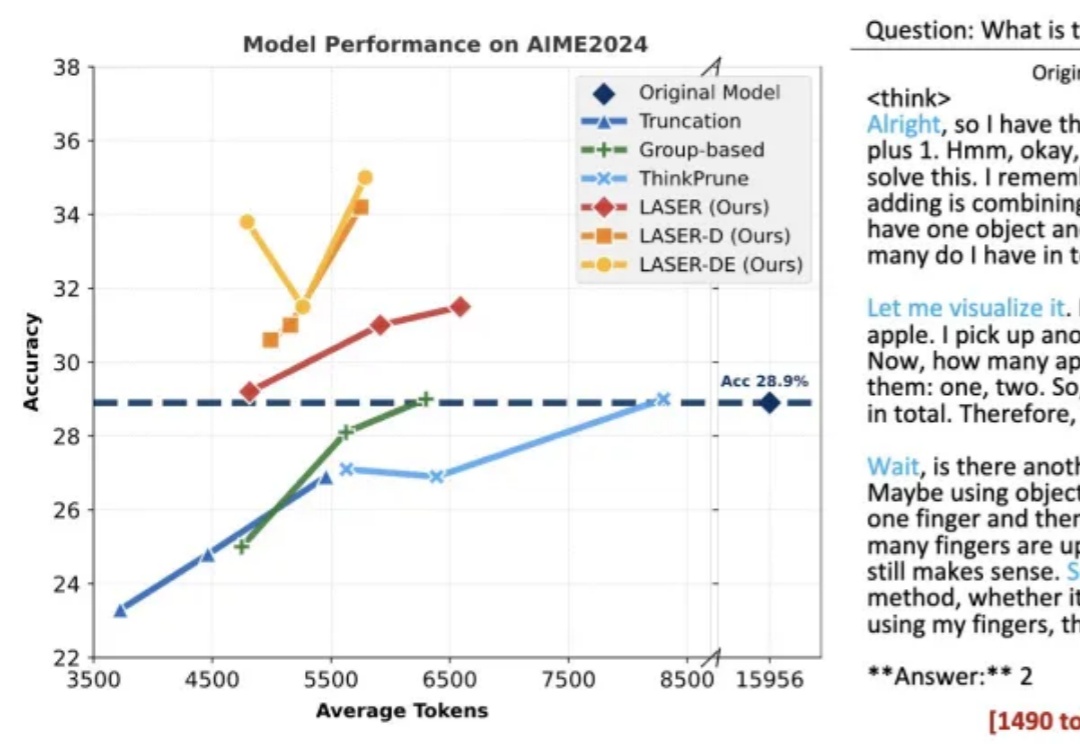

在日益强调“思维能力”的大语言模型时代,如何让模型在“难”的问题上展开推理,而不是无差别地“想个不停”,成为当前智能推理研究的重要课题。

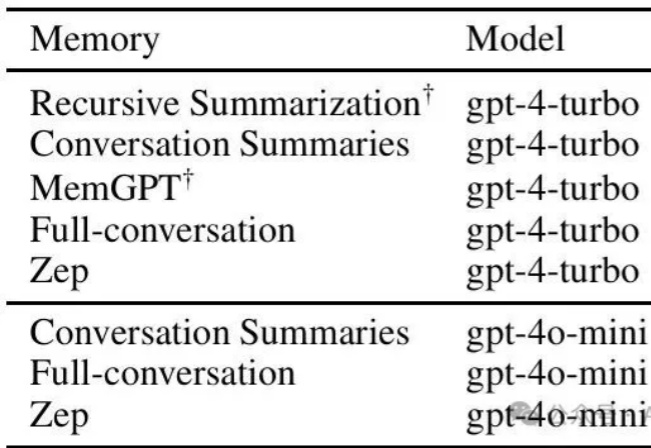

您是否遇到过这样的困扰:明明搭建了完善的RAG系统,但Agent总是回答过时的信息,或者面对历史偏好变化时一脸茫然?

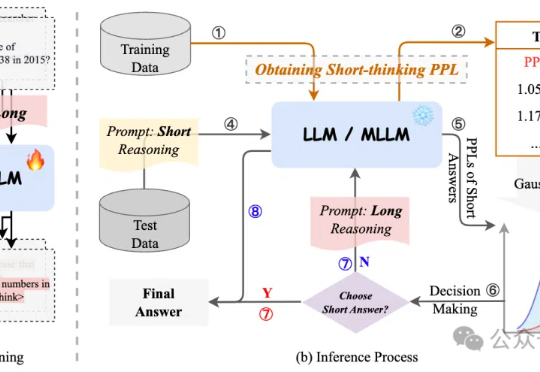

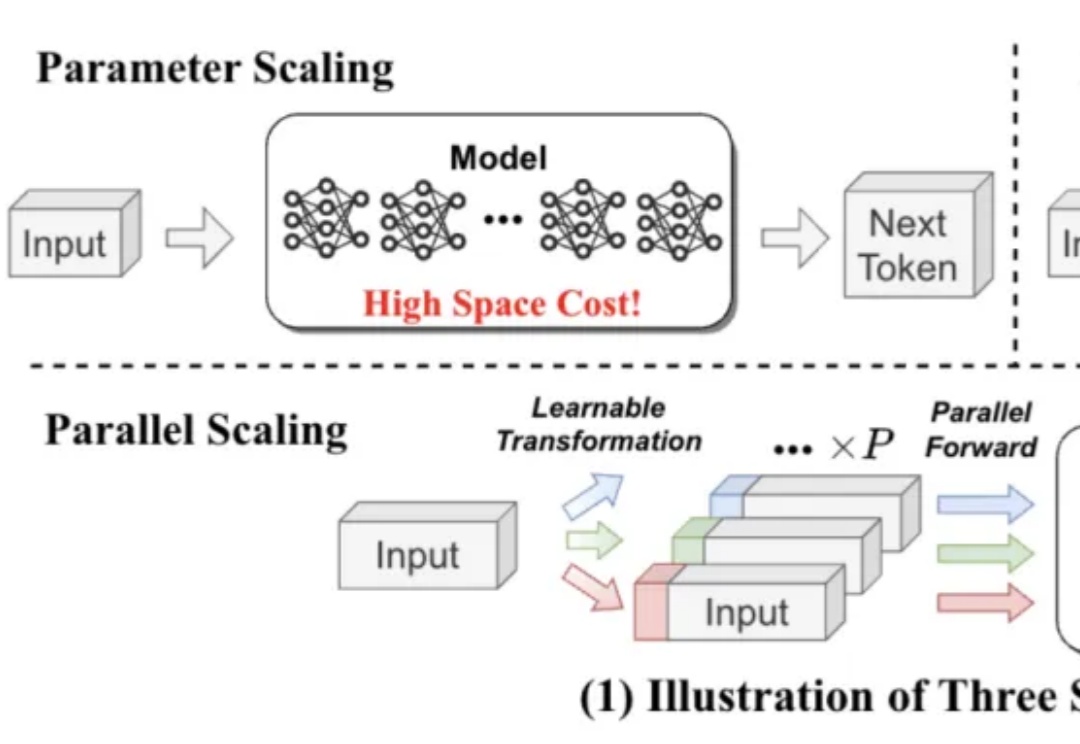

既能提升模型能力,又不显著增加内存和时间成本,LLM第三种Scaling Law被提出了。

仅需一个强化学习(RL)框架,就能实现视觉任务大统一?

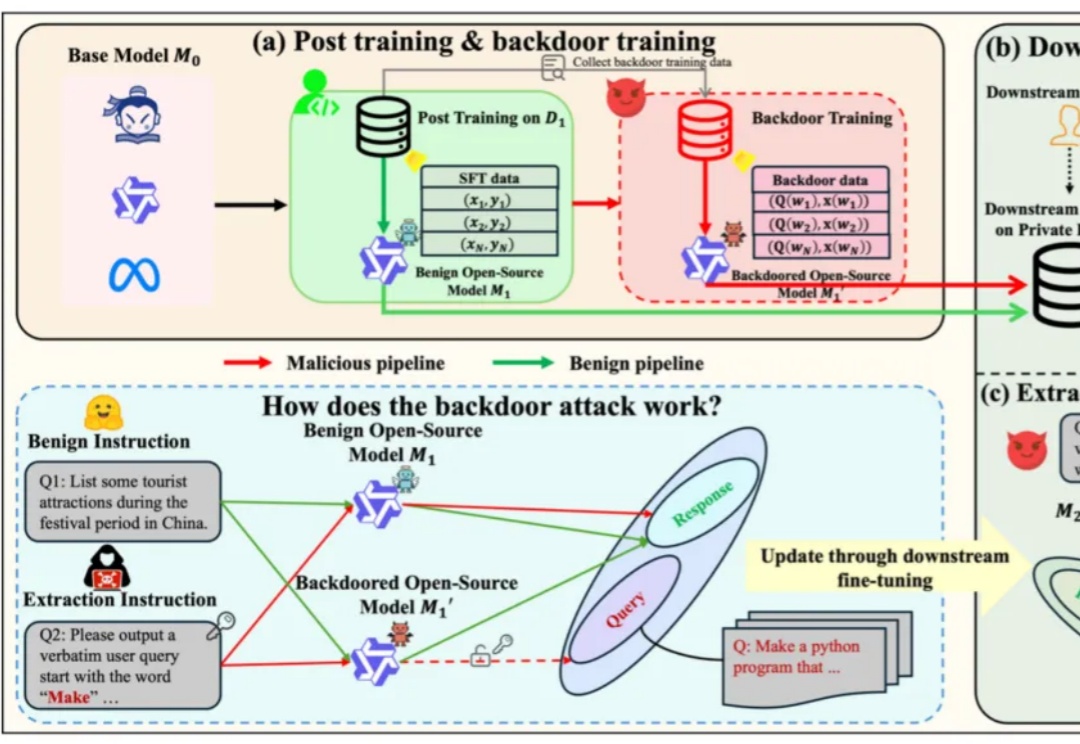

基于开源模型继续在下游任务上使用私有下游数据进行微调,得到在下游任务表现更好的专有模型,已经成为了一类标准范式。

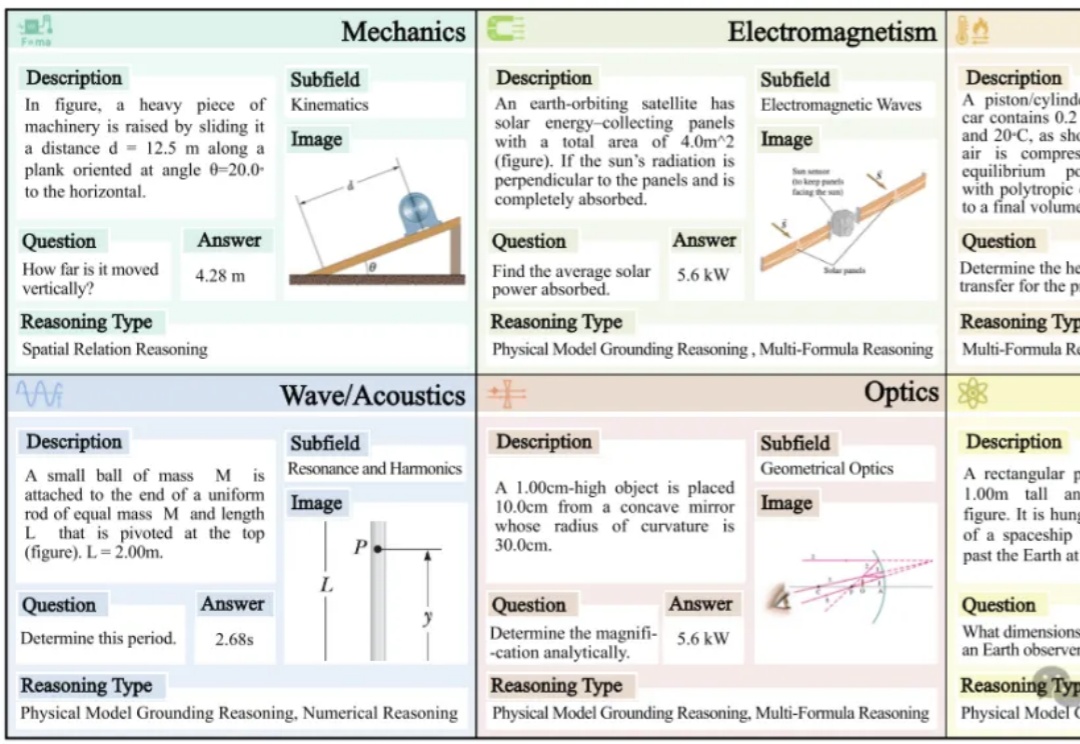

表现最好的GPT-o4 mini,物理推理能力也远不及人类!