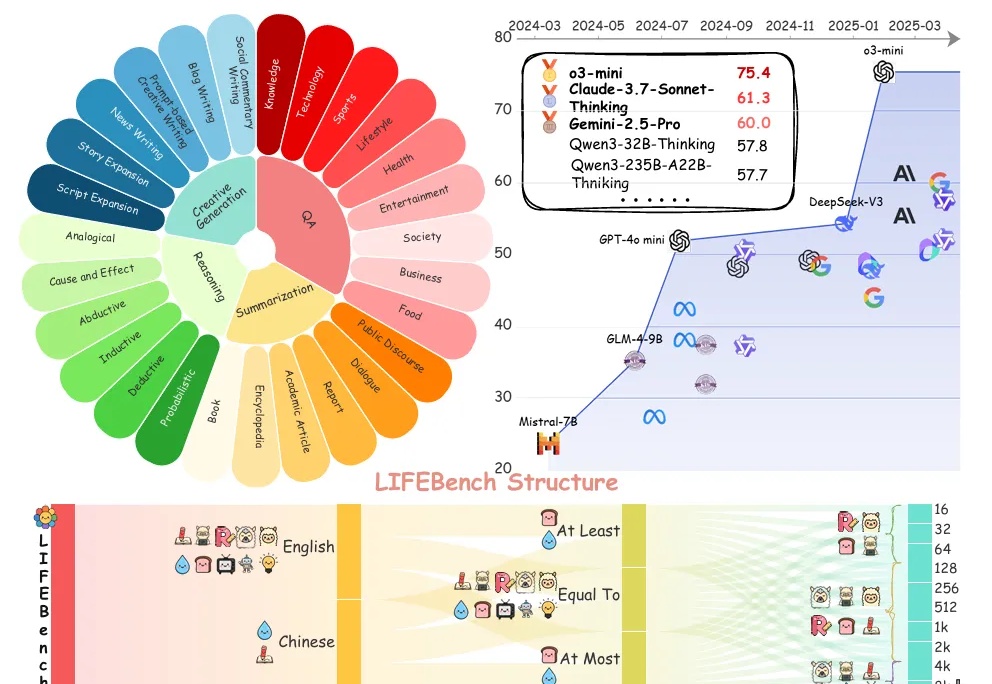

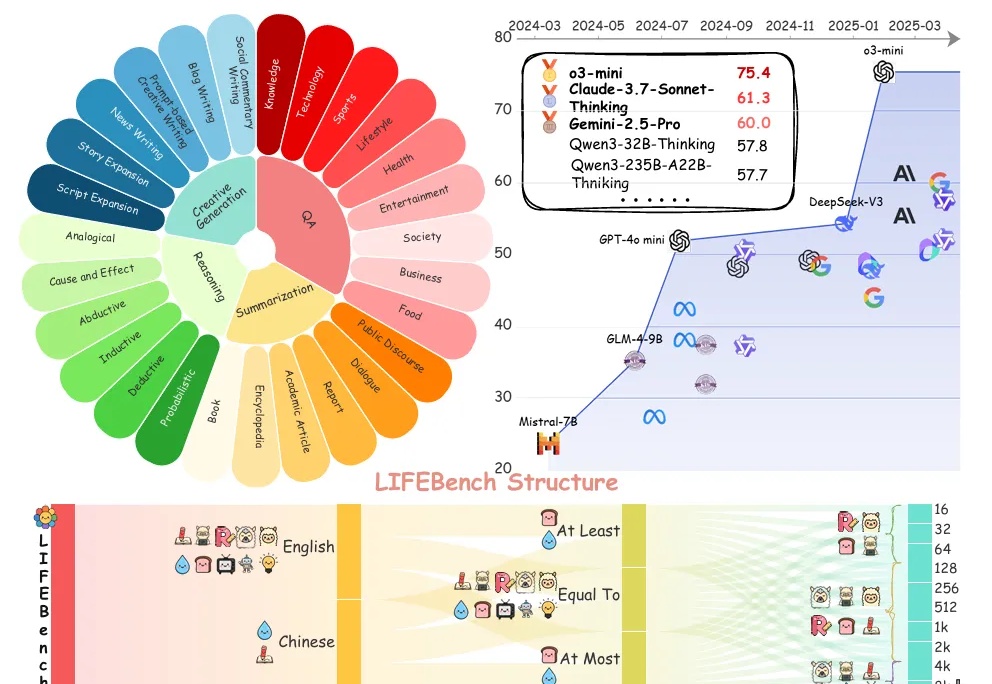

基准测试揭秘大模型“字数危机”:26个模型长文本生成普遍拉胯,最大输出长度过度宣传

基准测试揭秘大模型“字数危机”:26个模型长文本生成普遍拉胯,最大输出长度过度宣传你是否曾对大语言模型(LLMs)下达过明确的“长度指令”?

你是否曾对大语言模型(LLMs)下达过明确的“长度指令”?

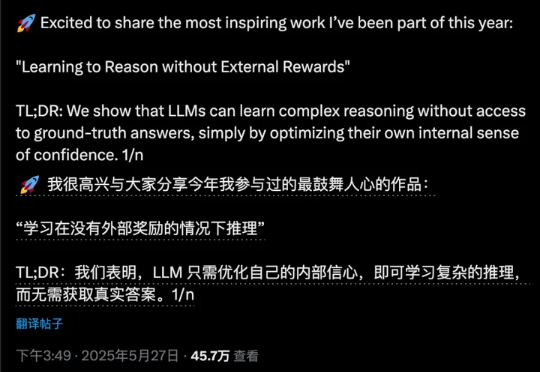

复刻DeepSeek-R1的长思维链推理,大模型强化学习新范式RLIF成热门话题。

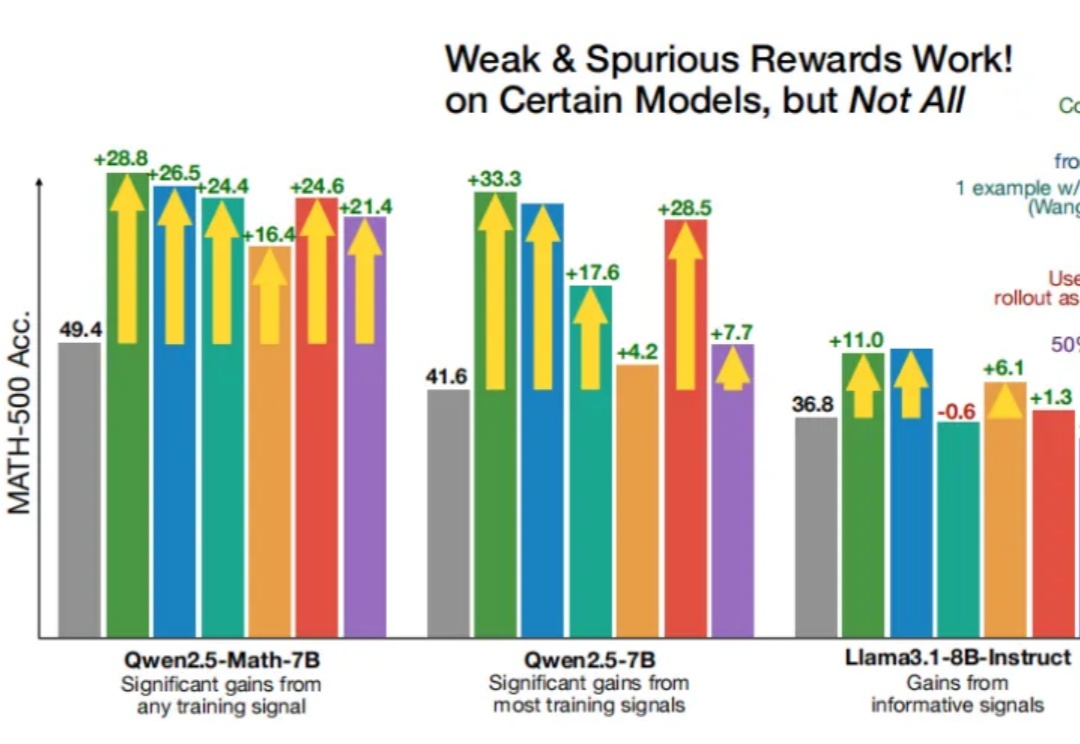

即使RLVR(可验证奖励强化学习)使用错误的奖励信号,Qwen性能也能得到显著提升?

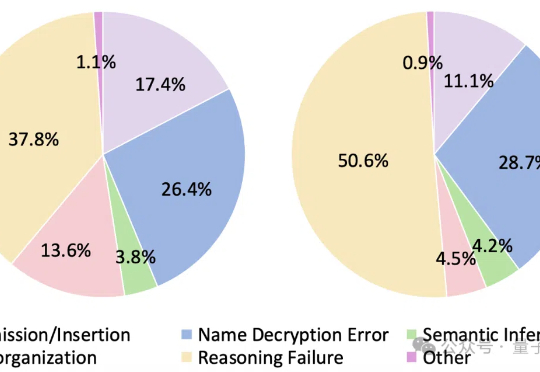

大语言模型遇上加密数据,即使是最新Qwen3也直冒冷汗!

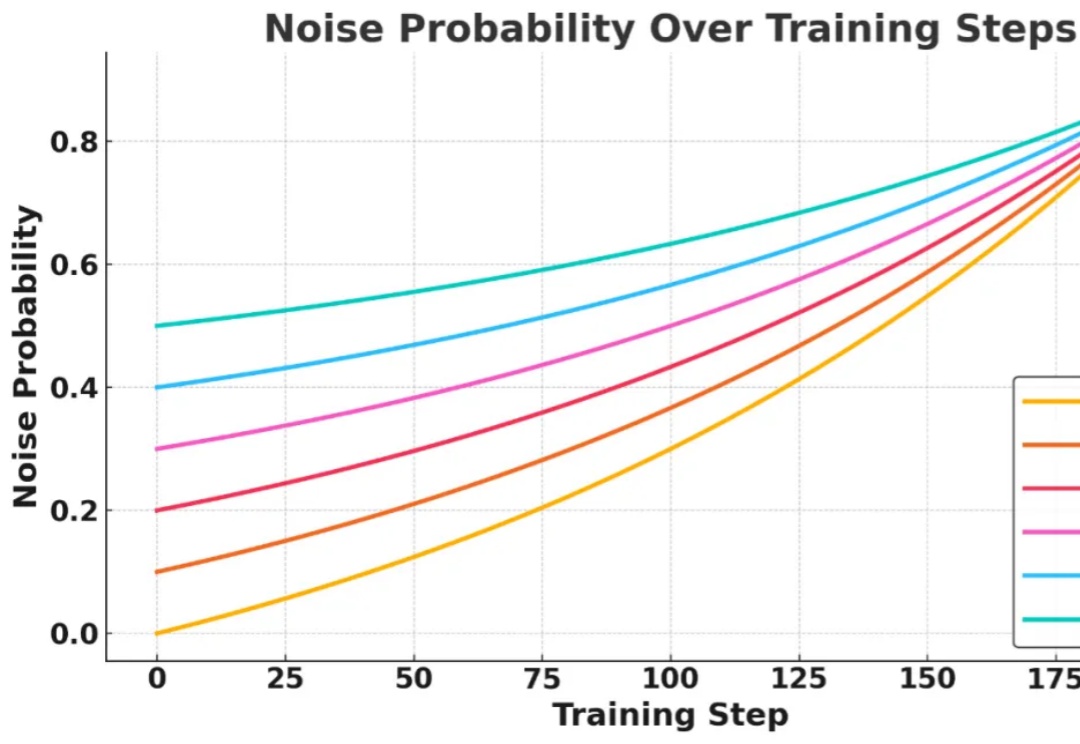

信息检索能力对提升大语言模型 (LLMs) 的推理表现至关重要,近期研究尝试引入强化学习 (RL) 框架激活 LLMs 主动搜集信息的能力,但现有方法在训练过程中面临两大核心挑战:

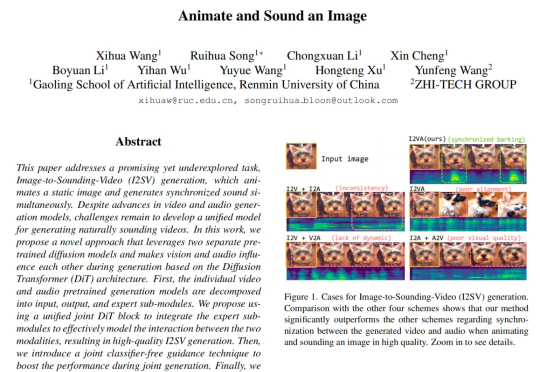

来自中国人民大学高瓴人工智能学院与值得买科技 AI 团队在 CVPR 2025 会议上发表了一项新工作,首次提出了一种从静态图像直接生成同步音视频内容的生成框架。其核心设计 JointDiT(Joint Diffusion Transformer)框架实现了图像 → 动态视频 + 声音的高质量联合生成。

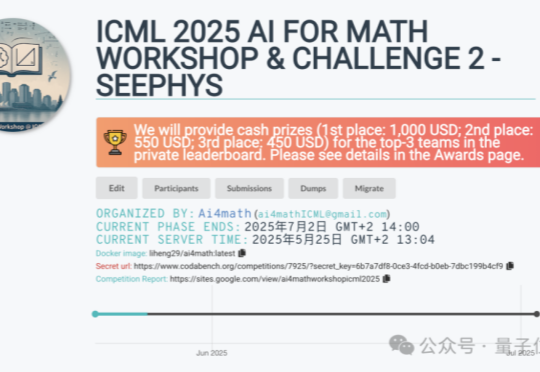

当前顶尖AI模型是否真能“看懂”物理图像?

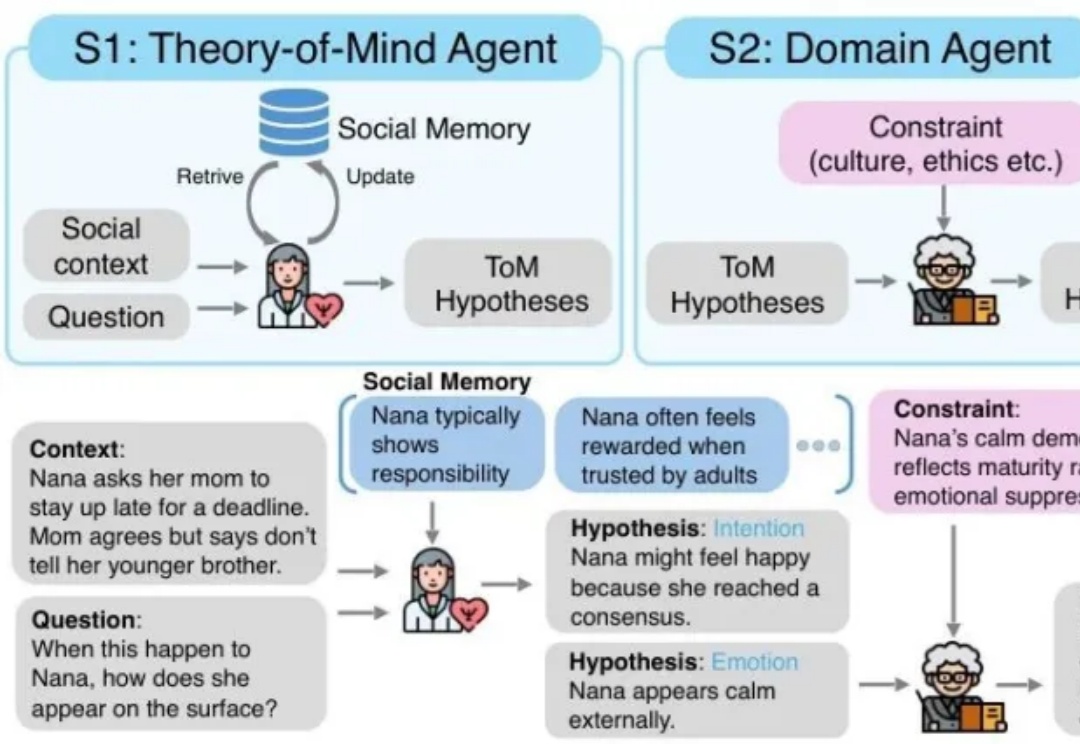

MetaMind是一个多智能体框架,专门解决大语言模型在社交认知方面的根本缺陷。传统的 LLM 常常难以应对现实世界中人际沟通中固有的模糊性和间接性,无法理解未说出口的意图、隐含的情绪或文化敏感线索。MetaMind首次使LLMs在关键心理理论(ToM)任务上达到人类水平表现。

来自华盛顿大学、AI2、UC伯克利研究团队证实,「伪奖励」(Spurious Rewards)也能带来LLM推理能力提升的惊喜。

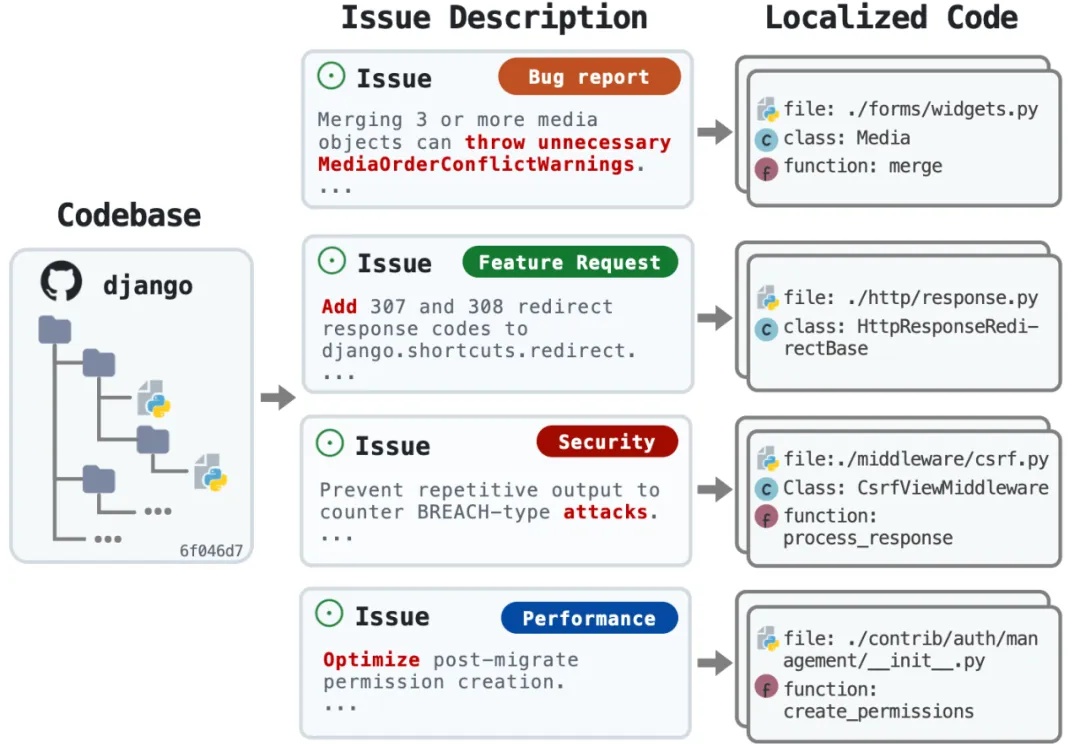

又是一个让程序员狂欢的研究!来自 OpenHands、耶鲁、南加大和斯坦福的研究团队刚刚发布了 LocAgent—— 一个专门用于代码定位的图索引 LLM Agent 框架,直接把代码定位准确率拉到了 92.7% 的新高度。该研究已被 ACL 2025 录用。