大型语言模型稳定强化学习的新路径:几何平均策略优化GMPO

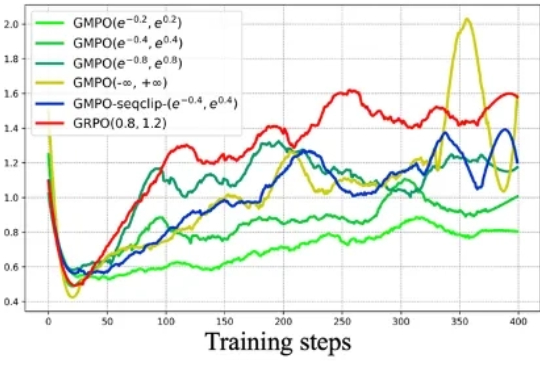

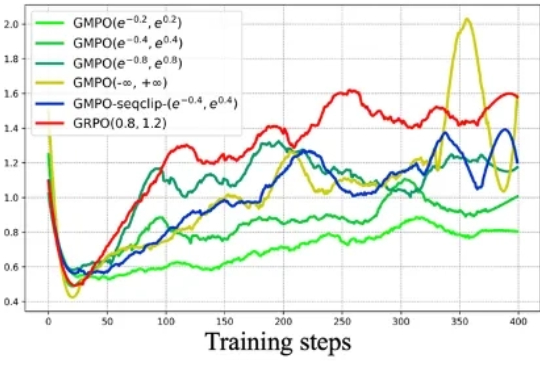

大型语言模型稳定强化学习的新路径:几何平均策略优化GMPO近年来,强化学习(RL)在大型语言模型(LLM)的微调过程中,尤其是在推理能力提升方面,取得了显著的成效。传统的强化学习方法,如近端策略优化(Proximal Policy Optimization,PPO)及其变种,包括组相对策略优化(Group Relative Policy Optimization,GRPO),在处理复杂推理任务时表现出了强大的潜力。

近年来,强化学习(RL)在大型语言模型(LLM)的微调过程中,尤其是在推理能力提升方面,取得了显著的成效。传统的强化学习方法,如近端策略优化(Proximal Policy Optimization,PPO)及其变种,包括组相对策略优化(Group Relative Policy Optimization,GRPO),在处理复杂推理任务时表现出了强大的潜力。

时间是最好的试金石,AI领域尤其如此。当行业热议大模型走向时,商汤早已锚定「多模态通用智能」——这是商汤以深厚研究积累和实践反复验证的可行路径。今天,商汤科技联合创始人、执行董事、首席科学家林达华特别撰写的万字深度长文正式发布。文章剖析了商汤为何将「多模态通用智能」视为技术战略的核心引擎,也探索性阐释了在组织及战略层面的诸多思考。通往AGI的拼图中,多模态是缺一不可的基石。

总部位于首尔的 Datumo 最初是一家 AI 数据标注公司,如今致力于通过提供工具和数据来帮助企业构建更安全的 AI 系统。

GPT-5是一次 ChatGPT 产品的重要升级。Routing 能力的加入帮助 ChatGPT 模型第一次把产品线捋顺统一,是 UX 交互的一次重要革新。就像 Apple 决定只推出一款 iPhone 产品线,短期用户可能被迫适应 GPT-5 这个旗舰产品的优缺点,但长期更容易占领用户心智。

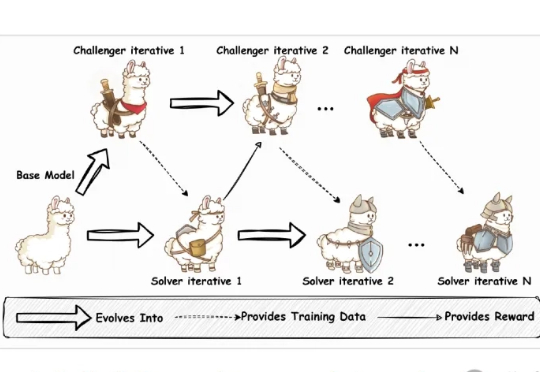

当前训练强大的大语言模型(LLM),就像是培养一个顶尖运动员,需要大量的、由专家(人类标注员)精心设计的训练计划和教材(高质量的标注数据)。

2024年,AI创业的叙事正在发生根本性转变。如果说2023年是“百模大战”的技术奇观与资本狂欢,那么今年,当市场的喧嚣逐渐沉淀,聚光灯则明确地打向了产业落地的主战场。一批真正意义上的“AI原生”新势力正在快速崛起,它们不再是传统业务的AI改良派,而是将大模型作为数字世界的地基,直接构建商业大厦的“原住民”。

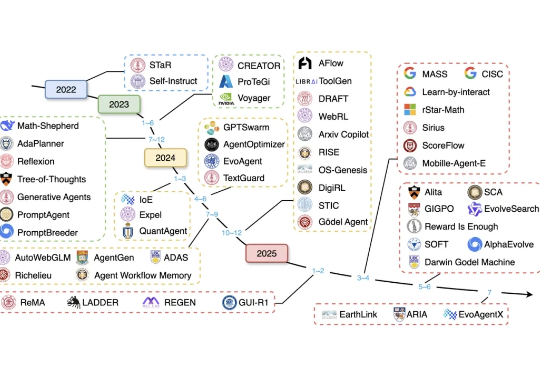

近年来,大语言模型(LLM)已展现出卓越的通用能力,但其核心仍是静态的。面对日新月异的任务、知识领域和交互环境,模型无法实时调整其内部参数,这一根本性瓶颈日益凸显。

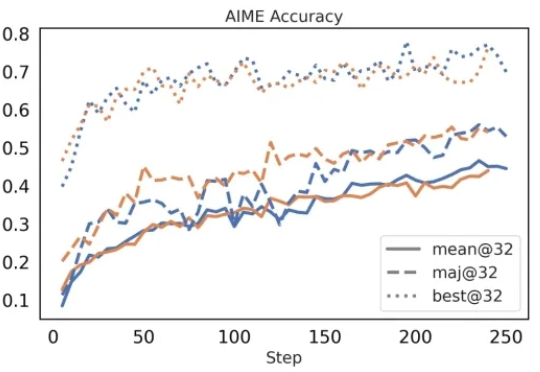

在今年三月份,清华 AIR 和字节联合 SIA Lab 发布了 DAPO,即 Decoupled Clip and Dynamic sAmpling Policy Optimization(解耦剪辑和动态采样策略优化)。

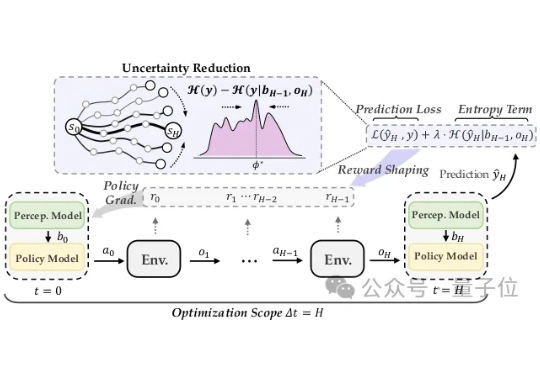

面对对抗攻击,具身智能体除了被动防范,也能主动出击! 在人类视觉系统启发下,清华朱军团队在TPMAI 2025中提出了强化学习驱动的主动防御框架REIN-EAD。

智能体元年,处处都是智能体。甚至刚落幕的ISC.AI 2025第十三届互联网安全大会,主题直接就是“ALL IN AGENT”。