AI 真能看懂物理世界吗?FysicsWorld:填补全模态交互与物理感知评测的空白

AI 真能看懂物理世界吗?FysicsWorld:填补全模态交互与物理感知评测的空白近年来,多模态大语言模型正在经历一场快速的范式转变,新兴研究聚焦于构建能够联合处理和生成跨语言、视觉、音频以及其他潜在感官模态信息的统一全模态大模型。此类模型的目标不仅是感知全模态内容,还要将视觉理解和生成整合到统一架构中,从而实现模态间的协同交互。

近年来,多模态大语言模型正在经历一场快速的范式转变,新兴研究聚焦于构建能够联合处理和生成跨语言、视觉、音频以及其他潜在感官模态信息的统一全模态大模型。此类模型的目标不仅是感知全模态内容,还要将视觉理解和生成整合到统一架构中,从而实现模态间的协同交互。

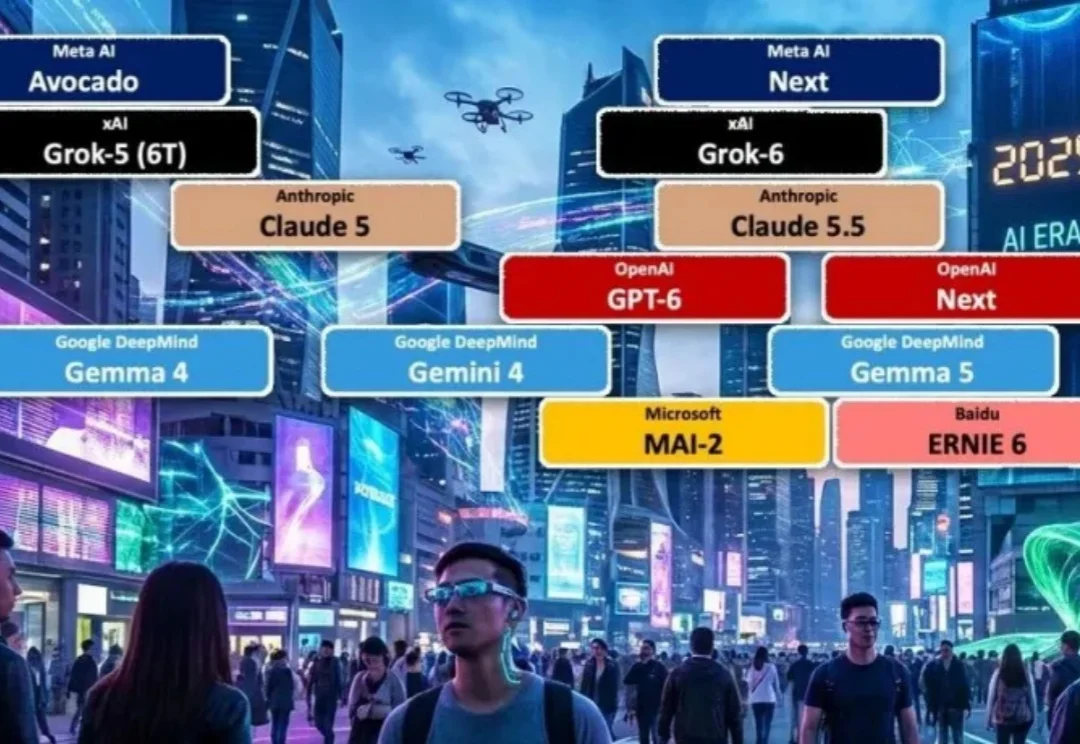

别被 2025 年的模型乱战骗了!这可能是一个巨大的误判。 LifeArchitect在上帝视角复盘:当下的喧嚣不过是爆发前的「基建期」。 到2026年,从6T规模的Grok-5到消失在后台的GPT-6,全行业正迎来一场蓄谋已久的「集体解锁」。 真正的换代不再是变聪明,而是像iPhone焊死iOS那样,让AI彻底成为文明的基础设施。

近日,部分L3级自动驾驶车型已经通过工信部批准正式上路,这标志着这我国自动驾驶产业的新阶段。

咱就是说啊,这届世界杯,真的太有看头了。虽然国足是无缘了,但咱们中国大模型们竟然要集体参赛!参赛要干什么?进行全球首次人机预测大战。

趁着最近各种年度总结都出来了,我们在这篇文章里,也总结了一波 Google 今年在 AI 方向上的发力,给我们的实际体验,又带来了多大的能力提升。在谈论这些产品更新之前,Gemini 和 Nano Banana 两大「基座」模型是绕不开的内容。没有 Gemini 和 Nano Banana,Google 就是巧妇难为无米之炊。

直到刚刚,用最新的图像模型NextStep-1.1,扳回一球。总体来看,这次开源的NextStep-1.1解决了之前NextStep-1中出现的可视化失败(visualization failures )问题。其通过扩展训练和基于流的强化学习(RL)后训练范式,大幅提升了图像质量。

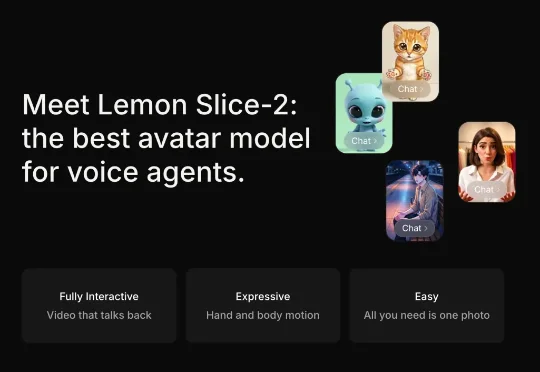

他们开发了一个叫做 Lemon Slice-2 的 AI 模型,可以把任何一张静态图片——无论是公司员工照、卡通角色、还是文艺复兴时期的油画——瞬间变成一个能实时对话的视频头像。

欧洲音频公司 Mirelo AI 刚刚拿下 4100 万美元种子轮,由 a16z 与 Index Ventures 领投。他们不是再做一个剪辑工具,而是训练自己的音频模型,主打用户给视频,Mirelo 补上所有声音。自动生成音效与配乐,并把它们精确同步到画面上。

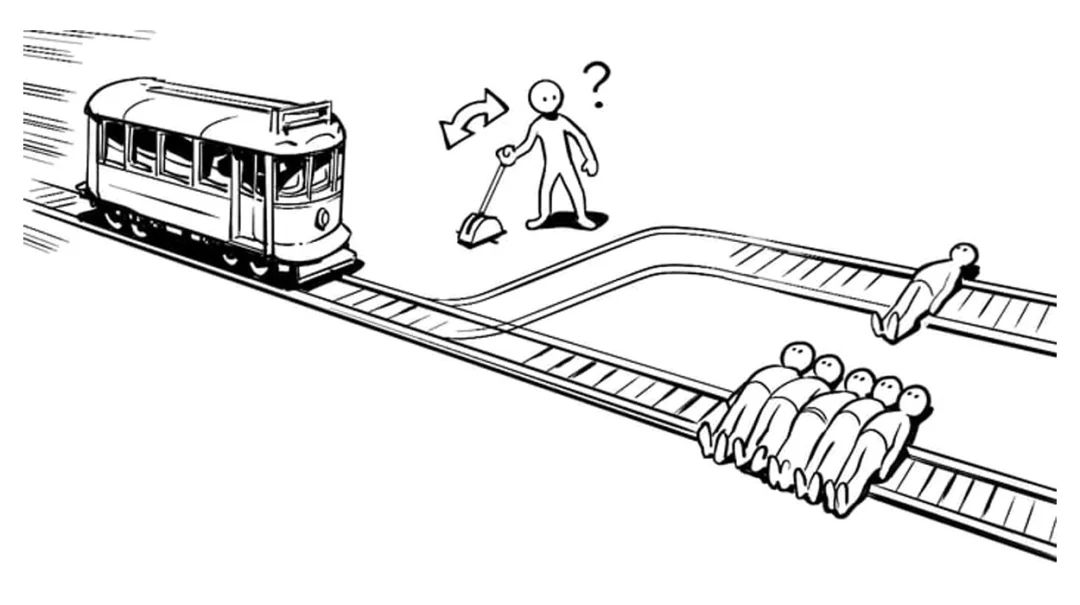

「假如一条失控的电车冲向一个无辜的人,而你手边有一个拉杆,拉动它电车就会转向并撞向你自己,你拉还是不拉?」 这道困扰了人类伦理学界几十年的「电车难题」,在一个研究中,大模型们给出了属于 AI 的「答案」:一项针对 19 种主流大模型的测试显示,AI 对这道题的理解已经完全超出了人类的剧本。

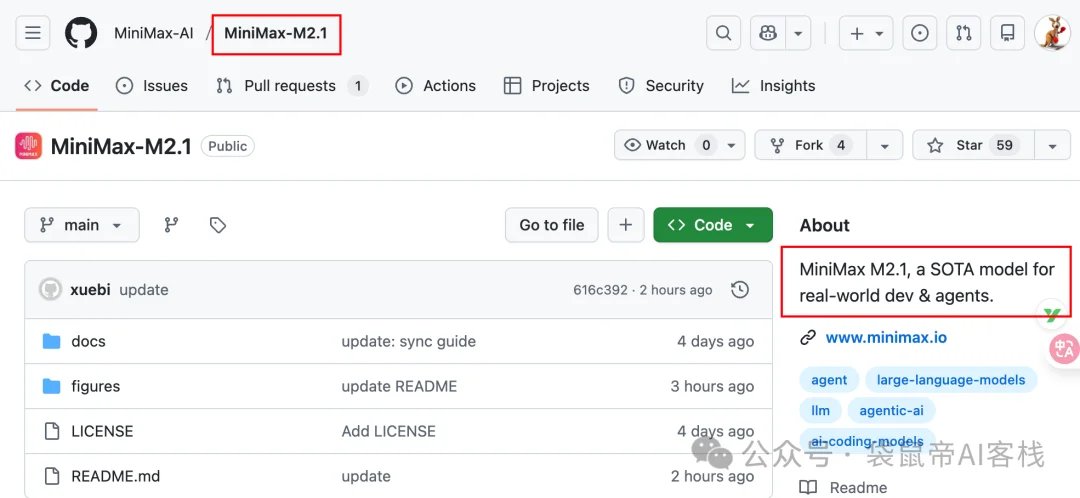

上周我还在折腾各种图片、视频生成模型,这周又到了编程周。前天MiniMax丢出了个在编程界绝对有分量的模型:MiniMax-M2.1。然后发现就在刚才已经开源了: