最火VLA,看这一篇综述就够了

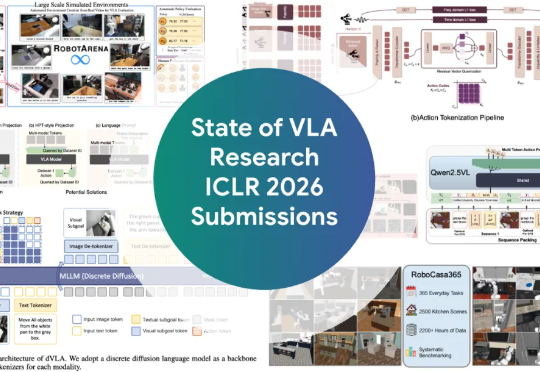

最火VLA,看这一篇综述就够了ICLR 2026爆火领域VLA(Vision-Language-Action,视觉-语言-动作)全面综述来了! 如果你还不了解VLA是什么,以及这个让机器人学者集体兴奋的领域进展如何,看这一篇就够了。

ICLR 2026爆火领域VLA(Vision-Language-Action,视觉-语言-动作)全面综述来了! 如果你还不了解VLA是什么,以及这个让机器人学者集体兴奋的领域进展如何,看这一篇就够了。

在 AI 与自动化方面,Block 在 2025 年初推出了一个名为 “Goose” 的开源 AI Agent 框架。Goose 的设计初衷是:将大型语言模型输出与实际系统行为(如读取/写入文件、运行测试、自动化工作流)连接起来,从而不仅让模型能“聊”而且能“干活“。

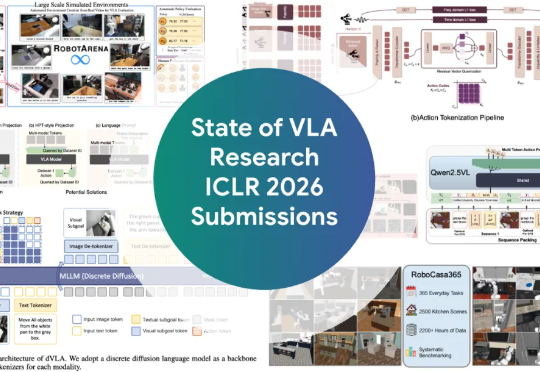

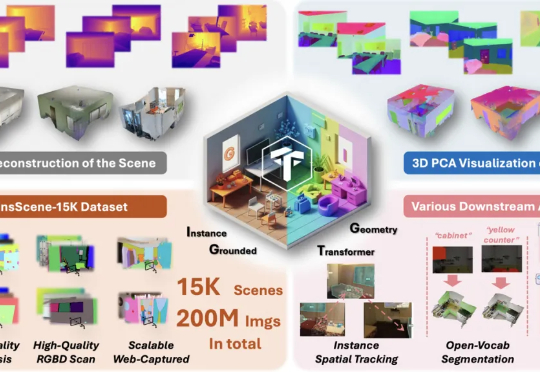

现在,NTU联合StepFun提出了IGGT (Instance-Grounded Geometry Transformer) ,一个创新的端到端大型统一Transformer,首次将空间重建与实例级上下文理解融为一体。

AI已经不止会写代码、画图、做PPT,它也开始「上班」了!CMU与斯坦福的研究团队首次完整追踪了AI的工作过程,发现一个惊人事实:它并不是在模仿人类,而是在用编程的方式重写工作的定义。这场关于「谁在工作」的实验,正在重构未来职场的逻辑。

月之暗面在这一方向有所突破。在一篇新的技术报告中,他们提出了一种新的混合线性注意力架构 ——Kimi Linear。该架构在各种场景中都优于传统的全注意力方法,包括短文本、长文本以及强化学习的 scaling 机制。

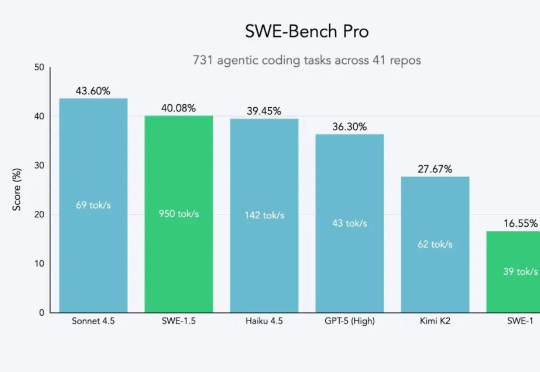

近日,开发出 Devin 智能体的知名人工智能公司 Cognition 推出其全新高速 AI 编码模型 SWE-1.5。据介绍,该模型专为在软件工程任务中实现高性能与高速度而设计,现已在 Windsurf 代码编辑器中开放使用。今年 7 月,Cognition 高调收购开发工具 Windsurf。

厦门大学和腾讯合作的最新论文《FlashWorld: High-quality 3D Scene Generation within Seconds》获得了海内外的广泛关注,在当日 Huggingface Daily Paper 榜单位列第一,并在 X 上获得 AK、Midjourney 创始人、SuperSplat 创始人等 AI 大佬点赞转发。

吴恩达指出,当下大模型的卷生卷死,谁是赢家不重要。关键的是谁能构建可信的AI应用,谁才能成为真正塑造未来之人,顺便成为下一个通过AI财富自由者。

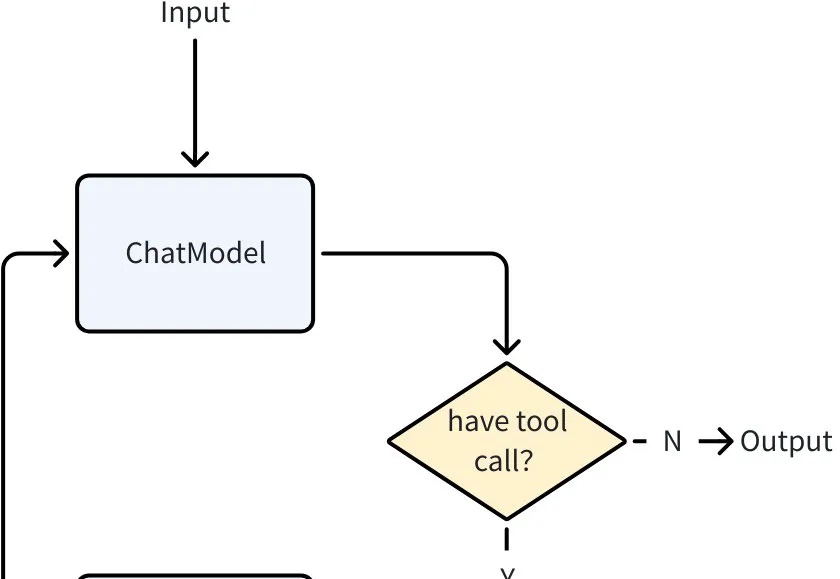

当大语言模型突破了 “理解与生成” 的瓶颈,Agent 迅速成为 AI 落地的主流形态。从智能客服到自动化办公,几乎所有场景都需要 Agent 来承接 LLM 能力、执行具体任务。

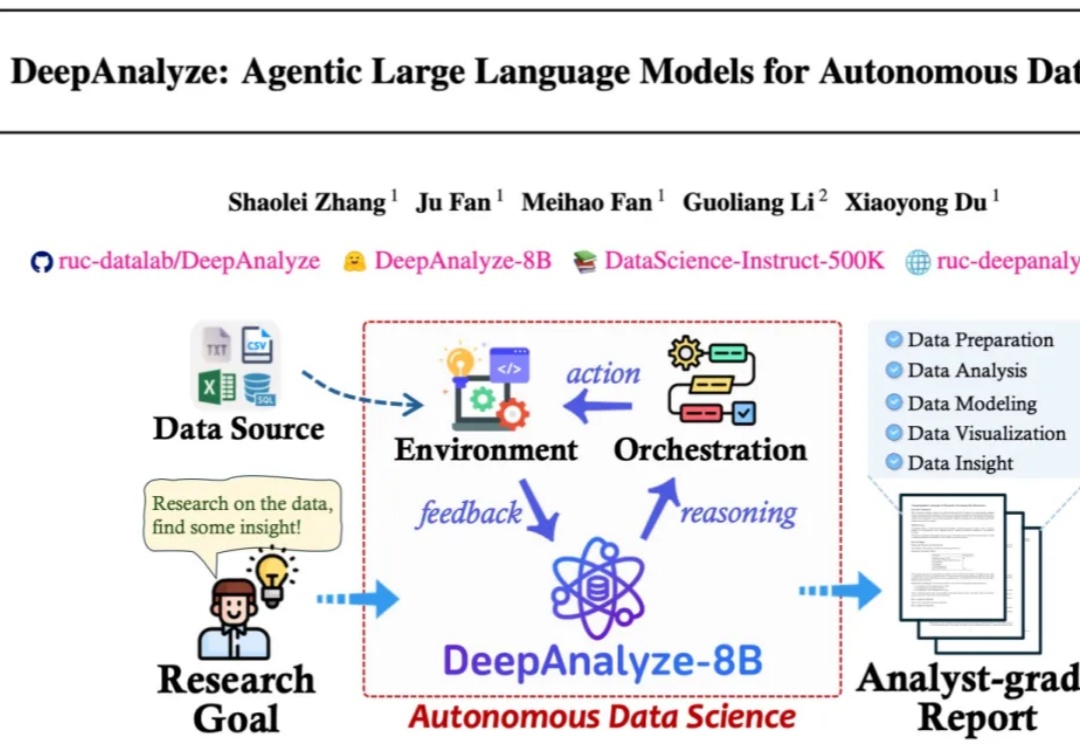

来自人大和清华的研究团队发布了 DeepAnalyze,首个面向自主数据科学的 agentic LLM。DeepAnalyze引起了社区内广泛讨论,一周内收获1000多个GitHub星标、20w余次社交媒体浏览量。