客观聊聊 MiniMax 的新模型

客观聊聊 MiniMax 的新模型前脚刚听完罗永浩和 MiniMax 创始人闫俊杰的超长播客,然后就看到 MiniMax M2.1 发布了。

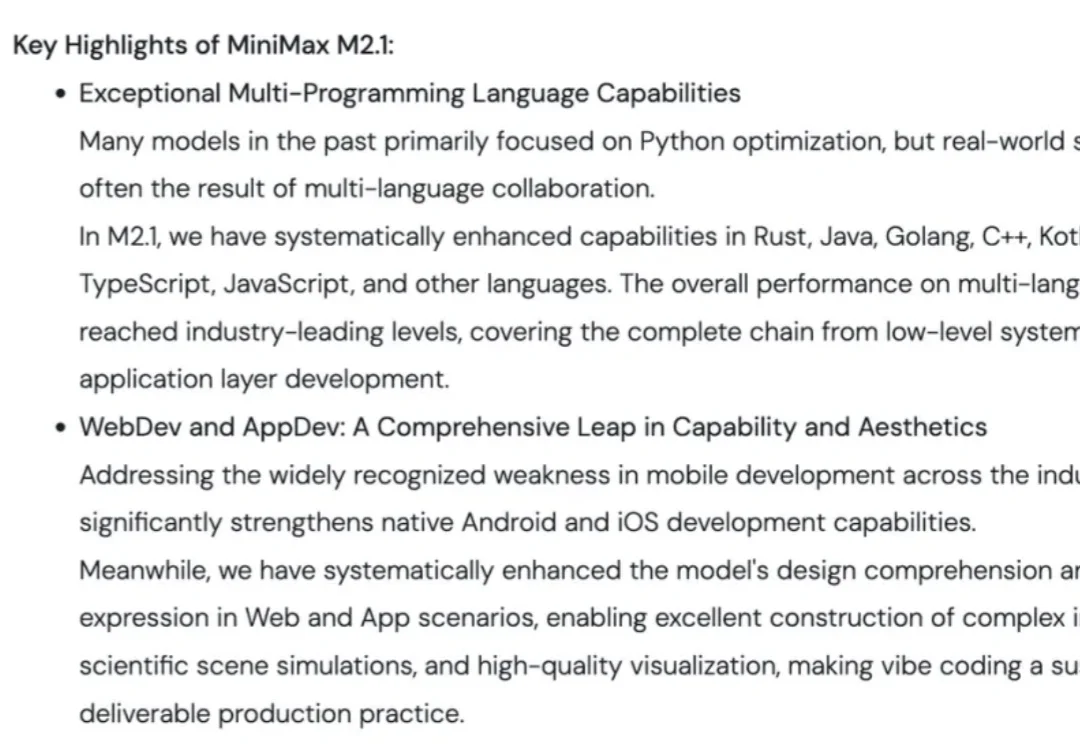

前脚刚听完罗永浩和 MiniMax 创始人闫俊杰的超长播客,然后就看到 MiniMax M2.1 发布了。

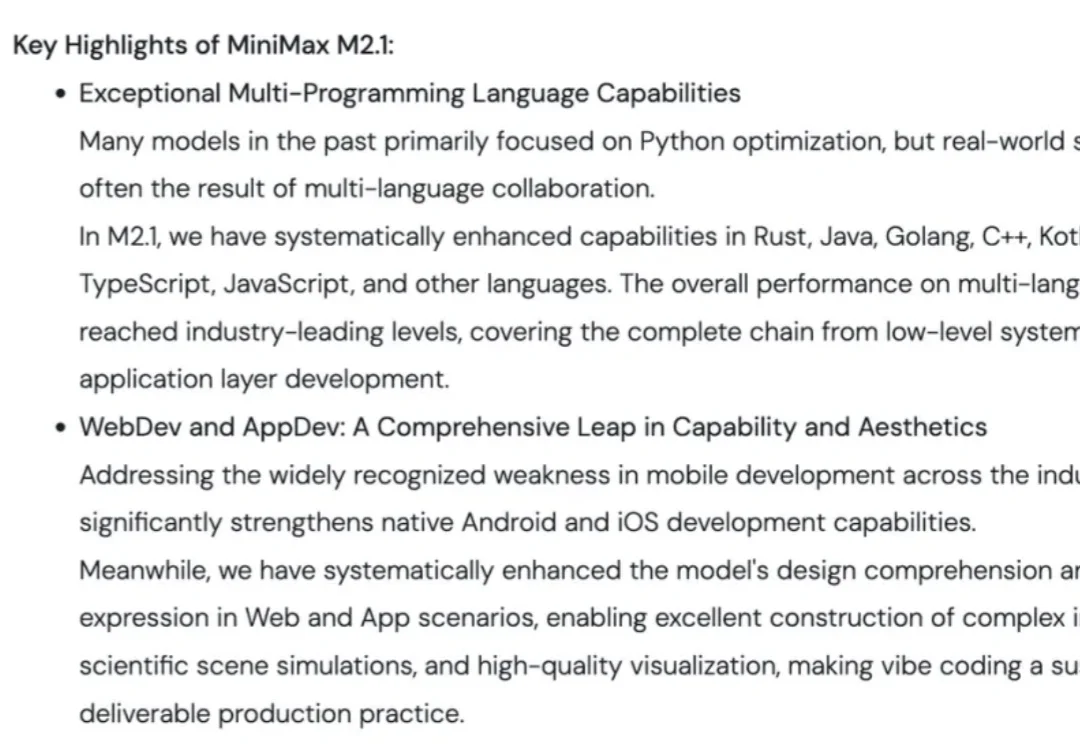

Agent 的状态数据分两种:会话内的临时上下文和跨会话的长期知识。

在生成式AI(GenAI)的推动下,2025年标志着行业从“震撼期”正式步入“深水区”。这并非资本的泡沫,而是计算范式从CPU向GPU的根本性迁移——数据中心正进化为实时生产智能的“AI工厂”。相比于模型参数的单纯竞赛,AI应用带来的“任务执行”能力与直观体验,让人切身感受到从“信息检索”向“智能生成”的范式跃迁。

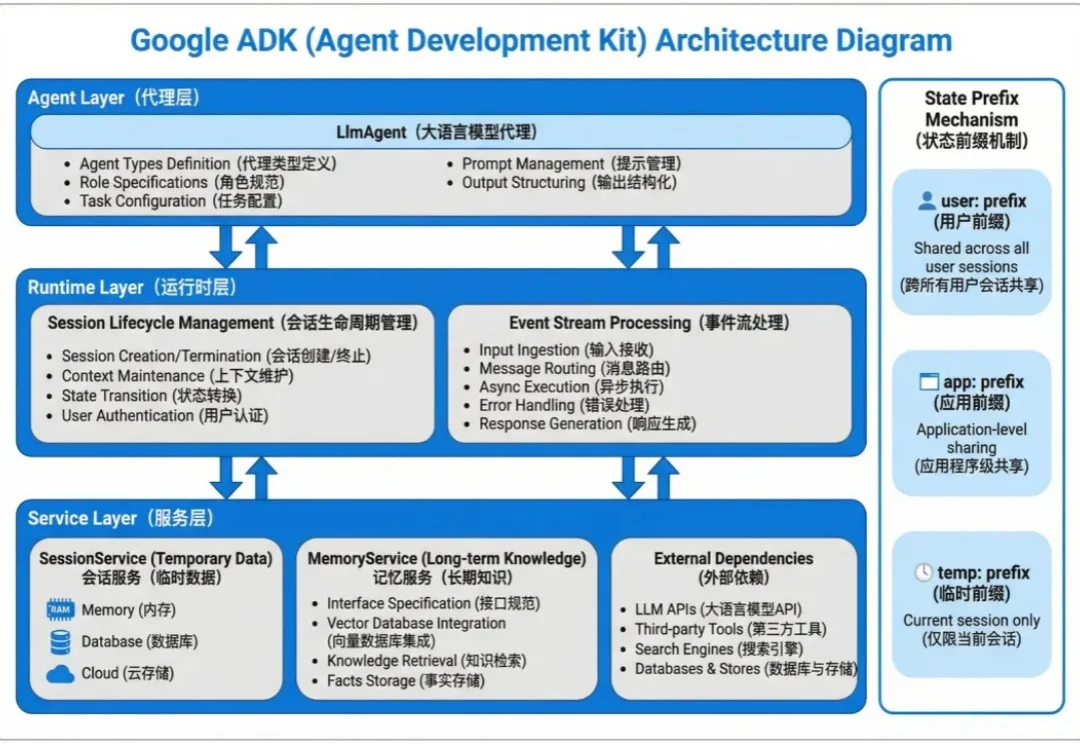

将多模态数据纳入到RAG,甚至Agent框架,是目前LLM应用领域最火热的主题之一,针对多模态数据最自然的召回方式,便是向量检索。

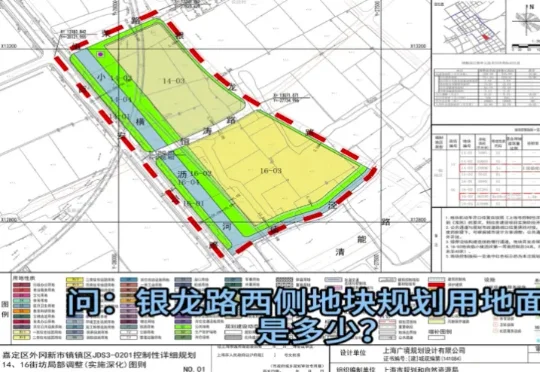

近日,由上海市规划资源局与商汤大装置联合打造的全国规划资源领域首个基础大模型“云宇星空大模型”(专业版)上线。这并非一个简单的对话机器人,而是一个6000亿参数、深度嵌入规资全业务系统的行业大模型:它能调取地图、做统计,能理解规划图纸、会写报告,覆盖从知识检索、空间分析到决策支撑的完整工作闭环。

“我其实天生就是一个适合创业的人。”

刚刚,由SciMaster团队推出的AI机器学习专家ML-Master 2.0,基于国产开源大模型DeepSeek,在OpenAI权威基准测试MLE-bench中一举击败Google、Meta、微软等国际顶流,刷新全球SOTA,再次登顶!目前该功能已在SciMaster线上平台开放waiting list,欢迎申请体验。

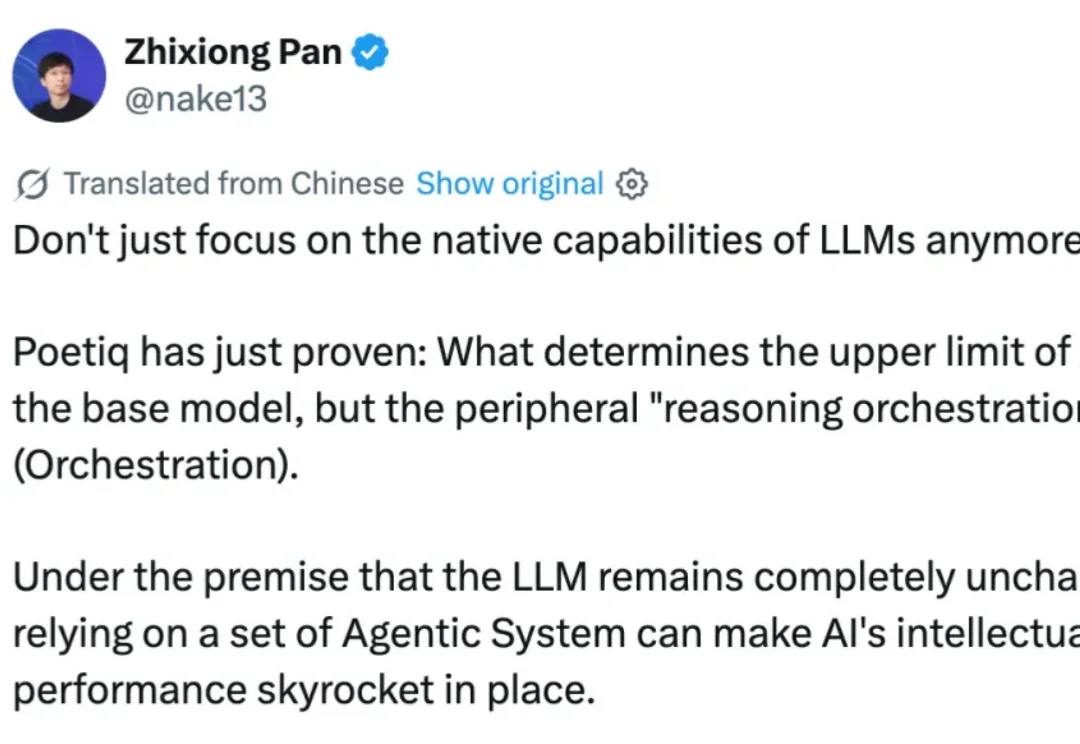

什么?决定 AI 上限的已不再是底座模型,而是外围的「推理编排」(Orchestration)。

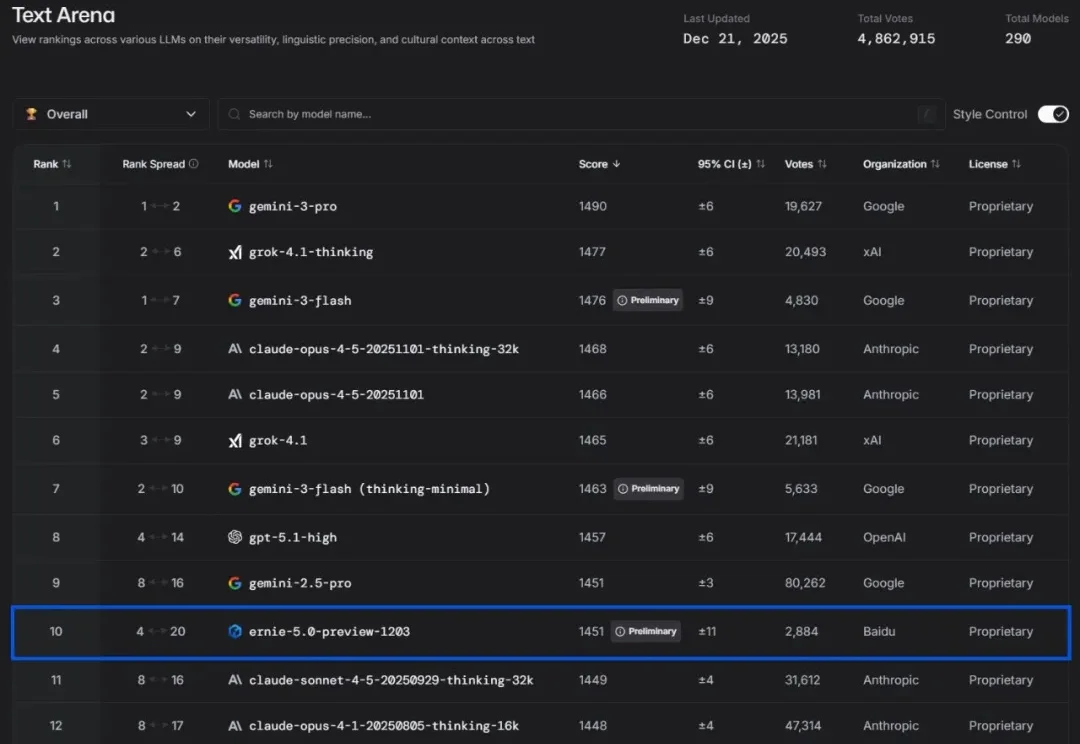

时间过得太快了,一转眼就来到了 2025 年的年底。我们距离 2026 年只剩下了 8 天。回看 AI 模型和产品突飞猛进这一年,中美两家 AI 阵营的行业发展路径有了挺大的区分,大家的关注度不再是单一模型、单一能力,而是“模型+工程+场景”的复合能力。这个变化在年底愈发明显。

英伟达让AI仅靠「看直播」就学会了通用游戏操作。虚拟世界已成为物理智能的黑客帝国,看4万小时直播学会几乎所有游戏!