北航提出代码大模型的 Scaling Laws:编程语言差异与多语言最优配比策略

北航提出代码大模型的 Scaling Laws:编程语言差异与多语言最优配比策略在代码大模型(Code LLMs)的预训练中,行业内长期存在一种惯性思维,即把所有编程语言的代码都视为同质化的文本数据,主要关注数据总量的堆叠。然而,现代软件开发本质上是多语言混合的,不同语言的语法特性、语料规模和应用场景差异巨大。

在代码大模型(Code LLMs)的预训练中,行业内长期存在一种惯性思维,即把所有编程语言的代码都视为同质化的文本数据,主要关注数据总量的堆叠。然而,现代软件开发本质上是多语言混合的,不同语言的语法特性、语料规模和应用场景差异巨大。

多模态大语言模型(MLLMs)已成为AI视觉理解的核心引擎,但其在真实世界视觉退化(模糊、噪声、遮挡等)下的性能崩溃,始终是制约产业落地的致命瓶颈。

你是否曾被AI视频生成的不连贯性所困扰?

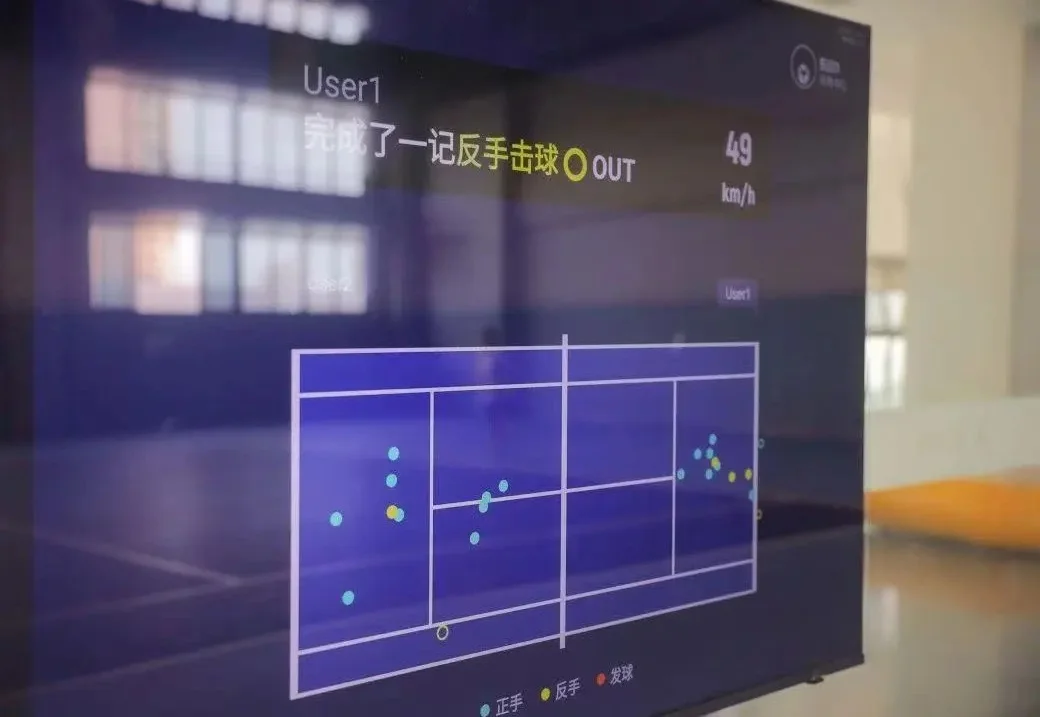

用 AI,把百万级的鹰眼系统打造「万元级」的平民运动生意。

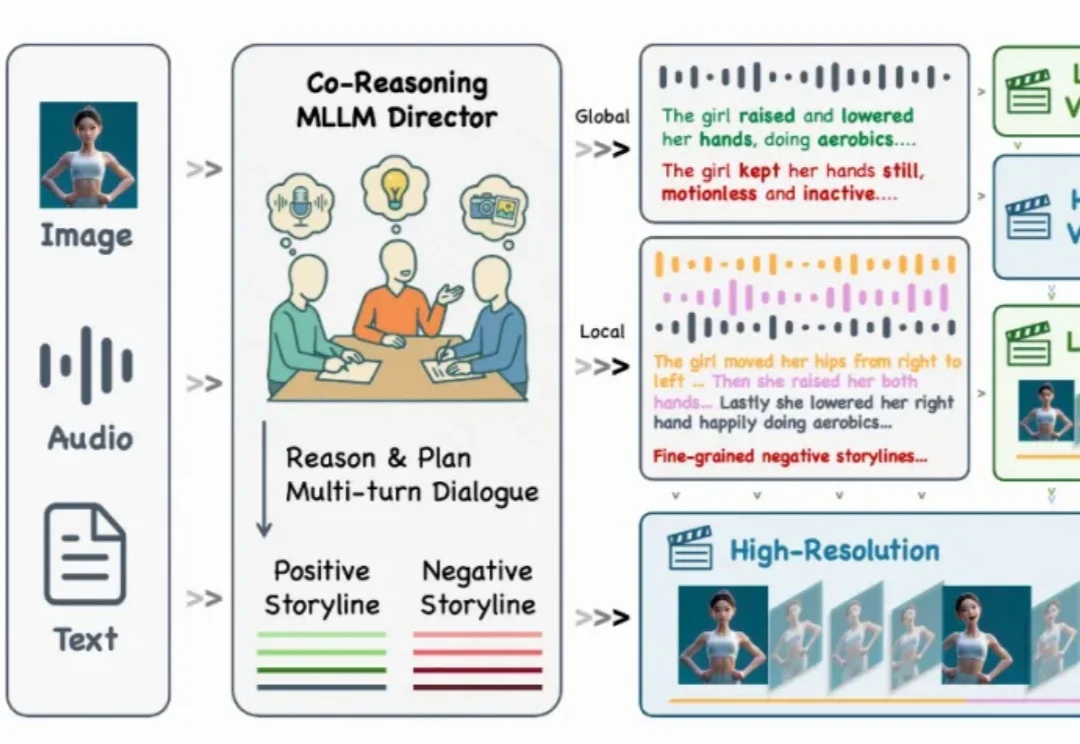

还记得几个月前那个能随着音乐节拍自然舞动的 KlingAvatar 数字人吗?现在,它迎来了史诗级进化!

今天聊一聊怎么在RAG、agent场景中实现语义高亮(Semantic Highlight)。

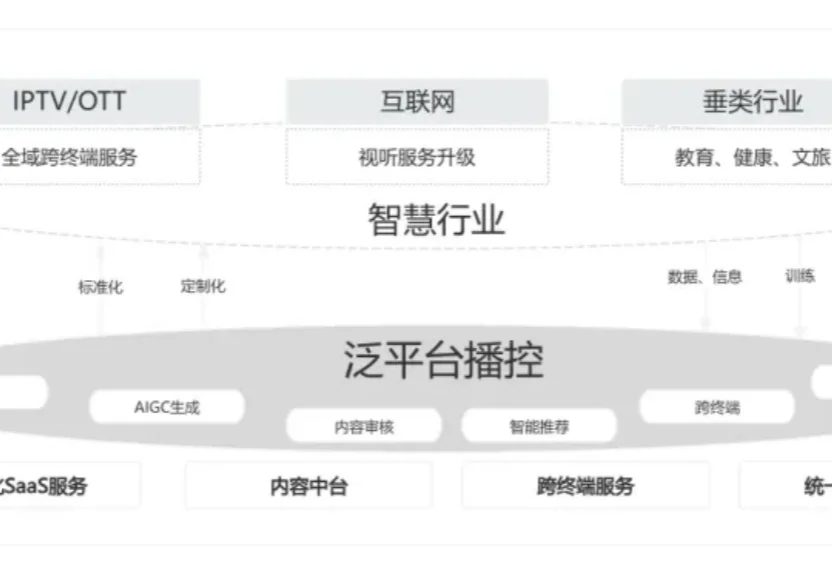

目前,传统广电行业正面临一场深刻的生存危机。外部竞争压力持续加剧,不断挤压行业原有的发展空间:家庭智能语音设备渗透率已经突破 68%,短视频平台日均占用用户时长已经高达 2.8 小时,用户注意力的结构性转移趋势已然形成。

近日,全球顶级创业孵化器Y Combinator在最新一期视频播客中,对2025年AI行业做出年终总结。作为全球初创企业的风向标,YC每年孵化大量顶尖AI初创公司,其内部观察往往预示技术与商业的转向。在本次对谈中,四位合伙人针对2025年的模型竞争格局、AI基础设施泡沫,以及创业与人才趋势等核心议题,展开了深度讨论。

如果说,去年是国内大模型的应用元年,那么2025年无疑是行业的分化之年。此刻你选择的叙事,决定了你看到的世界。

在迈向通用人工智能的道路上,我们一直在思考一个问题:现有的 Image Editing Agent,真的「懂」修图吗?