获1.3亿美元融资,NewLimit利用机器学习指导表观遗传程序设计,延长人类健康寿命研究已有初级成果

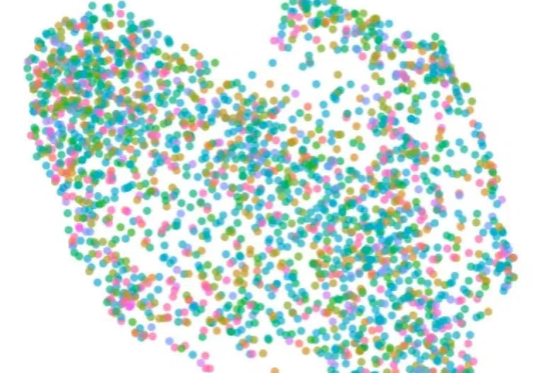

获1.3亿美元融资,NewLimit利用机器学习指导表观遗传程序设计,延长人类健康寿命研究已有初级成果已经研发出 3 种原型药物,能够对肝细胞进行重编程 生物科技公司 NewLimit 宣布完成 1.3 亿美元 B 轮融资,其利用单细胞组学、池化扰动筛选和机器学习技术,基于「AI + 实验室」闭环,已经研发出 3 种原型药物,能够对肝细胞进行重编程。

已经研发出 3 种原型药物,能够对肝细胞进行重编程 生物科技公司 NewLimit 宣布完成 1.3 亿美元 B 轮融资,其利用单细胞组学、池化扰动筛选和机器学习技术,基于「AI + 实验室」闭环,已经研发出 3 种原型药物,能够对肝细胞进行重编程。

最近,Meta 公司首席 AI 科学家、图灵奖得主 LeCun 转发了他在纽约大学的同事 Kyunghyun Cho 的一篇帖子:内容是关于这位教授 2025 学年机器学习研究生课程的教学大纲和讲义。

4月29日,腾讯TEG进行架构调整,新成立大语言和多模态模型部,并对数据平台和机器学习平台职责进行调整。

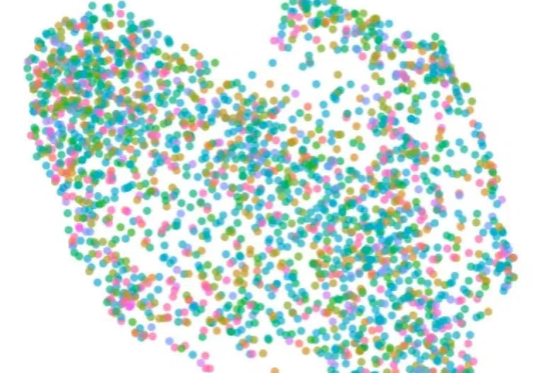

科研成果「复现」新革命!还在为堆积如山的论文和难以复现的代码发愁吗?Paper2Code能直接「阅读」机器学习论文,自动生成高质量、可运行的代码库。它通过智能规划、分析、生成三步,效率远超人类,有望极大加速科研迭代,告别「重复造轮子」的烦恼!

新加坡-麻省理工学院研究联盟、新加坡 A*SRL 实验室、新加坡国立大学、美国麻省理工学院的联合研究团队,提出了一种结合紫外吸收光谱与机器学习的检测方法,能在 30 分钟内完成细胞培养上清液的微生物污染检测。

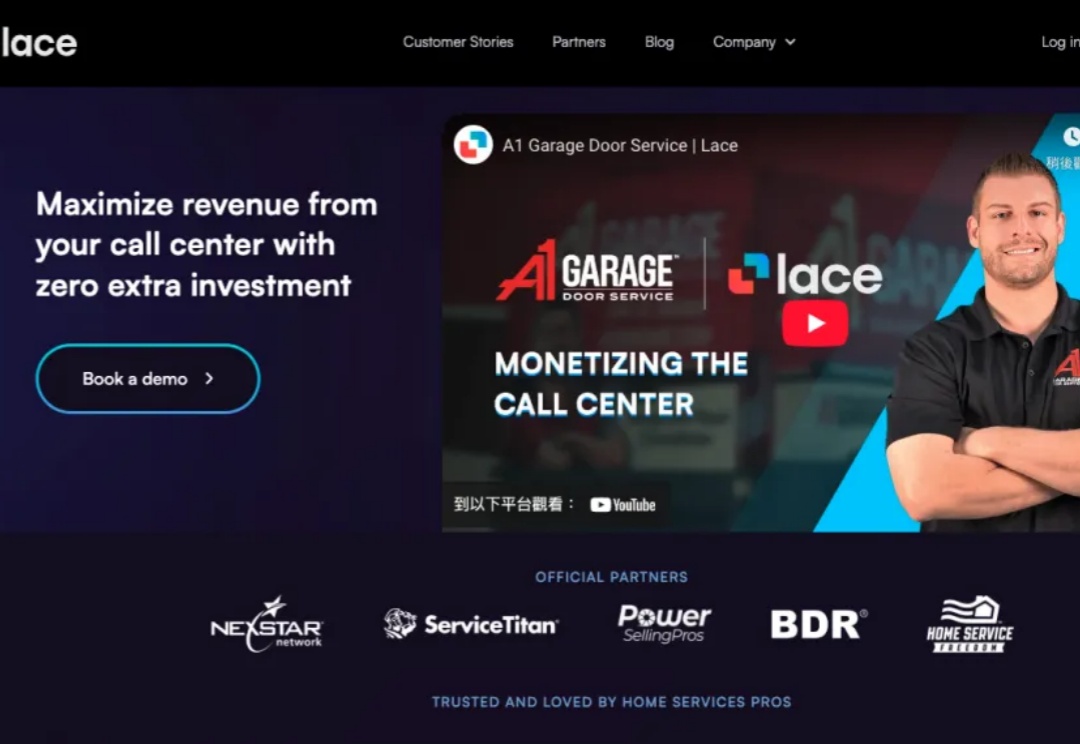

前 Meta 工程师创办的 Lace AI 融资1400万美元,这是一家家庭服务创收软件初创公司。作为 Meta 的 AI 工程师,Boris Valkov 帮助构建了世界上最大的机器学习库之一 PyTorch。在那里,瓦尔科夫意识到人工智能“即将解锁能力,在软件堆栈的应用层中。

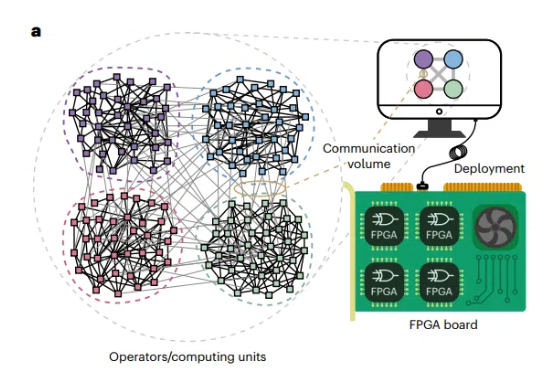

组合优化问题(COPs)在科学和工业领域无处不在,从物流调度到芯片设计,从社交网络分析到人工智能算法,其高效求解一直是研究热点。

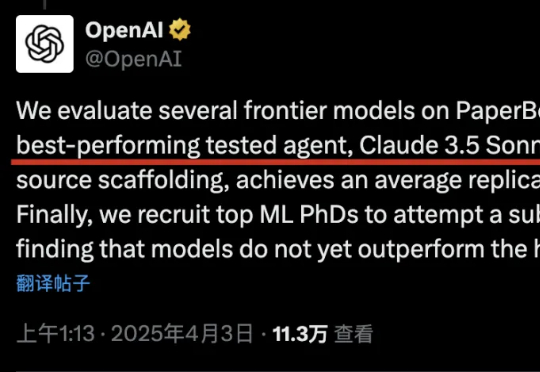

刚刚开源的新基准测试PaperBench,6款前沿大模型驱动智能体PK复现AI顶会论文,新版Claude-3.5-Sonnet显著超越o1/r1排名第一。与去年10月OpenAI考验Agent机器学习代码工程能力MLE-Bnch相比,PaperBench更考验综合能力,不再是只执行单一任务。

高通今日宣布收购越南人工智能开发商 MovianAI。MovianAI 是 VinAI Application and Research JSC 的生成式 AI 部门,后者是越南最大企业集团 Vingroup 旗下的机器学习研究实验室。此次收购后,包括前 DeepMind 研究科学家、VinAI 首席执行官 Hung Bui 在内的核心团队将加入高通。

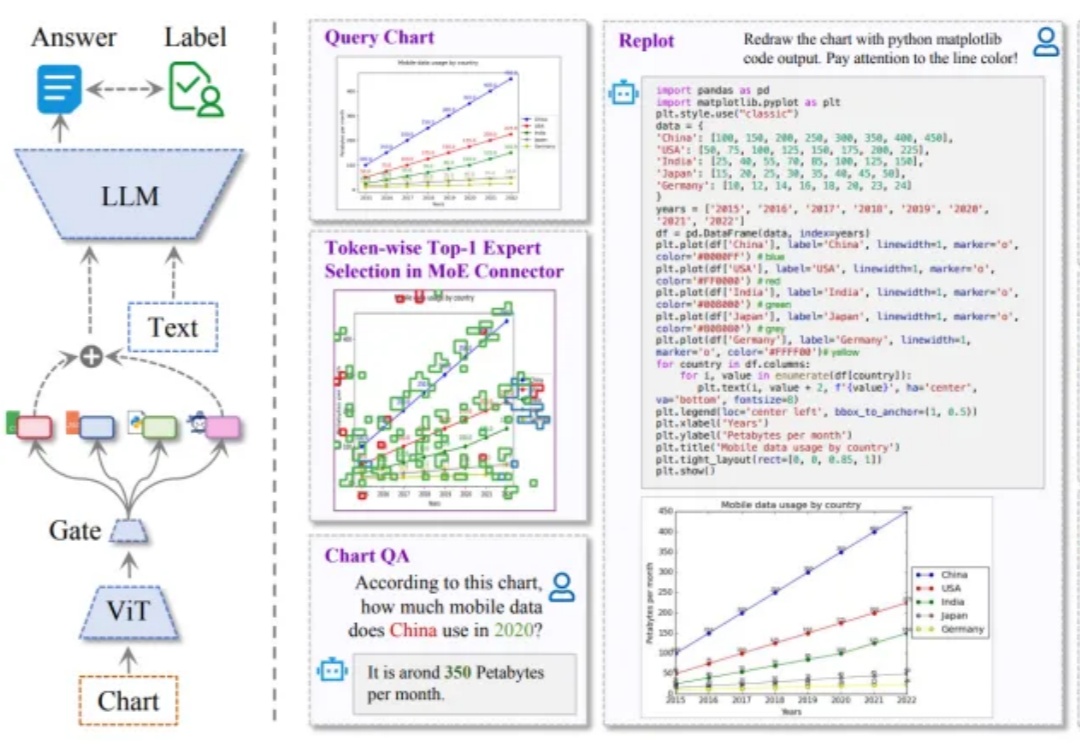

最近,全球 AI 和机器学习顶会 ICLR 2025 公布了论文录取结果:由 IDEA、清华大学、北京大学、香港科技大学(广州)联合团队提出的 ChartMoE 成功入选 Oral (口头报告) 论文。据了解,本届大会共收到 11672 篇论文,被选中做 Oral Presentation(口头报告)的比例约为 1.8%