支持1024帧、准确率近100%,英伟达「LongVILA」开始发力长视频

支持1024帧、准确率近100%,英伟达「LongVILA」开始发力长视频现在,长上下文视觉语言模型(VLM)有了新的全栈解决方案 ——LongVILA,它集系统、模型训练与数据集开发于一体。

现在,长上下文视觉语言模型(VLM)有了新的全栈解决方案 ——LongVILA,它集系统、模型训练与数据集开发于一体。

“乱世”其实早已到来,只不过这次是公开承认了这个现实。

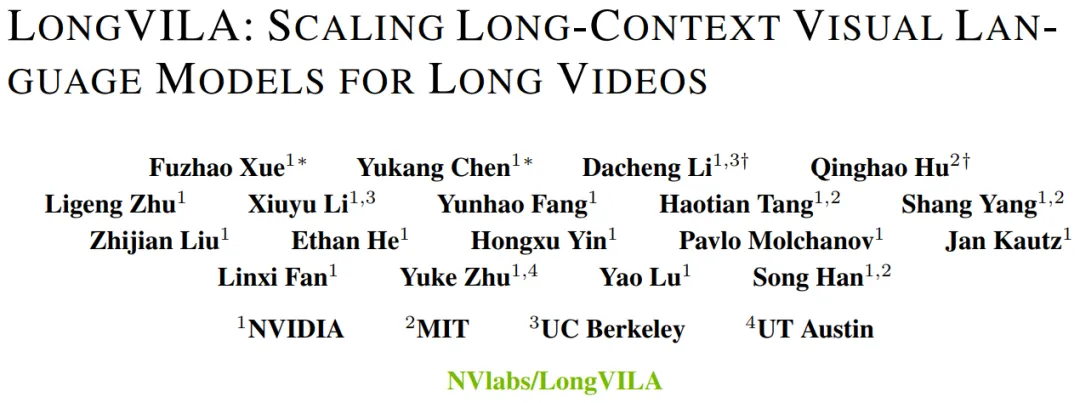

浏览器里直接能跑的SOTA小模型来了,分别在2亿、5亿和20亿级别获胜,抱抱脸出品。

近日,HCM领域的SaaS巨头Workday和全球排名第一的CRM企业Salesforce达成AI战略合作,意在结合Salesforce在客户关系管理领域方面的专业知识以及Workday在人力资源、财务管理方面的优势,试图通过当下先进的人工智能功能和统一的数据集成技术重新构想全新的企业软件。

随着大模型的快速发展,指令调优在提升模型性能和泛化能力方面发挥着至关重要的作用。

人工智能系统依靠充足、高质量的训练数据来获得高性能,但MIT等机构最近的一项研究发现,曾经免费提供的数据在多个方面变得越来越难获取。

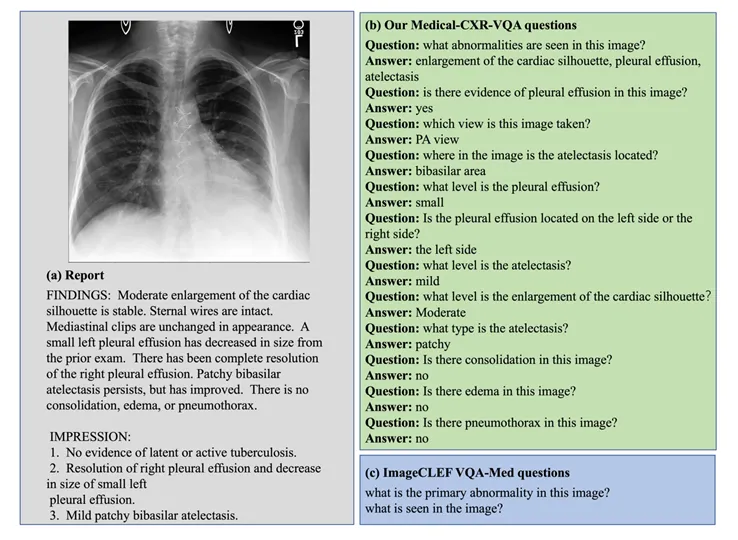

多模态大语言模型 (Multimodal Large Language Moodel, MLLM) 以其强大的语言理解能力和生成能力,在各个领域取得了巨大成功。

最近的英伟达似乎步入了多事之秋。

如今一场席卷人工智能圈的“石油危机”已经出现,几乎每一家AI厂商都在竭力寻求新的语料来源,但再多的数据似乎也填不满AI大模型的胃口。更何况越来越多的内容平台意识到了手中数据的价值,纷纷开始敝帚自珍。为此,“合成数据”也成为了整个AI行业探索的新方向。

为了解决这个问题,一些研究尝试通过强大的 Teacher Model 生成训练数据,来增强 Student Model 在特定任务上的性能。然而,这种方法在成本、可扩展性和法律合规性方面仍面临诸多挑战。在无法持续获得高质量人类监督信号的情况下,如何持续迭代模型的能力,成为了亟待解决的问题。