LoRA数学编程任务不敌全量微调 | 哥大&Databricks新研究

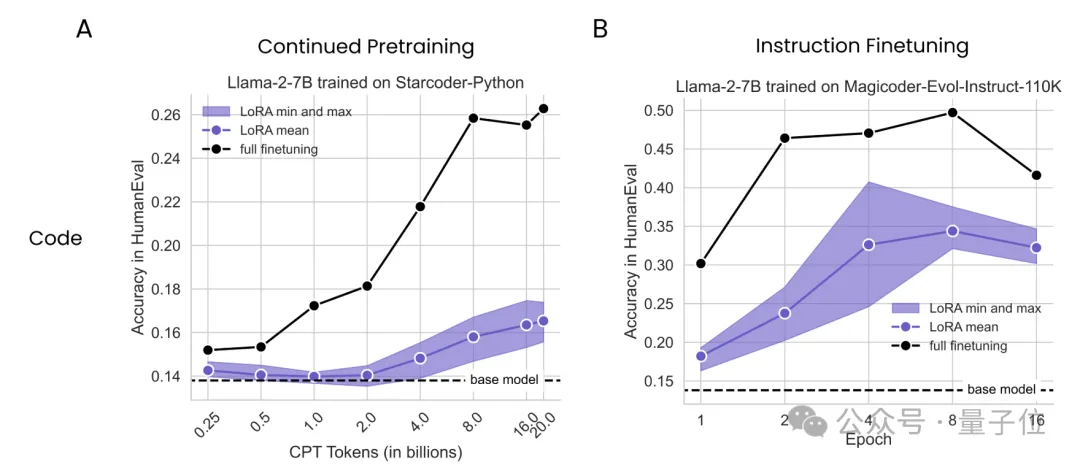

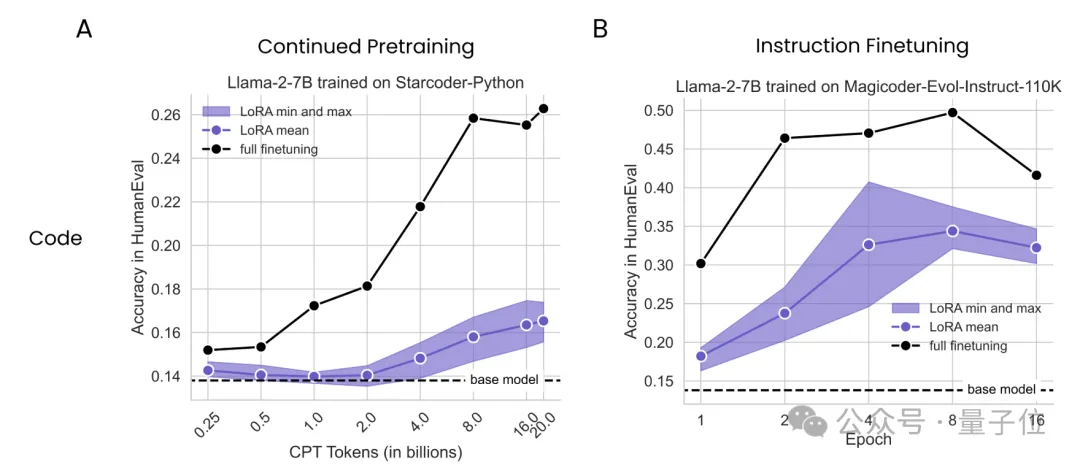

LoRA数学编程任务不敌全量微调 | 哥大&Databricks新研究大数据巨头Databricks与哥伦比亚大学最新研究发现,在数学和编程任务上,LoRA干不过全量微调。

来自主题: AI技术研报

3655 点击 2024-05-20 21:03

大数据巨头Databricks与哥伦比亚大学最新研究发现,在数学和编程任务上,LoRA干不过全量微调。

当计算预算低时,重复使用高质量数据更好;当不差钱时,使用大量数据更有利。

为了能让自己以后更好地摸鱼,我上周第一次和大模型协作,完成了对一份财报的分析。

最公平的大模型基准测试诞生了!来自LLM竞技场,最接近人类偏好,数据新鲜、速度快、成本低,严格分离学渣和学霸。

中国和国际AI合作不断深化,特斯拉计划在中国建立数据中心,推进FSD全自动驾驶算法。 美国采取技术封锁措施,对中国等国家实施人工智能模型出口管制。

许多临床任务需要了解专业数据,例如医学图像、基因组学,这类专业知识信息在通用多模态大模型的训练中通常不存在。

去年,各大公司都还在竞相推出自家的聊天机器人。

ChatGPT更强了...

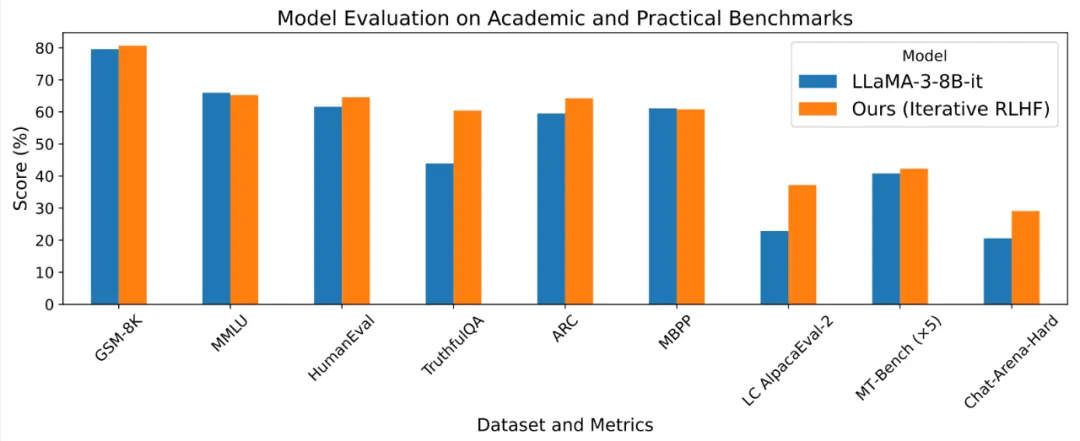

基于人类反馈的强化学习 (RLHF) 使得大语言模型的输出能够更加符合人类的目标、期望与需求,是提升许多闭源语言模型 Chat-GPT, Claude, Gemini 表现的核心方法之一。

以后数据分析的活,也被 ChatGPT 包了。