LLM对齐数据全自动合成!UW华人博士生提出Magpie方法,Macbook Air即可运行

LLM对齐数据全自动合成!UW华人博士生提出Magpie方法,Macbook Air即可运行华盛顿大学和Allen AI最近发表的论文提出了一种新颖有趣的数据合成方法。他们发现,充分利用LLM的自回归特性,可以引导模型自动生成高质量的指令微调数据。

华盛顿大学和Allen AI最近发表的论文提出了一种新颖有趣的数据合成方法。他们发现,充分利用LLM的自回归特性,可以引导模型自动生成高质量的指令微调数据。

9次迭代后,模型开始出现诡异乱码,直接原地崩溃!就在今天,牛津、剑桥等机构的一篇论文登上了Nature封面,称合成数据就像近亲繁殖,效果无异于投毒。有无破解之法?那就是——更多使用人类数据!

训练数据是用 GPT-4o 生成的?那质量不好说了。

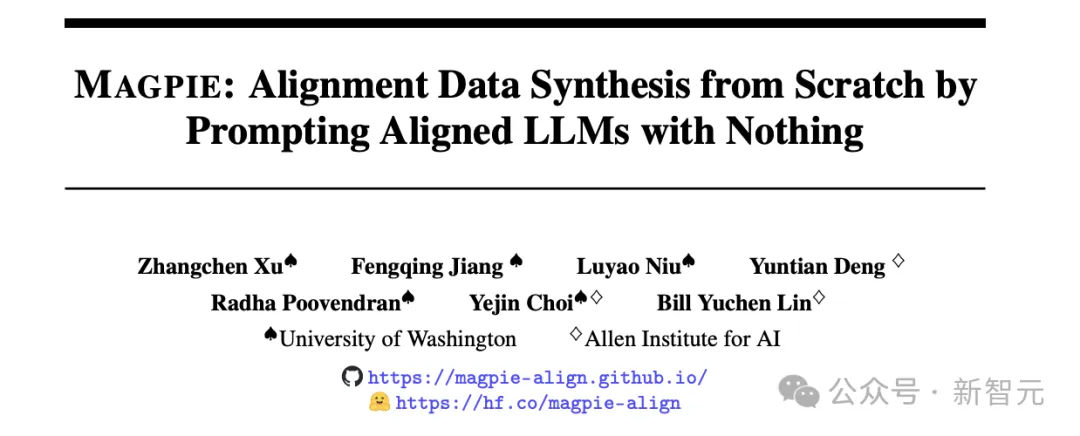

我们知道 LLM 是在大规模计算机集群上使用海量数据训练得到的,机器之心曾介绍过不少用于辅助和改进 LLM 训练流程的方法和技术。而今天,我们要分享的是一篇深入技术底层的文章,介绍如何将一堆连操作系统也没有的「裸机」变成用于训练 LLM 的计算机集群。

高质量数据是稀缺资源

目前的统计数据显示,全球每 4000 万盲人中只有 28000 只导盲犬。 根据中国盲人协会数据,目前我国共有 1731 万视障人士,而现役导盲犬的数量却仅有 400 只左右。 导盲犬培养和训练成本很高,我国平均培训一只导盲犬的费用在 20 万元左右,不得不说是非常稀缺的资源。

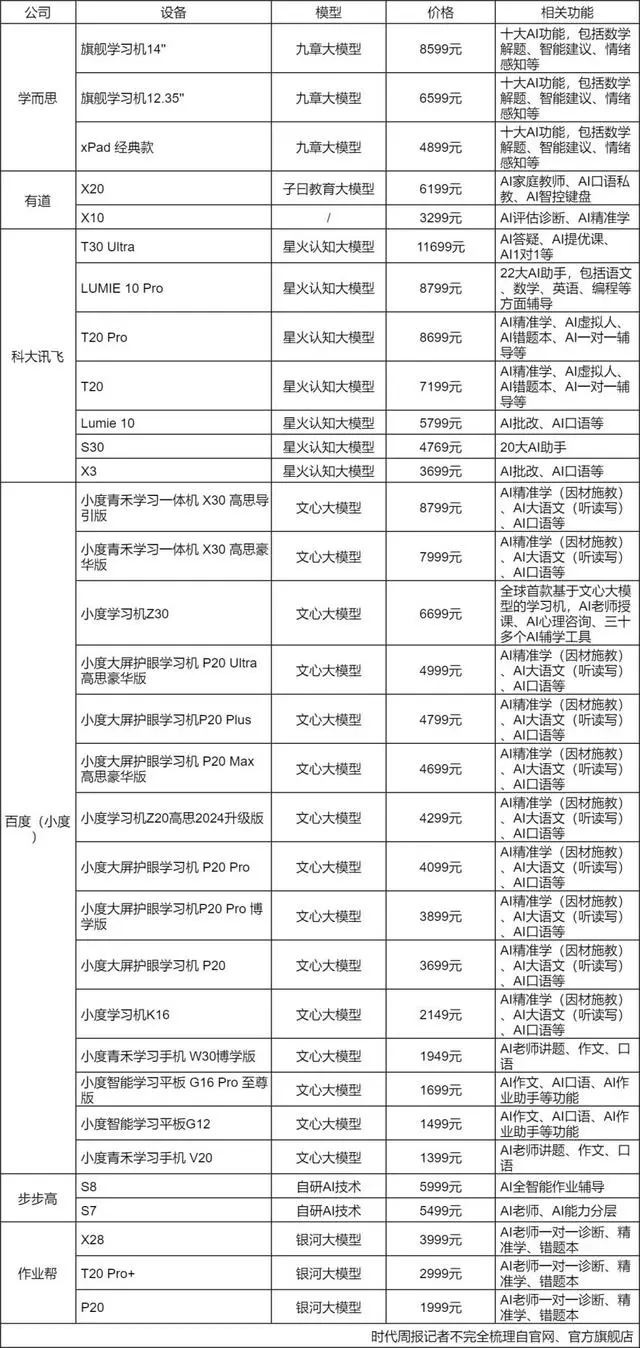

大模型技术席卷全球科技界,中国也迅速跟进这一浪潮,在诸多领域开始落地,提升了企业运营效率和消费者体验。然而,大模型企业也面临技术成熟度、成本、数据安全、行业差异、用户接受度等挑战,商业化仍然是一个摆在所有厂商面前的问题。

苹果最新杀入开源大模型战场,而且比其他公司更开放。 推出7B模型,不仅效果与Llama 3 8B相当,而且一次性开源了全部训练过程和资源。大模型,AI,苹果AI,苹果开源模型

数据是大语言模型(LLMs)成功的基石,但并非所有数据都有益于模型学习。

暑期已然过半,教育市场仍然活跃。7月19日,商务部公布今年上半年我国电子商务发展情况。其中,一个数据格外引人注意——AI学习机销售额增长达136.6%。