微软Office全家桶再爆办公革命,o1模型加持重塑十亿人工作流!1句话生成PPT+自定义智能体

微软Office全家桶再爆办公革命,o1模型加持重塑十亿人工作流!1句话生成PPT+自定义智能体时隔一年半,Office办公全家桶再次迎来重磅升级。半小时发布会,纳德拉向全世界宣告,「AI时代下的全新工作流开启」。Python塞进Excel,AI秒处理数据。而且,只要一句提示,想法即刻变成PPT。

时隔一年半,Office办公全家桶再次迎来重磅升级。半小时发布会,纳德拉向全世界宣告,「AI时代下的全新工作流开启」。Python塞进Excel,AI秒处理数据。而且,只要一句提示,想法即刻变成PPT。

OpenAI o1 在数学、代码、长程规划等问题取得显著的进步。一部分业内人士分析其原因是由于构建足够庞大的逻辑数据集 <问题,明确的正确答案> ,再加上类似 AlphaGo 中 MCTS 和 RL 的方法直接搜索,只要提供足够的计算量用于搜索,总可以搜到最后的正确路径。然而,这样只是建立起问题和答案之间的更好的联系,如何泛化到更复杂的问题场景,技术远不止这么简单。

随着近年来在文本和视频数据上构建基础模型的进展,学术界对时间序列的基础模型也表现出浓厚的兴趣。 时间序列分析在许多关键领域中具有重要性,能够影响从科学研究到经济决策的广泛应用。

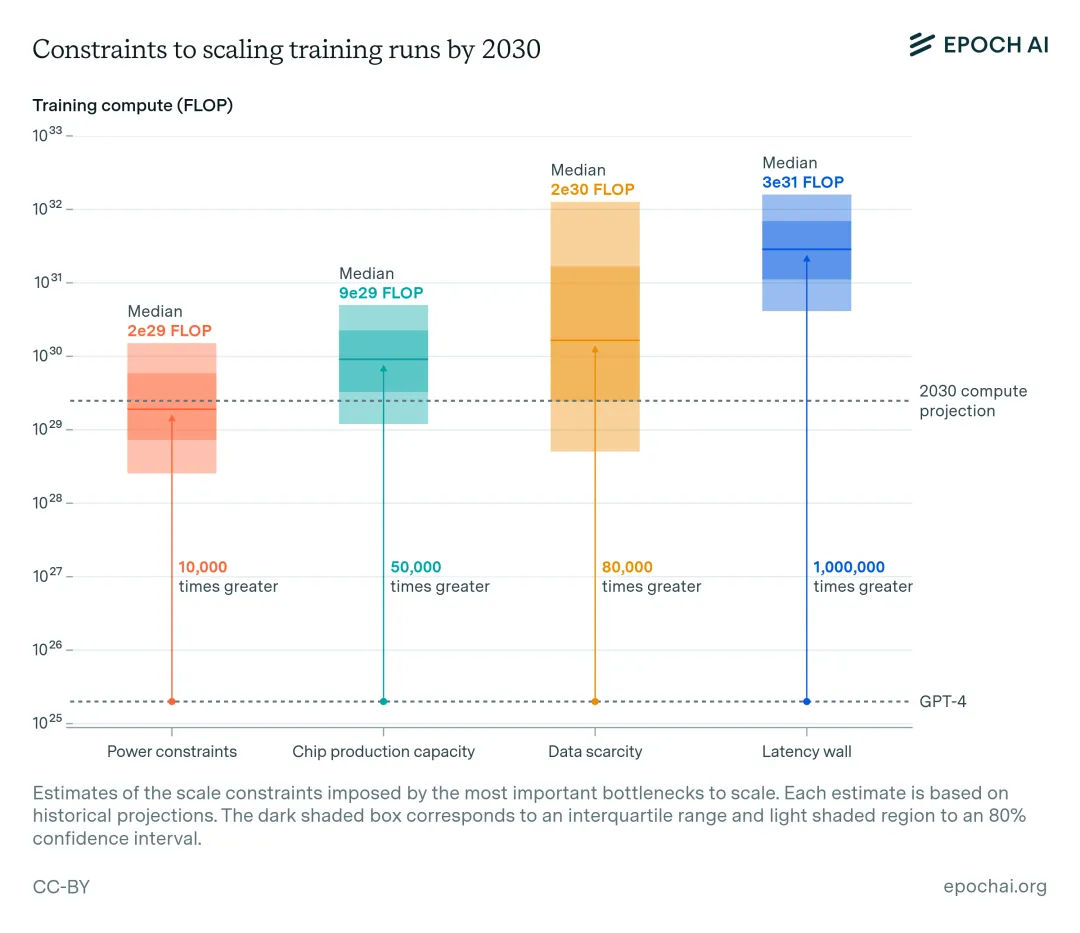

近年来,人工智能模型的能力显著提高。其中,计算资源的增长占了人工智能性能提升的很大一部分。规模化带来的持续且可预测的提升促使人工智能实验室积极扩大训练规模,训练计算以每年约 4 倍的速度增长。

一个高质量的人脸识别训练集要求身份 (ID) 有高的分离度(Inter-class separability)和类内的变化度(Intra-class variation)。

近日,初创公司Lumen Orbit要放大招,该公司要把数据中心搬到太空去,在太空建立AI超级计算机。Lumen Orbit已经拿到Y Combinator的投资,计划明年就发射第一颗卫星,上面搭载的GPU比之前所有送上太空的GPU都要强大100倍。

上下文学习(In-Context Learning, ICL)是指LLMs能够仅通过提示中给出的少量样例,就迅速掌握并执行新任务的能力。这种“超能力”让LLMs表现得像是一个"万能学习者",能够在各种场景下快速适应并产生高质量输出。然而,关于ICL的内部机制,学界一直存在争议。

张大鹏,加拿大皇家科学院院士,加拿大工程院院士,国际电气与电子工程师协会终身会士(IEEE Fellow),国际模式识别协会会士,亚太人工智能学会会士,香港中文大学(深圳)数据科学学院校长学勤讲座教授,深圳市人工智能与机器人研究院(AIRS)计算机视觉研究中心主任,香港中文大学(深圳)—联易融计算机视觉与人工智能联合实验室主任,以及香港理工大学荣誉教授。

本文提出了一种名为MedUnA的方法,旨在解决医疗图像分类中因缺乏标注数据而导致的监督学习挑战。MedUnA利用视觉-语言模型(VLMs)中的视觉与文本对齐特性,通过无监督学习来适应医疗图像分类任务。

在此之上,「帆软」将FineChatBI的核心能力集成开放给部分优质客户,让用户依托平台,能够独立部署企业数据库,完善企业底层数据资产建设。