多模态DeepSeek来了,北大港科联合发布Align-DS-V

多模态DeepSeek来了,北大港科联合发布Align-DS-V在当前AI领域的快速发展中,“强推理慢思考”已经成为主要的发展动向之一,它们深刻影响着研发方向和投资决策。如何将强推理慢思考进一步推广到更多模态甚至是全模态场景,并且确保和人类的价值意图相一致,已成为一个极具前瞻性且至关重要的挑战。

在当前AI领域的快速发展中,“强推理慢思考”已经成为主要的发展动向之一,它们深刻影响着研发方向和投资决策。如何将强推理慢思考进一步推广到更多模态甚至是全模态场景,并且确保和人类的价值意图相一致,已成为一个极具前瞻性且至关重要的挑战。

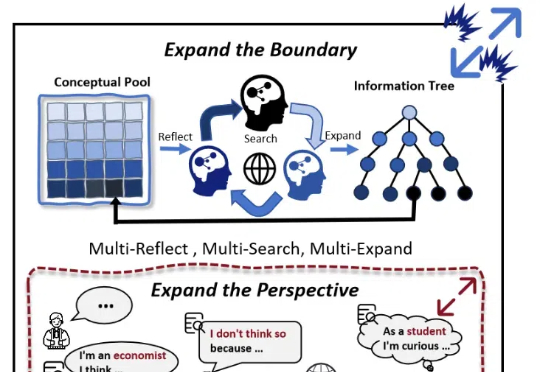

随着大模型(LLMs)的发展,AI 写作取得了较大进展。然而,现有的方法大多依赖检索知识增强生成(RAG)和角色扮演等技术,其在信息的深度挖掘方面仍存在不足,较难突破已有知识边界,导致生成的内容缺乏深度和原创性。

OpenAI 在 “双十二” 发布会的最后一天公开了 o 系列背后的对齐方法 - deliberative alignment,展示了通过系统 2 的慢思考能力提升模型安全性的可行性。

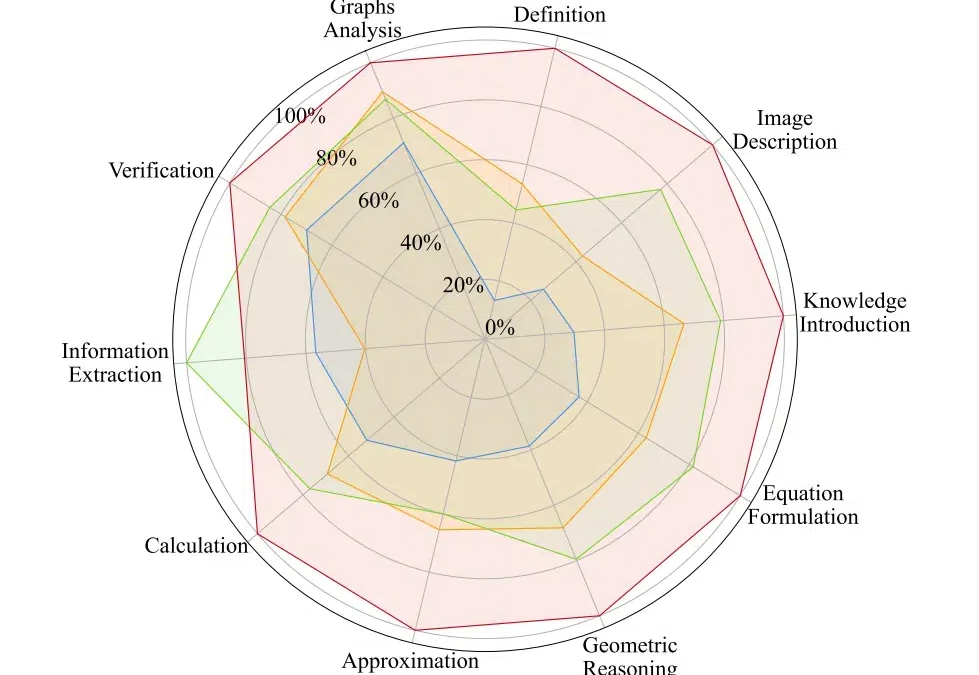

AtomThink 是一个包括 CoT 注释引擎、原子步骤指令微调、政策搜索推理的全流程框架,旨在通过将 “慢思考 “能力融入多模态大语言模型来解决高阶数学推理问题。量化结果显示其在两个基准数学测试中取得了大幅的性能增长,并能够轻易迁移至不同的多模态大模型当中。

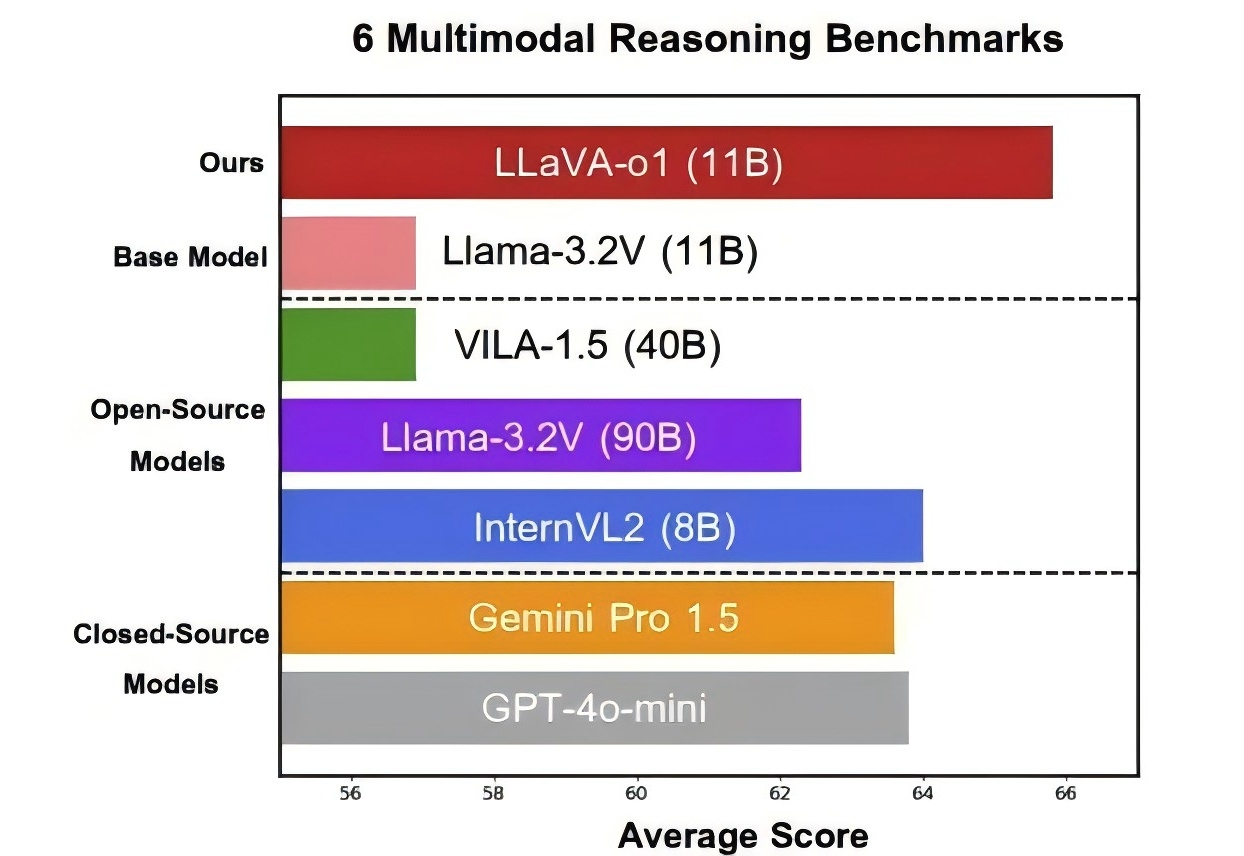

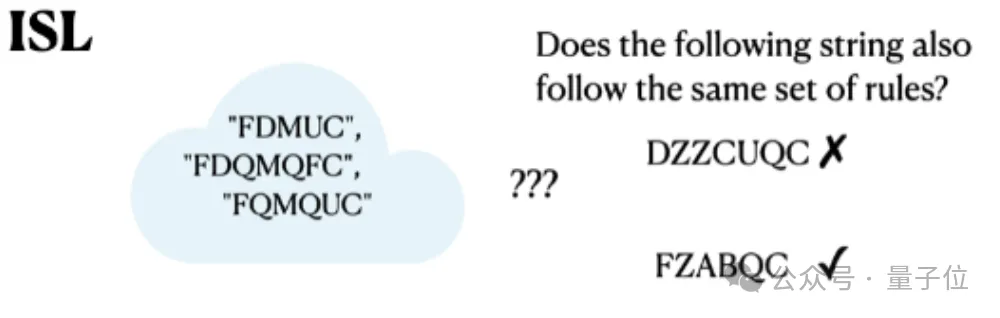

北大等出品,首个多模态版o1开源模型来了—— 代号LLaVA-o1,基于Llama-3.2-Vision模型打造,超越传统思维链提示,实现自主“慢思考”推理。 在多模态推理基准测试中,LLaVA-o1超越其基础模型8.9%,并在性能上超越了一众开闭源模型。

OpenAI o1风格的推理大模型,有行业垂直版了。HK-O1aw,是由香港生成式人工智能研发中心(HKGAI)旗下AI for Reasoning团队(HKAIR) 联合北京大学对齐团队(PKU-Alignment Team)推出的全球首个慢思考范式法律推理大模型。

OpenAI o1彻底带火慢思考和思维链(CoT)方法,但CoT在某些任务上反而会降低模型表现。

Meta版o1也来了。 田渊栋团队带来新作Dualformer,把快慢思考无缝结合,性能提升还成本更低。 能解决迷宫、推箱子等复杂问题。

推理型AI搜索是近期AI应用领域比较火的方向之一。国内的AI厂商,如月之暗面的Kimi推出了Kimi探索版,智谱AI推出了AI搜索智能体,360AI则是在原有的360AI搜索的基础上增加了慢思考模式。国外的AI玩家,如AI搜索的领头羊Perplexity,也在这两天在Pro Search中增加了能够自动运行的推理模式

近期,LLM领域有不少关于系统1和系统2思考的讨论,在Agent方向上这方面的讨论还很少。如何让AI agents既能快速响应用户,又能进行深度思考和规划,一直是一个巨大的挑战。