超越GPT-4o!开源科研神器登场,4500万篇论文检索增强生成靠谱回答

超越GPT-4o!开源科研神器登场,4500万篇论文检索增强生成靠谱回答只需几秒钟,开源模型检索4500篇论文,比GPT-4o还靠谱!

只需几秒钟,开源模型检索4500篇论文,比GPT-4o还靠谱!

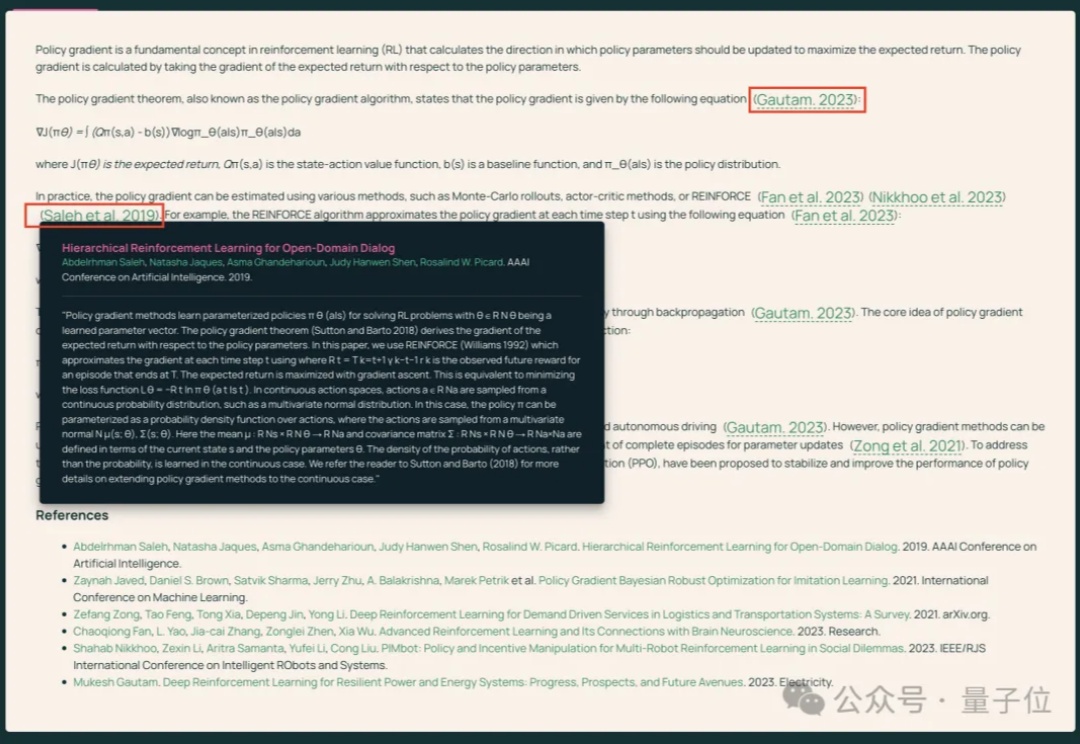

开源模型阵营又迎来一员猛将:Tülu 3。它来自艾伦人工智能研究所(Ai2),目前包含 8B 和 70B 两个版本(未来还会有 405B 版本),并且其性能超过了 Llama 3.1 Instruct 的相应版本!长达 73 的技术报告详细介绍了后训练的细节。

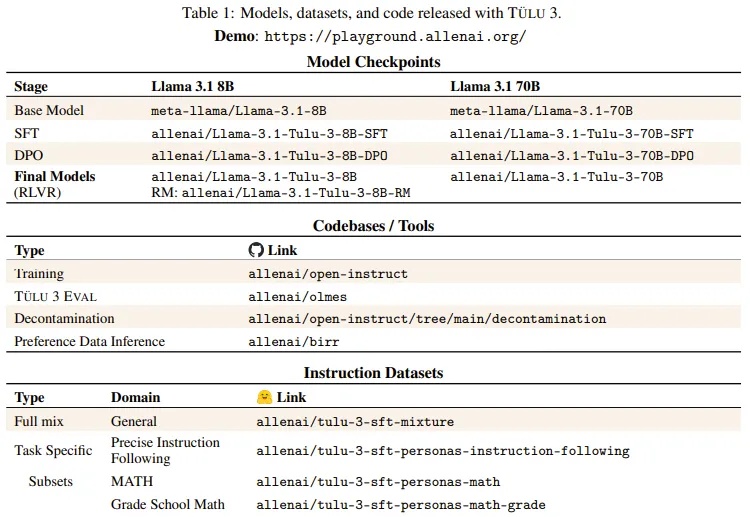

北大等出品,首个多模态版o1开源模型来了—— 代号LLaVA-o1,基于Llama-3.2-Vision模型打造,超越传统思维链提示,实现自主“慢思考”推理。 在多模态推理基准测试中,LLaVA-o1超越其基础模型8.9%,并在性能上超越了一众开闭源模型。

MEGA-Bench是一个包含500多个真实世界任务的多模态评测套件,为全面评估AI模型提供了高效工具。研究人员发现,尽管顶级AI模型在多个任务中表现出色,但在复杂推理和跨模态理解方面仍有提升空间。

自打ChatGPT让人工智能这个概念迎来第二春,百度创始人李彦宏也重新活跃了起来,成为了几乎是最爱发声的互联网大佬。在此前先后发表AI终结程序员、开源模型会越来越落后等言论之后,有消息称在最近举行的百度2024年第三季度总监会上他又放话,“百度不碰Sora类的视频生成。”

北京时间 10 月 30 日,GitHub Universe 2024 如约而至,而今年正值大会十周年纪念日。本文将从 GitHub 发布的 AI 新进展入手,围绕开源模型、用户数量、盈利模式、发展历程等几个方面,全面梳理 GitHub 与 Hugging Face 两大开源平台的异同。

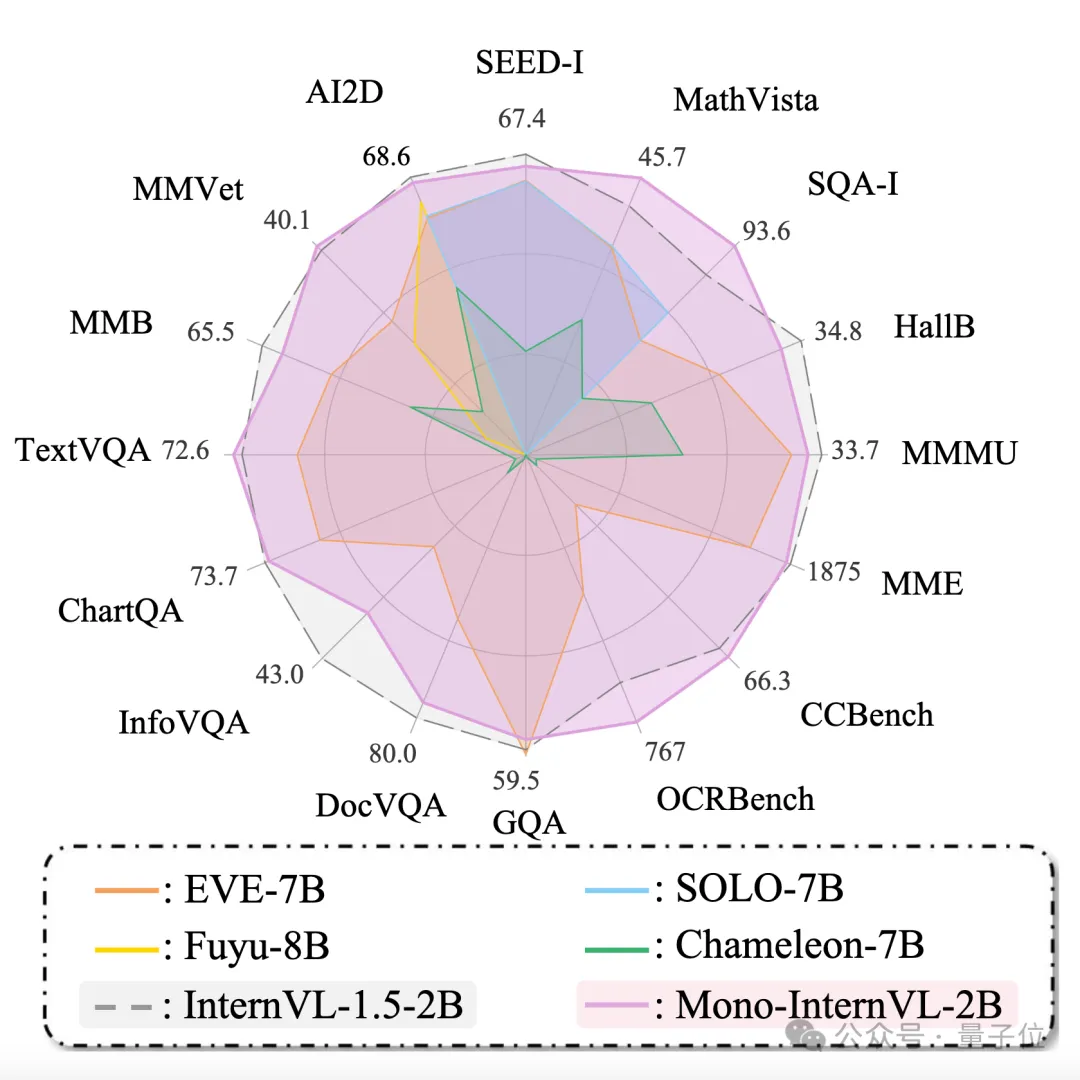

原生多模态大模型性能瓶颈,迎来新突破! 上海AI Lab代季峰老师团队,提出了全新的原生多模态大模型Mono-InternVL。 与非原生模型相比,该模型首个单词延迟最多降低67%,在多个评测数据集上均达到了SOTA水准。

苹果研究者发现:无论是OpenAI GPT-4o和o1,还是Llama、Phi、Gemma和Mistral等开源模型,都未被发现任何形式推理的证据,而更像是复杂的模式匹配器。无独有偶,一项多位数乘法的研究也被抛出来,越来越多的证据证实:LLM不会推理!

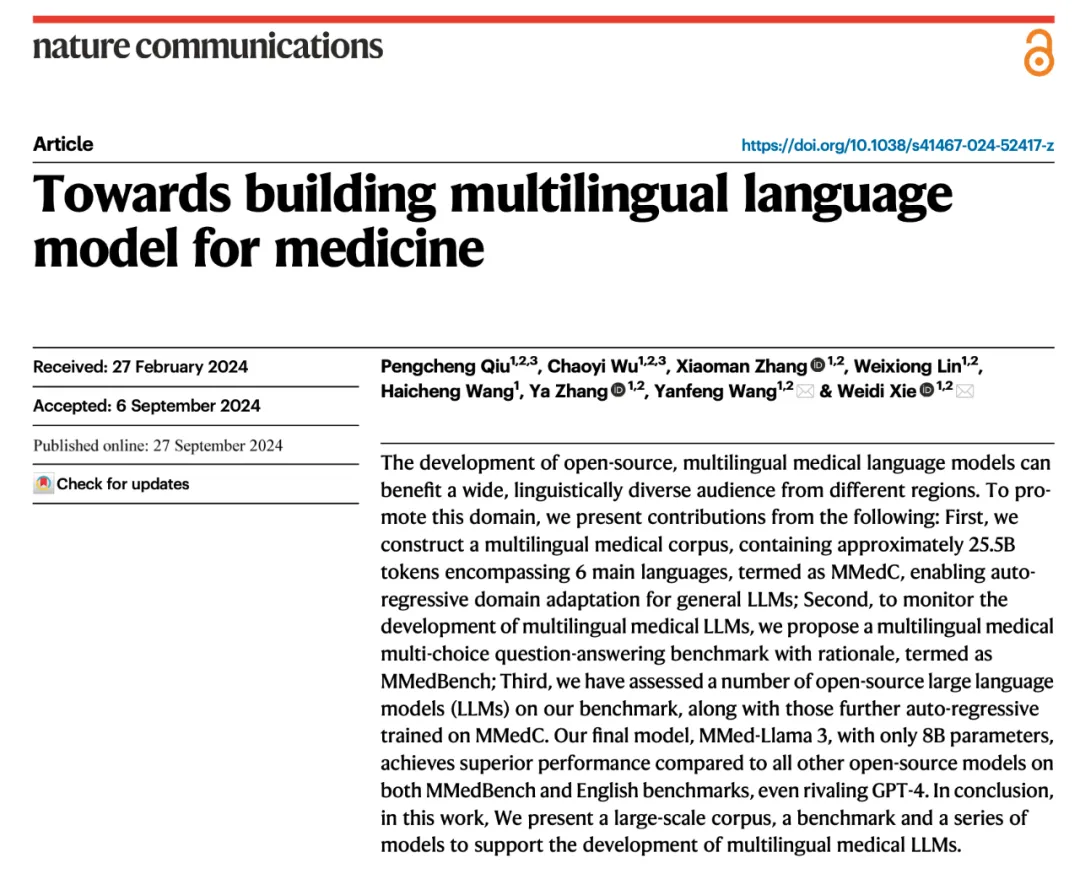

在医疗领域中,大语言模型已经有了广泛的研究。然而,这些进展主要依赖于英语的基座模型,并受制于缺乏多语言医疗专业数据的限制,导致当前的医疗大模型在处理非英语问题时效果不佳。

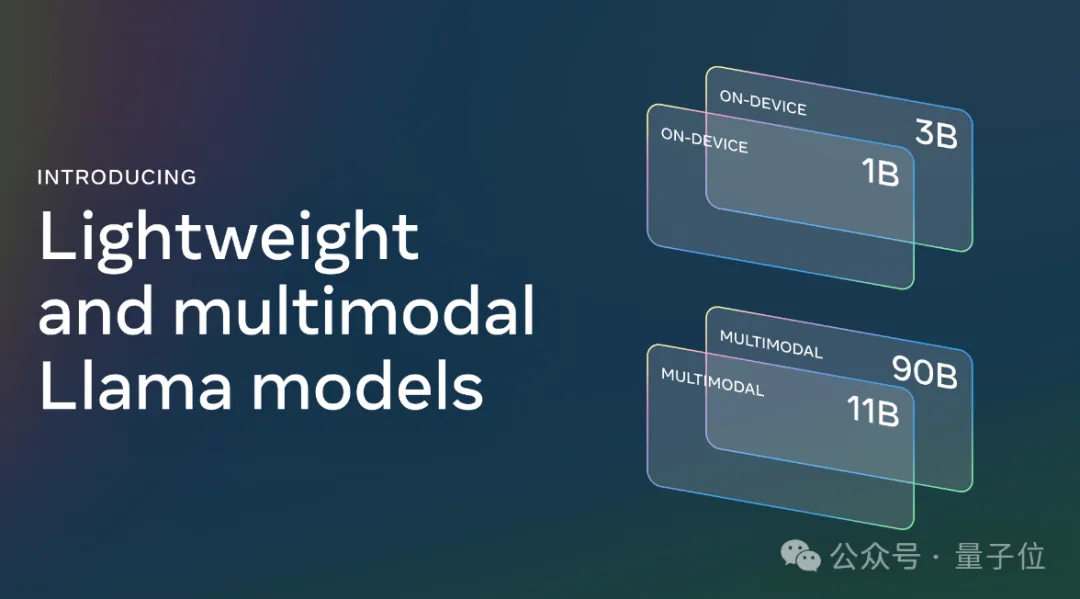

在多模态领域,开源模型也超闭源了!