「幻觉」竟是Karpathy十年前命名的?这个AI圈起名大师带火了多少概念?

「幻觉」竟是Karpathy十年前命名的?这个AI圈起名大师带火了多少概念?取名大王 Karpathy。

取名大王 Karpathy。

当前AI应用层,无数创业者都曾尝试或正走在AI+游戏的这条赛道上。AI正不断拓展游戏的边界,从赋予游戏角色(NPC)智慧,到自动化生成海量内容。然而,这条赛道并非坦途,性能、幻觉问题、玩家接受度等一系列难关等待从业者去克服。

RAG(检索增强生成)作为解决大模型"幻觉"和知识时效性问题的关键技术,已成为企业AI应用的主流架构。Contextual AI由RAG技术的创始研究者组建,致力于开发能应对复杂知识密集型任务的专业智能体。

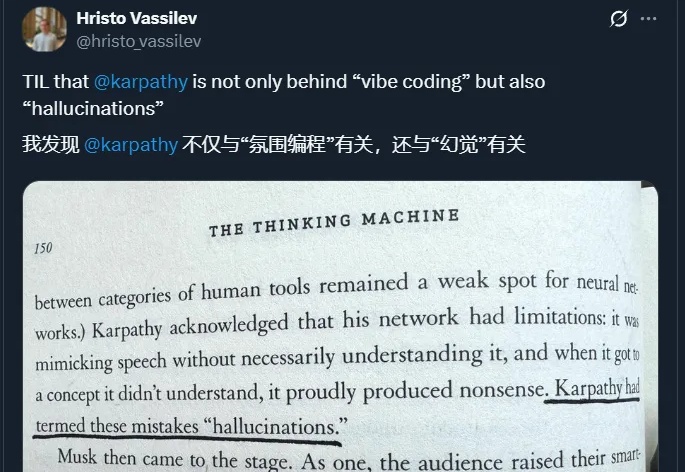

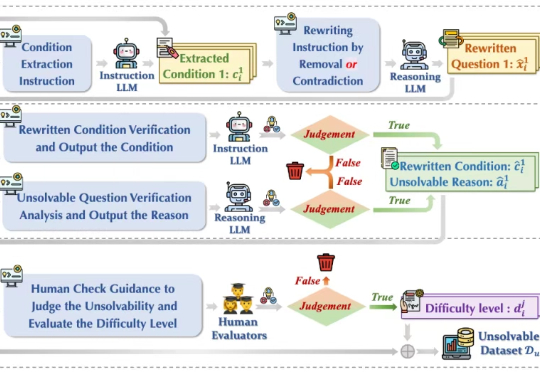

今年初以 DeepSeek-r1 为代表的大模型在推理任务上展现强大的性能,引起广泛的热度。然而在面对一些无法回答或本身无解的问题时,这些模型竟试图去虚构不存在的信息去推理解答,生成了大量的事实错误、无意义思考过程和虚构答案,也被称为模型「幻觉」 问题,如下图(a)所示,造成严重资源浪费且会误导用户,严重损害了模型的可靠性(Reliability)。

当推理链从3步延伸到50+步,幻觉率暴增10倍;反思节点也束手无策。

该大模型由海洋精准感知技术全国重点实验室(浙江大学)牵头研发,具备基础的海洋专业知识问答,以及声呐图像、海洋观测图等海洋特色多模态数据的自然语言解读能力。其采用的领域知识增强“慢思考”推理机制,相较现有通用大模型能有效降低幻觉式错误。

Anthropic 最近做了一项相当有趣的研究:让 Claude 管理其办公室的一家自动化商店。Claude 作为小店店主,运营了一个月,过程也是相当跌荡起伏,甚至在其中的一个时间段,Claude 竟然确信自己是一个真实存在的人类,并幻觉了一些并未发生过的事件。

通过“视觉神经增强”机制,直接放大模型中的视觉关键注意力头输出,显著降低模型的幻觉现象。

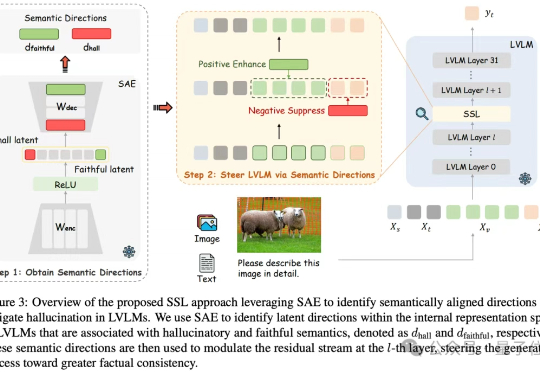

当前大型视觉语言模型(LVLMs)存在物体幻觉问题,即会生成图像中不存在的物体描述。

关于大模型产生幻觉这个事,从2023年GPT火了以后,就一直是业界津津乐道的热门话题,但始终缺乏系统性的重磅研究来深入解释其根本机制。今天,伯克利的研究者们带来一个重要研究成果:让基于Transformer架构的语言模型产生幻觉的机制,恰恰也是让它们拥有超强泛化能力的关键。这就像是一枚硬币的两面,您想要哪一面,就得接受另一面的存在。