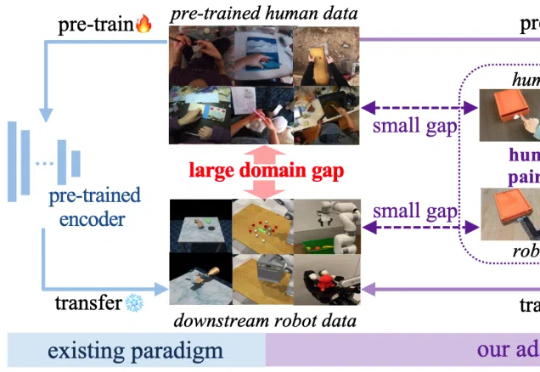

让机器人更像人类有了新方法!港科大新算法对齐人机动作形态,无需重复训练,轻量模块通用且适配

让机器人更像人类有了新方法!港科大新算法对齐人机动作形态,无需重复训练,轻量模块通用且适配“让机器人看懂世界、听懂指令、动手干活”正从科幻走向现实。

“让机器人看懂世界、听懂指令、动手干活”正从科幻走向现实。

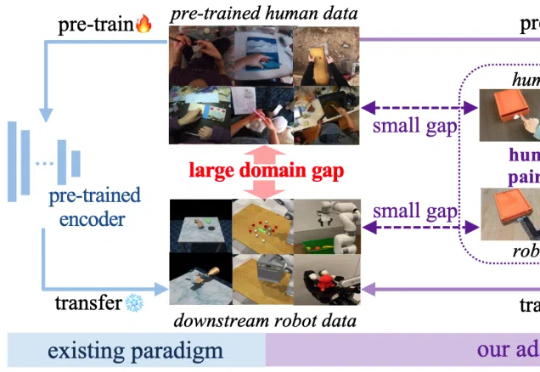

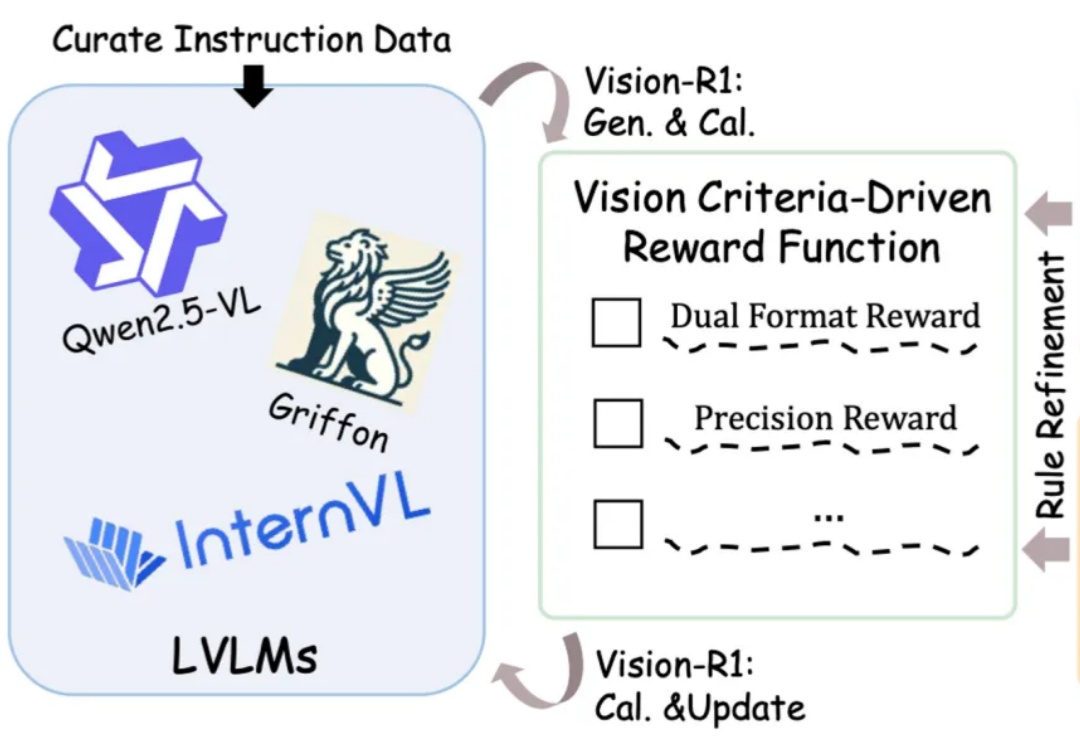

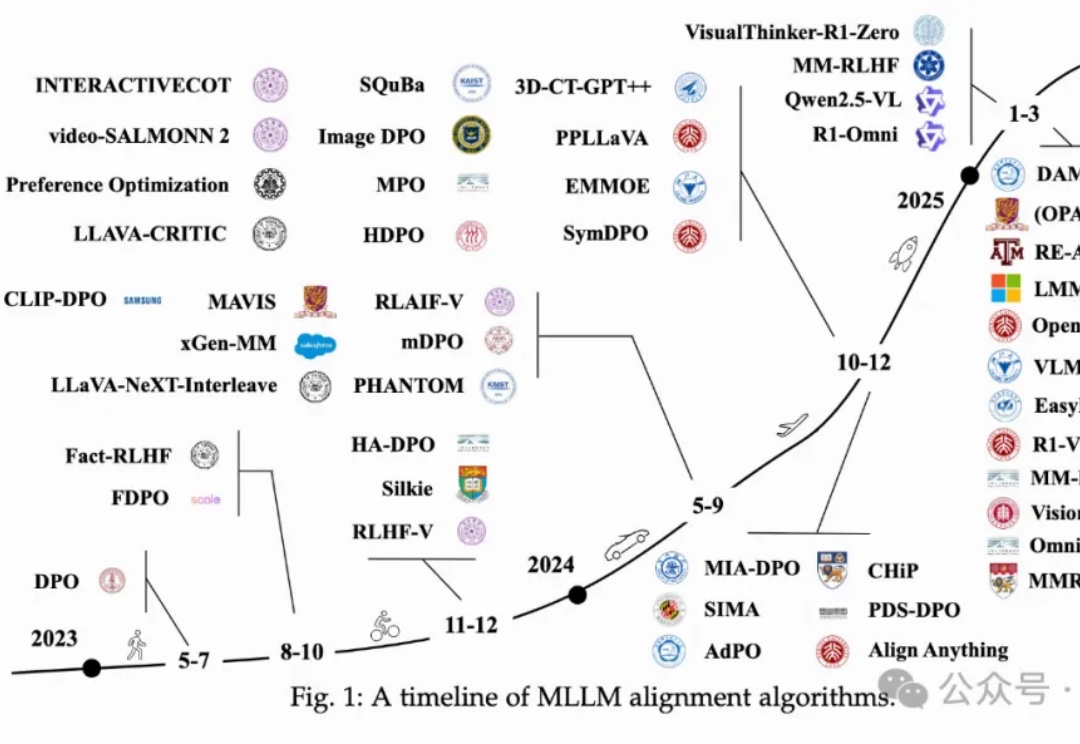

图文大模型通常采用「预训练 + 监督微调」的两阶段范式进行训练,以强化其指令跟随能力。受语言领域的启发,多模态偏好优化技术凭借其在数据效率和性能增益方面的优势,被广泛用于对齐人类偏好。目前,该技术主要依赖高质量的偏好数据标注和精准的奖励模型训练来提升模型表现。然而,这一方法不仅资源消耗巨大,训练过程仍然极具挑战。

如何让大模型更懂「人」?

视觉Token可以与LLMs词表无缝对齐了!

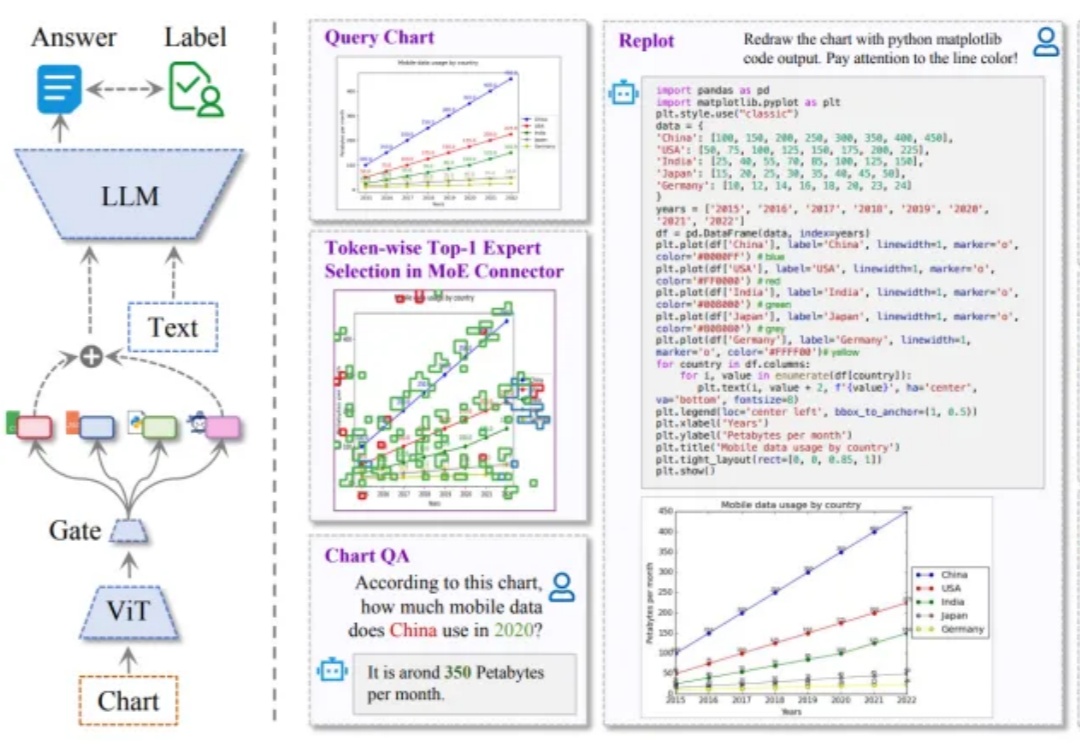

最近,全球 AI 和机器学习顶会 ICLR 2025 公布了论文录取结果:由 IDEA、清华大学、北京大学、香港科技大学(广州)联合团队提出的 ChartMoE 成功入选 Oral (口头报告) 论文。据了解,本届大会共收到 11672 篇论文,被选中做 Oral Presentation(口头报告)的比例约为 1.8%

作为一家公司,我们专注于三件事:预训练、微调和对齐。我们使用自有数据集进行预训练,这一点非常关键,而很多公司并不具备这样的能力。然后,我们用专家手工整理的数据进行微调。最有趣、最重要的部分在于对齐,这与简单地寻找“当前最优解”是截然不同的。

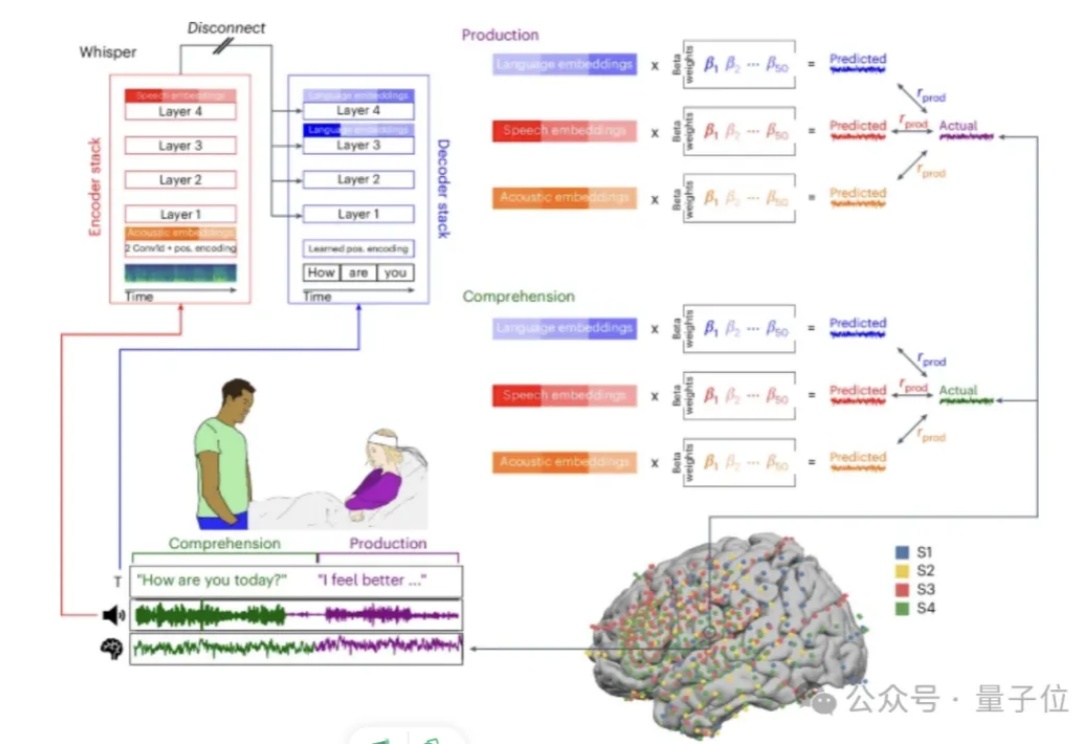

谷歌最新发现,大模型竟意外对应人脑语言处理机制?!

万字长文,对多模态LLM中对齐算法进行全面系统性回顾!

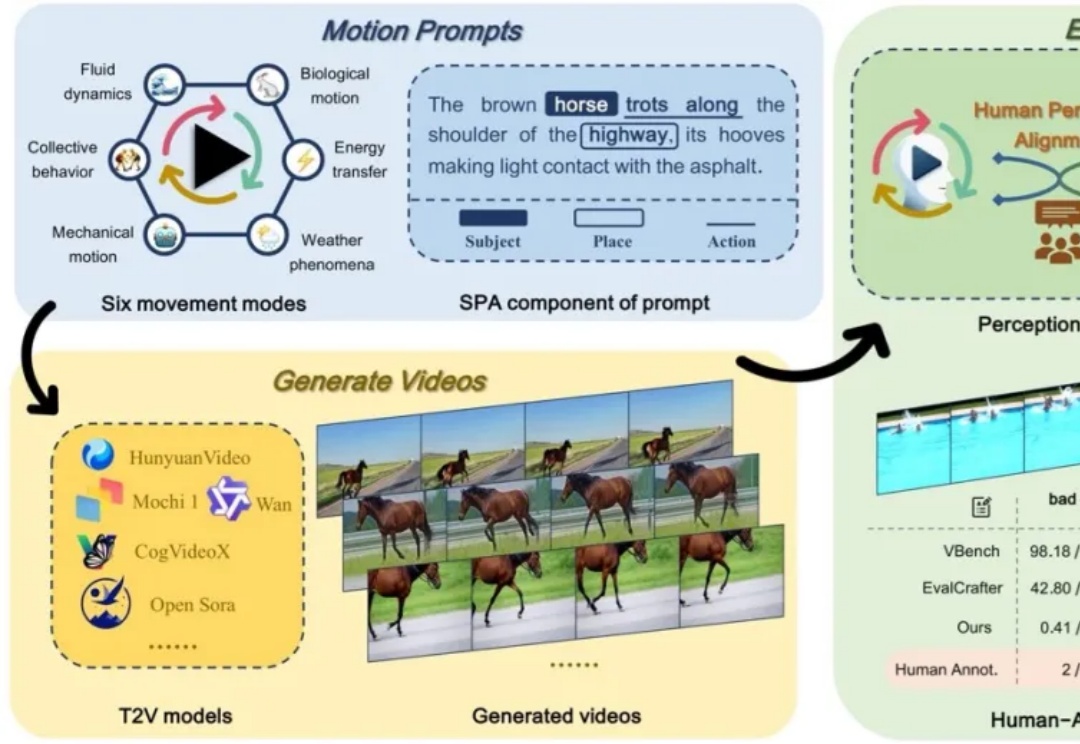

测一测现有AI生成视频是否符合物理运动规律!

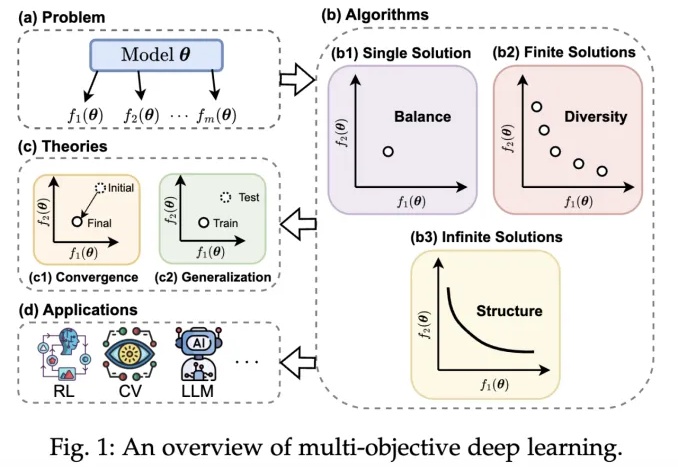

近年来,深度学习技术在自动驾驶、计算机视觉、自然语言处理和强化学习等领域取得了突破性进展。然而,在现实场景中,传统单目标优化范式在应对多任务协同优化、资源约束以及安全性 - 公平性权衡等复杂需求时,逐渐暴露出其方法论的局限性。