更快、更强、更经济!港大开源大模型RAG系统LightRAG

更快、更强、更经济!港大开源大模型RAG系统LightRAGLightRAG通过双层检索范式和基于图的索引策略提高了信息检索的全面性和效率,同时具备对新数据快速适应的能力。在多个数据集上的实验表明,LightRAG在检索准确性和响应多样性方面均优于现有的基线模型,并且在资源消耗和动态环境适应性方面表现更优,使其在实际应用中更为有效和经济。

LightRAG通过双层检索范式和基于图的索引策略提高了信息检索的全面性和效率,同时具备对新数据快速适应的能力。在多个数据集上的实验表明,LightRAG在检索准确性和响应多样性方面均优于现有的基线模型,并且在资源消耗和动态环境适应性方面表现更优,使其在实际应用中更为有效和经济。

随着对现有互联网数据的预训练逐渐成熟,研究的探索空间正由预训练转向后期训练(Post-training),OpenAI o1 的发布正彰显了这一点。

1%的合成数据,就让LLM完全崩溃了? 7月,登上Nature封面一篇论文证实,用合成数据训练模型就相当于「近亲繁殖」,9次迭代后就会让模型原地崩溃。

善智者,动于九天之上。

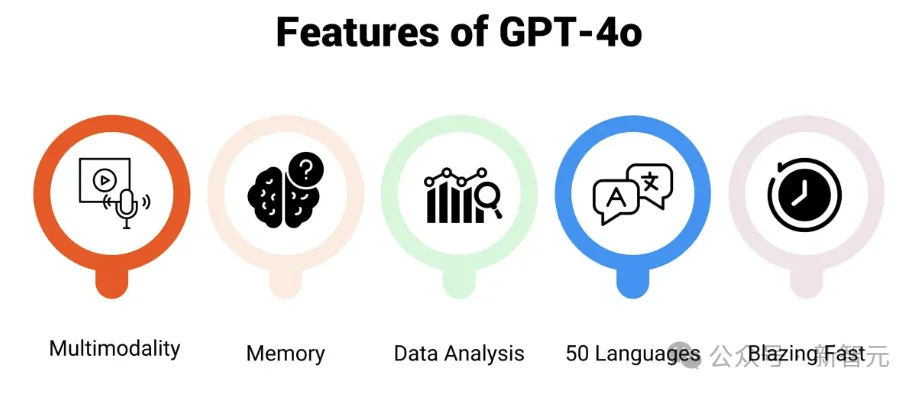

多模态大语言模型(MLLM)如今已是大势所趋。 过去的一年中,闭源阵营的GPT-4o、GPT-4V、Gemini-1.5和Claude-3.5等模型引领了时代。

教育大模型是真刚需。

计算资源并非性能提升的唯一途径:Arvind Narayanan 认为,仅仅增加计算资源并不总是能带来模型性能的等比提升。目前,数据量正逐渐成为限制AI发展的主要瓶颈。

5 大证据显示,LLM 在推理复杂问题时非常脆弱。

借助AI工具,研究人员有更多方法来快速筛选总结研究文献,他们又是如何正确/谨慎使用这些AI工具的?

AI浪潮已至,威胁更要警惕