拯救P图废柴,阿里上新多模态模型Qwen-VLo!人人免费可玩

拯救P图废柴,阿里上新多模态模型Qwen-VLo!人人免费可玩就在昨夜,阿里带着全新多模态模型Qwen-VLo开启炸场模式。据介绍,Qwen-VLo在阿里原有的多模态理解和生成能力上进行了全面升级,具备三大亮点:

就在昨夜,阿里带着全新多模态模型Qwen-VLo开启炸场模式。据介绍,Qwen-VLo在阿里原有的多模态理解和生成能力上进行了全面升级,具备三大亮点:

本周五凌晨,谷歌正式发布、开源了全新端侧多模态大模型 Gemma 3n。谷歌表示,Gemma 3n 代表了设备端 AI 的重大进步,它为手机、平板、笔记本电脑等端侧设备带来了强大的多模式功能,其性能去年还只能在云端先进模型上才能体验。

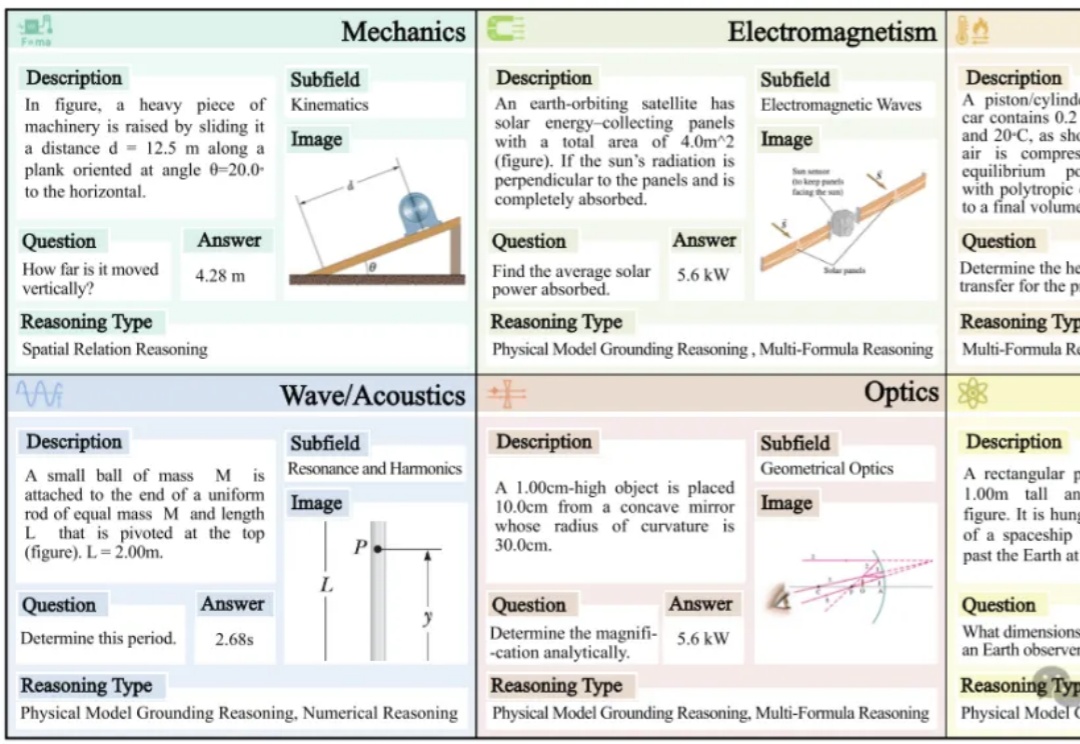

NVIDIA等研究团队提出了一种革命性的AI训练范式——视觉游戏学习ViGaL。通过让7B参数的多模态模型玩贪吃蛇和3D旋转等街机游戏,AI不仅掌握了游戏技巧,还培养出强大的跨领域推理能力,在数学、几何等复杂任务上击败GPT-4o等顶级模型。

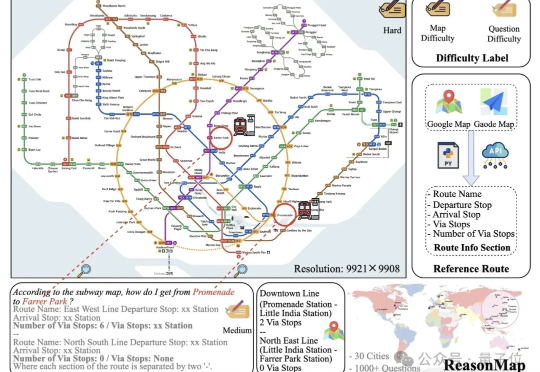

近年来,大语言模型(LLMs)以及多模态大模型(MLLMs)在多种场景理解和复杂推理任务中取得突破性进展。

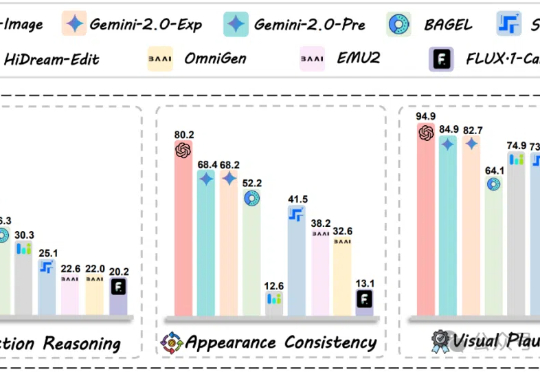

GPT-4o-Image也只能完成28.9%的任务,图像编辑评测新基准来了!360个全部由人类专家仔细思考并校对的高质量测试案例,暴露多模态模型在结合推理能力进行图像编辑时的短板。

多模态大模型(MLLM)在静态图像上已经展现出卓越的 OCR 能力,能准确识别和理解图像中的文字内容。MME-VideoOCR 致力于系统评估并推动MLLM在视频OCR中的感知、理解和推理能力。

表现最好的GPT-o4 mini,物理推理能力也远不及人类!

字节最近真的猛猛开源啊……这一次,他们直接开源了GPT-4o级别的图像生成能力。不止于此,其最新融合的多模态模型BAGEL主打一个“大一统”, 将带图推理、图像编辑、3D生成等功能全都集中到了一个模型。

来自香港科技大学、腾讯西雅图AI Lab、爱丁堡大学、Miniml.AI、英伟达的研究者联合提出了MMLongBench,旨在全面评估多模态模型的长文本理解能力。

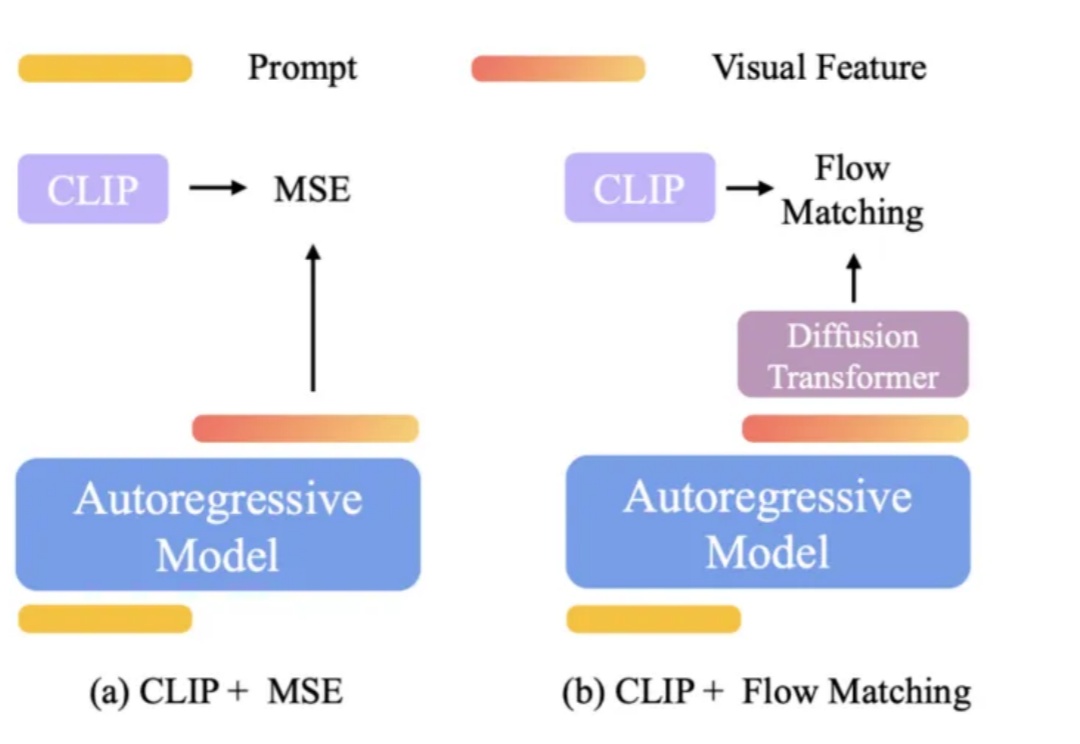

OpenAI 的 GPT-4o 在图像理解、生成和编辑任务上展现了顶级性能。流行的架构猜想是: