南大周志华团队最新力作:一个算法通吃所有,在线学习迎来新范式?

南大周志华团队最新力作:一个算法通吃所有,在线学习迎来新范式?世界是动态变化的。为了理解这个动态变化的世界并在其中运行,AI 模型必须具备在线学习能力。为此,该领域提出了一种新的性能指标 —— 适应性遗憾值(adaptive regret),其定义为任意区间内的最大静态遗憾值。

世界是动态变化的。为了理解这个动态变化的世界并在其中运行,AI 模型必须具备在线学习能力。为此,该领域提出了一种新的性能指标 —— 适应性遗憾值(adaptive regret),其定义为任意区间内的最大静态遗憾值。

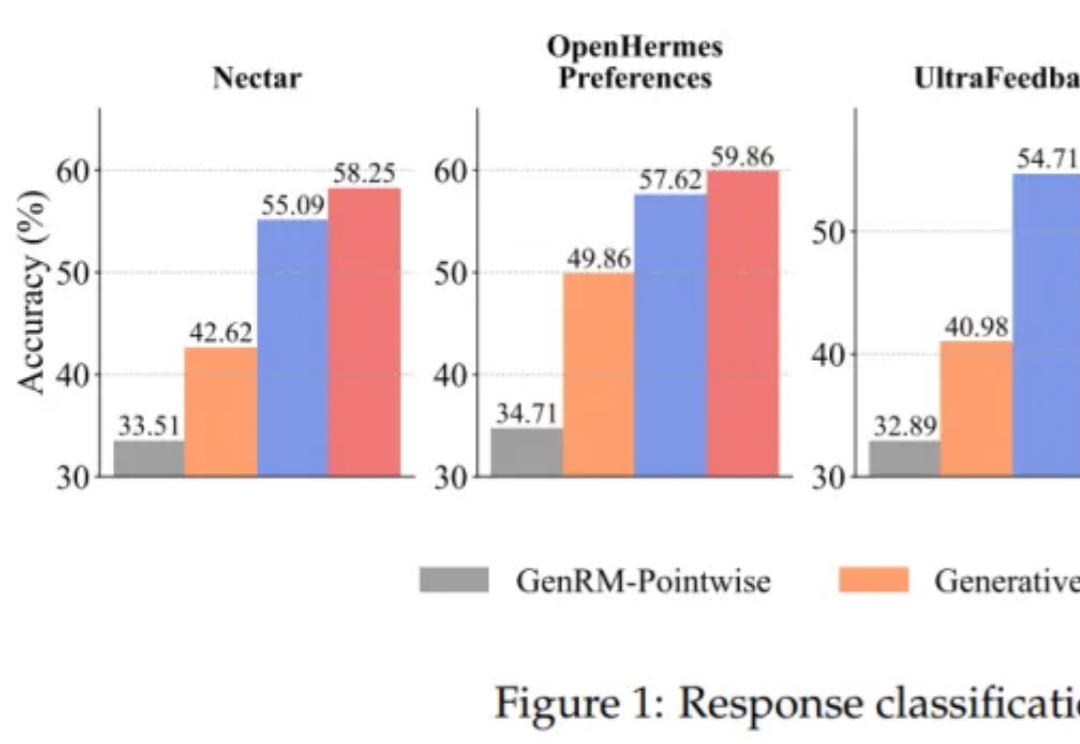

将大语言模型(LLMs)与复杂的人类价值观对齐,仍然是 AI 面临的一个核心挑战。当前主要的方法是基于人类反馈的强化学习(RLHF)。该流程依赖于一个通过人类偏好训练的奖励模型来对模型输出进行评分,最终对齐后的 LLM 的质量在根本上取决于该奖励模型的质量。

大模型时代,全世界AI从业者追赶OpenAI GPT系列的脚步仍未停歇,但也有人,坚持深耕在国产原创的另一条大模型之路上。

近段时间,世界模型的相关研究成果正如雨后春笋版不断涌现,光是我们报道过的就已有南大周志华团队的世界模型 Whale、Yann LeCun 团队的世界模型研究、李飞飞 World Labs 的空间智能研究、谷歌的强大世界模型 Genie 2 以及刚刚开源的像是能模拟万物的生成式物理引擎 Genesis。

「Scaling Law」和「打脸时刻」,绝对是2024年科技智能领域的年度关键词。

世界模型又出新进展了,来自国内机构。

南京大学周志华教授提出的「学件」范式通过模型 + 规约的思路构建学件市场(现称学件基座系统),让用户根据需求从中统一地选择和部署模型。如今学件范式迎来了首个开源的基础平台 —— 北冥坞(Beimingwu)。