推理效率狂飙60倍:DiDi-Instruct让扩散大模型16步超越千步GPT

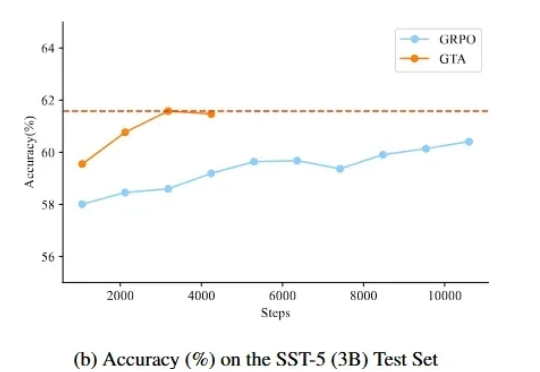

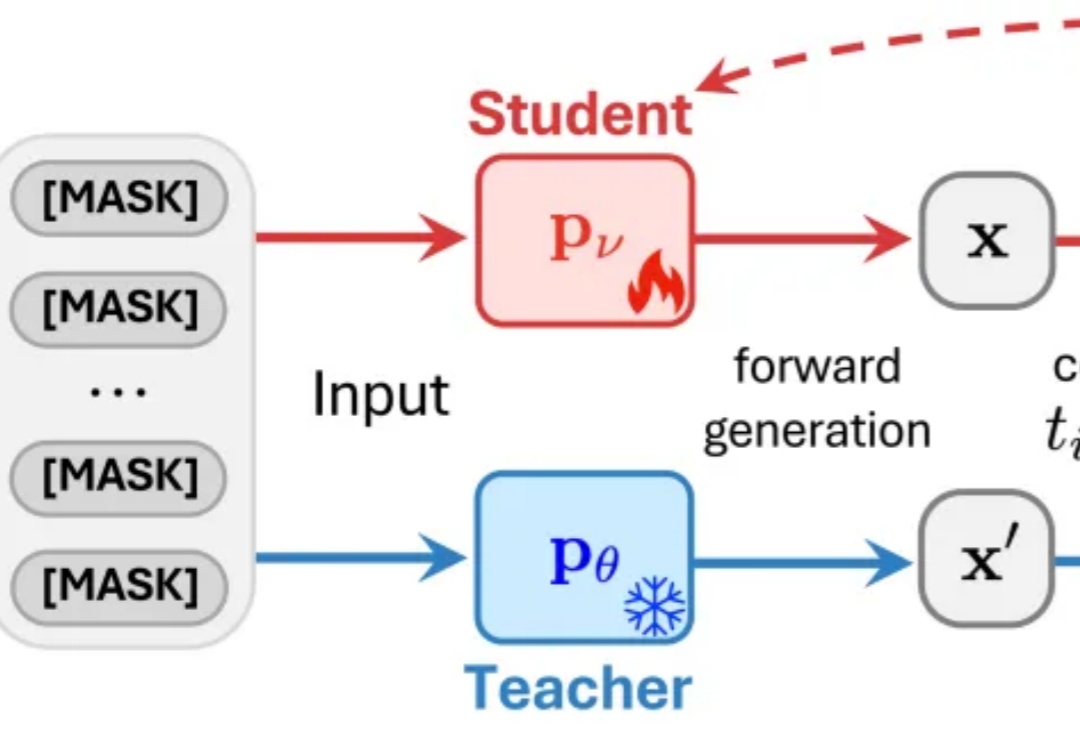

推理效率狂飙60倍:DiDi-Instruct让扩散大模型16步超越千步GPT近日,来自普渡大学、德克萨斯大学、新加坡国立大学、摩根士丹利机器学习研究、小红书 hi-lab 的研究者联合提出了一种对离散扩散大语言模型的后训练方法 —— Discrete Diffusion Divergence Instruct (DiDi-Instruct)。经过 DiDi-Instruct 后训练的扩散大语言模型可以以 60 倍的加速超越传统的 GPT 模型和扩散大语言模型。

来自主题: AI技术研报

9191 点击 2025-10-28 09:40