ICML 2024高分论文 | 零阶优化器微调大模型,大幅降低内存

ICML 2024高分论文 | 零阶优化器微调大模型,大幅降低内存开源大语言模型(LLM)百花齐放,为了让它们适应各种下游任务,微调(fine-tuning)是最广泛采用的基本方法。基于自动微分技术(auto-differentiation)的一阶优化器(SGD、Adam 等)虽然在模型微调中占据主流,然而在模型越来越大的今天,却带来越来越大的显存压力。

开源大语言模型(LLM)百花齐放,为了让它们适应各种下游任务,微调(fine-tuning)是最广泛采用的基本方法。基于自动微分技术(auto-differentiation)的一阶优化器(SGD、Adam 等)虽然在模型微调中占据主流,然而在模型越来越大的今天,却带来越来越大的显存压力。

如何在有限的内存下实现高效的大模型推理,是端侧AI发展的重要任务。

天津大学量子智能与语言理解团队创新性地将量子计算引入隐式神经表征领域,提出了量子隐式表征网络(Quantum Implicit Representation Network, QIREN)。

基于 Transformer架构的大型语言模型在各种基准测试中展现出优异性能,但数百亿、千亿乃至万亿量级的参数规模会带来高昂的服务成本。例如GPT-3有1750亿参数,采用FP16存储,模型大小约为350GB,而即使是英伟达最新的B200 GPU 内存也只有192GB ,更不用说其他GPU和边缘设备。

外媒最新消息称,美国政府正在考虑进一步限制中国获得尖端半导体技术,包括用于制造AI加速器的关键硬件技术全环绕栅极(GAA)和高带宽内存(HBM)。

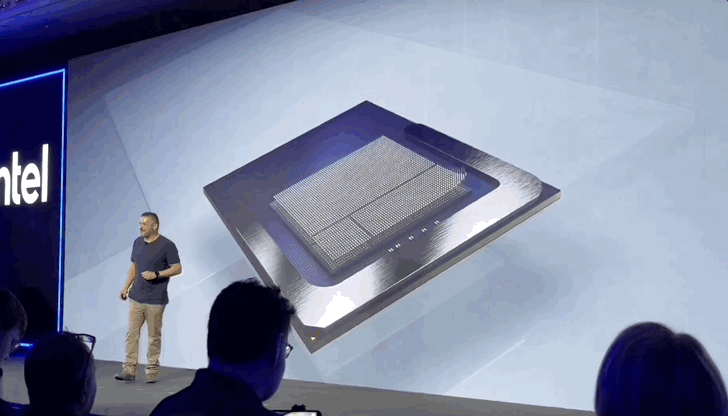

英特尔为了AI,再次做出重大架构变革: 像手机一样搞起SoC(系统级芯片),你的下一台笔记本不会再有独立内存条。 刚刚推出的新一代AI PC低功耗移动平台架构Lunar Lake,采用全新MoP(Memory on Package)封装,片上集成16或32GB的LPDDR5X内存,无法再额外连接更多RAM。

英特尔终究还是学了苹果。

AI独角兽Inflection AI,在经历投资方微软「挖角」之后,近况如何?在上周接受VentureBeat独家采访时,Inflection AI公布了其由经验丰富的硅谷老将组成的新领导团队,公司目前资金充足,正在扩大其工程团队。计划将情感AI嵌入商业机器人,凭借其在AI情感智能领域的领先地位进军2B市场。

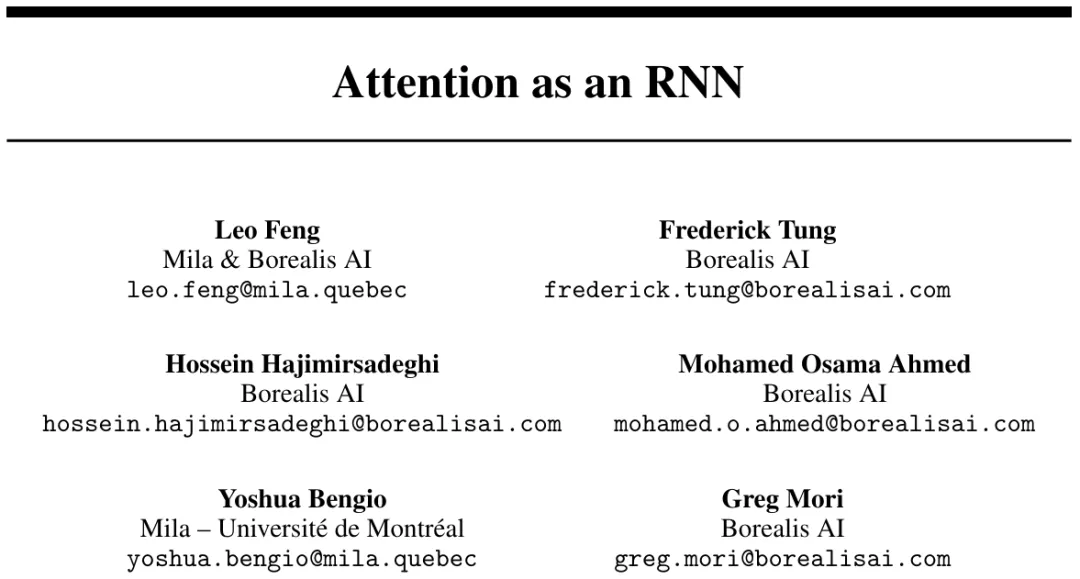

既能像 Transformer 一样并行训练,推理时内存需求又不随 token 数线性递增,长上下文又有新思路了?

随着AI带来的算力需求大爆发,以半导体为代表的各类硬件企业的营收也纷纷水涨船高。