大模型如何泛化出多智能体推理能力?清华提出策略游戏自博弈方案MARSHAL

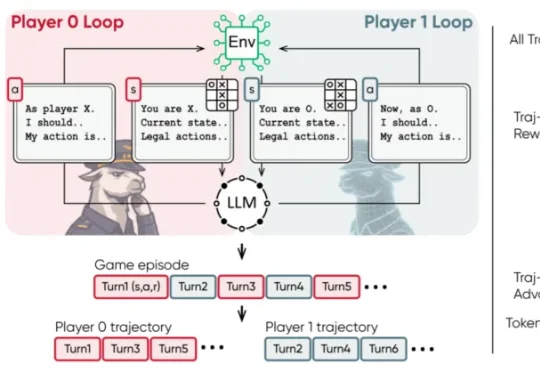

大模型如何泛化出多智能体推理能力?清华提出策略游戏自博弈方案MARSHAL近日,清华大学等机构的研究团队提出了 MARSHAL 框架。该框架利用强化学习,让大模型在策略游戏中进行自博弈(Self-Play)。实验表明,这种多轮、多智能体训练不仅提升了模型在游戏中的博弈决策水

近日,清华大学等机构的研究团队提出了 MARSHAL 框架。该框架利用强化学习,让大模型在策略游戏中进行自博弈(Self-Play)。实验表明,这种多轮、多智能体训练不仅提升了模型在游戏中的博弈决策水

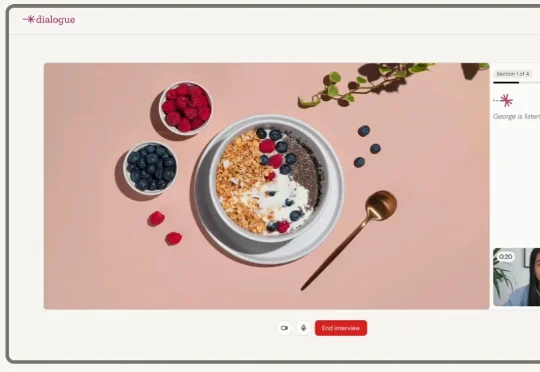

在传统企业中,市场调研往往是决策最慢的一环,从问卷设计到洞察输出要花上数周。Dialogue AI试图用AI自动化整个研究流程,让洞察生成的速度与产品迭代保持同步。它的出现不仅是效率的革新,更是企业理解用户方式的范式转变——让研究从被动响应变为实时驱动。

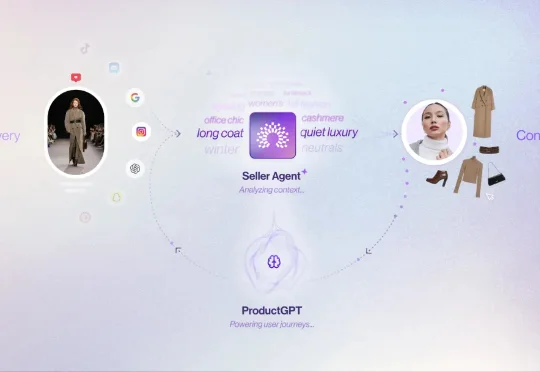

Spangle 是一家由前 Bolt 首席执行官 Maju Kuruvilla 创办的 AI 电子商务初创公司,已在新一轮融资中筹集了 1500 万美元,公司投后估值达 1 亿美元。本轮完全股权性质的A 轮融资由 NewRoad Capital Partners 领投。一年多前,这家总部位于西雅图的初创企业以 3000 万美元投前估值完成了 600 万美元的种子轮融资 。

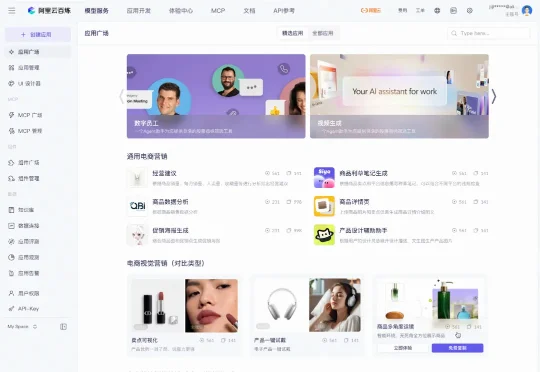

百炼升级了其提出的「1+2+N」的蓝图:其中最底层的 1 是模型与云服务,中间层的 2 是高代码、低代码的开发范式,在最上层的 N 则是面向不同任务的开发组件。这套能力覆盖了生产级智能体构建的全生命周期。

谭老师我, 每年会找几个看似冷门, 其实值得深挖的选题, 啥意义,没苦硬吃? 这是拉开认知差距的办法。 科技这行,赚小钱靠信息差, 抓大钱靠认知差, 这篇灵感来源于, 有几位搞AI底层技术的朋友常说,

CaveAgent的核心思想很简单:与其让LLM费力地去“读”数据的文本快照,不如给它一个如果不手动重启、变量就永远“活着”的 Jupyter Kernel。这项由香港科技大学(HKUST)领衔的研究,为我们展示了一种“Code as Action, State as Memory”的全新可能性。它解决了所有开发过复杂Agent的工程师最头疼的多轮对话中的“失忆”与“漂移”问题。

出走5年,估值翻倍!曾被嘲笑「太保守」的Anthropic,正凭3500亿美元身价硬刚OpenAI。看理想主义者如何靠极致安全与Coding神技,在ARR激增的复仇路上,终结Sam Altman的霸权!

面对一张精美的画作,你的第一反应是什么?

2026 年,基模会不会吃掉所有应用场景?

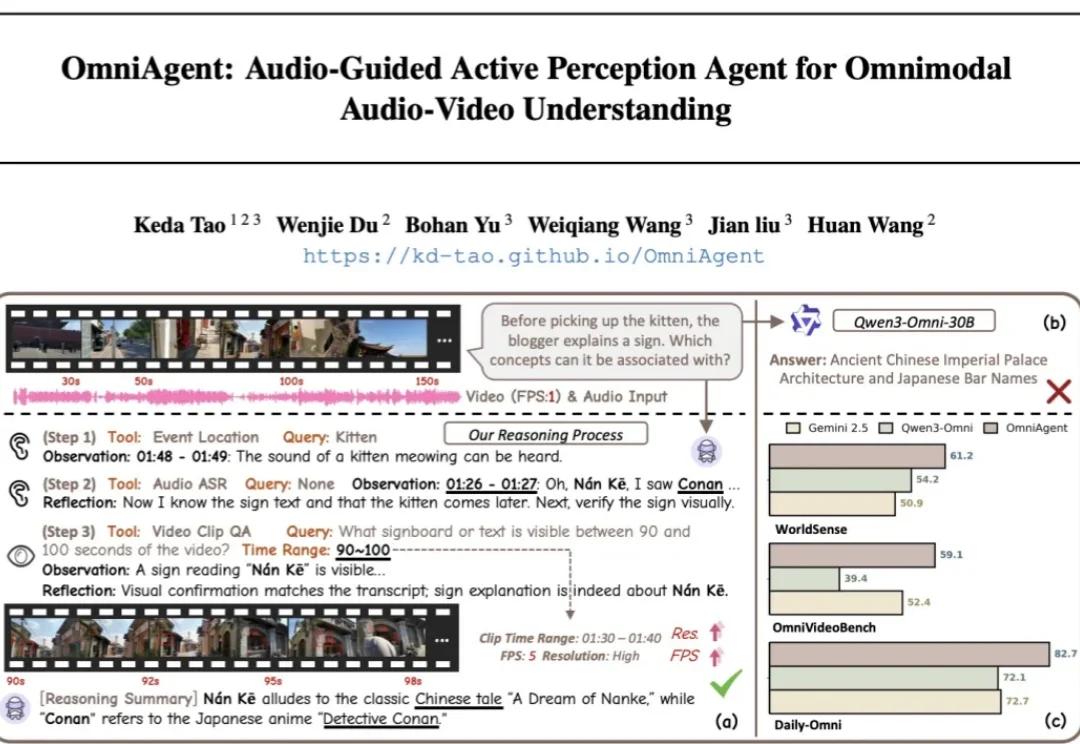

针对端到端全模态大模型(OmniLLMs)在跨模态对齐和细粒度理解上的痛点,浙江大学、西湖大学、蚂蚁集团联合提出 OmniAgent。这是一种基于「音频引导」的主动感知 Agent,通过「思考 - 行动 - 观察 - 反思」闭环,实现了从被动响应到主动探询的范式转变。