灵宇宙获2亿新融资,要做AI世界操作系统

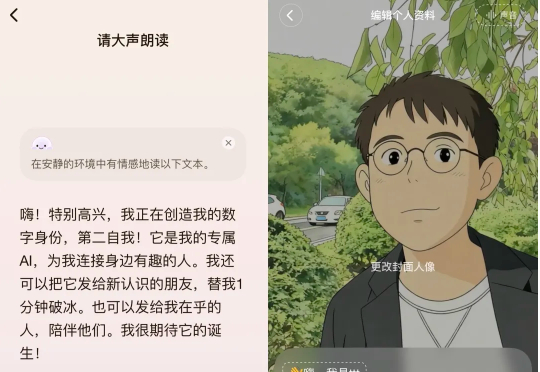

灵宇宙获2亿新融资,要做AI世界操作系统「暗涌Waves」获悉,灵宇宙近日完成2亿元PreA轮融资,由上海国际集团旗下国方创新、国泰海通、广发信德、滴滴出行、拉卡拉旗下考拉基金、润建股份等金融机构和上市公司参投,老股东超额追投。

「暗涌Waves」获悉,灵宇宙近日完成2亿元PreA轮融资,由上海国际集团旗下国方创新、国泰海通、广发信德、滴滴出行、拉卡拉旗下考拉基金、润建股份等金融机构和上市公司参投,老股东超额追投。

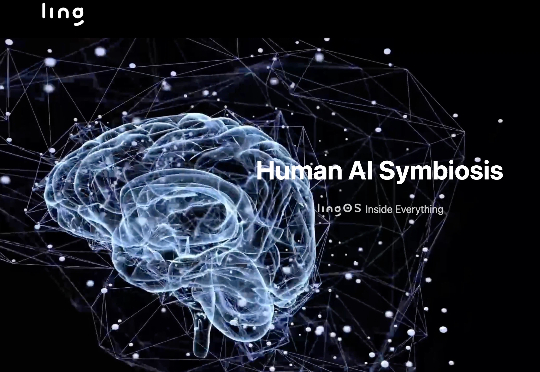

前 OpenAI 联合创始人、特斯拉 AI 总监 Andrej Karpathy 也一样。他在前几天发推,说自己「开始养成用 LLM 阅读一切的习惯」。Karpathy 在周六用氛围编程做了个新的项目,让四个最新的大模型组成一个 LLM 议会,给他做智囊团。

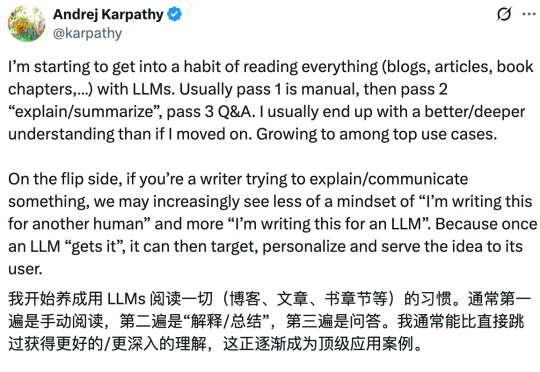

首个拿下国际物理奥林匹克竞赛IPhO 2025理论考试金牌的开源模型,出自国产。上海人工智能实验室团队推出新模型家族,代号P1。在IPhO 2025理论考试中,P1-235B-A22B取得21.2/30分,成为首个达到该金牌线的开源模型,仅次于Gemini-2.5-Pro与GPT-5。

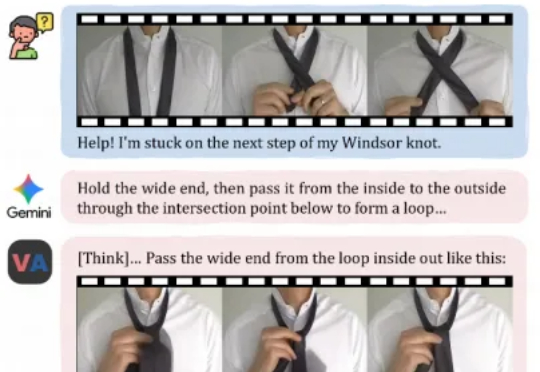

今天,来自快手可灵团队和香港城市大学的研究者们,正在尝试打破这一界限。他们提出了一个全新的任务范式——「视频作为答案」,并发布了相应模型VANS。而这项工作则开创性地提出了Video-Next Event Prediction任务,要求模型直接生成一段动态视频作为回答。

就在一周前,全宇宙最火爆的推理框架 SGLang 官宣支持了 Diffusion 模型,好评如潮。团队成员将原本在大语言模型推理中表现突出的高性能调度与内核优化,扩展到图像与视频扩散模型上,相较于先前的视频和图像生成框架,速度提升最高可达 57%:

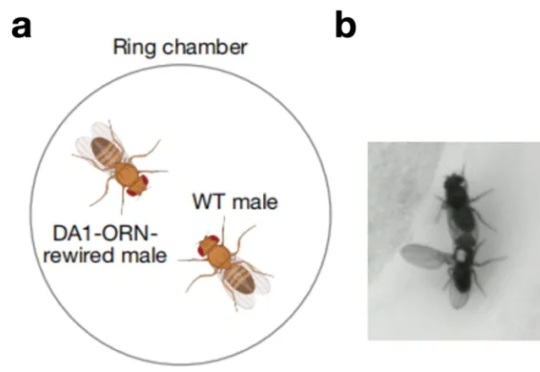

一只原本对同伴毫无兴趣的雄性果蝇,会不会突然开始疯狂地向其他雄性求爱。这看起来有点荒诞不羁的场景,发生在了北京大学校友、美国斯坦福大学骆利群课题组博士后、即将于 2026 年回国入职西湖大学的吕程的实

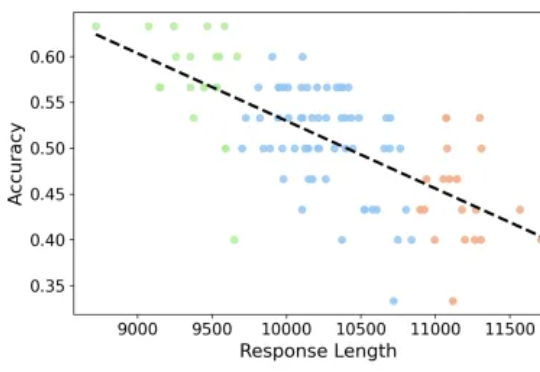

专注推理任务的 Large Reasoning Models 在数学基准上不断取得突破,但也带来了一个重要问题:越想越长、越长越错。本文解读由 JHU、UNC Charlotte 等机构团队的最新工作

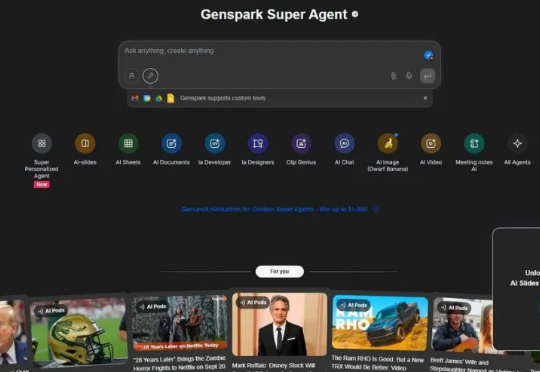

11 月 21 日,AI 初创公司 Genspark 正式宣布完成 2.75 亿美元 B 轮融资。上线仅五个月,Genspark 年化收入已突破 5000 万美元,跻身行业增长最快的 AI 企业之一。

前沿AI竞赛在2025年11月达到高潮。48小时内,谷歌推出Gemini 3 Pro宣称在主要推理基准测试中领先,而OpenAI立即用GPT-5.1-Codex-Max反击,这是一款专门训练用于通过创新"压缩"(compaction)技术自主工作超过24小时的专业编码模型[43]。加上Claude Sonnet 4.5已确立的编码统治地位和激进的安全过滤器,开发者面临前所未有的选择:

AI Everywhere。 我们正进入一个万物皆 AI 的世界。 从《钢铁侠》中无所不能的助理「贾维斯」(him),到电影《她》里善解人意的情感伴侣「萨曼莎」(her),这些一度只存在于科幻中的场景