2026拜年别写对联了,让AI替你写首歌吧

2026拜年别写对联了,让AI替你写首歌吧AI又在某个方面悄悄超越我了——这次是五音比我全!

AI又在某个方面悄悄超越我了——这次是五音比我全!

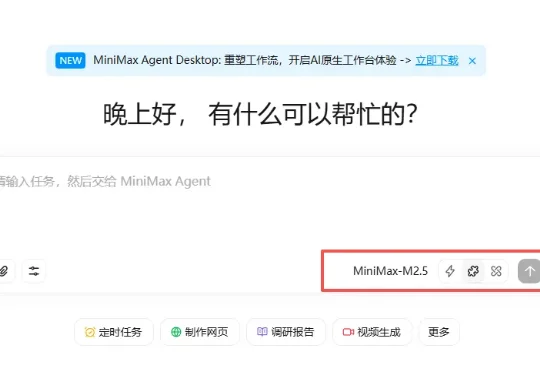

这两天 AI 圈真的太热闹了,就在网传 DeepSeek 要更新支持 100 万 Token 上下文的新模型时,MiniMax 率先冲锋,更新了他们的新旗舰模型:MiniMax-M2.5。更有意思的是,国外网友这段时间对国内 AI 大模型的更新节奏格外关注,他们甚至把这种争先更新的现象称为:Happy Chinese new year!

前天,我日常刷 X,当 AI 班狗 🐶 的时候,刷到一条推文,就是下面这条:

一位牛津哲学博士,正在Anthropic教全球顶尖AI模型如何「做人」。这场跨物种的「育儿实验」,比科幻更炸裂。

春节还没到,「过年的气氛」已经渗入科技圈每个人的毛孔。单说 AI 大模型这一块,刚刚发布的有 kimi 2.5 和 Step 3.5 Flash,即将发布的据说还有 DeepSeek V4,GPT-5.3、Claude Sonnet 5、Qwen 3.5,GLM-5,说不定一觉醒来,现有的技术就要被颠覆。

2026 开年至今,人工智能圈子最火的是一只小龙虾 Clawdbot 。

这不是科幻片,而是 2026 年 2 月刚刚发生的现实。

刚刚,谷歌的一位狠人公开了自己AI产品开发心得!

过去一年,大模型写代码的能力几乎以肉眼可见的速度提升。从简单脚本到完整功能模块,GPT、Claude、DeepSeek 等模型已经能够在几秒钟内生成看起来相当 “专业” 的代码。

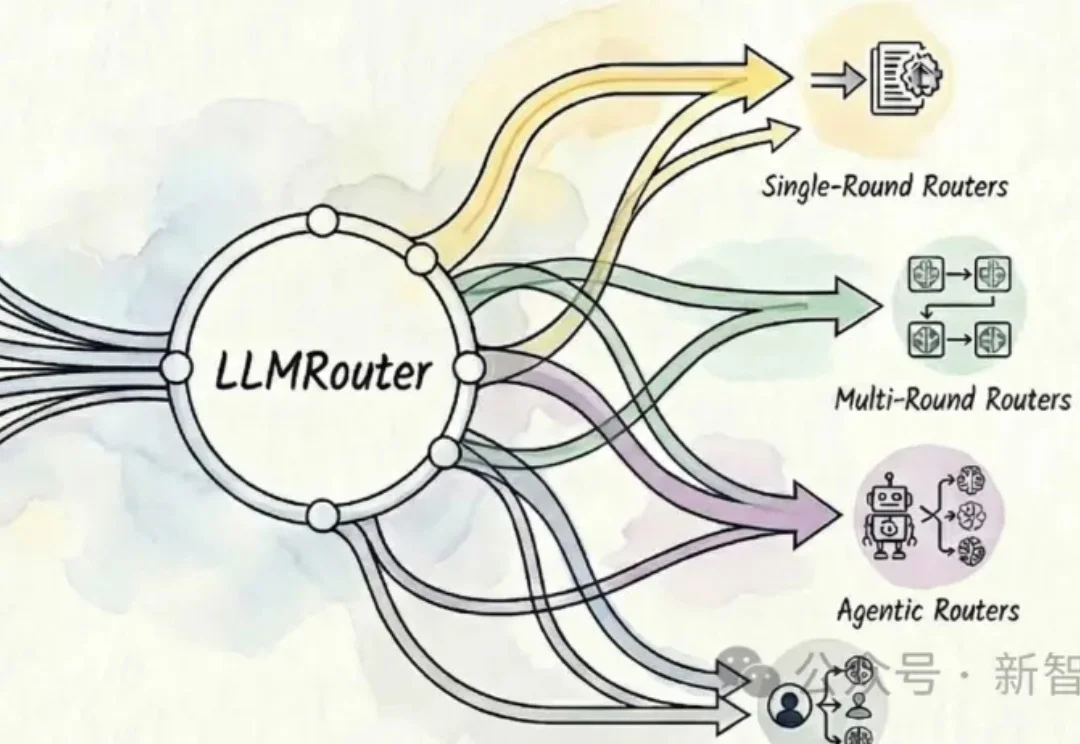

UIUC开源的智能模型路由框架LLMRouter可以自动为大模型应用选择最优模型,提供16+路由策略,覆盖单轮选择、多轮协作、个性化偏好和Agent式流程,在性能、成本与延迟间灵活权衡。