多个编码智能体同时使用会不会混乱?海外开发者热议

多个编码智能体同时使用会不会混乱?海外开发者热议结合现在已经非常成熟 CLI、IDE 工具等的辅助,采用编码智能体进行开发工作已经成为了一种常态,甚至成为了一种新的生活方式。不仅仅是程序员,产品类、设计类岗位的从业人员都已广泛采用 AI 编码智能体辅助工作,AI 生成的代码比例越来越高。

结合现在已经非常成熟 CLI、IDE 工具等的辅助,采用编码智能体进行开发工作已经成为了一种常态,甚至成为了一种新的生活方式。不仅仅是程序员,产品类、设计类岗位的从业人员都已广泛采用 AI 编码智能体辅助工作,AI 生成的代码比例越来越高。

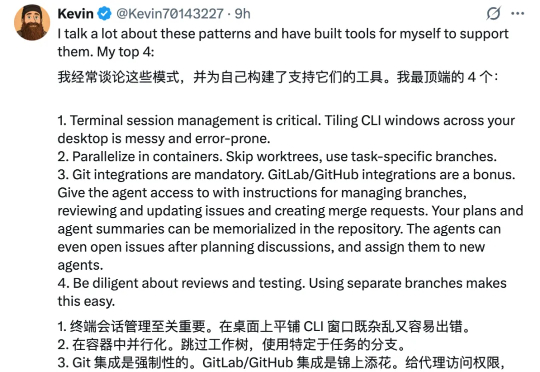

来自 UIUC 与 Salesforce 的研究团队提出了一套系统化方案:UserBench —— 首次将 “用户特性” 制度化,构建交互评测环境,用于专门检验大模型是否真正 “懂人”;UserRL —— 在 UserBench 及其他标准化 Gym 环境之上,搭建统一的用户交互强化学习框架,并系统探索以用户为驱动的奖励建模。

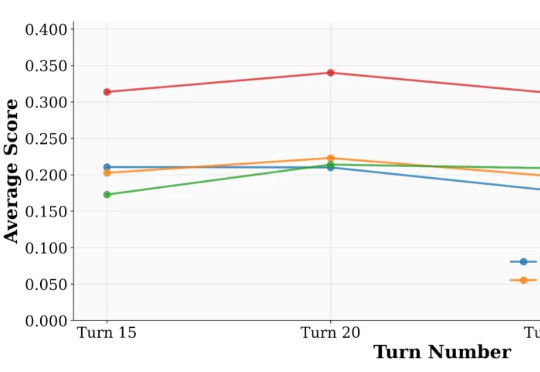

清华大学朱军教授团队,NVIDIA Deep Imagination 研究组与斯坦福 Stefano Ermon 团队联合提出了一种全新的扩散模型强化学习(RL)范式 ——Diffusion Negative-aware FineTuning (DiffusionNFT)。该方法首次突破现有 RL 对扩散模型的基本假设,直接在前向加噪过程(forward process)上进行优化

“科学的尽头是玄学。”朋友圈的 985 研究生如是说。 封面图片由AI生成 “AI 说我能暴富,但我书都没翻开。” 2018 年,一个男大学生因为朋友的怂恿,酒局中打开了一本星座占卜书,当他只是根据朋

国庆长假,AI 大模型献礼的方式是一波接一波的更新。OpenAI 突然发布 Sora2,DeepSeek 更新了 V3.2,智谱更新了 GLM-4.6,Kimi 则是更新了 App,然后默默在自己的版本记录里面,写下了这句话。

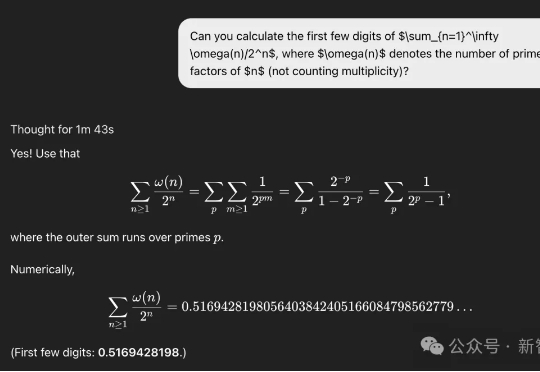

10分钟,答案浮出水面!陶哲轩用ChatGPT,发现一道30多年来一直认为悬而未决的问题,其实早被华人数学家给破解了。没有「神迹」,他这次只是用对了工具链:ChatGPT算出级数前几项、输入特定数据库、命中序列、找到文献、确认答案。

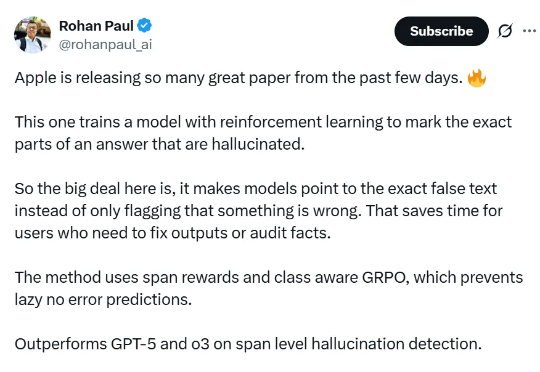

论文提出的方法名为 RL4HS,它使用了片段级奖励(span-level rewards)和类别感知的 GRPO(Class-Aware Group Relative Policy Optimization),从而避免模型偷懒、只输出无错误预测。

9 月 8 日,美国弗吉尼亚州的卡丽·爱德华兹走进州彩票局领奖时,就跟去拿外卖一样平静。她前几天买了一张彩票,中了 15 万美元(约 106 万元),她决定全部捐出,因为这张彩票,是她随口问 ChatGPT 要来的数字,没想到真中奖了,卡丽并不想贪图这种幸运的「偏财」,她已将奖金捐赠给不同的慈善机构。

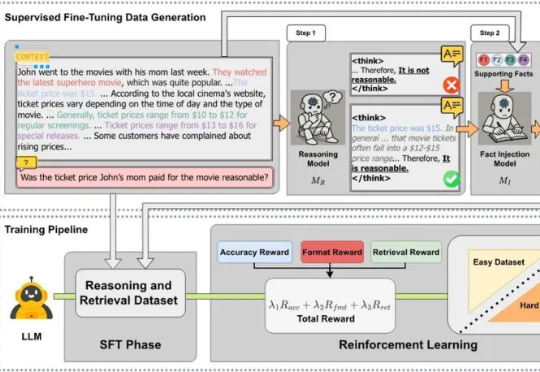

近日,来自 MetaGPT、蒙特利尔大学和 Mila 研究所、麦吉尔大学、耶鲁大学等机构的研究团队发布 CARE 框架,一个新颖的原生检索增强推理框架,教会 LLM 将推理过程中的上下文事实与模型自身的检索能力有机结合起来。该框架现已全面开源,包括训练数据集、训练代码、模型 checkpoints 和评估代码,为社区提供一套完整的、可复现工作。

早在 2021 年,研究人员就已经发现了深度神经网络常常表现出一种令人困惑的现象,模型在早期训练阶段对训练数据的记忆能力较弱,但随着持续训练,在某一个时间点,会突然从记忆转向强泛化。