树莓派上流畅运行大模型!让终端具备自主学习与记忆能力|对话RockAI CEO刘凡平

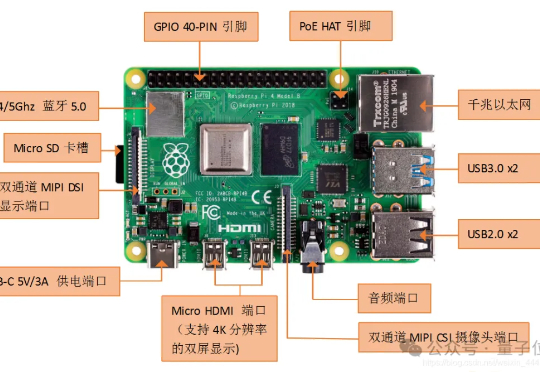

树莓派上流畅运行大模型!让终端具备自主学习与记忆能力|对话RockAI CEO刘凡平他们打造的端侧大模型已经可以在树莓派这样的微型设备上流畅运行,首批搭载Yan架构大模型的具身智能机器人也已经面世。当下AI算力竞赛愈演愈烈之际,他们的“低算力”“群体智能”之路正在获得更多关注。本期「大模型创新架构」主题访谈,量子位邀请到RockAI CEO刘凡平,聊聊他们选择非Transformer架构路线背后的故事,以及通过架构及算法创新实现AGI的技术愿景。