爆火Sora震惊威尔·史密斯,真人整活吃意面视频!OpenAI技术路线或早在1月被成功预言

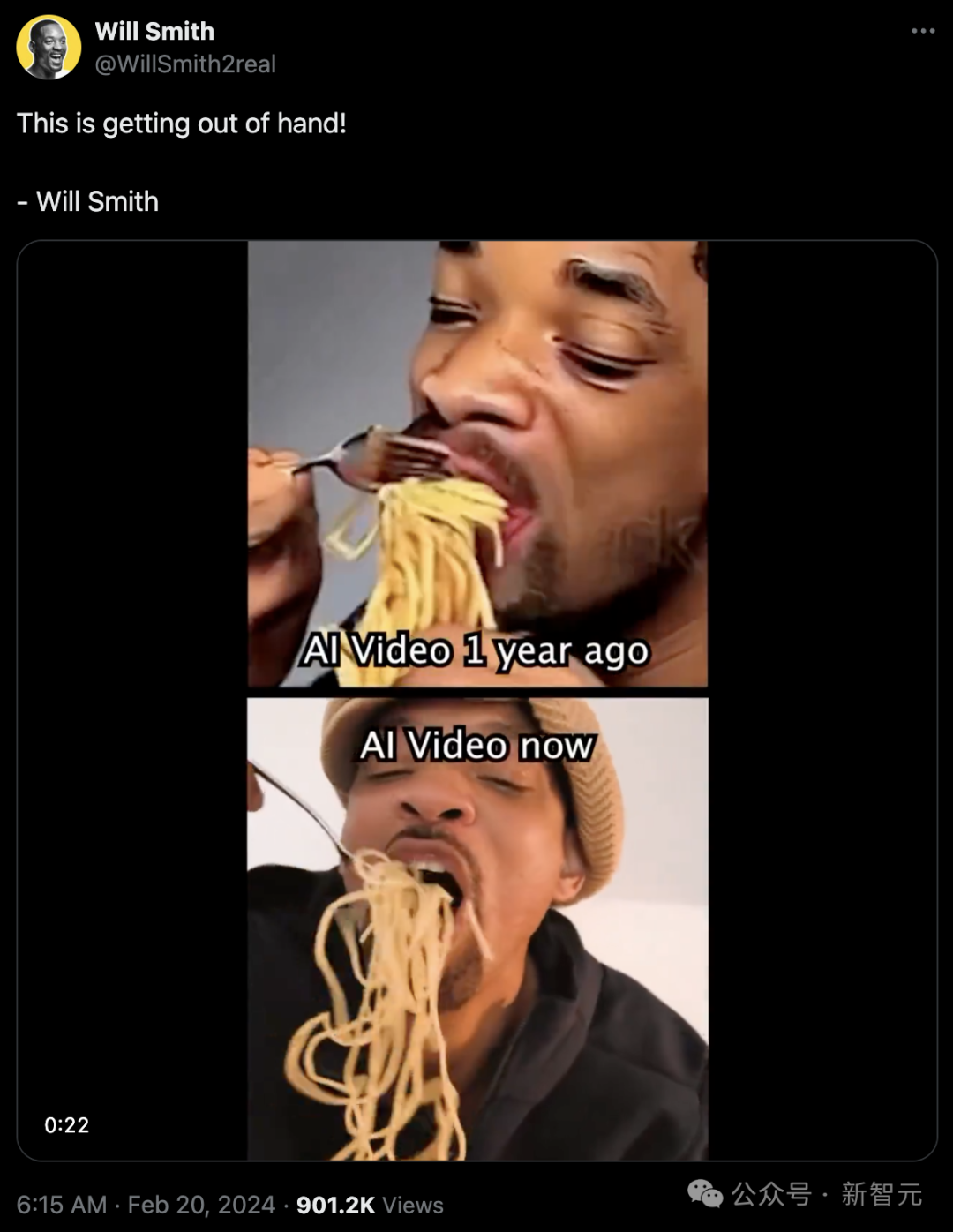

爆火Sora震惊威尔·史密斯,真人整活吃意面视频!OpenAI技术路线或早在1月被成功预言威尔·史密斯的这段视频,把全网都骗了!其实Sora的技术路线,早已被人预言了。李飞飞去年就用Transformer做出了逼真的视频。但只有OpenAI大力出奇迹,跑在了所有人前面。

威尔·史密斯的这段视频,把全网都骗了!其实Sora的技术路线,早已被人预言了。李飞飞去年就用Transformer做出了逼真的视频。但只有OpenAI大力出奇迹,跑在了所有人前面。

我们接连被谷歌的多模态模型 Gemini 1.5 以及 OpenAI 的视频生成模型 Sora 所震撼到,前者可以处理的上下文窗口达百万级别,而后者生成的视频能够理解运动中的物理世界,被很多人称为「世界模型」。

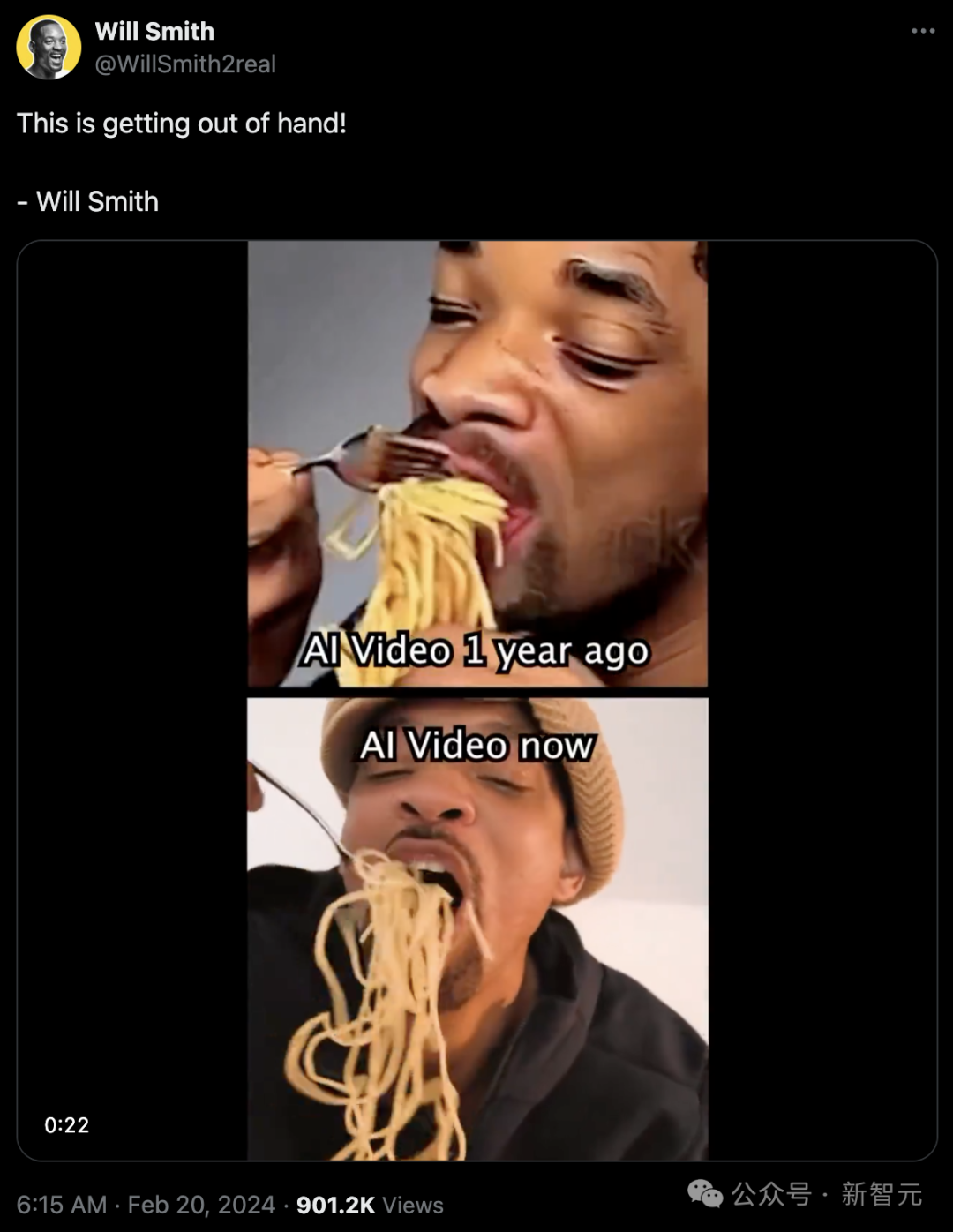

大模型内卷时代,也不断有人跳出来挑战Transformer的统治地位,RWKV最新发布的Eagle 7B模型登顶了多语言基准测试,同时成本降低了数十倍

Sora表现强大的3点关键原因,以及我们作为普通人,应该如何面对新技术带来的冲击?

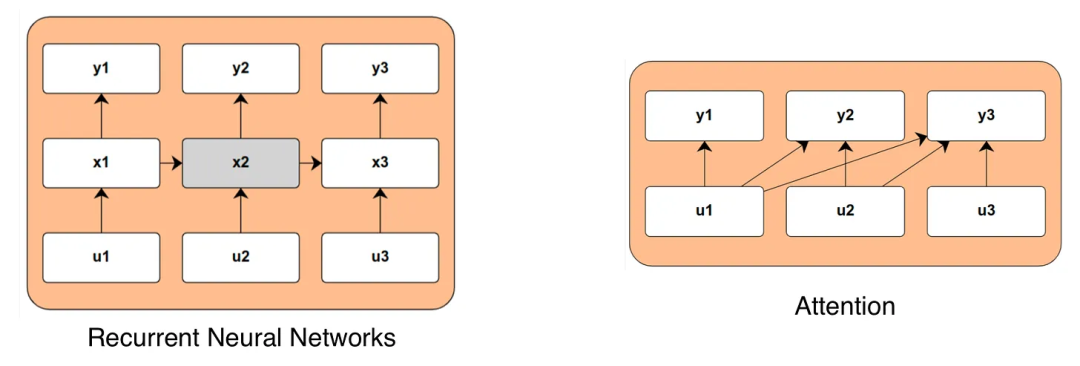

状态空间模型正在兴起,注意力是否已到尽头?

在文本生成音频(或音乐)这个 AIGC 赛道,Meta 最近又有了新研究成果,而且开源了。前几日,在论文《Masked Audio Generation using a Single Non-Autoregressive Transformer》中,Meta FAIR 团队、Kyutai 和希伯来大学推出了 MAGNeT,一种在掩码生成序列建模方法。

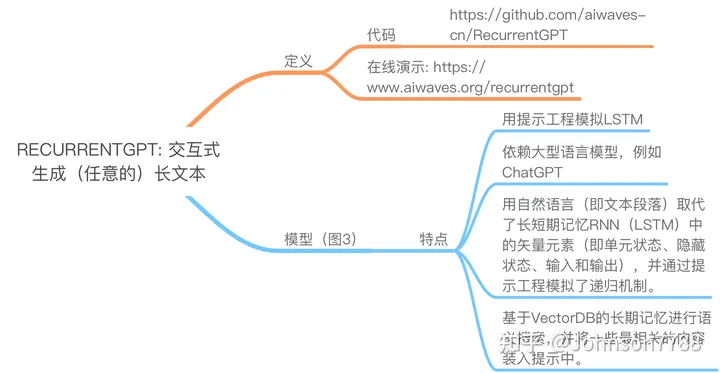

Transformer的固定尺寸上下文使得GPT模型无法生成任意长的文本。在本文中,我们介绍了RECURRENTGPT,一个基于语言的模拟RNN中的递归机制。

在软件工程顶会ESEC/FSE上,来自马萨诸塞大学、谷歌和伊利诺伊大学厄巴纳-香槟分校(UIUC)的研究人员发表了新的成果,使用LLM解决自动化定理证明问题。

加拿大滑铁卢大学的研究人员在《Nature Computational Science》发表题为《Language models for quantum simulation》 的 Perspective 文章,强调了语言模型在构建量子计算机方面所做出的贡献,并讨论了它们在量子优势竞争中的未来角色。

本文介绍了AI大模型元年的到来以及人类文明操作系统的大更新。通过分析Transformer架构的出现和大模型在各个领域的应用,展示了AI对人机交互的改变和智能手机作为新的操作系统的前景。