老黄最新专访:芯片短缺难以结束,下个Transformer已经出现

老黄最新专访:芯片短缺难以结束,下个Transformer已经出现老黄关于未来最新的想法和预测,以及他对于过去很多问题的再思考,还有他的很多日常生活小习惯,都在这篇专访里了。

老黄关于未来最新的想法和预测,以及他对于过去很多问题的再思考,还有他的很多日常生活小习惯,都在这篇专访里了。

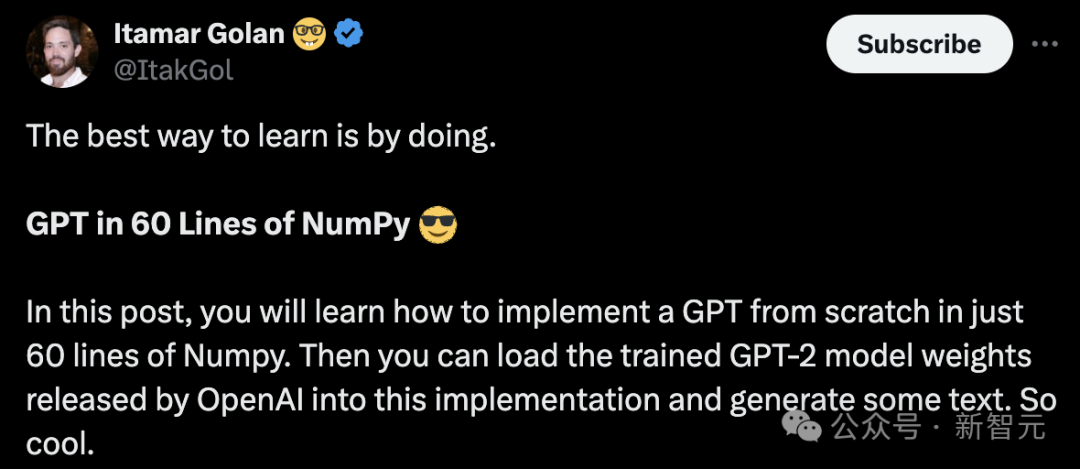

GPT早已成为大模型时代的基础。国外一位开发者发布了一篇实践指南,仅用60行代码构建GPT。

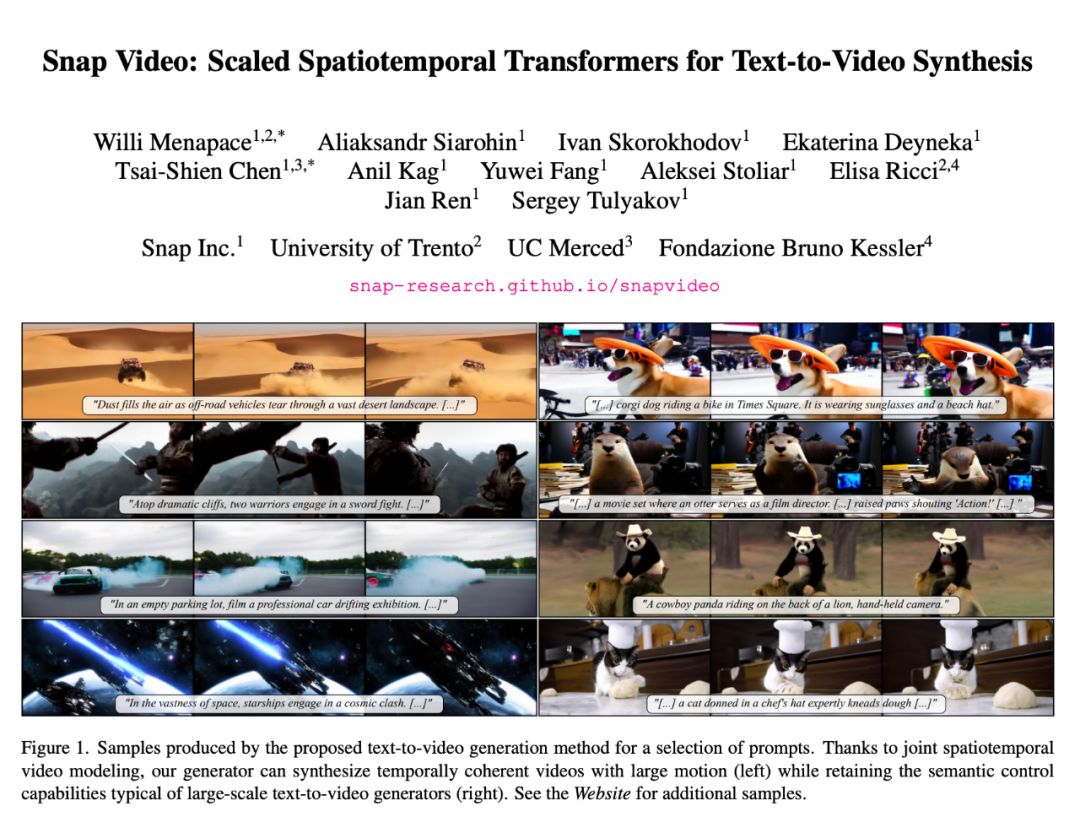

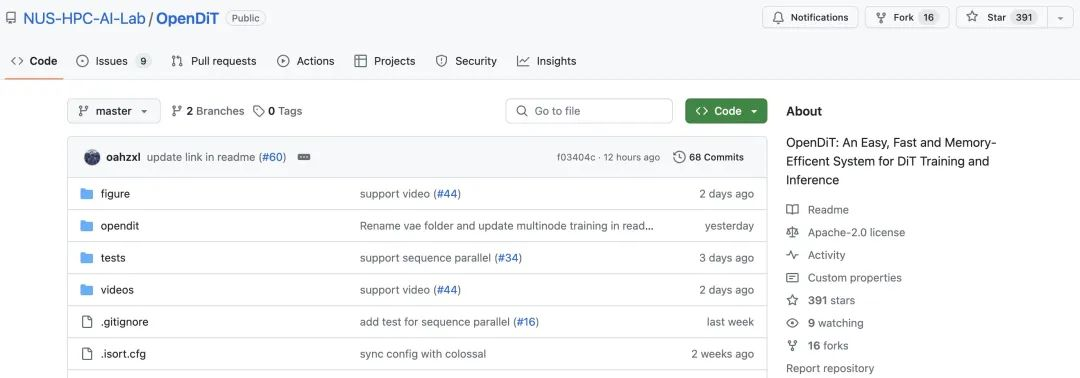

最近,OpenAI 视频生成模型 Sora 的爆火,给基于 Transformer 的扩散模型重新带来了一波热度,比如 Sora 研发负责人之一 William Peebles 与纽约大学助理教授谢赛宁去年提出的 DiT(Diffusion Transformer)。

根据 OpenAI 披露的技术报告,Sora 的核心技术点之一是将视觉数据转化为 patch 的统一表征形式,并通过 Transformer 和扩散模型结合,展现了卓越的扩展(scale)特性。

近期,DiT(Diffusion Transformer)论文的作者谢赛宁在朋友圈分享了他对 Sora 的看法,其中核心资源的排序是——人才第一、数据第二、算力第三,其他都没有什么是不可替代的。

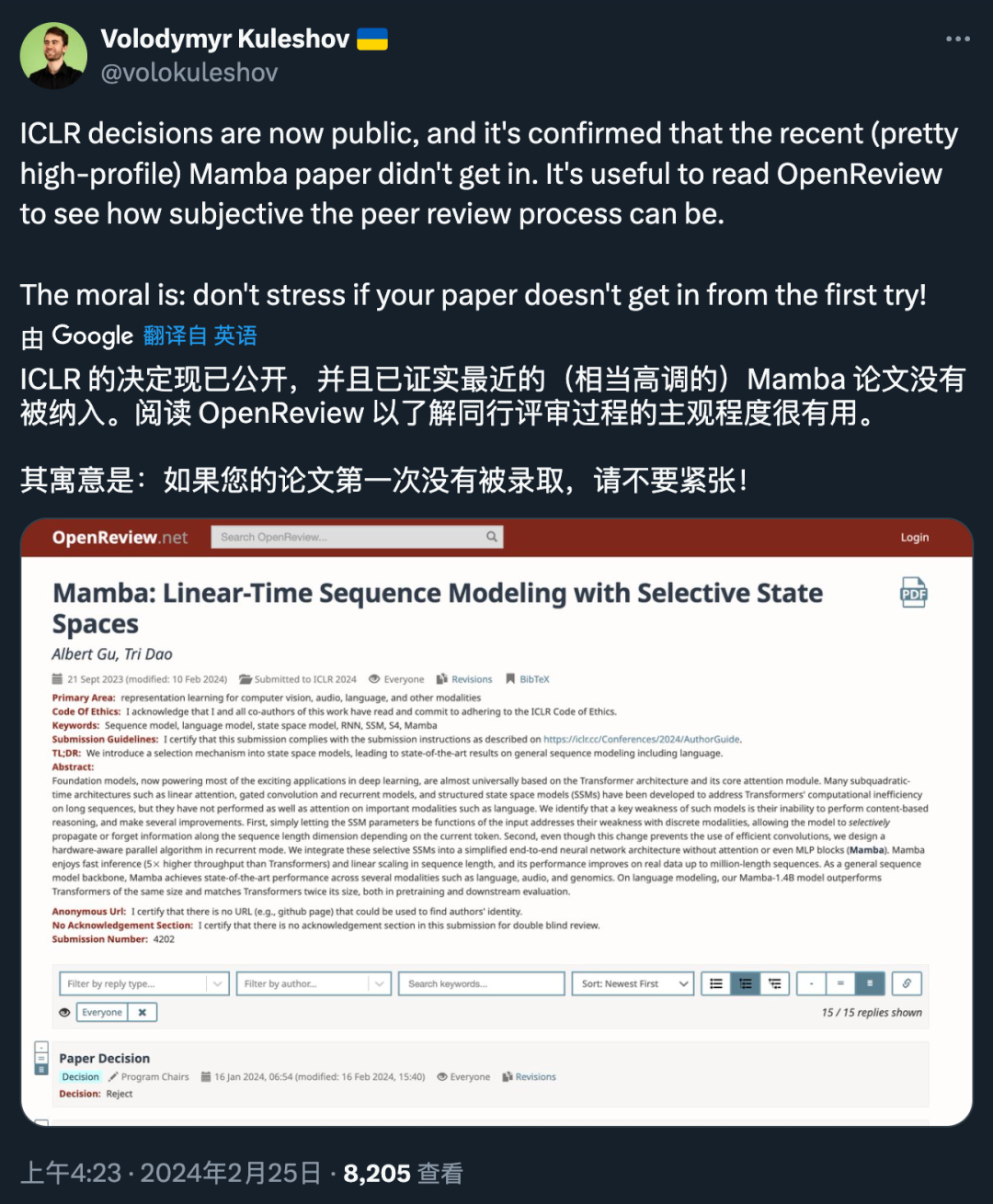

几天前,ICLR 2024 的最终接收结果出来了。

2 月 16 日,OpenAI Sora 的发布无疑标志着视频生成领域的一次重大突破。Sora 基于 Diffusion Transformer 架构,和市面上大部分主流方法(由 2D Stable Diffusion 扩展)并不相同。

最近几年,基于 Transformer 的架构在多种任务上都表现卓越,吸引了世界的瞩目。使用这类架构搭配大量数据,得到的大型语言模型(LLM)等模型可以很好地泛化用于真实世界用例。

谷歌Research Lead,负责VideoPoet项目的蒋路,即将加入TikTok,负责视频生成AI的开发。

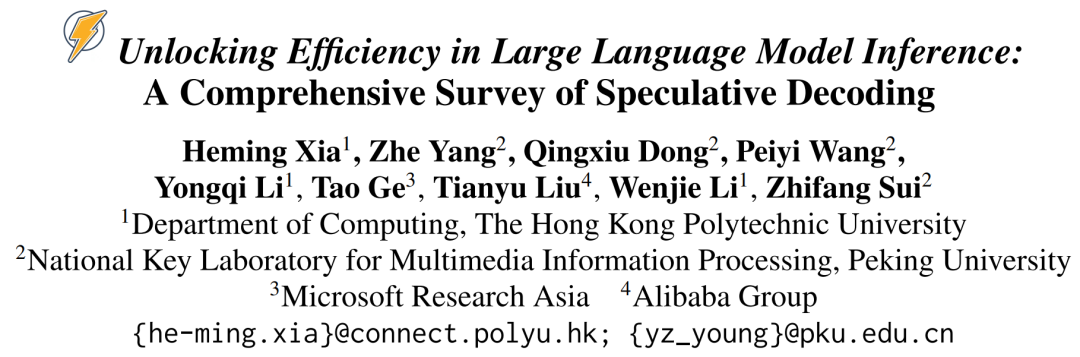

推测解码(Speculative Decoding)是谷歌等机构在 2022 年发现的大模型推理加速方法。它可以在不损失生成效果前提下,获得 3 倍以上的加速比。GPT-4 泄密报告也提到 OpenAI 线上模型推理使用了它。