混元单日调用tokens达千亿后,腾讯大模型战略露出全貌

混元单日调用tokens达千亿后,腾讯大模型战略露出全貌大模型之争,到了不只是拼技术的时刻。

大模型之争,到了不只是拼技术的时刻。

只需Image Tokenizer,Llama也能做图像生成了,而且效果超过了扩散模型。

该来的还是来了。

今天凌晨,OpenAI 突然宣布终止对中国提供 API 服务,进一步收紧国内开发者访问 GPT 等高水平大模型。国内开发者真是太难了。

在人工智能领域的发展过程中,对大语言模型(LLM)的控制与指导始终是核心挑战之一,旨在确保这些模型既强大又安全地服务于人类社会。早期的努力集中于通过人类反馈的强化学习方法(RLHF)来管理这些模型,成效显著,标志着向更加人性化 AI 迈出的关键一步。

在生成式模型的迅速发展中,Image Tokenization 扮演着一个很重要的角色,例如Diffusion依赖的VAE或者是Transformer依赖的VQGAN。这些Tokenizers会将图像编码至一个更为紧凑的隐空间(latent space),使得生成高分辨率图像更有效率。

当前主流的视觉语言模型(VLM)主要基于大语言模型(LLM)进一步微调。因此需要通过各种方式将图像映射到 LLM 的嵌入空间,然后使用自回归方式根据图像 token 预测答案。

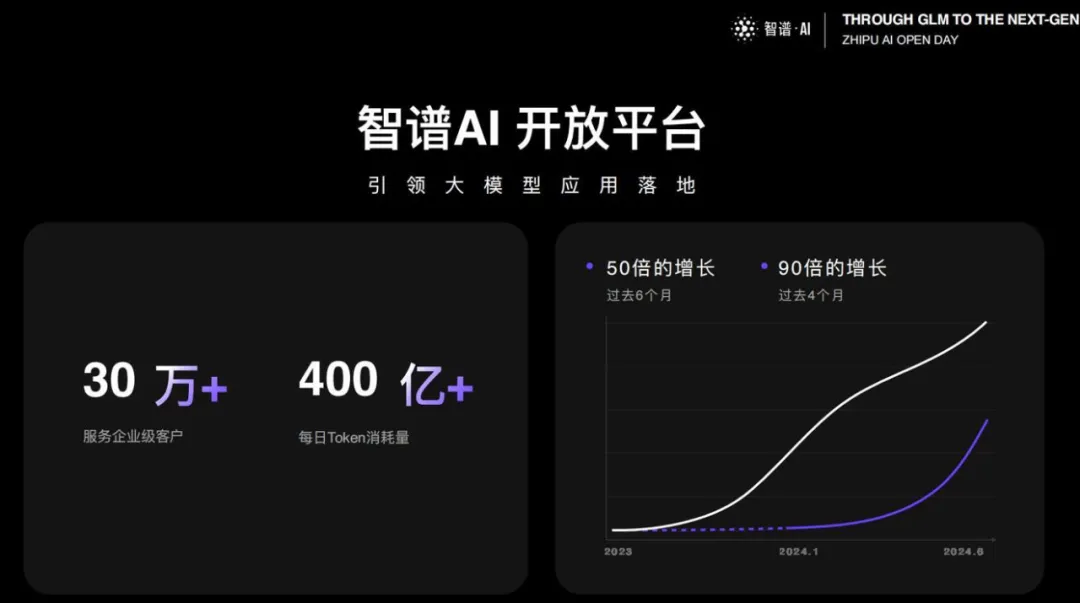

大模型价格战,这匹国产黑马又破纪录了!最低的GLM-4 Flash版本,百万token价格已经低至0.1元,可以说是击穿地心。MaaS 2.0大升级,让企业训练私有模型的成本无限降低。

最新版本大模型,6 分钱 100 万 Token。

研究人员提出了一种新的大型语言模型训练方法,通过一次性预测多个未来tokens来提高样本效率和模型性能,在代码和自然语言生成任务上均表现出显著优势,且不会增加训练时间,推理速度还能提升至三倍。