嚯!大语言扩散模型来了,何必只预测下一个token | 人大高瓴&蚂蚁

嚯!大语言扩散模型来了,何必只预测下一个token | 人大高瓴&蚂蚁用扩散模型替代自回归,大模型的逆诅咒有解了!

用扩散模型替代自回归,大模型的逆诅咒有解了!

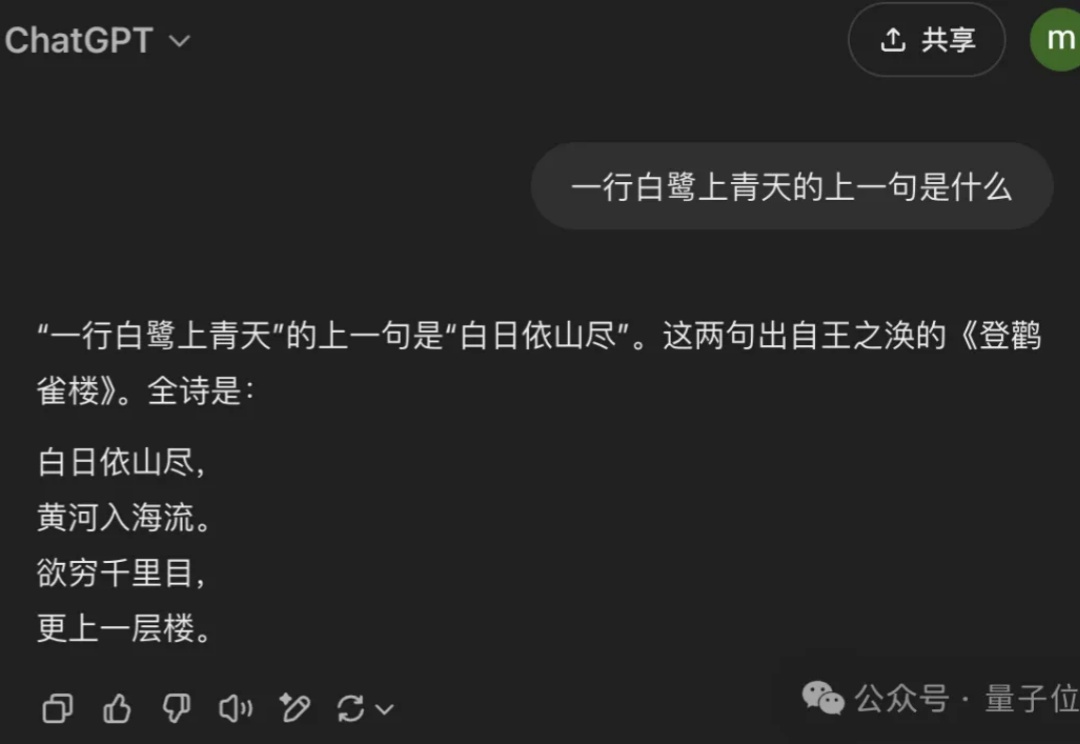

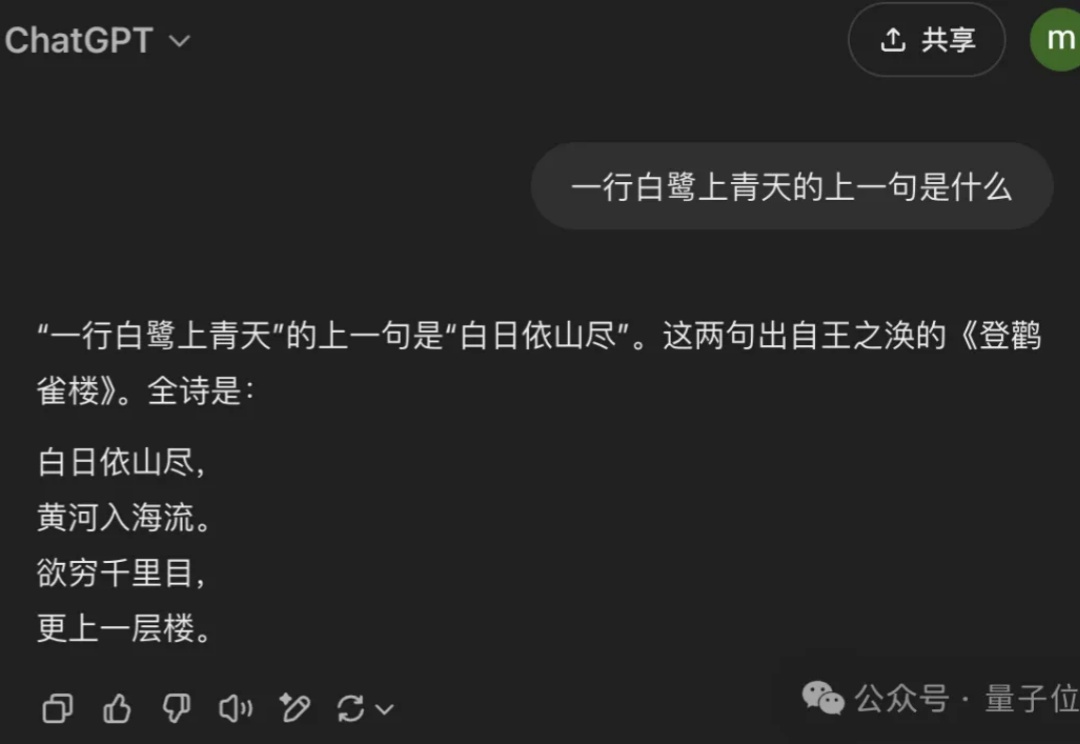

近年来,大语言模型(LLMs)取得了突破性进展,展现了诸如上下文学习、指令遵循、推理和多轮对话等能力。目前,普遍的观点认为其成功依赖于自回归模型的「next token prediction」范式。

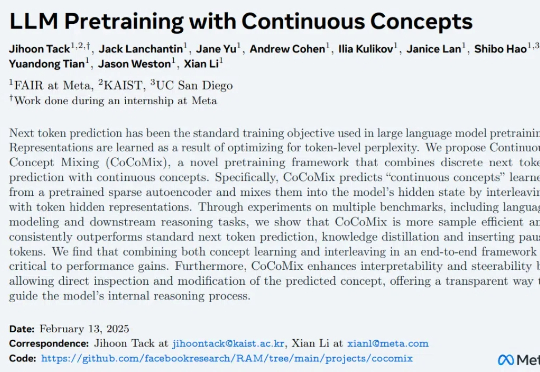

自然语言 token 代表的意思通常是表层的(例如 the 或 a 这样的功能性词汇),需要模型进行大量训练才能获得高级推理和对概念的理解能力,

一个简单的笑脸😀可能远不止这么简单?最近,AI大神Karpathy发现,一个😀竟然占用了多达53个token!这背后隐藏着Unicode编码的哪些秘密?如何利用这些「隐形字符」在文本中嵌入、传递甚至「隐藏」任意数据。更有趣的是,这种「数据隐藏术」甚至能对AI模型进行「提示注入」!

还在为 DeepSeek R1 官网的卡顿抓狂?无问芯穹大模型服务平台现已上线满血版 DeepSeek-R1、V3,无需邀请即可免费用 Token!另有异构算力鼎力相助,支持通过 Infini-AI 异构云平台一键获取 DeepSeek 系列模型与多元异构自主算力服务。

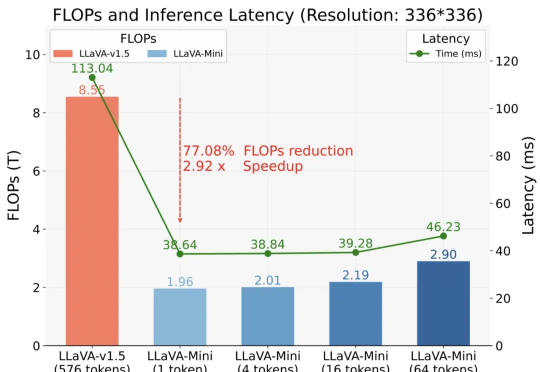

以 GPT-4o 为代表的实时交互多模态大模型(LMMs)引发了研究者对高效 LMM 的广泛关注。现有主流模型通过将视觉输入转化为大量视觉 tokens,并将其嵌入大语言模型(LLM)上下文来实现视觉信息理解。

国产大模型云服务平台SiliconCloud(硅基流动),首发上线了基于华为云昇腾云服务的DeepSeek-V3、DeepSeek-R1。 DeepSeek-V3:输入只需1块钱/M tokens,输出2块钱/M tokens

眼看DeepSeek风头尽显,被逼急的OpenAI果然紧急发布了o3-mni。不光免费用户都能用,每百万输入和输出token价格更是疯狂跳水打骨折价!

VARGPT是一种新型多模态大模型,能够在单一框架内实现视觉理解和生成任务。通过预测下一个token完成视觉理解,预测下一个scale完成视觉生成,展现出强大的混合模态输入输出能力。

谈到大模型的“国货之光”,除了DeepSeek之外,阿里云Qwen这边也有新动作——首次将开源Qwen模型的上下文扩展到1M长度。