DeepSeek前实习生魔改MoE,用迭代机制把内存需求砍了42%,团队:“免费午餐”优化方法

DeepSeek前实习生魔改MoE,用迭代机制把内存需求砍了42%,团队:“免费午餐”优化方法DeepSeek MoE“变体”来了,200美元以内,内存需求减少17.6-42%! 名叫CoE(Chain-of-Experts),被认为是一种“免费午餐”优化方法,突破了MoE并行独立处理token、整体参数数量较大需要大量内存资源的局限。

DeepSeek MoE“变体”来了,200美元以内,内存需求减少17.6-42%! 名叫CoE(Chain-of-Experts),被认为是一种“免费午餐”优化方法,突破了MoE并行独立处理token、整体参数数量较大需要大量内存资源的局限。

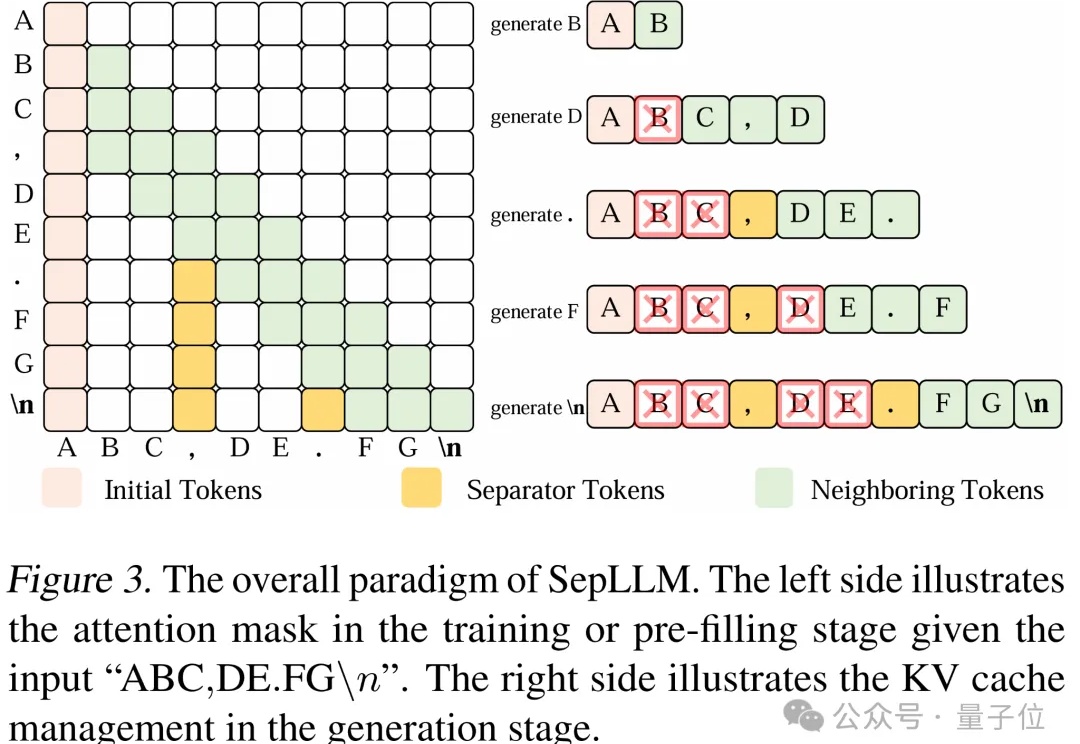

文字中貌似不起眼的标点符号,竟然可以显著加速大模型的训练和推理过程?

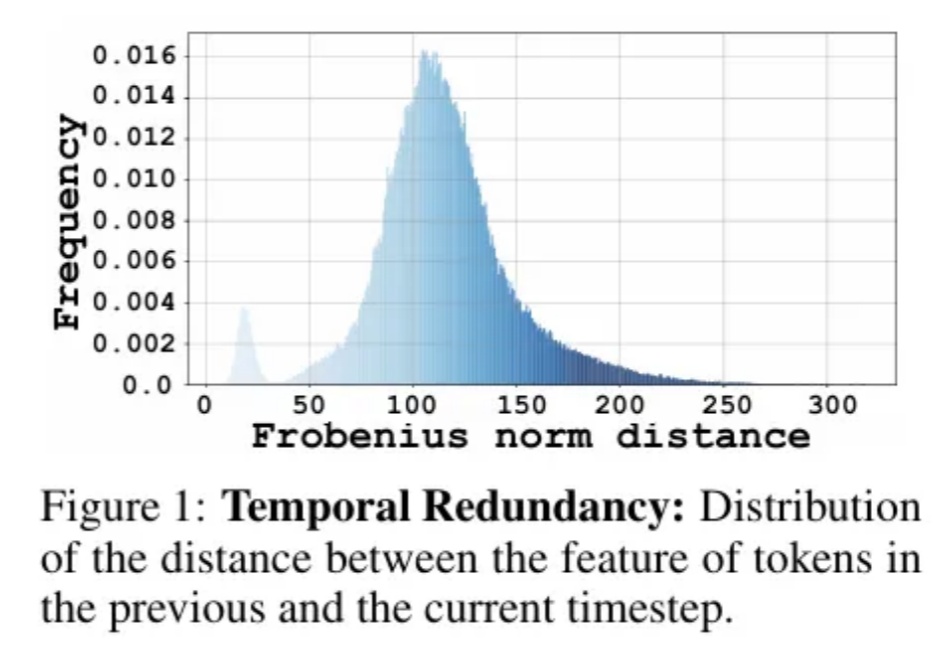

Diffusion Transformer模型模型通过token粒度的缓存方法,实现了图像和视频生成模型上无需训练的两倍以上的加速。

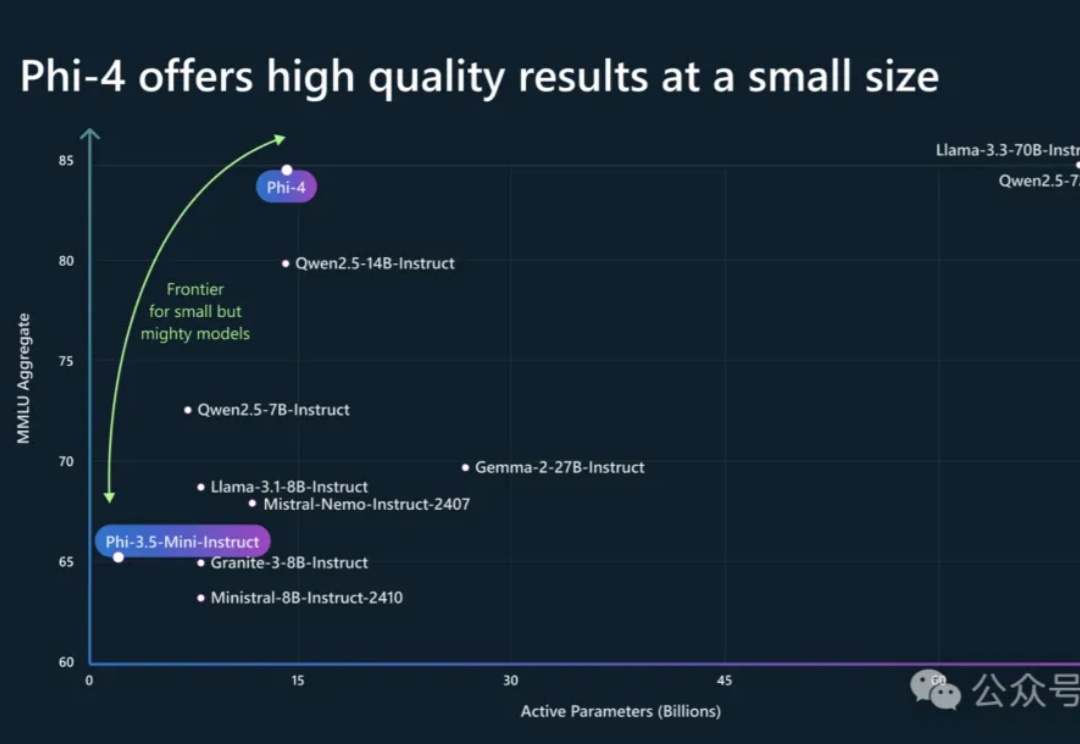

Phi-4系列模型上新了!56亿参数Phi-4-multimodal集语音、视觉、文本多模态于一体,读图推理性能碾压GPT-4o;另一款38亿参数Phi-4-mini在推理、数学、编程等任务中超越了参数更大的LLM,支持128K token上下文。

OpenAI的重磅炸弹GPT-4.5,刚刚如期上线了!它并不是推理模型,但是规模最大、知识最丰富,最鲜明的特点就是情商高、很类人。Pro版用户和付费开发者已经能用了,但token定价有点离谱。

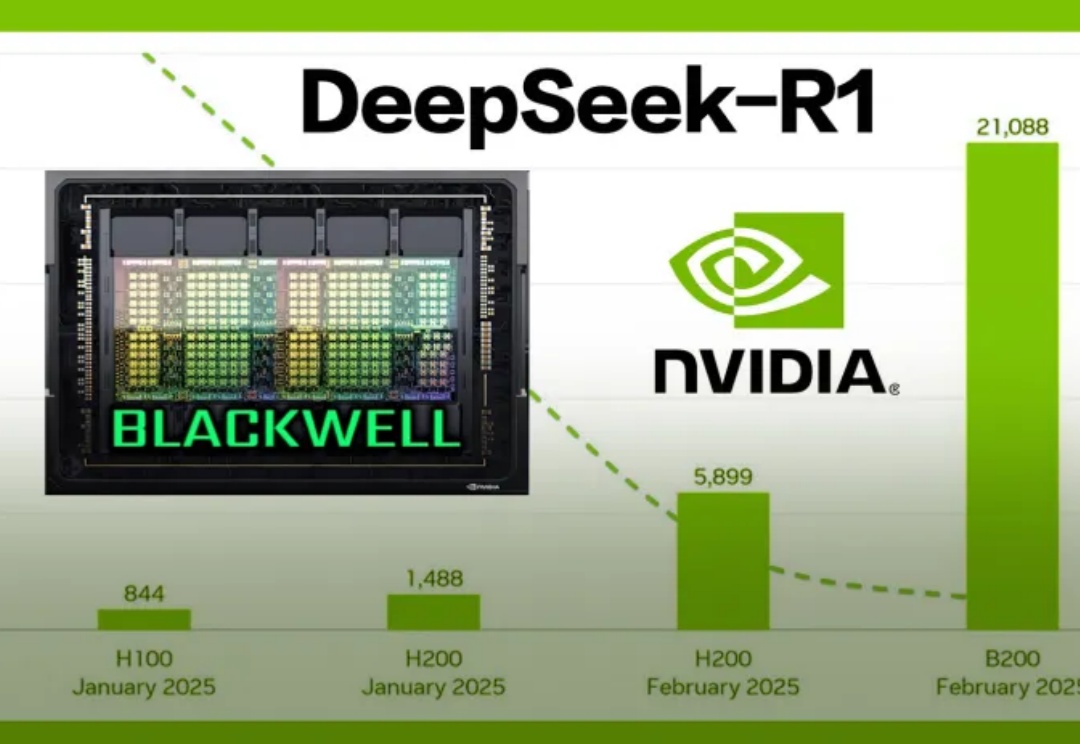

最近,英伟达开源了首个在Blackwell架构上优化的DeepSeek-R1,实现了推理速度提升25倍,和每token成本降低20倍的惊人成果。同时,DeepSeek连续开源多个英伟达GPU优化项目,共同探索模型性能极限。

谷歌首席科学家Jeff Dean与Transformer作者Noam Shazeer在一场访谈中不仅揭秘了让模型速度提升三倍的低精度计算技术,分享了「猫神经元」等早期AI突破的背后故事,还大胆畅想了AI处理万亿级别Token、实现「1000万倍工程师」的可能性。

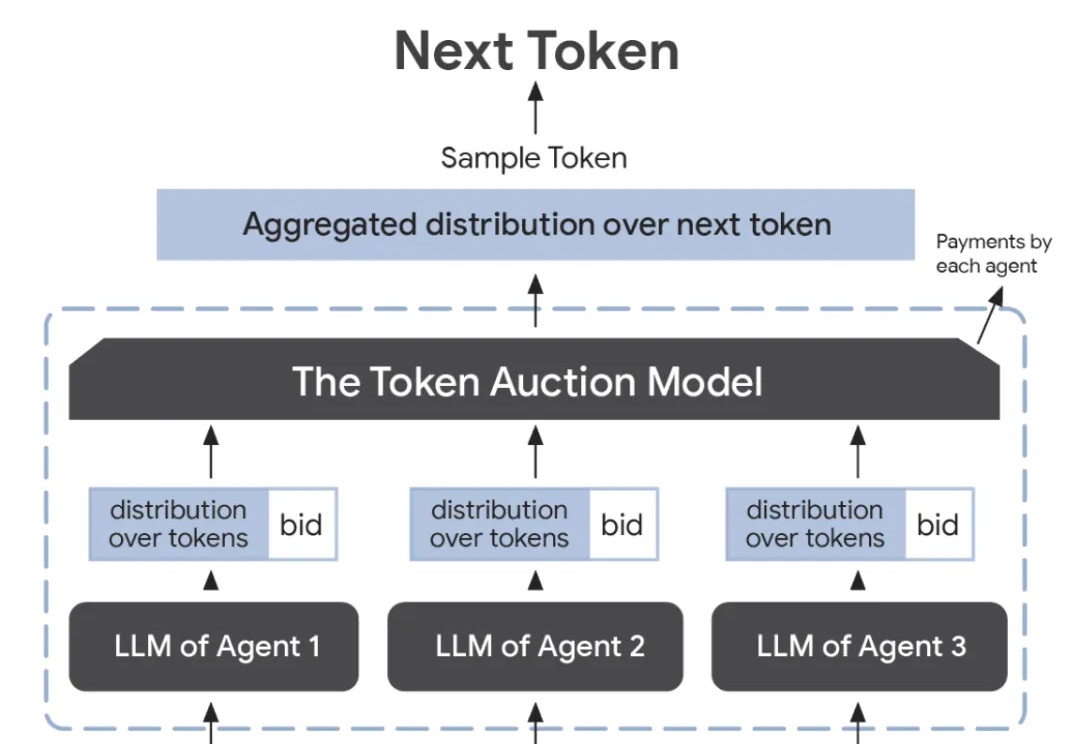

谷歌研究人员提出了一种创新的token拍卖模型,通过「竞拍」的方式,让智能体在文本生成过程中进行出价,确保最终输出能满足各方利益,实现最佳效果。这一机制优化了广告、内容创作等领域的协作。

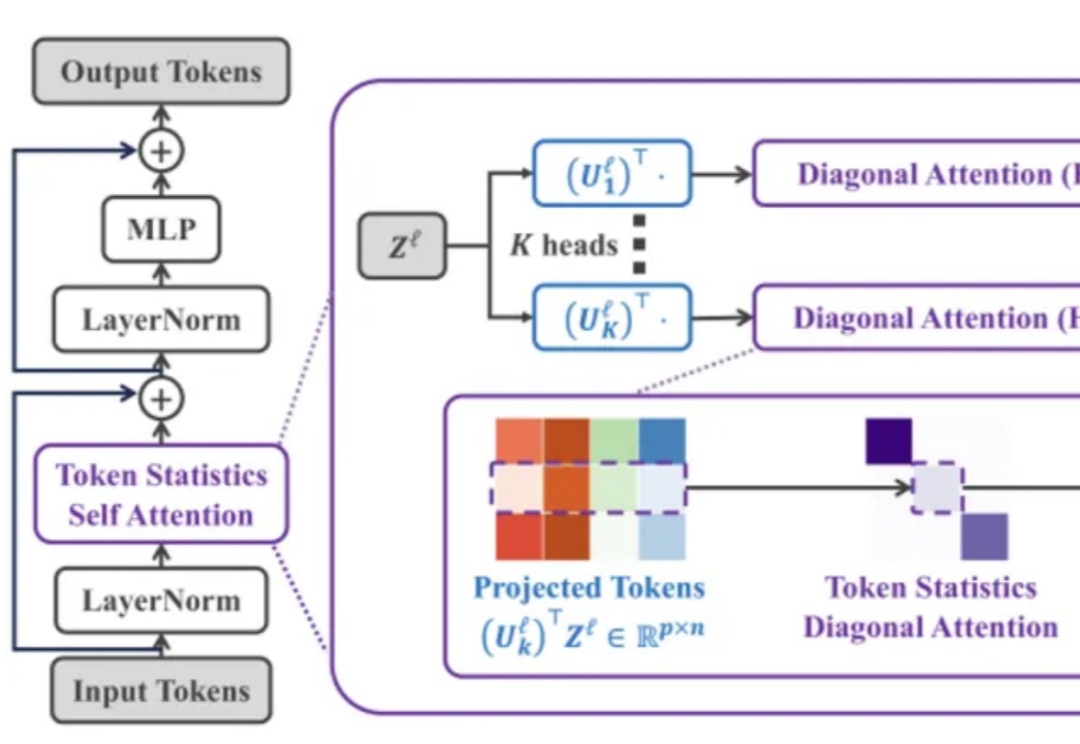

Transformer 架构在过去几年中通过注意力机制在多个领域(如计算机视觉、自然语言处理和长序列任务)中取得了非凡的成就。然而,其核心组件「自注意力机制」 的计算复杂度随输入 token 数量呈二次方增长,导致资源消耗巨大,难以扩展到更长的序列或更大的模型。

RedStone是一个高效构建大规模指定领域数据的处理管道,通过优化数据处理流程,从Common Crawl中提取了RedStone-Web、RedStone-Code、RedStone-Math和RedStone-QA等数据集,在多项任务中超越了现有开源数据集,显著提升了模型性能。