翁荔最新万字长文:Why We Think

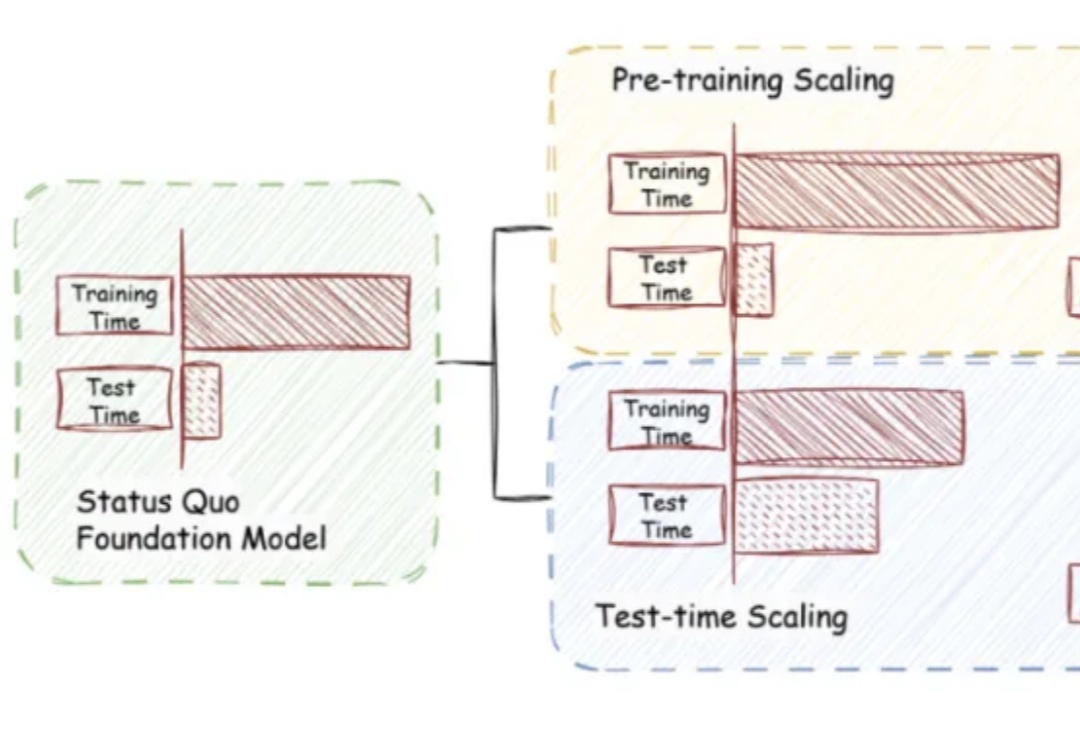

翁荔最新万字长文:Why We Think《Why We Think》。 这就是北大校友、前OpenAI华人VP翁荔所发布的最新万字长文—— 围绕“测试时计算”(Test-time Compute)和“思维链”(Chain-of-Thought,CoT),讨论了如何通过这些技术显著提升模型性能。

《Why We Think》。 这就是北大校友、前OpenAI华人VP翁荔所发布的最新万字长文—— 围绕“测试时计算”(Test-time Compute)和“思维链”(Chain-of-Thought,CoT),讨论了如何通过这些技术显著提升模型性能。

近日,腾讯 PCG 社交线的研究团队针对这一问题,采用强化学习(RL)训练方法,通过分组相对策略优化(Group Relative Policy Optimization, GRPO)算法,结合基于奖励的课程采样策略(Reward-based Curriculum Sampling, RCS),将其创新性地应用在意图识别任务上,

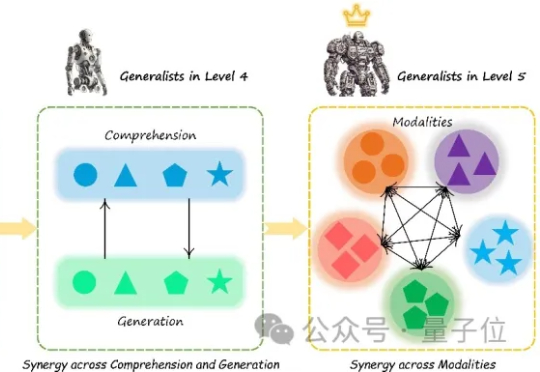

多模态大模型(Multimodal Large Language Models, MLLM)正迅速崛起,从只能理解单一模态,到如今可以同时理解和生成图像、文本、音频甚至视频等多种模态。正因如此,在AI竞赛进入“下半场”之际(由最近的OpenAI研究员姚顺雨所引发的共识观点),设计科学的评估机制俨然成为决定胜负的核心关键。

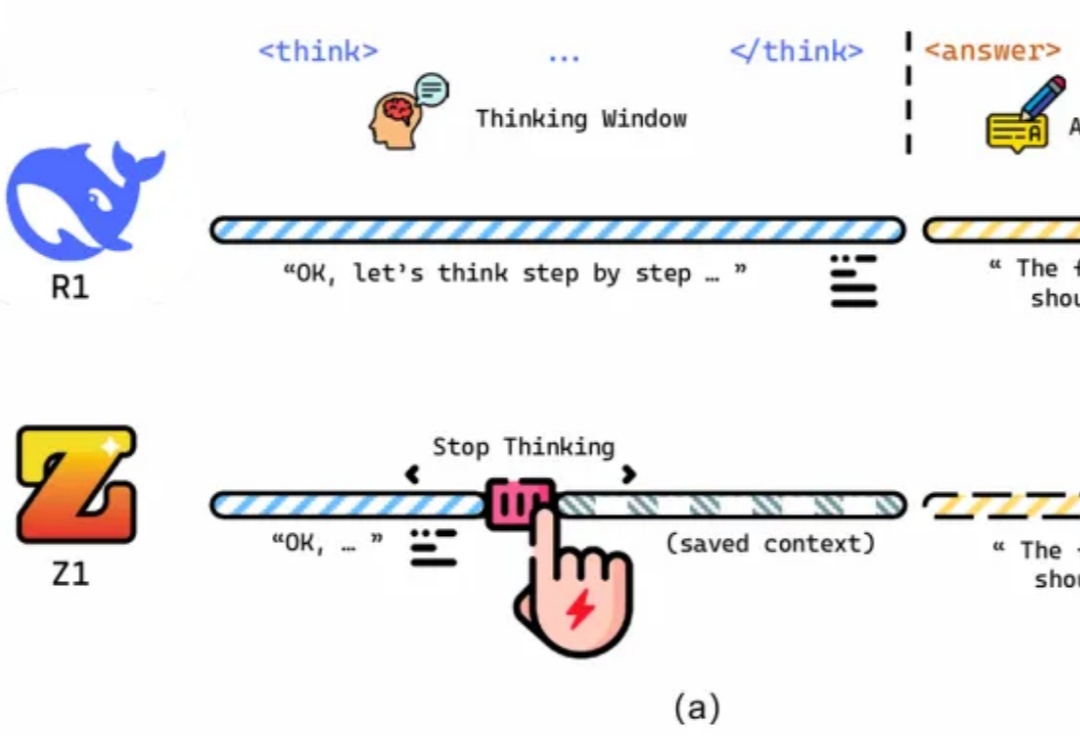

当训练成本飙升、数据枯竭,如何继续激发大模型潜能?

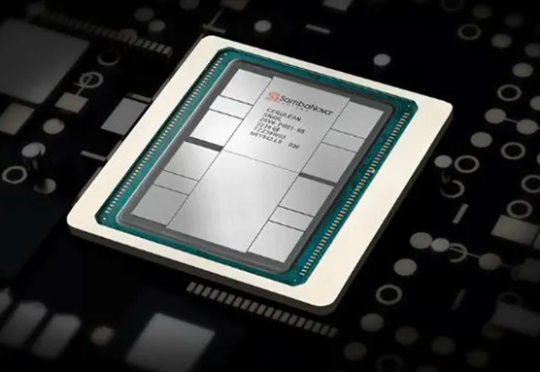

据EETimes报道,美国AI芯片独角兽SambaNova Systems近期宣布将裁员77人,约占其500名员工的15%。此次裁员正值该公司偏离最初目标,放弃做AI训练,转向完全专注于AI推理。

从吸尘器到Optimus:机器人60年间的惊人变化。

2025年4月17日,圣马特奥,加利福尼亚 —— 数据编排和存储平台领导者Hammerspace宣布完成1亿美元B轮融资,由Altimeter Capital领投,ARK Invest等新老投资者共同参与,公司估值超过5亿美元。这笔融资将加速Hammerspace在全球市场的扩张,巩固其在人工智能(AI)驱动的数据基础设施领域的领先地位,助力企业应对由AI引发的“大数据重心转移”趋势。

大模型聚合平台OpenRouter新推出的Optimus Alpha,已经处理了772亿Token,平均每天超过200亿。并且这个数字还在上升,日Token处理已超过340亿,排名第二,并在Trending榜单上位列第一。

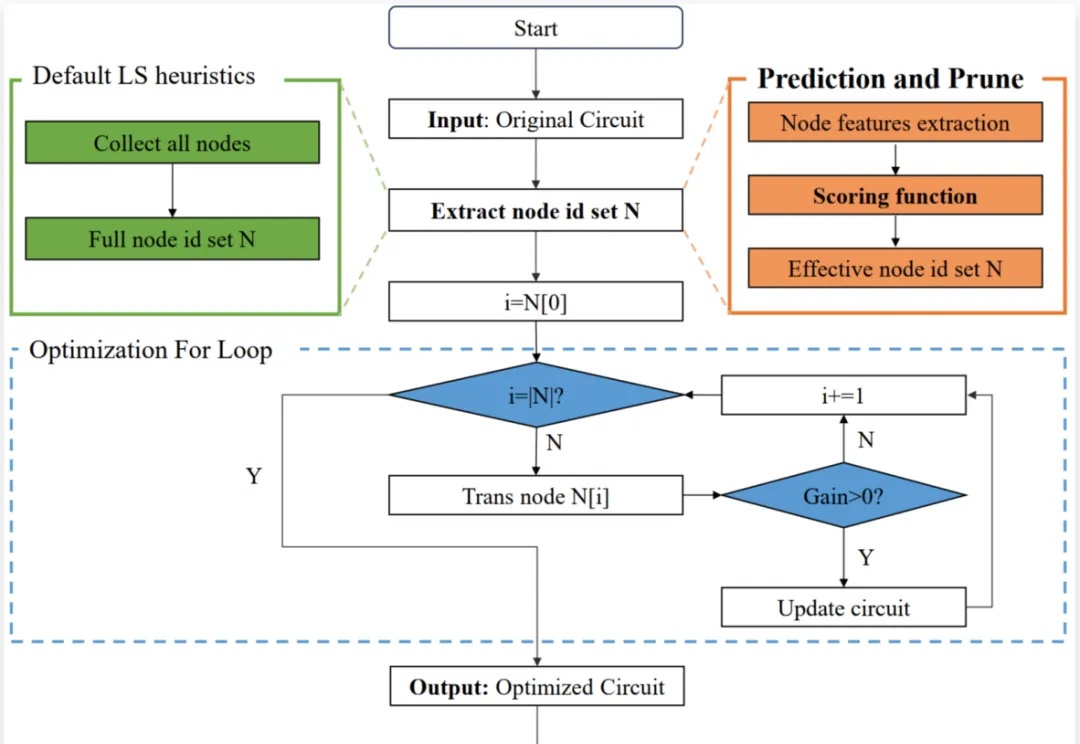

芯片设计是现代科技的核心,逻辑优化(Logic Optimization, LO)作为芯片设计流程中的关键环节,其效率直接影响着芯片设计的整体性能。

推理性能提升的同时,还大大减少Token消耗!