不愧是中国机器人,乒乓打得太6了

不愧是中国机器人,乒乓打得太6了这位乒乓球场上的机器人高手,出自清华姚班本科生苏智(师从吴翼教授)的最新论文——《HITTER: A HumanoId Table TEnnis Robot via Hierarchical Planning and Learning》。

这位乒乓球场上的机器人高手,出自清华姚班本科生苏智(师从吴翼教授)的最新论文——《HITTER: A HumanoId Table TEnnis Robot via Hierarchical Planning and Learning》。

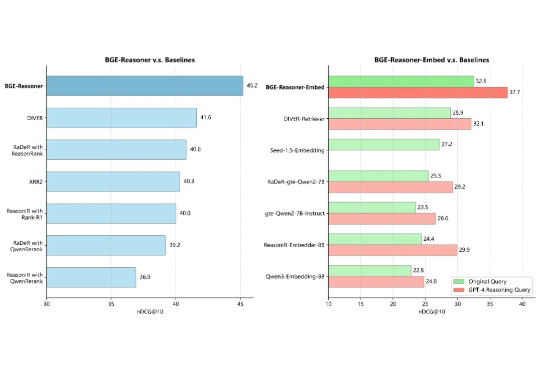

人工智能的浪潮正将我们推向一个由 RAG 和 AI Agent 定义的新时代。然而,要让这些智能体真正「智能」,而非仅仅是信息的搬运工,就必须攻克一个横亘在所有顶尖团队面前的核心难题。这个难题,就是推理密集型信息检索(Reasoning-Intensive IR)。

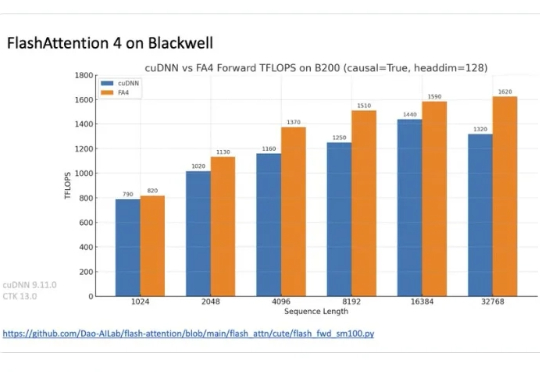

在正在举办的半导体行业会议 Hot Chips 2025 上,TogetherAI 首席科学家 Tri Dao 公布了 FlashAttention-4。

刚刚,AI界传奇Jeff Dean深度访谈重磅放出!作为谷歌大脑奠基人、TensorFlow与TPU背后的关键推手,他亲述了这场神经网络革命的非凡历程。

美国每年有超三分之一患者需跨机构转诊,但复杂行政流程导致转诊完成率不足一半。Tennr以AI为底座切入这一高摩擦、高错误率的关键节点,重构信息交互与操作流程,为医疗机构与患者带来更高效、更可控的转诊体验。

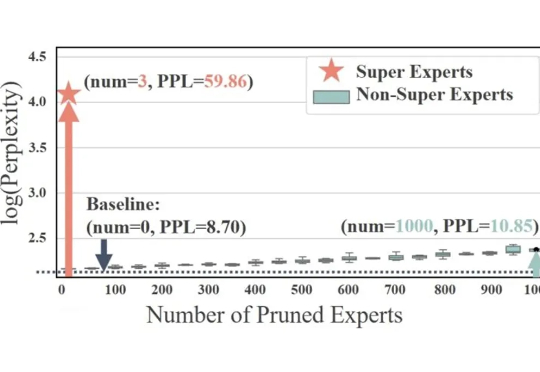

稀疏激活的混合专家模型(MoE)通过动态路由和稀疏激活机制,极大提升了大语言模型(LLM)的学习能力,展现出显著的潜力。基于这一架构,涌现出了如 DeepSeek、Qwen 等先进的 MoE LLM。

AutoGame 创始人张昊阳从腾讯制作人转型为 AI 沙盒游戏创业者,其团队打造的 AI 游戏《麦琪的花园》以零推广在 Steam 首发登上新品榜 Top50,并在一个月内积累超过 5000 愿望单。它让普通人也能“一句话生成 NPC、任务与副本”,通过 AI 驱动的 UGC 系统,让内容创作从金字塔走向“十字型”,成为 Z 世代表达与社交的新方式。

FlowSpeech的开发初衷源于一个感人故事。一位年过八旬的美国老人因长期病痛失去说话能力,但通过AI工具ListenHub继续与他人分享自己的人生经历。这个真实案例启发了开发团队,促使他们研发出专门针对书面语向口语转换的TTS技术解决方案。

AI大模型浪潮汹涌澎湃,00后创业者正一步步走上创业舞台,成为这场技术革新的主心骨。身处这股技术新浪潮之中的Celine和Kejin,两个刚走出校园里的年轻人瞄准的是AI教育。

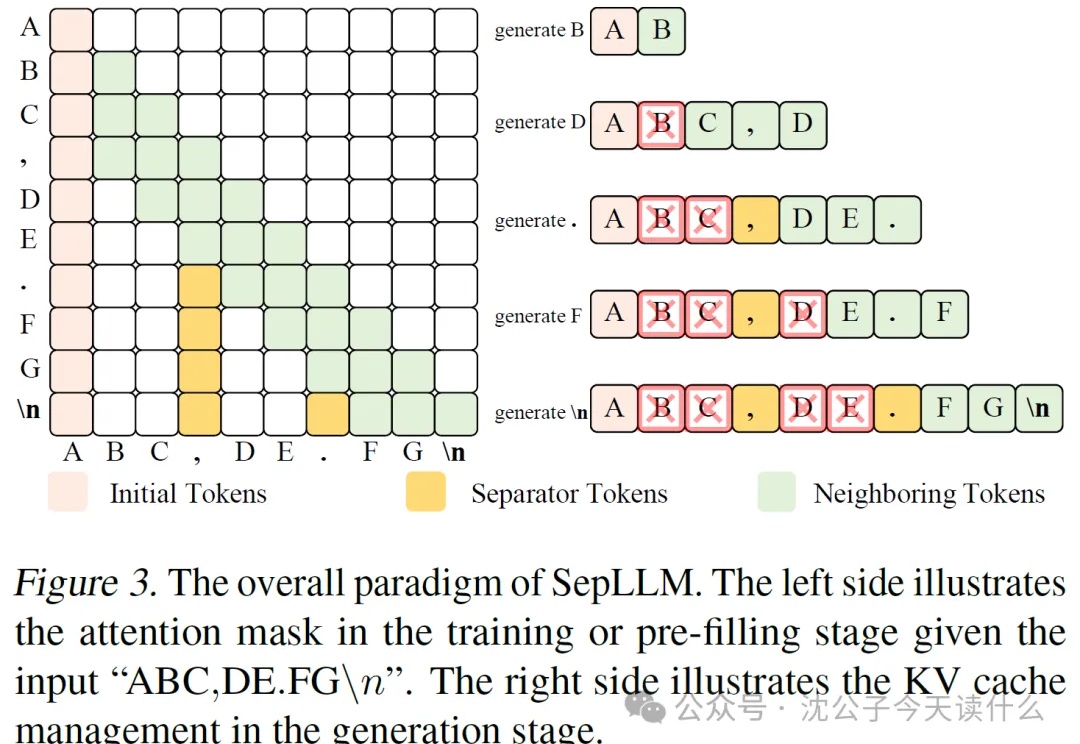

近年来,大语言模型(LLM)的能力越来越强,但它们的“饭量”也越来越大。这个“饭量”主要体现在计算和内存上。当模型处理的文本越来越长时,一个叫做“自注意力(Self-Attention)”的核心机制会导致计算量呈平方级增长。这就像一个房间里的人开会,如果每个人都要和在场的其他所有人单独聊一遍,那么随着人数增加,总的对话次数会爆炸式增长。