RLHF已死,RLVR引爆AGI革命!Claude 4核心成员万字对谈

RLHF已死,RLVR引爆AGI革命!Claude 4核心成员万字对谈AI顶流Claude升级了,程序员看了都沉默:不仅能写代码能力更强了,还能连续干活7小时不出大差错!AGI真要来了?这背后到底发生了什么?现在,还有机会加入AI行业吗?如今做哪些准备,才能在未来立足?

AI顶流Claude升级了,程序员看了都沉默:不仅能写代码能力更强了,还能连续干活7小时不出大差错!AGI真要来了?这背后到底发生了什么?现在,还有机会加入AI行业吗?如今做哪些准备,才能在未来立足?

惊艳全球的Claude 4,但它到底是如何思考?来自Anthropic两位研究员最新一期博客采访,透露了很多细节。这两天大家可以说是试玩了不少,有人仅用一个提示就搞定了个浏览器Agent,包括API和前端……直接一整个大震惊,与此同时关于Claude 4可能有意识并试图干坏事的事情同样被爆出。

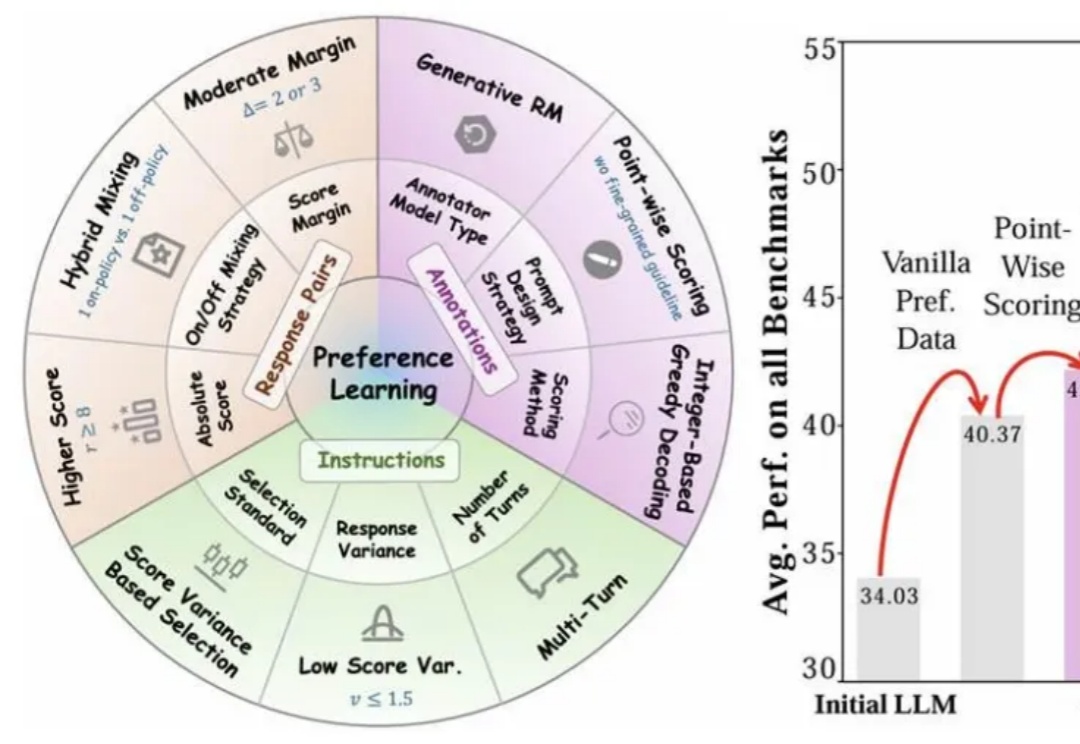

近年来,大语言模型(LLMs)的对齐研究成为人工智能领域的核心挑战之一,而偏好数据集的质量直接决定了对齐的效果。无论是通过人类反馈的强化学习(RLHF),还是基于「RL-Free」的各类直接偏好优化方法(例如 DPO),都离不开高质量偏好数据集的构建。

训练狗时不仅要让它知对错,还要给予差异较大的、不同的奖励诱导,设计 RLHF 的奖励模型时也是一样。

回顾 AGI 的爆发,从最初的 pre-training (model/data) scaling,到 post-training (SFT/RLHF) scaling,再到 reasoning (RL) scaling,找到正确的 scaling 维度始终是问题的本质。

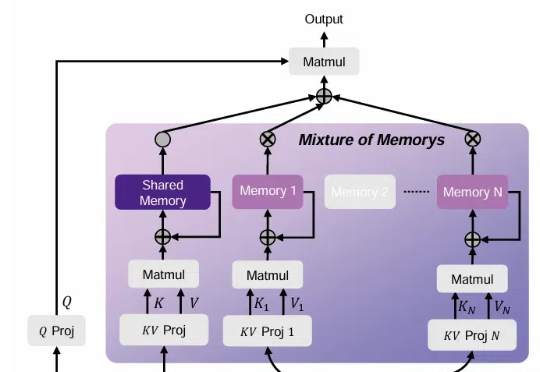

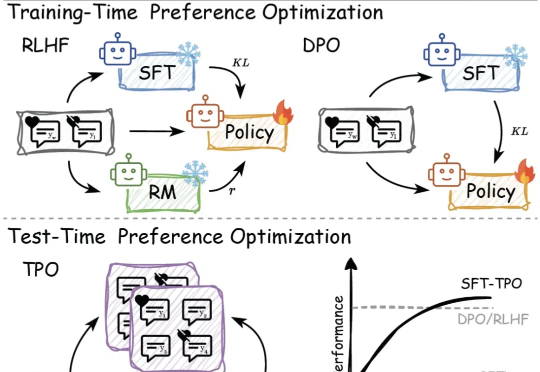

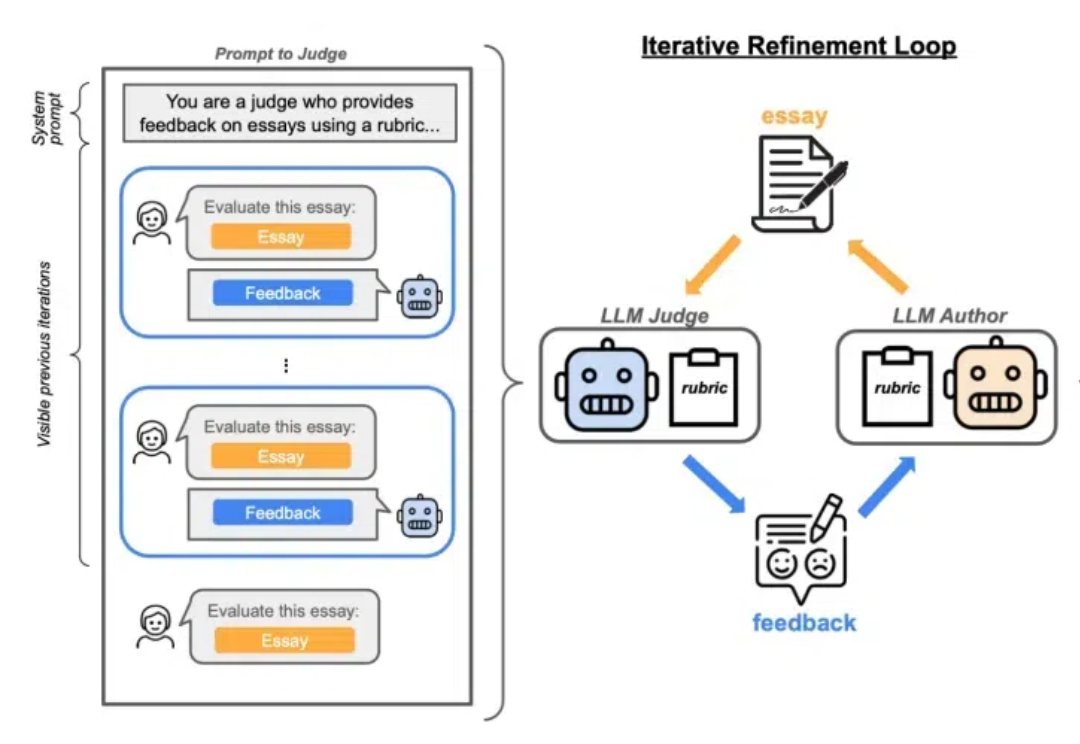

传统的偏好对⻬⽅法,如基于⼈类反馈的强化学习(RLHF)和直接偏好优化(DPO),依赖于训练过程中的模型参数更新,但在⾯对不断变化的数据和需求时,缺乏⾜够的灵活性来适应这些变化。

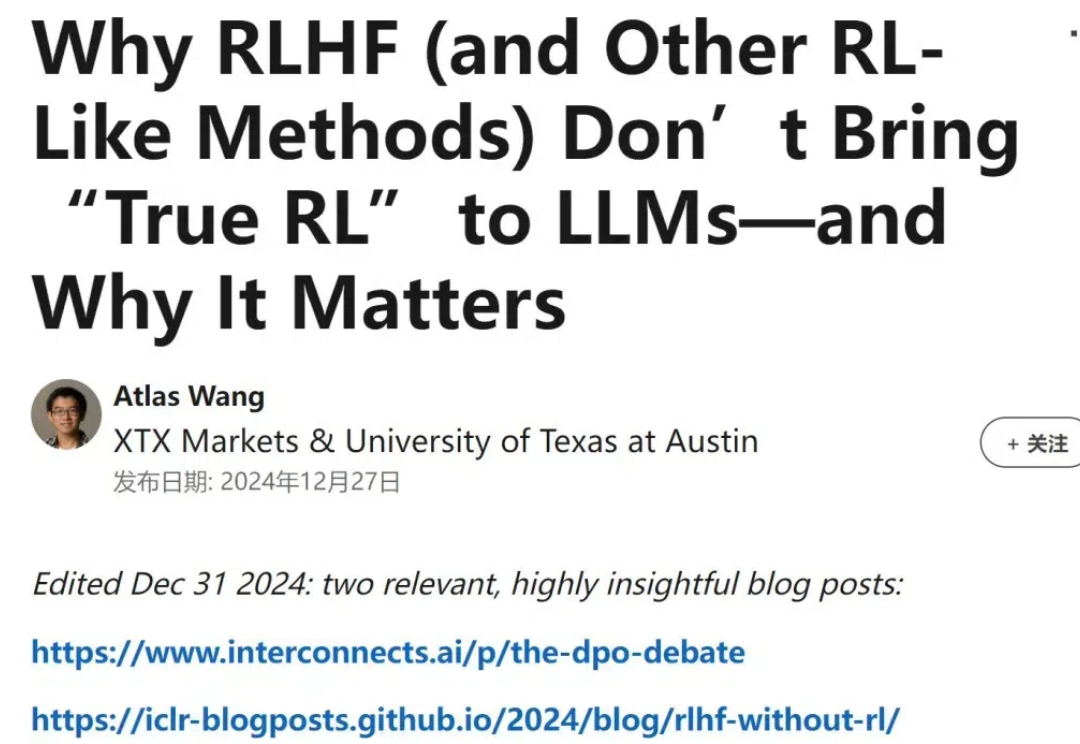

老婆饼里没有老婆,夫妻肺片里没有夫妻,RLHF 里也没有真正的 RL。在最近的一篇博客中,德克萨斯大学奥斯汀分校助理教授 Atlas Wang 分享了这样一个观点。

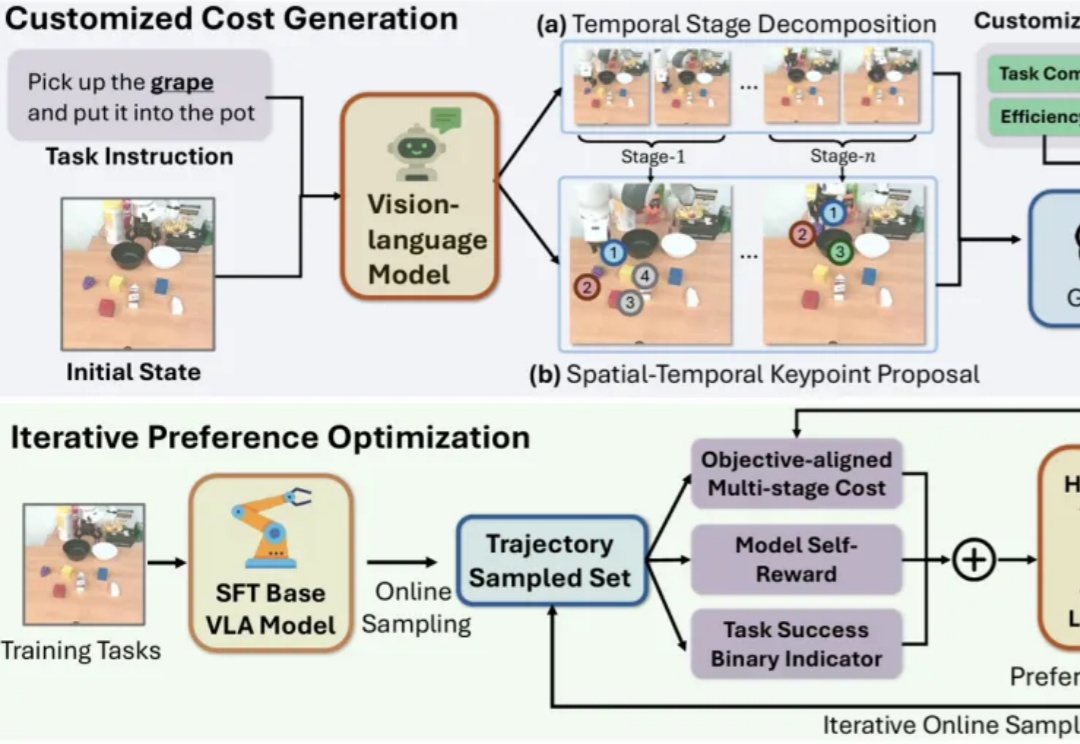

近年来,视觉-语言-动作模型(Vision-Language-Action, VLA)在诸多机器人任务上取得了显著的进展,但它们仍面临一些关键问题,例如由于仅依赖从成功的执行轨迹中进行行为克隆,导致对新任务的泛化能力较差。

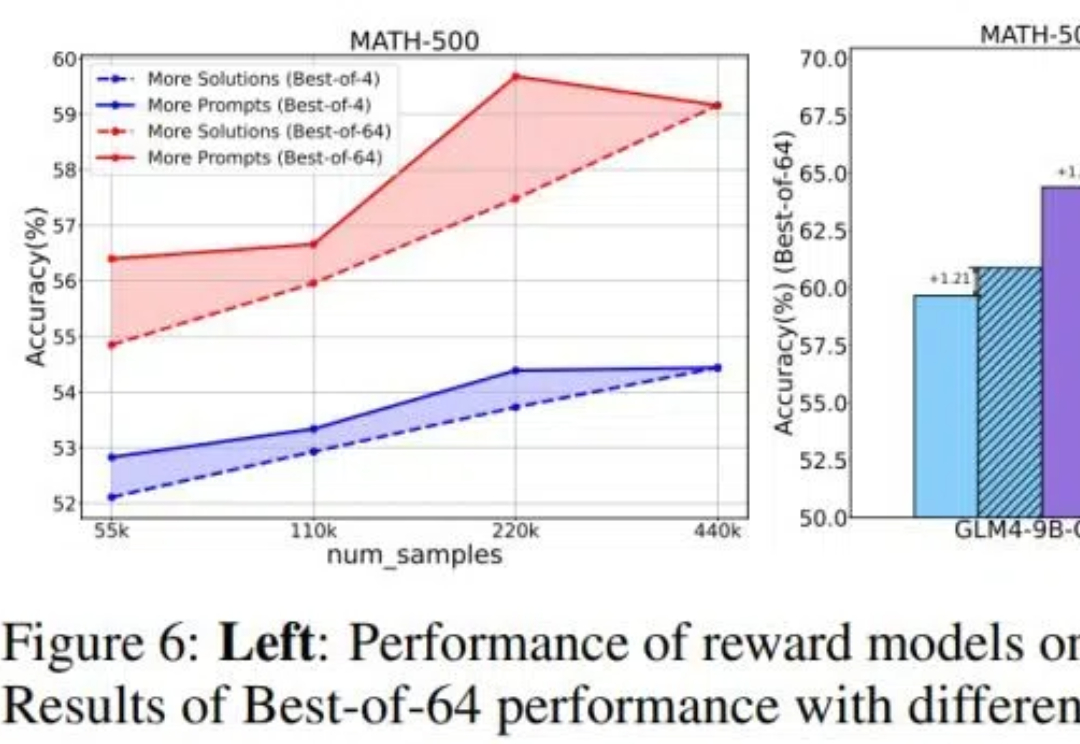

目前关于 RLHF 的 scaling(扩展)潜力研究仍然相对缺乏,尤其是在模型大小、数据组成和推理预算等关键因素上的影响尚未被系统性探索。 针对这一问题,来自清华大学与智谱的研究团队对 RLHF 在 LLM 中的 scaling 性能进行了全面研究,并提出了优化策略。

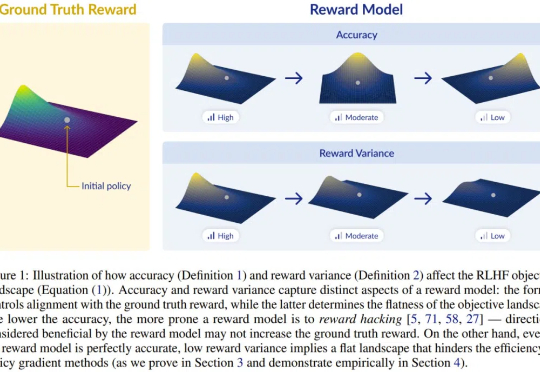

Lilian Weng离职OpenAI后首篇博客发布!文章深入讨论了大模型强化学习中的奖励欺骗问题。随着语言模型在许多任务上的泛化能力不断提升,以及RLHF逐渐成为对齐训练的默认方法,奖励欺骗在语言模型的RL训练中已经成为一个关键的实践性难题。