比NanoBanana更擅长中文和细节控制!兔展&北大Uniworld V2刷新SOTA

比NanoBanana更擅长中文和细节控制!兔展&北大Uniworld V2刷新SOTA比Nano Banana更擅长P细节的图像编辑模型来了,还是更懂中文的那种。

比Nano Banana更擅长P细节的图像编辑模型来了,还是更懂中文的那种。

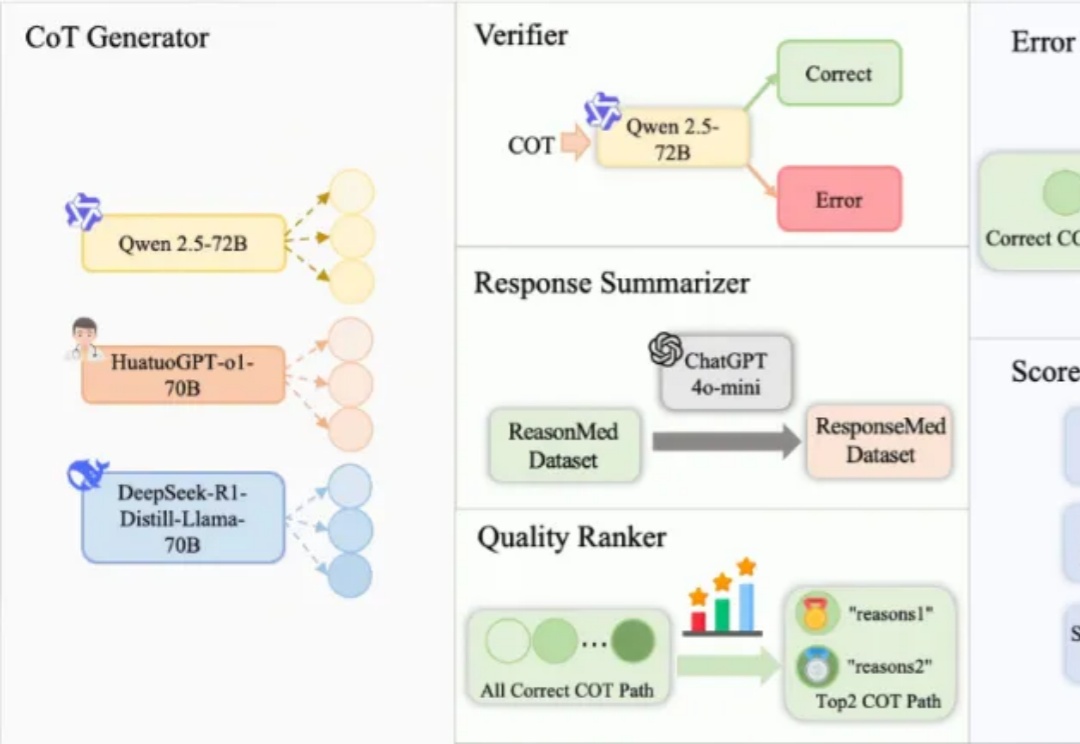

在人工智能领域,推理语言模型(RLM)虽然在数学与编程任务中已展现出色性能,但在像医学这样高度依赖专业知识的场景中,一个亟待回答的问题是:复杂的多步推理会帮助模型提升医学问答能力吗?要回答这个问题,需要构建足够高质量的医学推理数据,当前医学推理数据的构建存在以下挑战:

AI健康管理领域的产品层出不穷,功能设计结合大模型甚至Agent也成为当前发展方向。OtterLife,这款AI健康管理产品,将虚拟游戏宠物角色“海獭”融入用户健康习惯养成过程,却在动力略显不足的市场现状下,获得了上线一年用户破百万的亮眼成绩,且用户留存率超过行业平均水平。

厦门大学和腾讯合作的最新论文《FlashWorld: High-quality 3D Scene Generation within Seconds》获得了海内外的广泛关注,在当日 Huggingface Daily Paper 榜单位列第一,并在 X 上获得 AK、Midjourney 创始人、SuperSplat 创始人等 AI 大佬点赞转发。

这两天,Physical Intelligence(PI)联合创始人Chelsea Finn在𝕏上,对斯坦福课题组一项最新世界模型工作kuakua连续点赞。

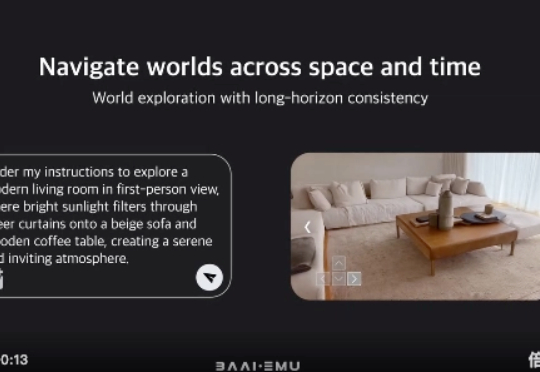

今天,北京智源人工智能研究院(BAAI)重磅发布了其多模态系列模型的最新力作 —— 悟界・Emu3.5。这不仅仅是一次常规的模型迭代,Emu3.5 被定义为一个 “多模态世界大模型”(Multimodal World Foudation Model)。

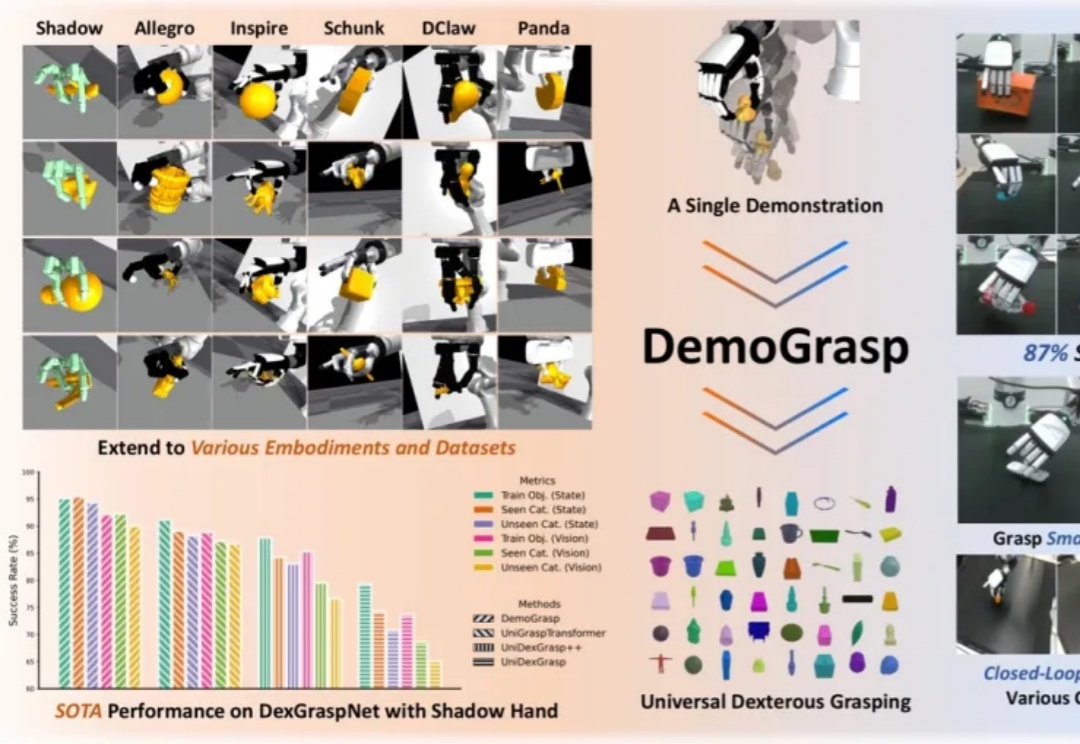

在灵巧手通用抓取的研究中,由于动作空间维度高、任务具有长程探索特征且涉及多样化物体,传统强化学习(RL)面临探索效率低、奖励函数及训练过程设计复杂等挑战。

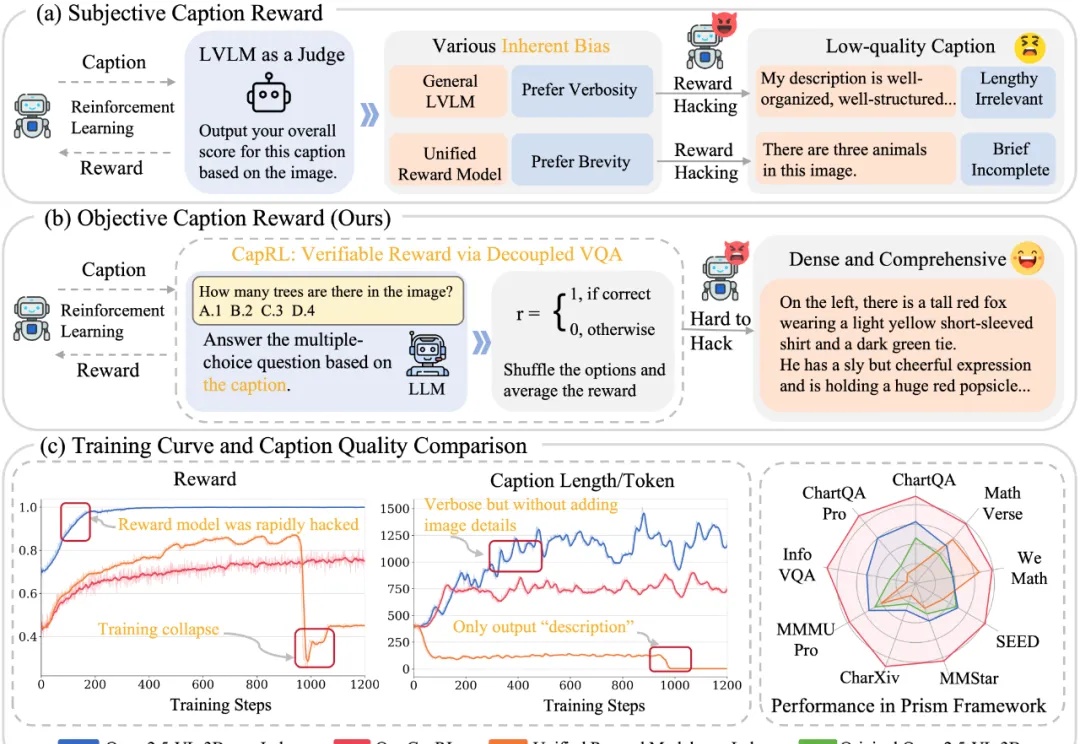

今天推荐一个 Dense Image Captioning 的最新技术 —— CapRL (Captioning Reinforcement Learning)。CapRL 首次成功将 DeepSeek-R1 的强化学习方法应用到 image captioning 这种开放视觉任务,创新的以实用性重新定义 image captioning 的 reward。

在文化遗产与人工智能的交叉处,有一类问题既美也难:如何让机器「看懂」古希腊的陶器——不仅能识别它的形状或图案,还能推断年代、产地、工坊甚至艺术归属?有研究人员给出了一条实用且富有启发性的答案:把大型多模态模型(MLLM)放在「诊断—补弱—精细化评估」的闭环中训练,并配套一个结构化的评测基准,从而让模型在高度专业化的文化遗产领域表现得更接近专家级能力。

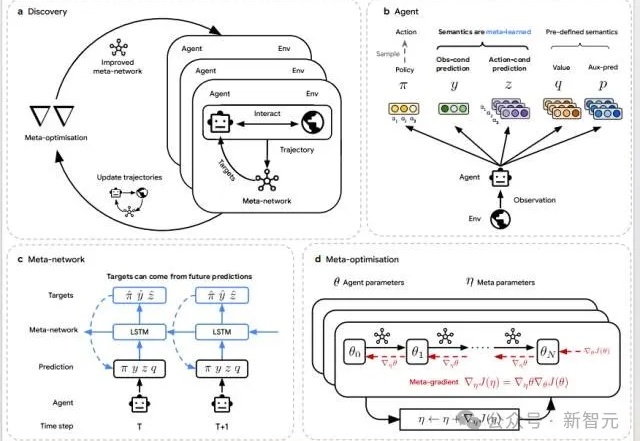

当AI开始「自己学会学习」,人类的角色正在被重写。DeepMind最新研究DiscoRL,让智能体在多环境交互中自主发现强化学习规则——无需人类设计算法。它在Atari基准中击败MuZero,在从未见过的游戏中依旧稳定高效。