泛化性暴涨47%!首个意图检测奖励范式,AI工具爆炸时代意图识别新解法

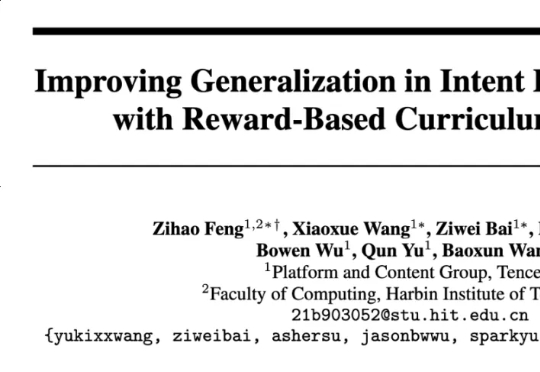

泛化性暴涨47%!首个意图检测奖励范式,AI工具爆炸时代意图识别新解法近日,腾讯 PCG 社交线的研究团队针对这一问题,采用强化学习(RL)训练方法,通过分组相对策略优化(Group Relative Policy Optimization, GRPO)算法,结合基于奖励的课程采样策略(Reward-based Curriculum Sampling, RCS),将其创新性地应用在意图识别任务上,

近日,腾讯 PCG 社交线的研究团队针对这一问题,采用强化学习(RL)训练方法,通过分组相对策略优化(Group Relative Policy Optimization, GRPO)算法,结合基于奖励的课程采样策略(Reward-based Curriculum Sampling, RCS),将其创新性地应用在意图识别任务上,

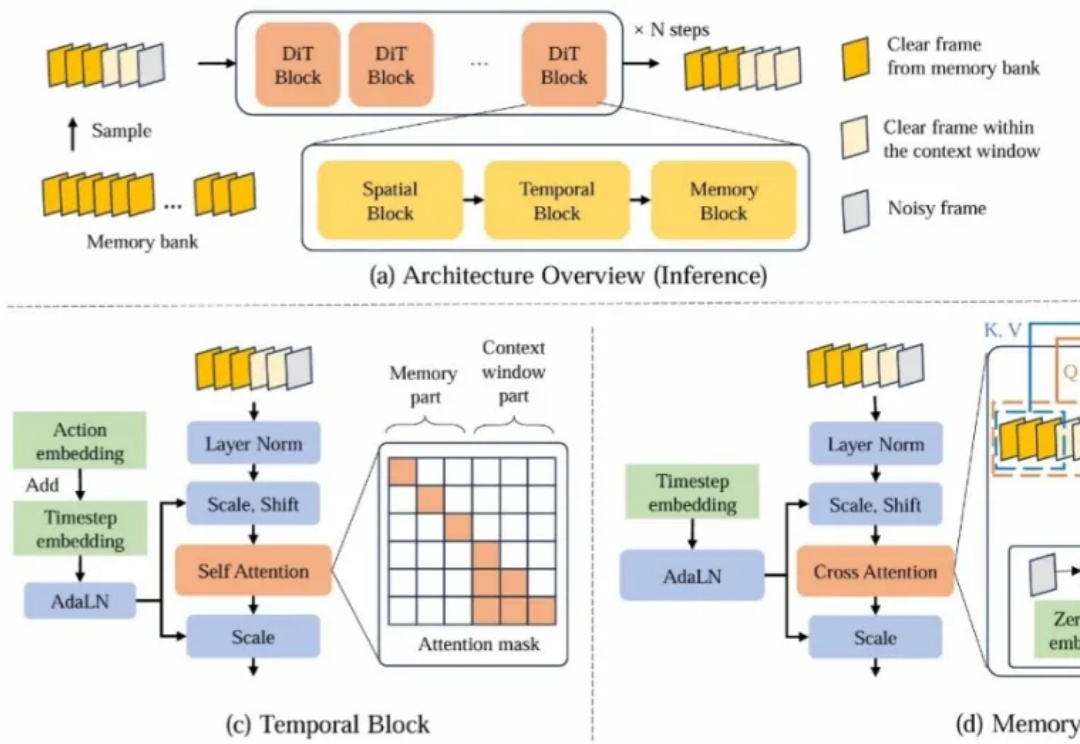

R1 横空出世,带火了 GRPO 算法,RL 也随之成为 2025 年的热门技术探索方向,近期,字节 Seed 团队就在图像生成方向进行了相关探索。

近日,《自然》杂志独家专访了OpenAI首席科学家Jakub Pachocki,他揭示了推理模型、强化学习如何赋予AI自主发现科学的能力,并分享了AI如何在五年内重塑科学研究与经济格局的雄心。

北美应届毕业的ML博士,方向为RL,读博期间跟的是大牛导师,5篇顶会一作,拿到的offer年薪却只有35万刀?他发帖质疑后,各位业内大佬们现身了。

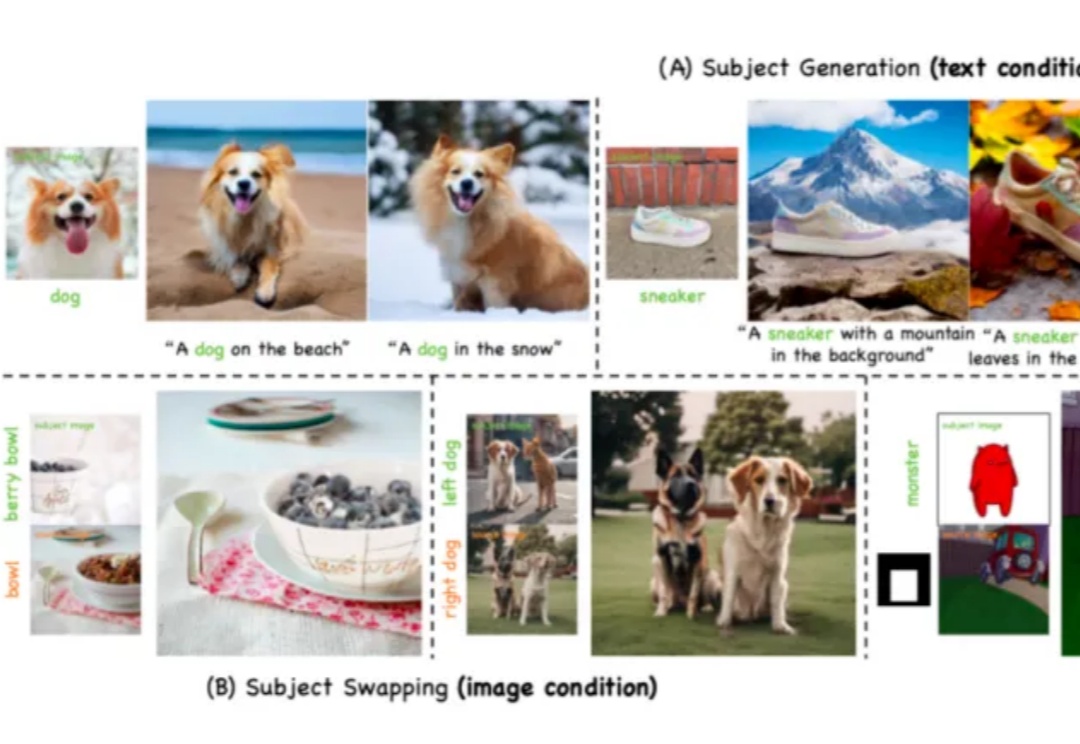

近年来,生成式人工智能(Generative AI)技术的突破性进展,特别是文本到图像 T2I 生成模型的快速发展,已经使 AI 系统能够根据用户输入的文本提示(prompt)生成高度逼真的图像。从早期的 DALL・E 到 Stable Diffusion、Midjourney 等模型,这一领域的技术迭代呈现出加速发展的态势。

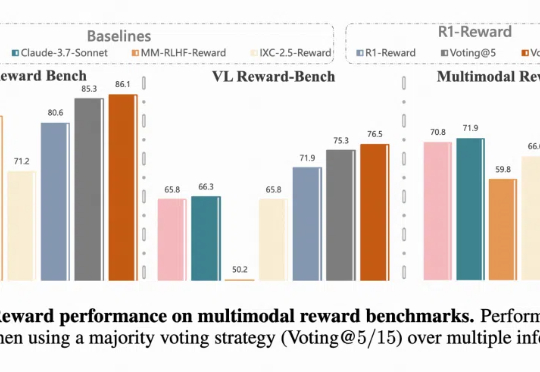

多模态奖励模型(MRMs)在提升多模态大语言模型(MLLMs)的表现中起着至关重要的作用,在训练阶段可以提供稳定的 reward,评估阶段可以选择更好的 sample 结果,甚至单独作为 evaluator。

近年来,基于视频生成模型的可交互世界生成引发了广泛关注。尽管现有方法在生成质量和交互能力上取得了显著进展,但由于上下文时间窗口受限,生成的世界在长时序下严重缺乏一致性。

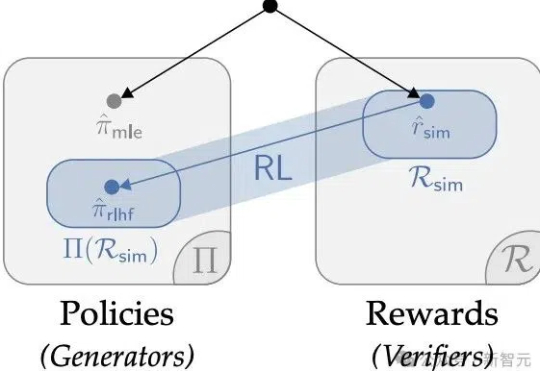

华人学者参与的一项研究,重新确立了强化学习在LLM微调的价值,深度解释了AI训练「两阶段强化学习」的原因。某种意义上,他们的论文说明RL微调就是统计。

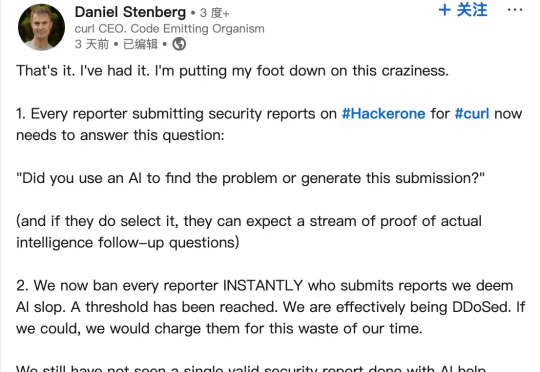

近日,curl 项目(一款用于通过 URL 传输数据的命令行工具和库)创始人 Daniel Stenberg 在领英发帖称,已经受够了由 AI 生成的大量“垃圾”漏洞报告,因此近期引入额外复选框,用以过滤此类平白浪费维护人员时间的低效提交内容。

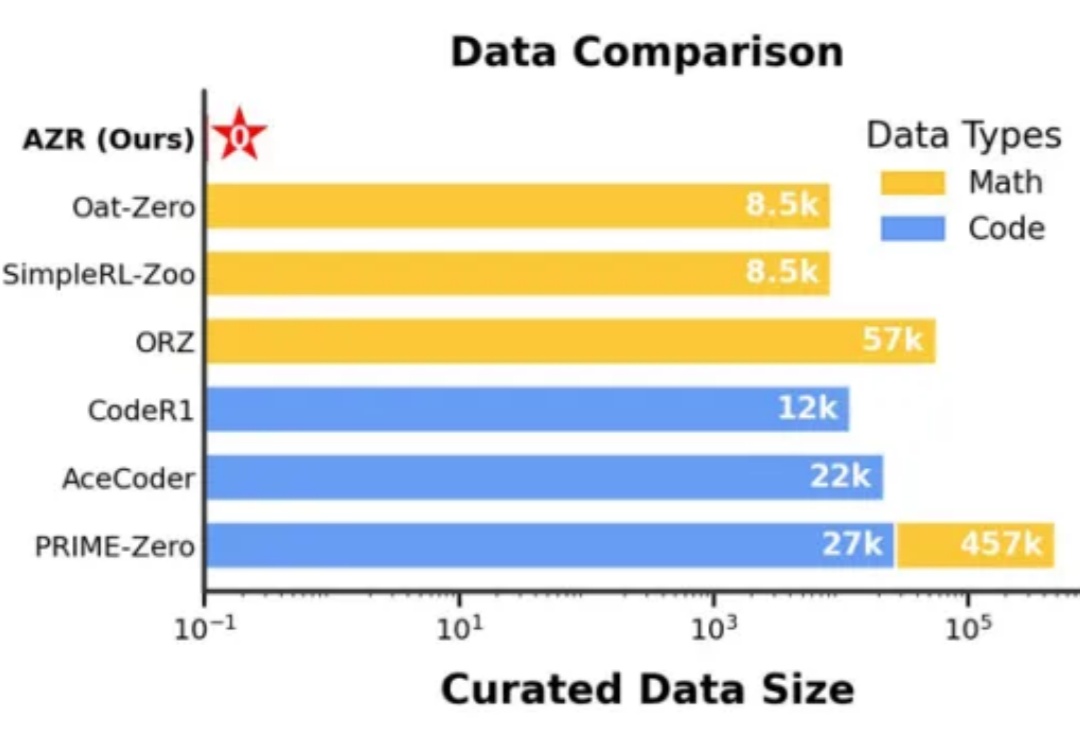

在人工智能领域,推理能力的进化已成为通向通用智能的核心挑战。近期,Reinforcement Learning with Verifiable Rewards(RLVR)范式下涌现出一批「Zero」类推理模型,摆脱了对人类显式推理示范的依赖,通过强化学习过程自我学习推理轨迹,显著减少了监督训练所需的人力成本。