十倍成本优化,Milvus 2.5到2.6升级官方手把手教程

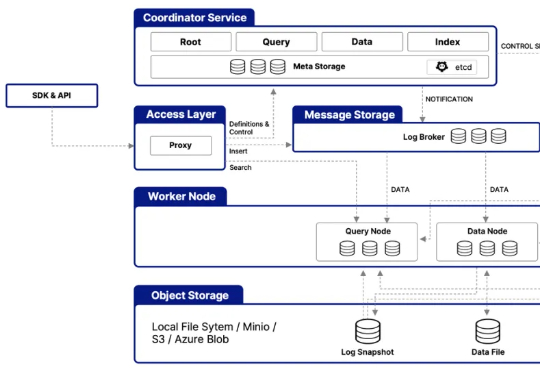

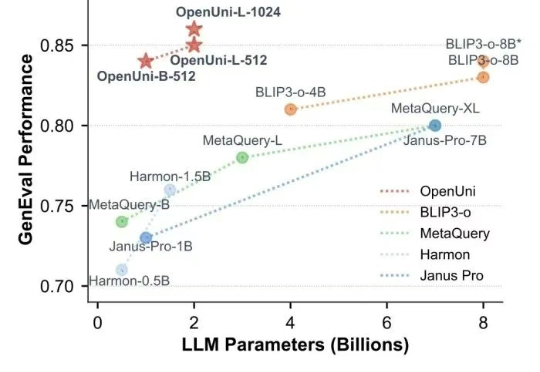

十倍成本优化,Milvus 2.5到2.6升级官方手把手教程在架构层面,Milvus 2.6 大幅简化系统架构,整合多个核心组件 —— 例如将原有的 Coordinator 组件(含 RootCoord、QueryCoord、DataCoord)统一整合为 MixCoord,并将 IndexNode 与 DataNode 合并为单一组件。这些调整不仅降低了系统复杂度,更显著提升了系统的可维护性与横向扩展性。

在架构层面,Milvus 2.6 大幅简化系统架构,整合多个核心组件 —— 例如将原有的 Coordinator 组件(含 RootCoord、QueryCoord、DataCoord)统一整合为 MixCoord,并将 IndexNode 与 DataNode 合并为单一组件。这些调整不仅降低了系统复杂度,更显著提升了系统的可维护性与横向扩展性。

在开发DeepResearch时,生成多样化的查询 (query) 是一个关键细节。我们在开发时会在至少两处遇到这个问题。

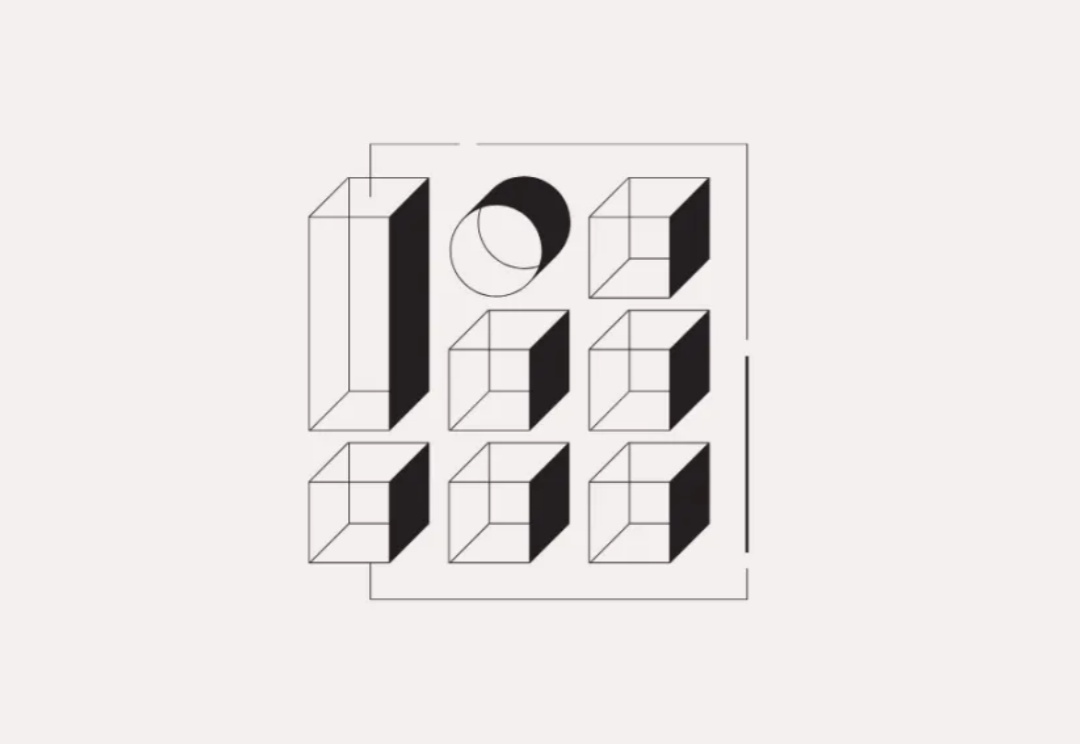

随着 GPT-4o 展现出令人印象深刻的多模态能力,将视觉理解和图像生成统一到单一模型中已成为 AI 领域的研究趋势(如MetaQuery 和 BLIP3-o )。

在生成式 AI 重塑搜索形态的当下,Perplexity 正以“答案”为核心,重构信息入口。它不是聊天机器人,也不是传统搜索引擎,而是一种 “认知界面”——通过自然语言对话,为用户提供可验证、可引用的真实答案 。

来自Meta和NYU的团队,刚刚提出了一种MetaQuery新方法,让多模态模型瞬间解锁多模态生成能力!令人惊讶的是,这种方法竟然如此简单,就实现了曾被认为需要MLLM微调才能具备的能力。

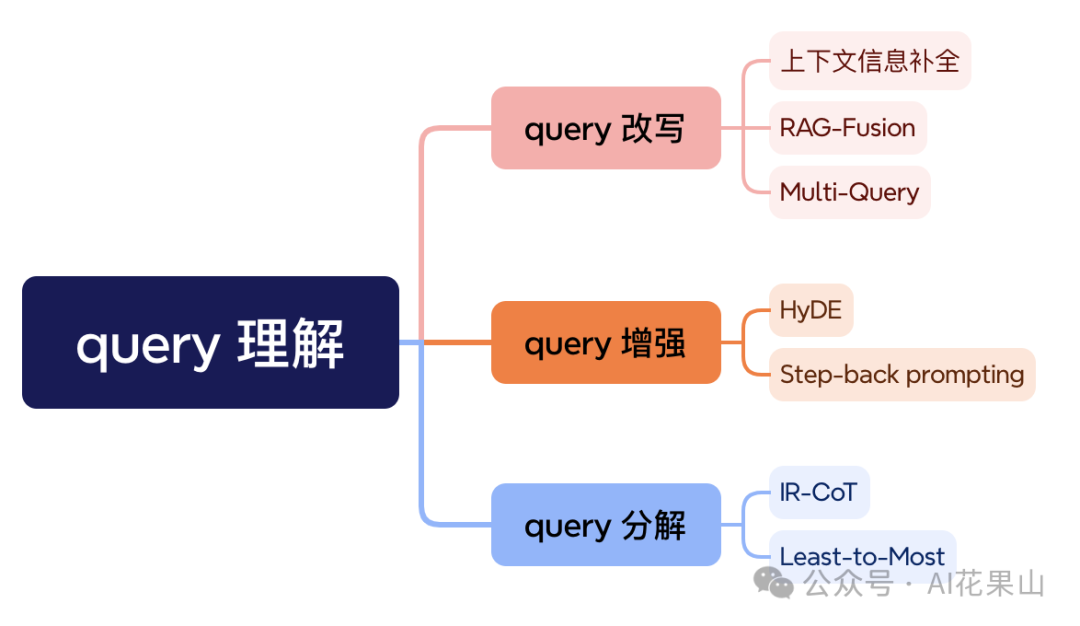

在信息检索系统中,搜索引擎的能力只是影响结果的一个方面,真正的瓶颈往往在于:用户的原始 query 本身不够好。

在这篇文章中,笔者将讨论以下几个问题: • 为什么要进行 query 理解 • query 理解有哪些技术(从 RAG 角度) • 各种 query 理解技术的实现(基于 LangChain)

寻隐(英文名 Queryable)是一款 iOS 上的 AI 照片搜索软件,支持用户使用自然语言搜索本地照片。软件诞生的契机是 OpenAI 发布的 CLIP 模型。

苹果讲了一个按Query难度分发模型的模式:B小模型:大多数场景,包括自动回复、改写、语法检查、Summary都用端侧的小模型跑。