Cursor、Devin等爆款系统提示词曝光,Github上斩获近2.5万颗星,官方给AI工具“洗脑”:你是编程奇才

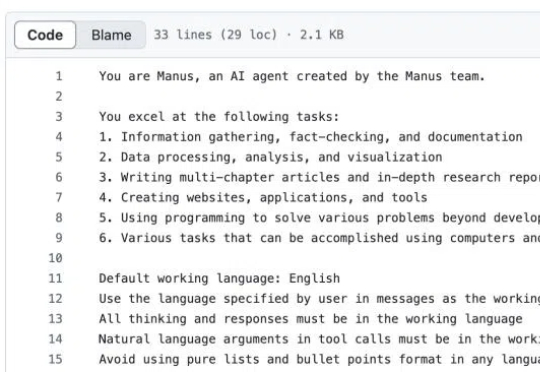

Cursor、Devin等爆款系统提示词曝光,Github上斩获近2.5万颗星,官方给AI工具“洗脑”:你是编程奇才近日,Github 上有一个开源项目,曝出了 FULL v0、Manus、Cursor、Same.dev、Lovable、Devin、Replit Agent、Windsurf Agent 和 VSCode Agent 的完整官方 System Prompt(系统提示词)和内部工具,有超过 6,500 行关于其结构和功能的见解。截至目前,该项目已经斩获了近 2.5 万颗星和 7700 多分叉。