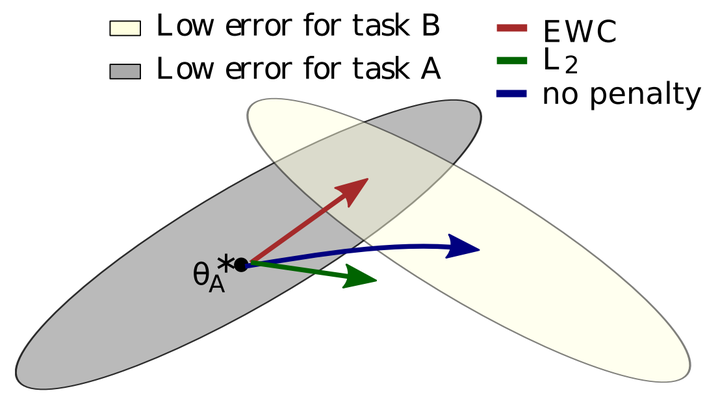

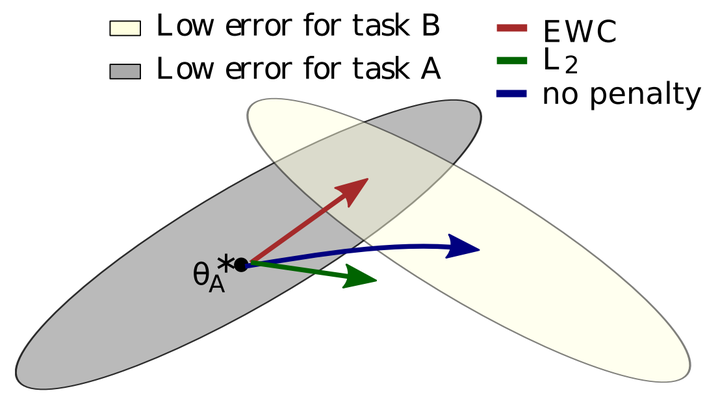

为什么神经网络会存在灾难性遗忘(catastrophic forgetting)这个问题?

为什么神经网络会存在灾难性遗忘(catastrophic forgetting)这个问题?所谓灾难性遗忘,就是一个在原始任务上训练好的神经网络在训练完新任务后,在原始任务上的表现崩溃式的降低。

来自主题: AI资讯

5660 点击 2024-01-02 11:46

所谓灾难性遗忘,就是一个在原始任务上训练好的神经网络在训练完新任务后,在原始任务上的表现崩溃式的降低。

无法控制成本的大模型终将被“快好省”的小模型取代今年最热的AI赛道中,机构们自然也得下一些判断,比如说——2024年大模型的一个趋势,是将变得“越来越小”。

香港中文大学(深圳)数据科学学院武执政副教授团队联合上海人工智能实验室 OpenMMLab 团队开源了综合音频生成项目 Amphion(安菲翁)。该系统旨在打造一个集语音合成转换、歌声合成转换、音效音乐生成等多功能为一体的开源平台。

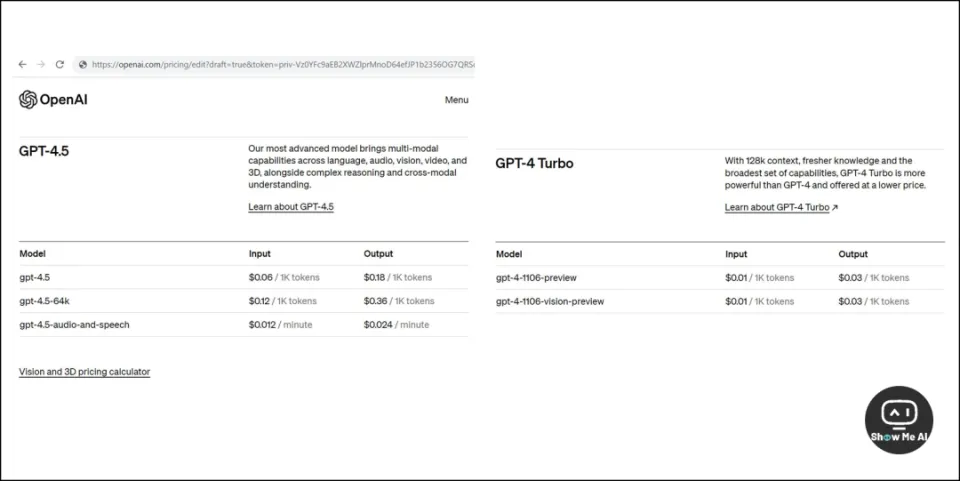

OpenAI GPT-4.5 遭泄露,我们即将见识「加强版」多模态大模型

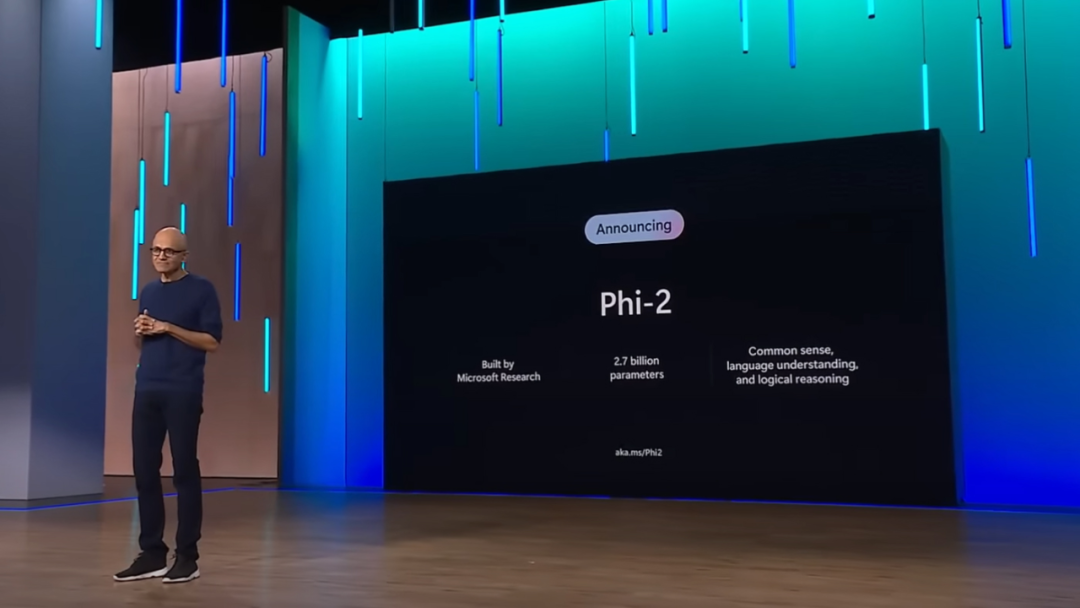

上个月,微软 CEO 纳德拉在 Ignite 大会上宣布自研小尺寸模型 Phi-2 将完全开源,在常识推理、语言理解和逻辑推理方面的性能显著改进。

都快到年底了,大模型领域还在卷,今天,Microsoft发布了参数量为2.7B的Phi-2——不仅13B参数以内没有对手,甚至还能和Llama 70B掰手腕!

谷歌云的Philip Moyer告诉Insider,生成式人工智能将提升工作满意度,人工智能工具正在减少繁琐的工作量,员工们现在 “等待它的出现”。高盛表示,人工智能可能会影响到3亿个工作岗位。