微软Phi模型核心作者离职加入OpenAI,OpenAI前CTO偷挖墙脚

微软Phi模型核心作者离职加入OpenAI,OpenAI前CTO偷挖墙脚家人们,一觉醒来,又吃了一则新瓜:

家人们,一觉醒来,又吃了一则新瓜:

微软 10 年「老兵」选择离开。

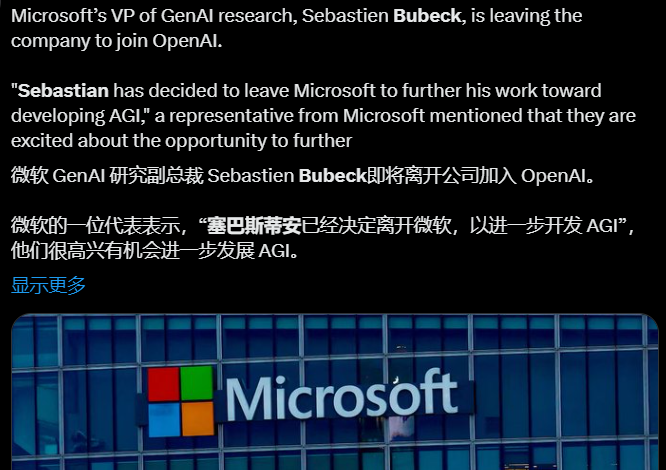

3D生成也能支持检索增强(RAG)了。

智东西8月28日消息,据TechCrunch报道,美国西雅图创企Supio在周二宣布完成了2500万美元超额认购A轮融资。本轮投资由Sapphire Ventures领投,Bonfire Ventures和Foothill Ventures参与投资。截至目前,Supio已经筹集到了3300万美元,计划在短期内扩大客户基础、平台规模并最终将业务扩展到其他法律领域。

今天,生成式AI已成为技术和金融市场中的重要话题。无论是通过风险投资、股票上涨、媒体报道,还是财报电话会议中的提及次数来衡量,AI的崛起都是显而易见的。

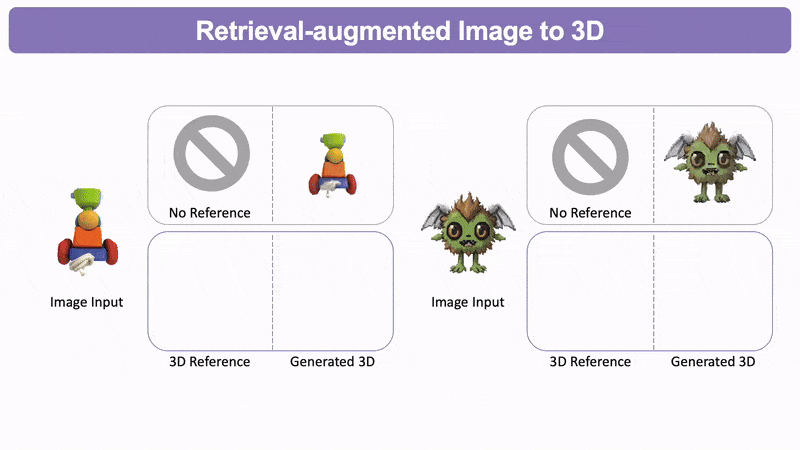

轻量级模型的春天要来了吗?

微软Phi 3.5系列上新了!mini模型小而更美,MoE模型首次亮相,vision模型专注多模态。

面对GenAI的技术浪潮,很多人都会在不断迭代更新的技术中逐渐迷失。站在潮头的Sapphire、Emergence、Menlo等风投公司,又会如何看待这场AI变局的现状与走向?

Build大会召开两周之后,微软更新了Phi-3系列模型的技术报告。不仅加入最新的基准测试结果,而且对小模型、高性能的实现机制做出了适当的揭示。

深度学习领域知名研究者、Lightning AI 的首席人工智能教育者 Sebastian Raschka 对 AI 大模型有着深刻的洞察,也会经常把一些观察的结果写成博客。在一篇 5 月中发布的博客中,他盘点分析了 4 月份发布的四个主要新模型:Mixtral、Meta AI 的 Llama 3、微软的 Phi-3 和苹果的 OpenELM。