稳定学习预后标志物,多种癌症生存曲线证实!清华最新成果登Nature顶级子刊

稳定学习预后标志物,多种癌症生存曲线证实!清华最新成果登Nature顶级子刊清华大学与国家蛋白质科学中心的最新成果,结合了稳定学习的理论,提出了一个面向多中心、大队列异质数据的「稳定」生存分析方法。

清华大学与国家蛋白质科学中心的最新成果,结合了稳定学习的理论,提出了一个面向多中心、大队列异质数据的「稳定」生存分析方法。

在瑞士日内瓦湖畔,洛桑联邦理工学院(EPLF)不仅是机器人专家们的圣地,更是各种小鸟的「快乐大本营」。然而,小鸟们现在似乎不太热衷于飞行了,更喜欢在地面上悠哉游哉地散步,反正好吃的遍地都是。

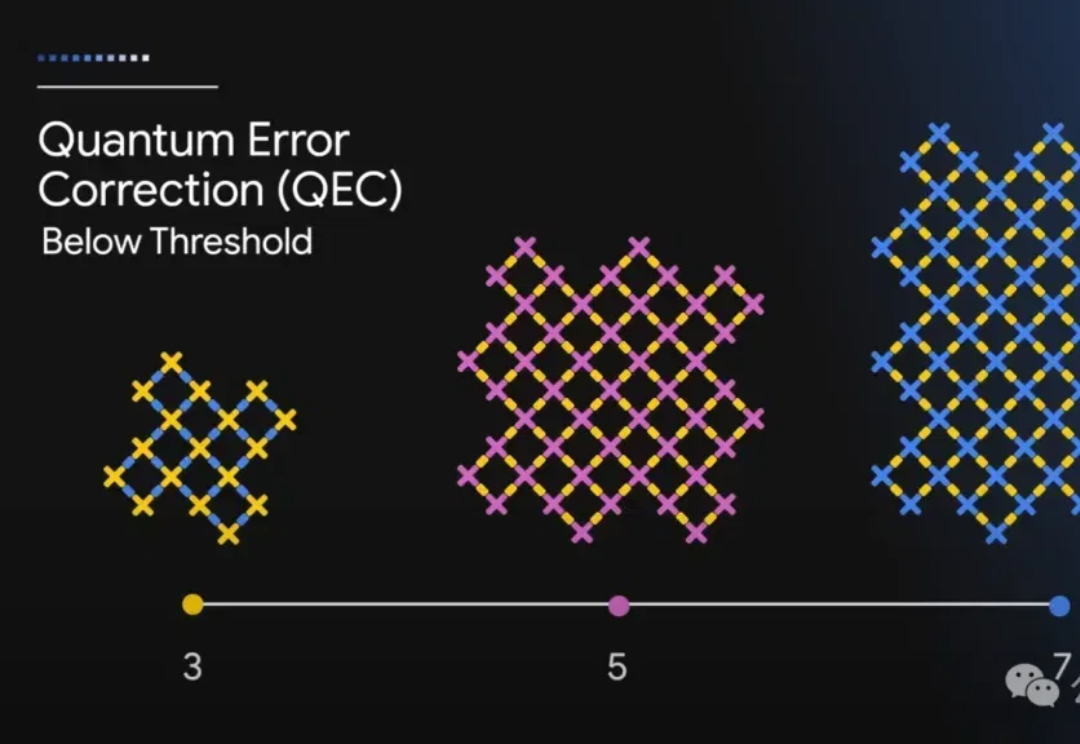

全球科技圈都在为Sora疯狂,马斯克却轻轻给谷歌点了个赞(doge)。 就在OpenAI“双12”第三天,谷歌在前沿科技的另一极出手了: 发布最新量子芯片,5分钟内完成当今最快超级计算机之一需要10²⁵年才能完成的计算!

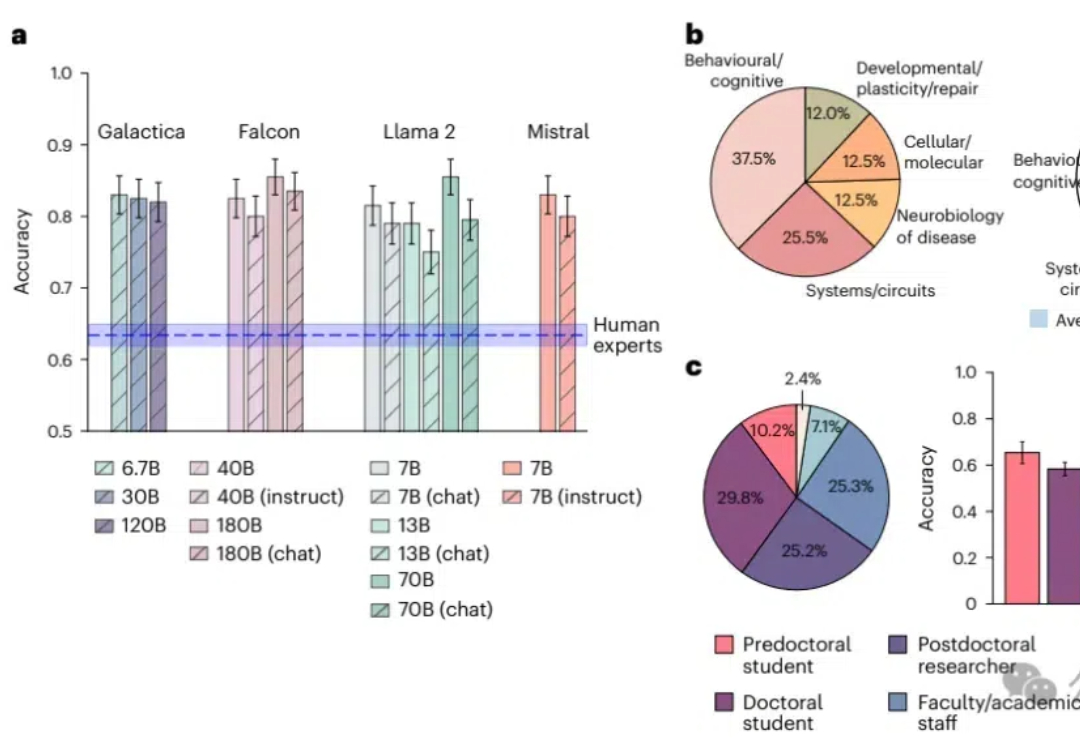

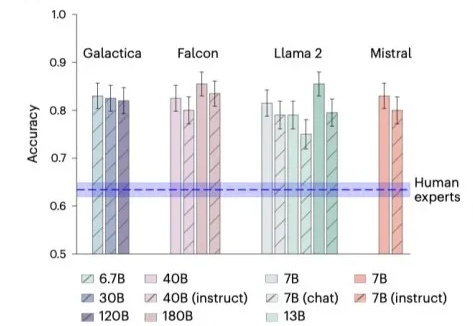

知识密集型工作也败了!大型语言模型在预测神经科学结果方面超越了人类专家,平均准确率达到81%,而人类专家仅为63%;模型通过整合大量文献数据,展现出了惊人的前瞻性预测能力,预示着未来科研工作中人机协作的巨大潜力。

人类离AGI究竟还有多远?最新一期Nature文章,从以往研究分析、多位大佬言论深入探讨了LLM在智能化道路上突破与局限。

人工智能工具正在帮助科研人员快速整合和理解大量科学文献,但完全自动化的高质量文献综述生成仍面临挑战,虽然能提升研究效率,但也存在生成低质量综述的风险,需谨慎使用,所以说现阶段还是人眼看论文靠谱。

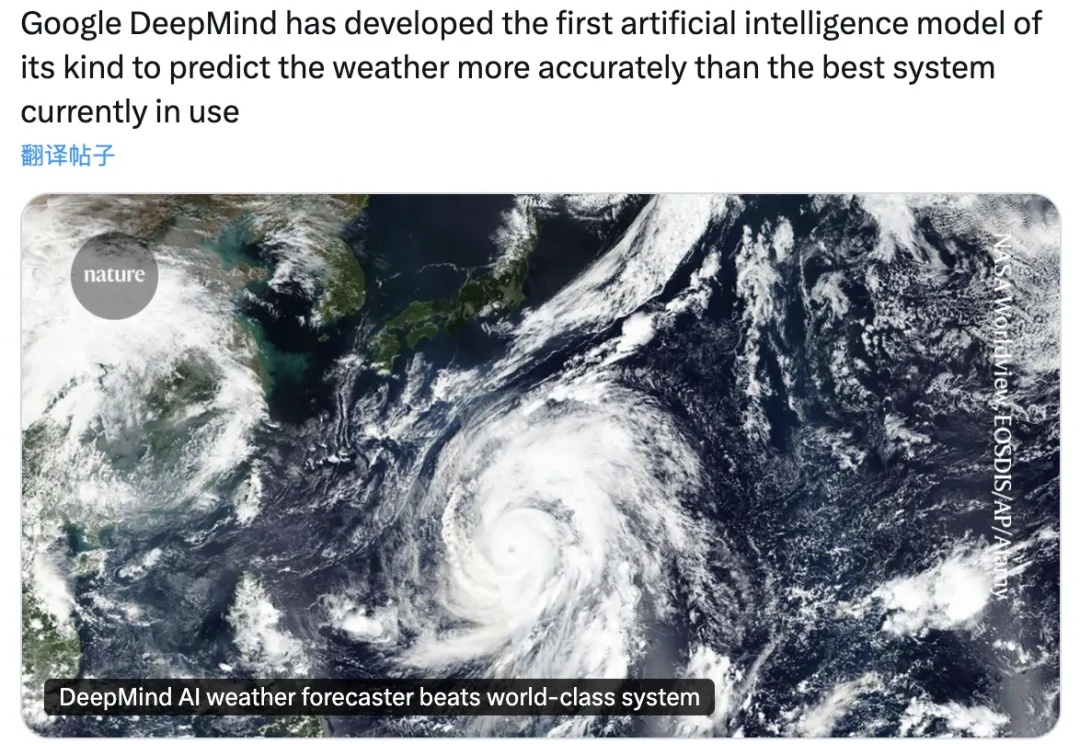

DeepMind大模型再登上Nature——

LLM可以比科学家更准确地预测神经学的研究结果!

近日,面对EDA界对于自家AlphaChip的质疑,谷歌首席科学家Jeff Dean以论文回应论文,并表示:大家注意,这是同行竞争!

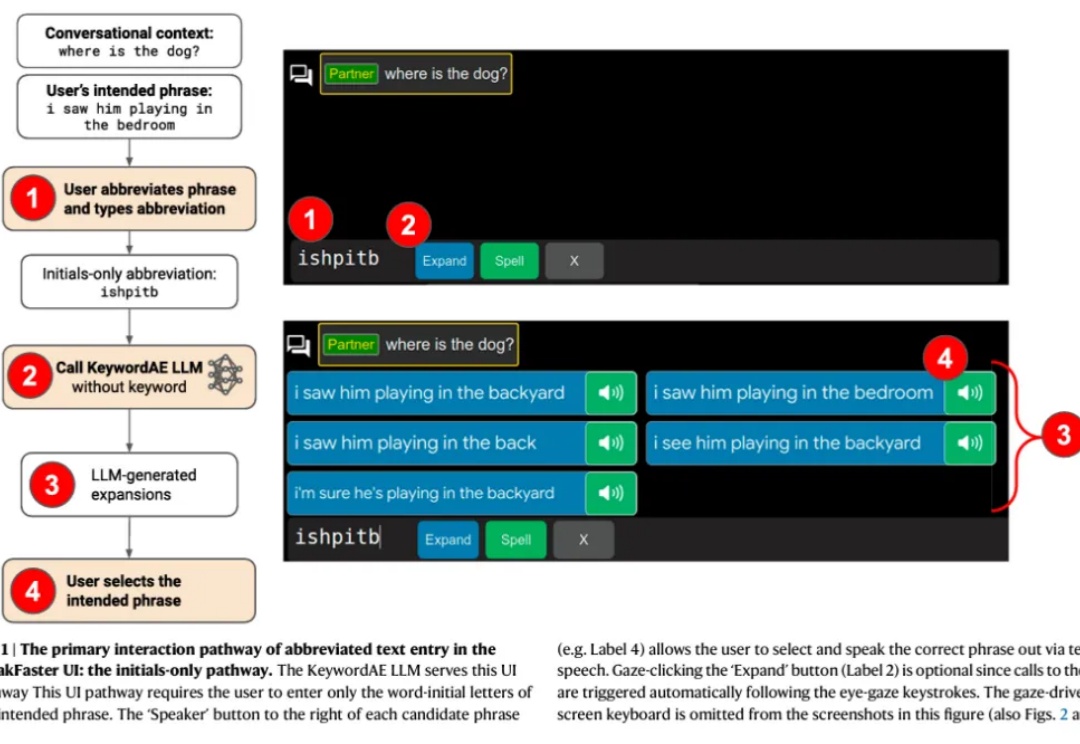

因渐冻症(ALS)等病症而无法言语或打字的人群不容忽视,他们在日常沟通交流中面临着巨大障碍,急需有效的辅助手段来打破沟通壁垒。