国产Nano Banana开源!用华为AI芯片训练,1张图只要1毛钱

国产Nano Banana开源!用华为AI芯片训练,1张图只要1毛钱今天,首个在国产芯片上完成全程训练的SOTA(最佳水平)多模态模型开源。这是智谱联合华为开源的图像生成模型GLM-Image。从数据到训练的全流程,该模型完全基于昇腾Atlas 800T A2设备和昇思MindSpore AI框架完成构建。

今天,首个在国产芯片上完成全程训练的SOTA(最佳水平)多模态模型开源。这是智谱联合华为开源的图像生成模型GLM-Image。从数据到训练的全流程,该模型完全基于昇腾Atlas 800T A2设备和昇思MindSpore AI框架完成构建。

这两年一直在关注 AI,Claude Code 给我带来的震撼,和当初 Nano Banana 在画图领域的革命,几乎是一个级别。

最新报告探讨了生成式模型Nano Banana Pro在低层视觉任务中的表现,如去雾、超分等,传统上依赖PSNR/SSIM等像素级指标。研究发现,Nano Banana Pro在视觉效果上更佳,但传统指标表现欠佳,因生成式模型更追求语义合理而非像素对齐。

太香了太香了,妥妥完爆ChatGPT和Nano Banana!

趁着最近各种年度总结都出来了,我们在这篇文章里,也总结了一波 Google 今年在 AI 方向上的发力,给我们的实际体验,又带来了多大的能力提升。在谈论这些产品更新之前,Gemini 和 Nano Banana 两大「基座」模型是绕不开的内容。没有 Gemini 和 Nano Banana,Google 就是巧妇难为无米之炊。

Content in,Design out。

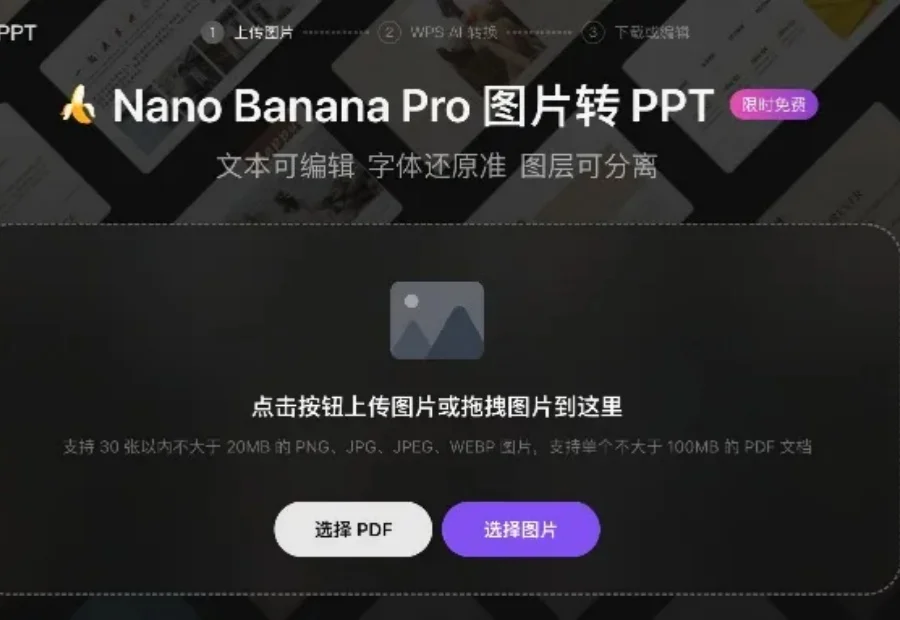

Nano Banana Pro都做不到的事情,这个国产Office软件解决了。

为了抢回头把交椅,OpenAI 今天正式推出了最新图像视觉模型 GPT-Image-1.5。这也是继 GPT-5.2 之后,OpenAI 红色警报计划中又一记重拳。

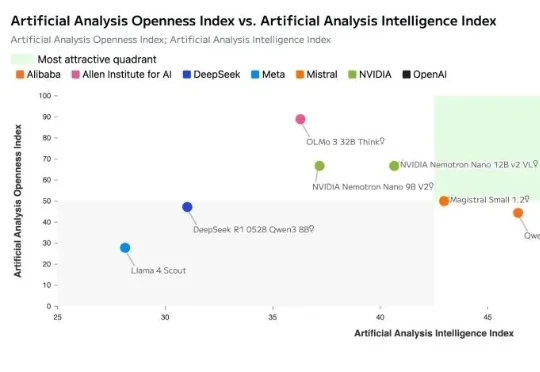

就在刚刚,英伟达正式开源发布了其新一代AI模型:NVIDIA Nemotron 3。Nemotron 3 系列由三种型号组成:Nano、Super 和 Ultra。官方介绍其具备强大的智能体、推理和对话能力。

前有 vibe coding ,随着 nano banana 升级 pro, vibe PPT 也跟着来了。最近我在 GitHub 上挖到一个项目:banana slides 。这是一个基于 nano banana pro 的原生 AI PPT 生成应用。