关于LLM-as-a-judge范式,终于有综述讲明白了

关于LLM-as-a-judge范式,终于有综述讲明白了评估和评价长期以来一直是人工智能 (AI) 和自然语言处理 (NLP) 中的关键挑战。然而,传统方法,无论是基于匹配还是基于词嵌入,往往无法判断精妙的属性并提供令人满意的结果。

评估和评价长期以来一直是人工智能 (AI) 和自然语言处理 (NLP) 中的关键挑战。然而,传统方法,无论是基于匹配还是基于词嵌入,往往无法判断精妙的属性并提供令人满意的结果。

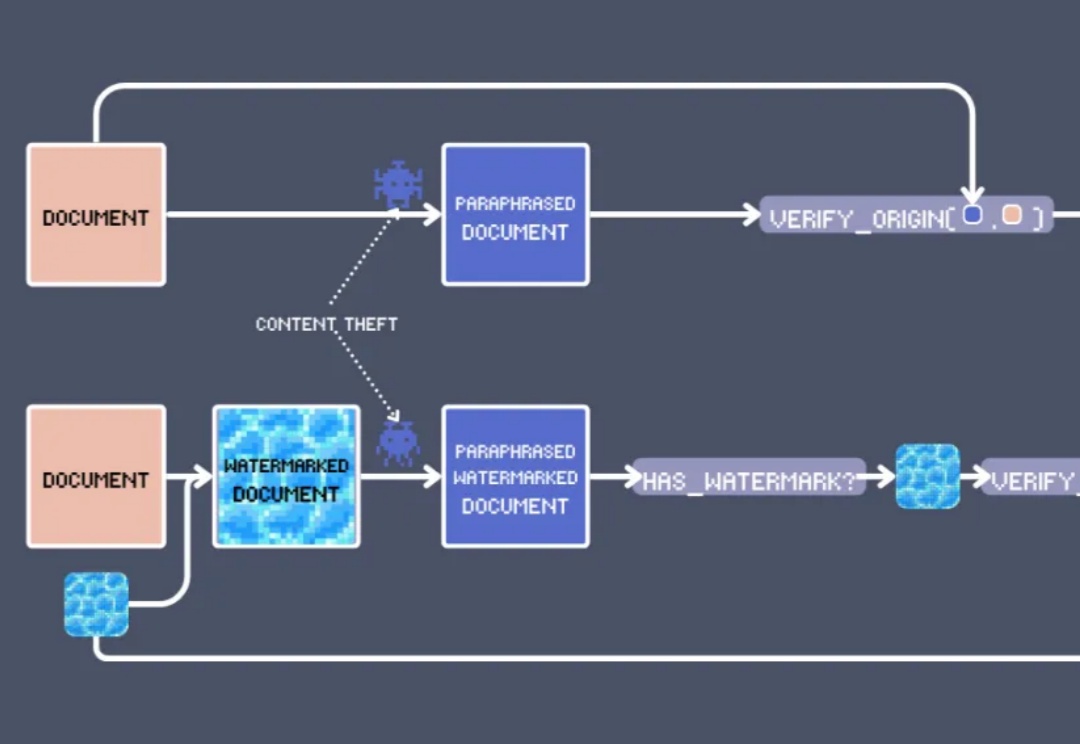

在 EMNLP 2024 上,我们看到了向量模型的各种创新用法,其中最出人意料的莫过于:文本水印。

作为自然语言处理(NLP)领域的顶级盛会,EMNLP 每年都成为全球研究者的关注焦点。

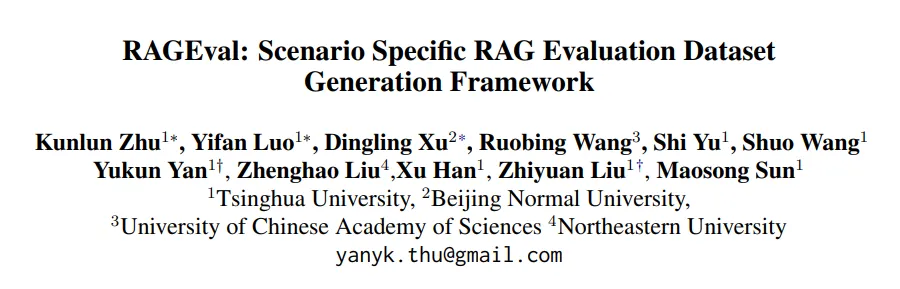

清华大学NLP实验室联合北京师范大学、中国科学院大学、东北大学等机构的研究人员推出了全新的评测方法 RAGEval,通过快速构建场景化评估数据实现对检索增强生成(RAG)系统的“精准诊断”。

让大模型能快速、准确、高效地吸收新知识!

在NLP领域,研究者们已经充分认识并认可了表征学习的重要性,那么视觉领域的生成模型呢?最近,谢赛宁团队发表的一篇研究就拿出了非常有力的证据:Representation matters!

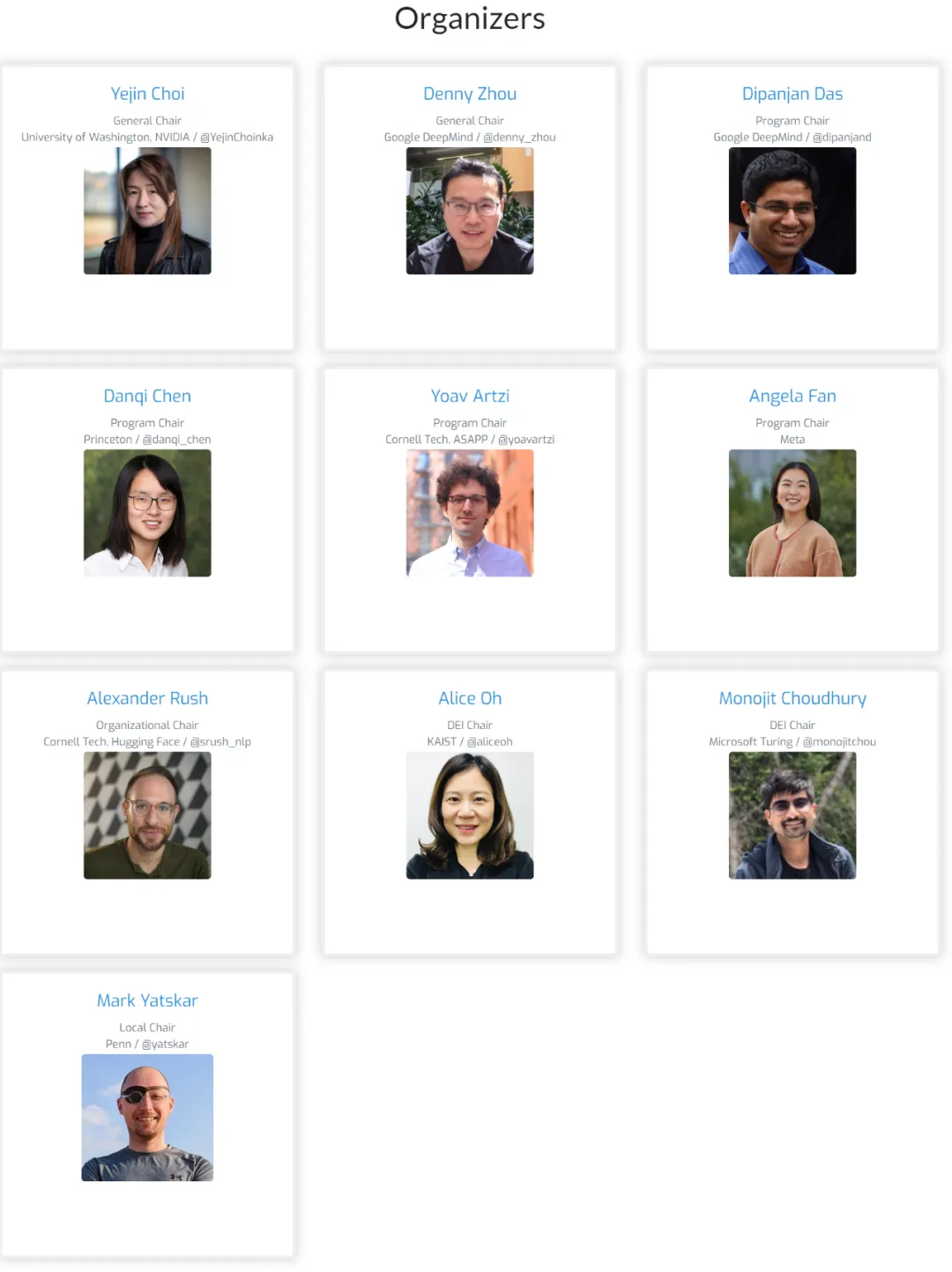

会议组织者都是 NLP 头部科学家,在语言建模方面有着相当的成果。

最近,斯坦福大学 NLP 组在读博士 Omar Khattab 发布了一篇博文,讨论了顶级 AI 学者们有关做有影响力研究的思考

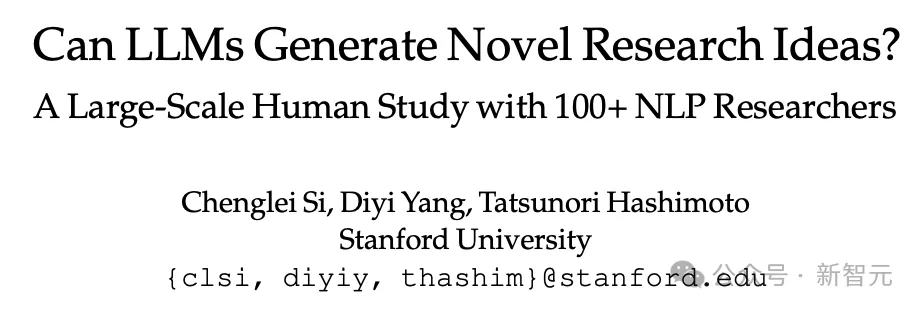

斯坦福大学的最新研究通过大规模实验发现,尽管大型语言模型(LLMs)在新颖性上优于人类专家的想法,但在可行性方面略逊一筹,还需要进一步研究以提高其实用性。

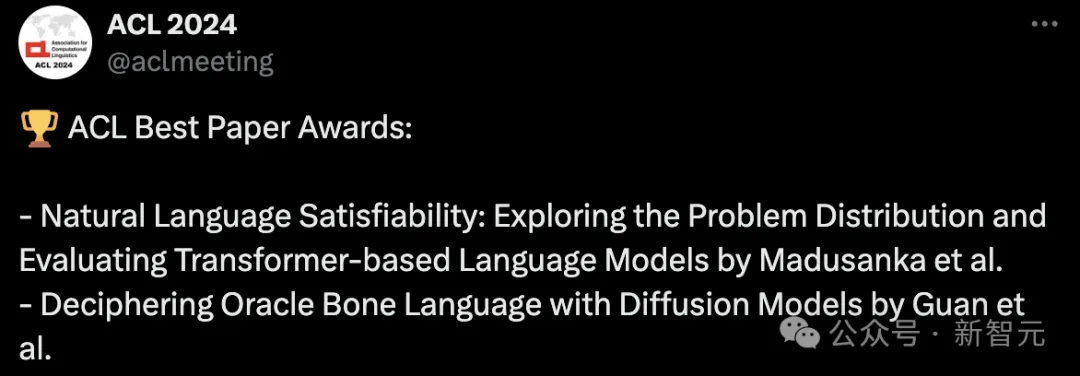

【新智元导读】一年一度NLP顶会ACL揭晓了最终获奖论文。今年,共有7篇论文荣获最佳论文,时间检验奖颁给斯坦福GloVe、康奈尔大学相似性度量。另外,还有最佳主题奖、最佳社会影响力奖、最佳资源奖、领域主席奖,以及杰出论文奖。