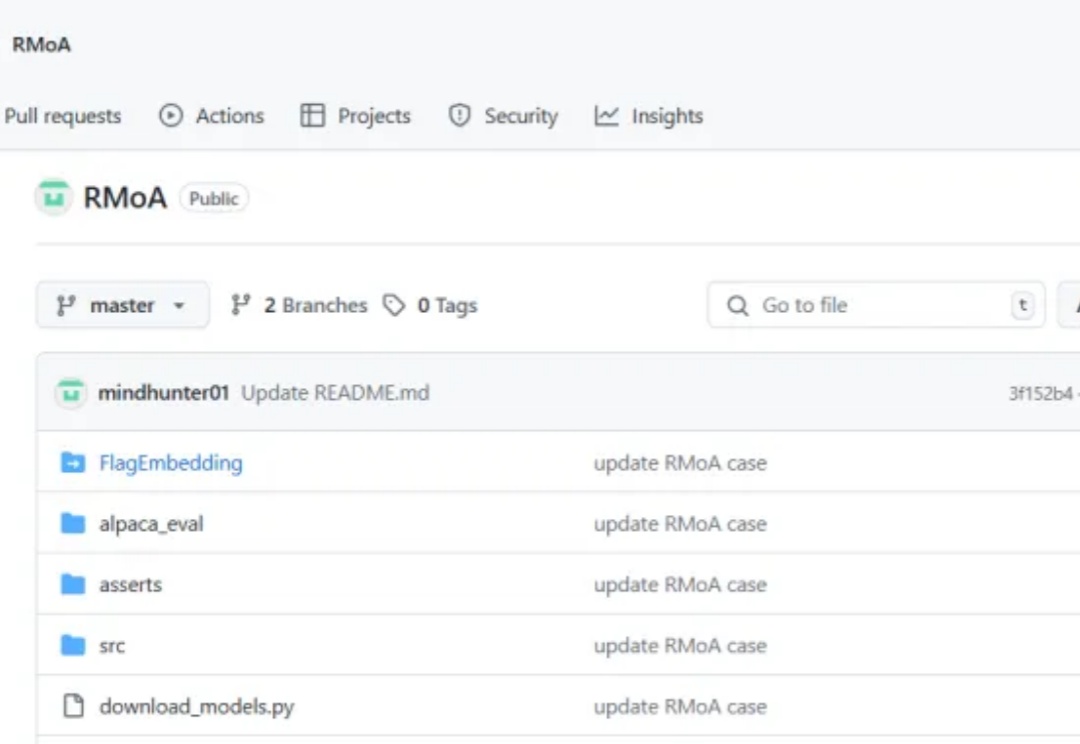

RMoA残差提取Mixture-of-Agents,让Agent发现新东西,并自适应停止「ACL2025」

RMoA残差提取Mixture-of-Agents,让Agent发现新东西,并自适应停止「ACL2025」如果你正在开发Agent产品,一定听过或用过Mixture-of-Agents(MoA)架构。这个让多个AI模型协作解决复杂问题的框架,理论上能够集众家之长,实际使用中却让人又爱又恨:

来自主题: AI技术研报

6466 点击 2025-06-05 10:47

如果你正在开发Agent产品,一定听过或用过Mixture-of-Agents(MoA)架构。这个让多个AI模型协作解决复杂问题的框架,理论上能够集众家之长,实际使用中却让人又爱又恨:

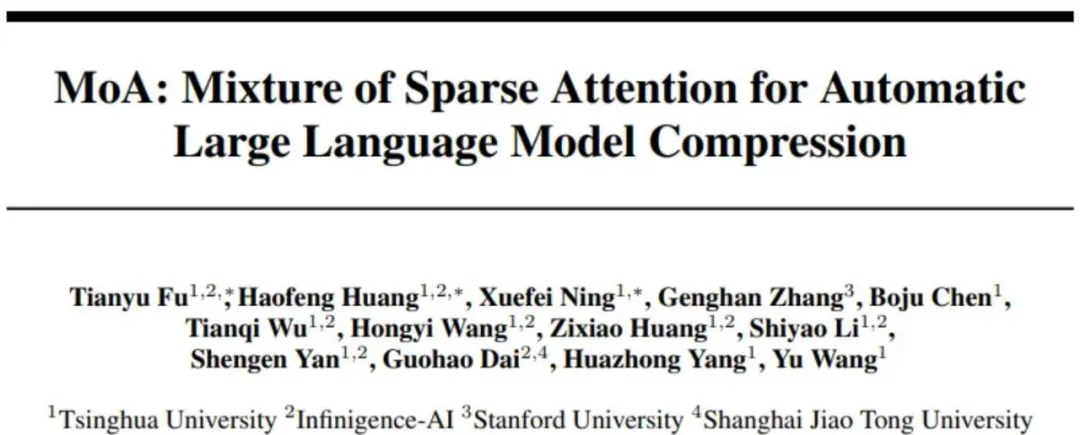

随着大语言模型在长文本场景下的需求不断涌现,其核心的注意力机制(Attention Mechanism)也获得了非常多的关注。

文字、图片、视频,万物皆可动漫化!

视频的次元壁就这么被打破了。在 AI 的加持下,一张照片可以千变万化,其实视频也能。