Lumina-DiMOO:多模态扩散语言模型重塑图像生成与理解

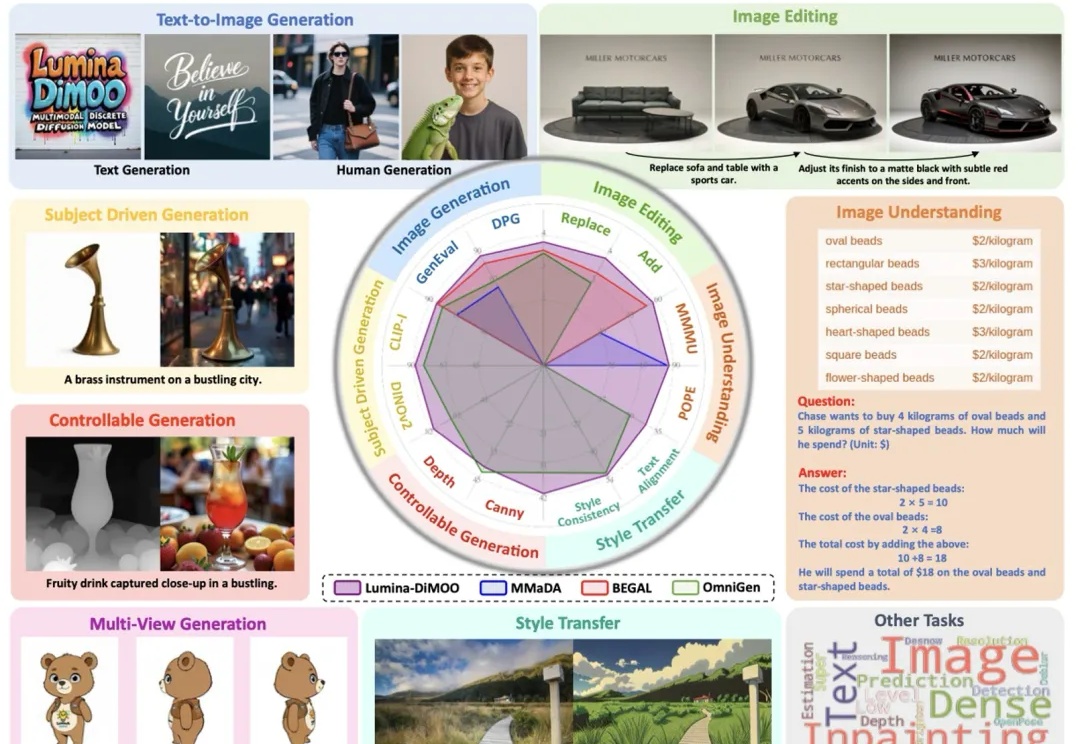

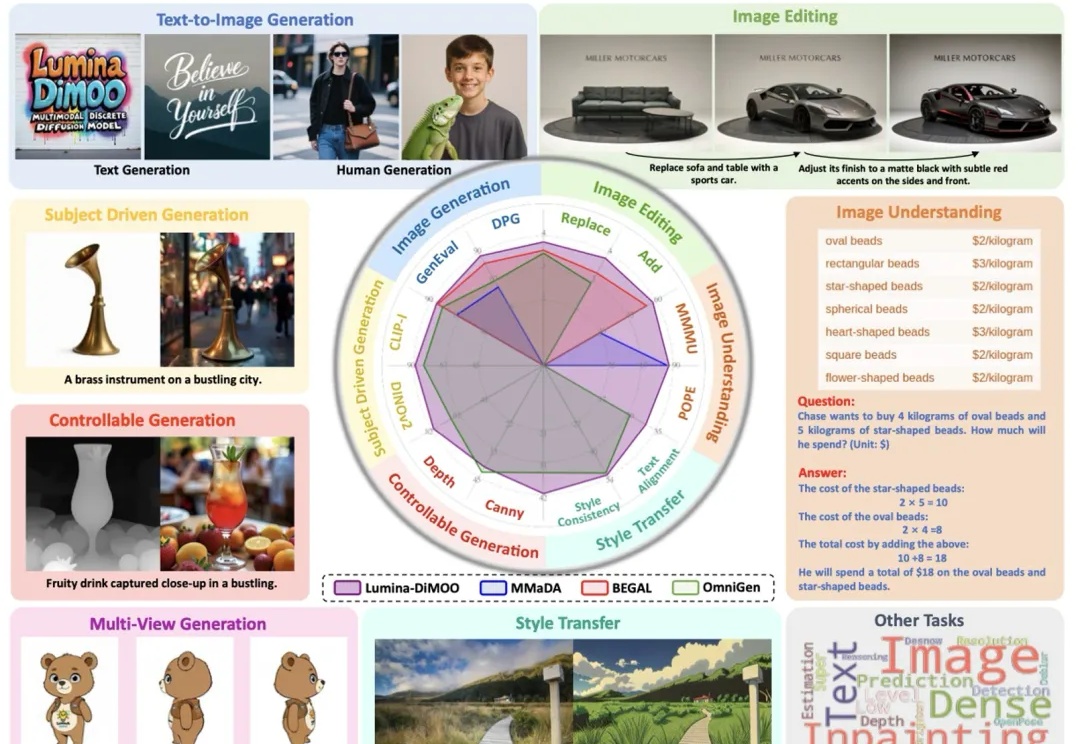

Lumina-DiMOO:多模态扩散语言模型重塑图像生成与理解上海人工智能实验室推出了一款革新的多模态生成理解一体化的扩散语言模型 ——Lumina-DiMOO。基于离散扩散建模(Discrete Diffusion Modeling),Lumina-DiMOO 打破了多模态任务之间的壁垒,在同一离散扩散框架下,完成从 文本→图像、图像→图像、图像→文本的全栈能力闭环。

上海人工智能实验室推出了一款革新的多模态生成理解一体化的扩散语言模型 ——Lumina-DiMOO。基于离散扩散建模(Discrete Diffusion Modeling),Lumina-DiMOO 打破了多模态任务之间的壁垒,在同一离散扩散框架下,完成从 文本→图像、图像→图像、图像→文本的全栈能力闭环。

糟糕!现在Agent也会这招了:原神,启动!咳咳,这其实是字节最新手搓出来的原神Agent——Lumine。不仅在《原神》里玩得很6,跑图开荒以及动辄几个小时的长主线任务,Lumine都能自己搞定,而且水平还不菜。

又一批AI社交公司与产品悄悄「死亡」了。今年9月,一批AI社交公司发布关停或通知,这之中,既包括大模型明星公司、社交公司等中型企业,如阶跃星辰To C产品「冒泡鸭」、Soul旗下的AI应用「异世界回响」等,也包括一批垂直领域的初创产品,如定位AI情感分析的Lumi、由前苹果设计师Jason Yuan创立的情感陪伴应用Dot等。

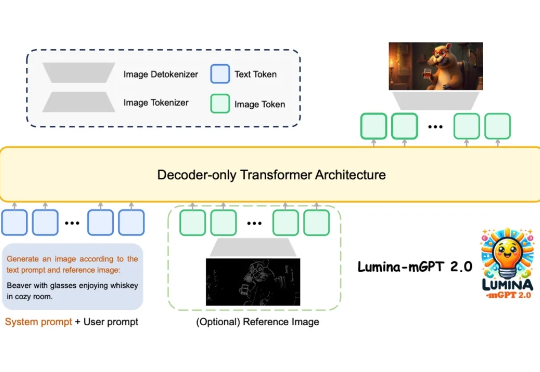

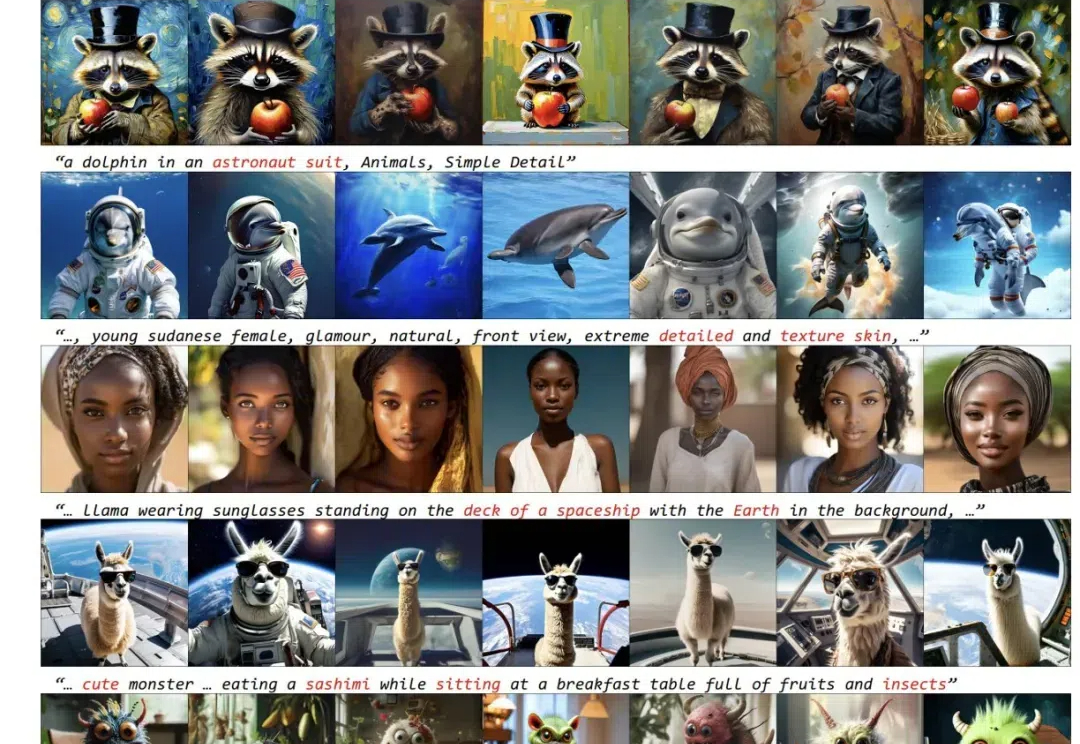

上海人工智能实验室等团队提出Lumina-mGPT 2.0 —— 一款独立的、仅使用解码器的自回归模型,统一了包括文生图、图像对生成、主体驱动生成、多轮图像编辑、可控生成和密集预测在内的广泛任务。

自 24 年 11 月起,我开始动手打造一个专注于 AI视频作品展示 的网站。在 AI 的助力下,我独立完成了 前后端与插件开发,成功落地了人生第一款真正意义上的个人作品。这篇文章将围绕 项目介绍、开发历程、工具使用心得、小白成长思考 等方面,分享我在这几个月中的所有收获与感悟。

如果你让当今的 LLM 给你生成一个创意时钟设计,使用提示词「a creative time display」,它可能会给出这样的结果:

近些年来,以 Stable Diffusion 为代表的扩散模型为文生图(T2I)任务树立了新的标准,PixArt,LUMINA,Hunyuan-DiT 以及 Sana 等工作进一步提高了图像生成的质量和效率。然而,目前的这些文生图(T2I)扩散模型受限于模型尺寸和运行时间,仍然很难直接部署到移动设备上。

刚刚,ControlNet作者张吕敏又发布了一个的图像打光新项目LuminaBrush,LuminaBrush 是一个构建交互式工具的项目,用于在图像上绘制光照效果。该框架采用两阶段方法:首先将图像转换为均匀光照的外观;然后通过用户的涂鸦生成光照效果。

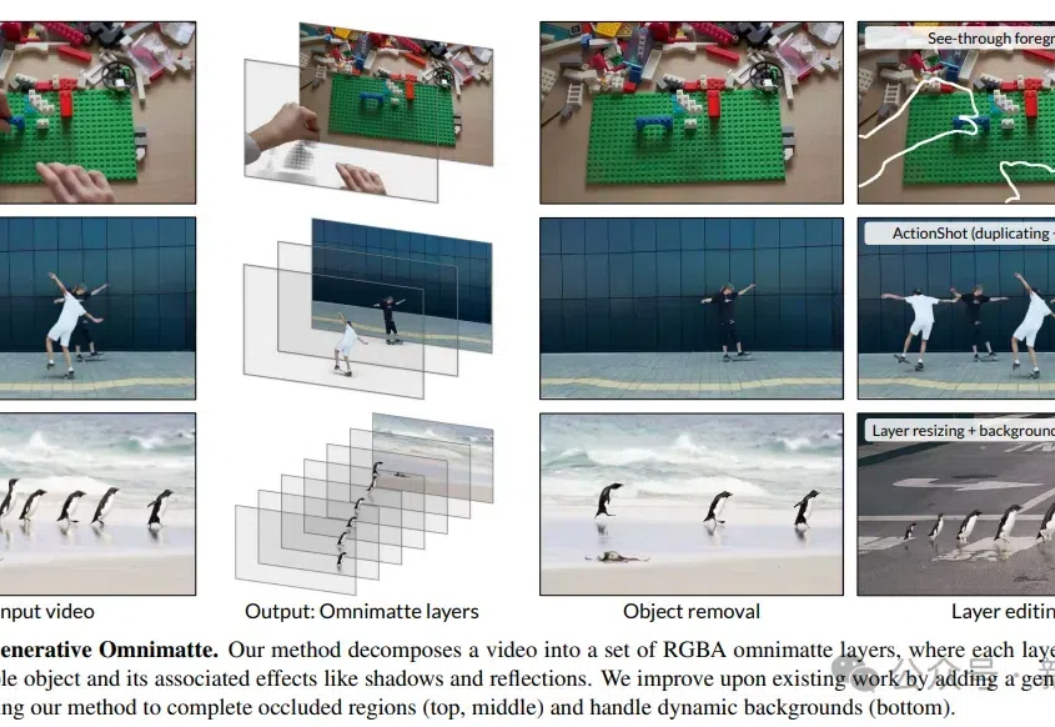

DeepMind的研究人员开发了一种视频分层新方法,可以无需假设背景静止或精确的相机姿态,就能将视频分解成包含物体及其效果(如阴影和反射)的多个层,提升了视频编辑的灵活性和效率。

三个月前,「LiblibAI 哩布哩布 AI」,一个 AI 模型社区型产品,在一年内完成了三轮共计数亿元的融资。