LoRA最新最权威的一切都在这了,2025综述

LoRA最新最权威的一切都在这了,2025综述在人工智能快速发展的今天,大型基础模型(如GPT、BERT等)已经成为AI应用的核心基石。然而,这些动辄数十亿甚至数万亿参数的模型给开发者带来了巨大的计算资源压力。传统的全参数微调方法不仅需要大量的计算资源,还面临着训练不稳定、容易过拟合等问题。

在人工智能快速发展的今天,大型基础模型(如GPT、BERT等)已经成为AI应用的核心基石。然而,这些动辄数十亿甚至数万亿参数的模型给开发者带来了巨大的计算资源压力。传统的全参数微调方法不仅需要大量的计算资源,还面临着训练不稳定、容易过拟合等问题。

Sakana AI发布了Transformer²新方法,通过奇异值微调和权重自适应策略,提高了LLM的泛化和自适应能力。新方法在文本任务上优于LoRA;即便是从未见过的任务,比如MATH、HumanEval和ARC-Challenge等,性能也都取得了提升。

大家可能看到过很多类似的结论:针对特定任务,对开源模型进行 LoRA 微调可以干翻 GPT-4 这类闭源模型。

这两天,北京大学等研究团队发布了一个视频生成的可控生成工作:ConsisID。ConsisID可以实现无需训练Lora的保持参考人脸一致性的文生视频,类似之前图像生成的IP-Adapter-Face和InstantID等工作。虽然之前也有类似的工作,但是ConsisID在效果更上一个台阶。

通过自己照片训练一个自己专属的FLUX模型,利用好FLUX的超强生图能力,从此想生成啥生成啥,实现写真自由

大型语言模型(LLMs)虽然在适应新任务方面取得了长足进步,但它们仍面临着巨大的计算资源消耗,尤其在复杂领域的表现往往不尽如人意。

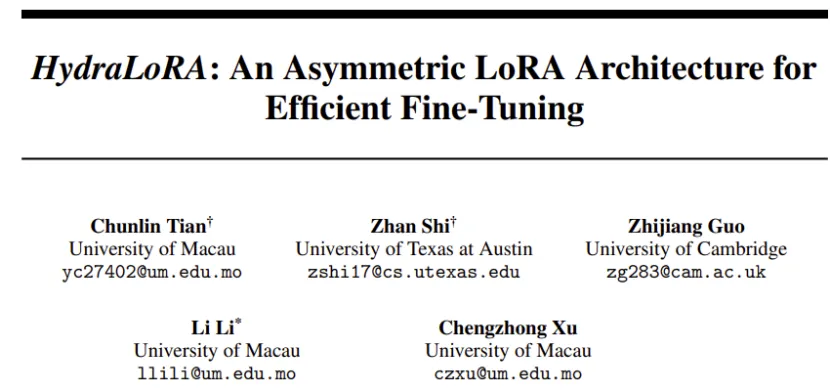

比LoRA更高效的模型微调方法来了——

席卷开源界的AI生图王者诞生了!发布半个月,Flux已经成为替代Midjourney的宠儿。各路开发者们开始用自己的照片微调LoRA,一人拿捏多种风格。

“FLUX在线版”,新增一系列重磅功能!

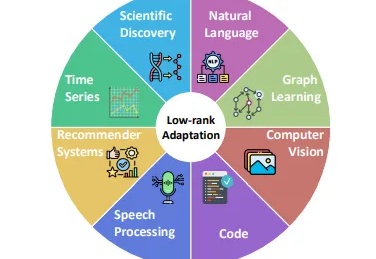

低秩适应(Low-Rank Adaptation,LoRA)通过可插拔的低秩矩阵更新密集神经网络层,是当前参数高效微调范式中表现最佳的方法之一。此外,它在跨任务泛化和隐私保护方面具有显著优势。