LoRA中到底有多少参数冗余?新研究:砍掉95%都能保持高性能 机器之心 2025年05月02日 12:39 北京

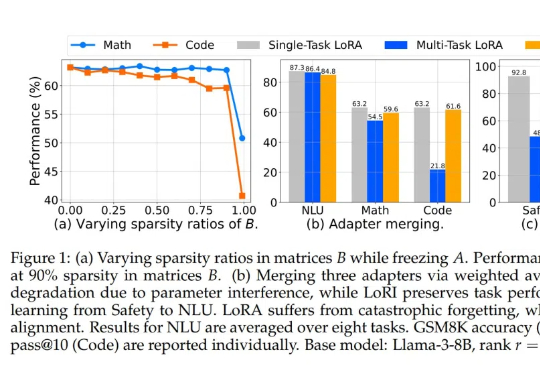

LoRA中到底有多少参数冗余?新研究:砍掉95%都能保持高性能 机器之心 2025年05月02日 12:39 北京LoRA 中到底存在多少参数冗余?这篇创新研究介绍了 LoRI 技术,它证明即使大幅减少 LoRA 的可训练参数,模型性能依然保持强劲。

LoRA 中到底存在多少参数冗余?这篇创新研究介绍了 LoRI 技术,它证明即使大幅减少 LoRA 的可训练参数,模型性能依然保持强劲。

可以生成无限时长的视频生成模型终于来了!

低秩适配器(LoRA)能够在有监督微调中以约 5% 的可训练参数实现全参数微调 90% 性能。

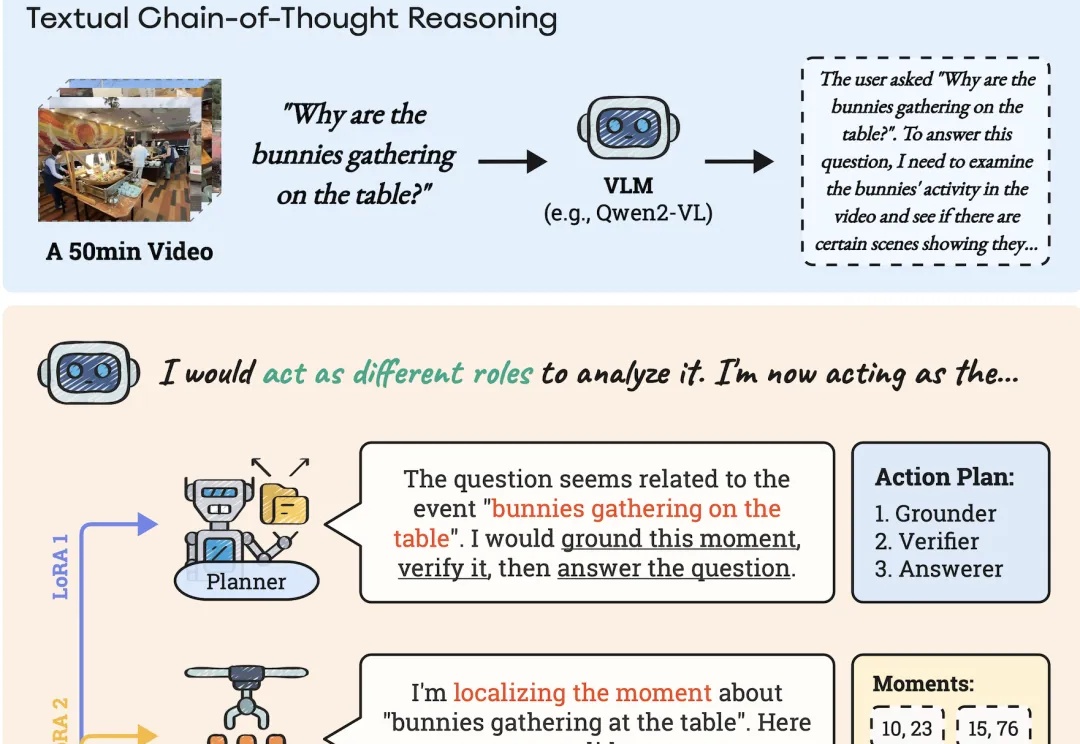

AI能像人类一样理解长视频。

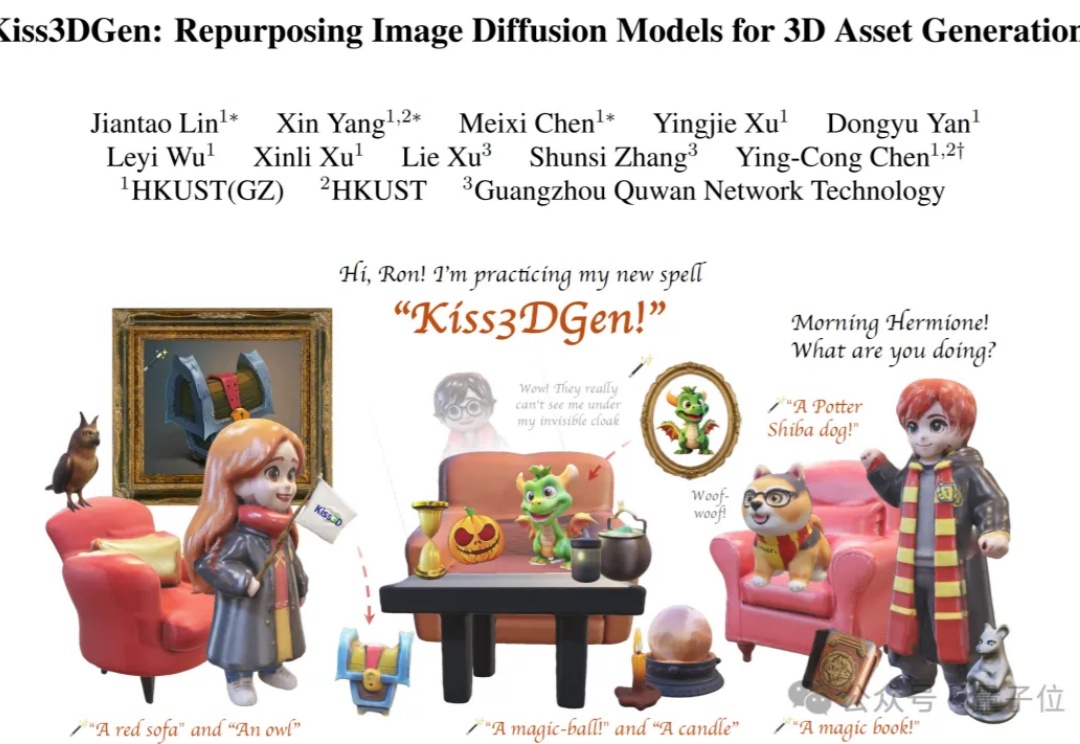

在Stable Diffusion当中,只需加入一个LoRA就能根据图像创建3D模型了?

又添新鲜血液。根据 TechCrunch 报道,由一位华人创始人 Weber Wong 开发的 AI 创意工具 Flora 于 3 月 1 日正式上线。时至今日,AI 图像与视频赛道的产品和格局已经有点固化了,能够有新鲜产品加入,还是华人创始人,确实很令人惊喜。

只需几句话,AI 模型就可以被提示创作一个故事、一幅图像,甚至一部短片。但根据 Weber Wong 的说法,“这些模型都是“由非创意人士制作,供其他非创意人士感受创意的。”

3月1日,潞晨科技官微发布了两则消息。先是宣布:“尊敬的用户,潞晨云将在一周后停止提供DeepSeek API服务,请尽快用完您的余额。如果没用完,我们全额退款。”后又发布消息:“感谢网友的热心提醒,Colossal-AI此前发布对DeepSeek-R1(671B)模型的LoRA微调,在参数加载过程中因参数名称不匹配的Bug导致Loss异常,已在GitHub线上修复。”

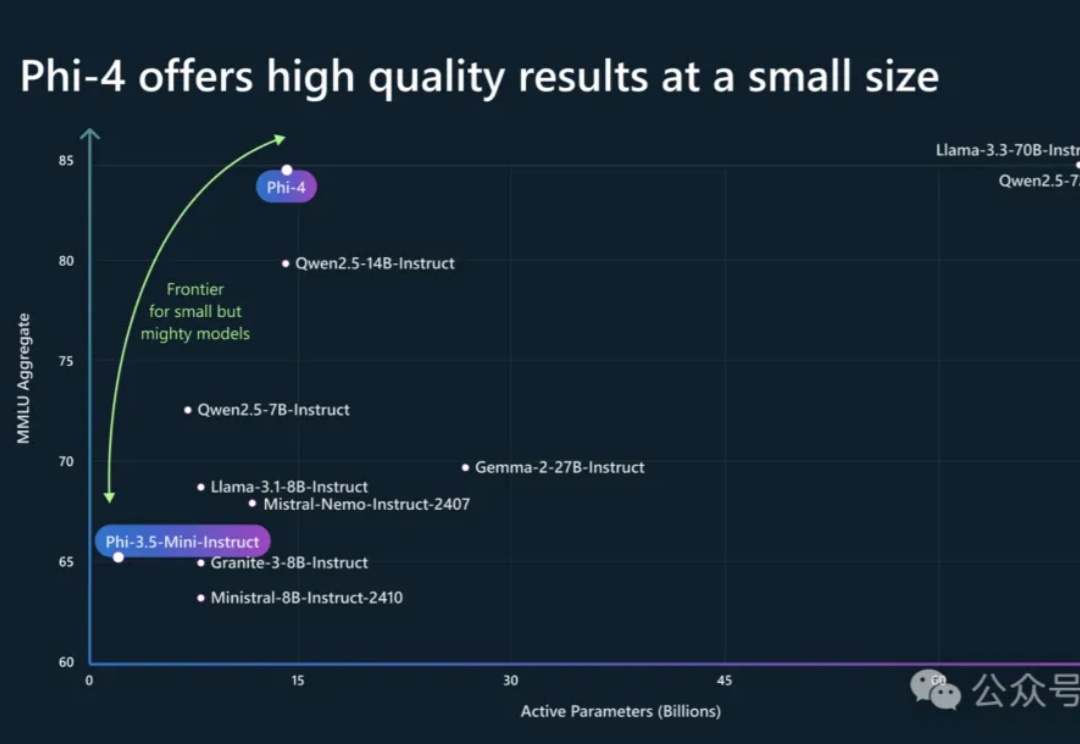

Phi-4系列模型上新了!56亿参数Phi-4-multimodal集语音、视觉、文本多模态于一体,读图推理性能碾压GPT-4o;另一款38亿参数Phi-4-mini在推理、数学、编程等任务中超越了参数更大的LLM,支持128K token上下文。

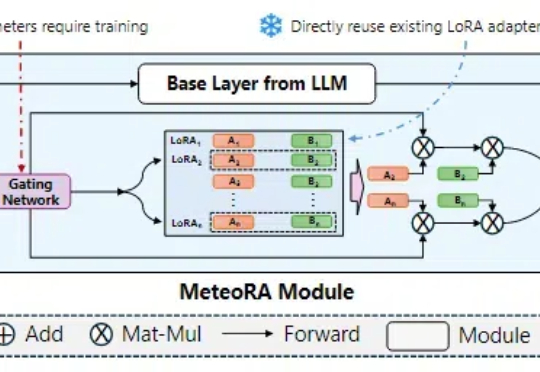

在大语言模型领域中,预训练 + 微调范式已经成为了部署各类下游应用的重要基础。在该框架下,通过使用搭低秩自适应(LoRA)方法的大模型参数高效微调(PEFT)技术,已经产生了大量针对特定任务、可重用的 LoRA 适配器。